目录

背景案例

换成 Edge Chrome

驱动下载

配置环境

代码案例

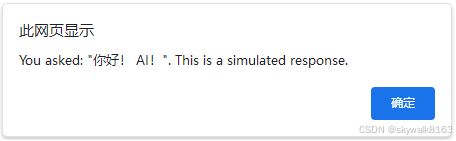

测试结果

背景案例

Python正常,环境正常,驱动正常,但是就是打不开浏览器,就是一直报错,导致很烦躁

换成 Edge Chrome

与 Google Chrome浏览器一样,下载驱动,配置环境变量

驱动下载

https://msedgedriver.azureedge.net/136.0.3190.0/edgedriver_win64.zip

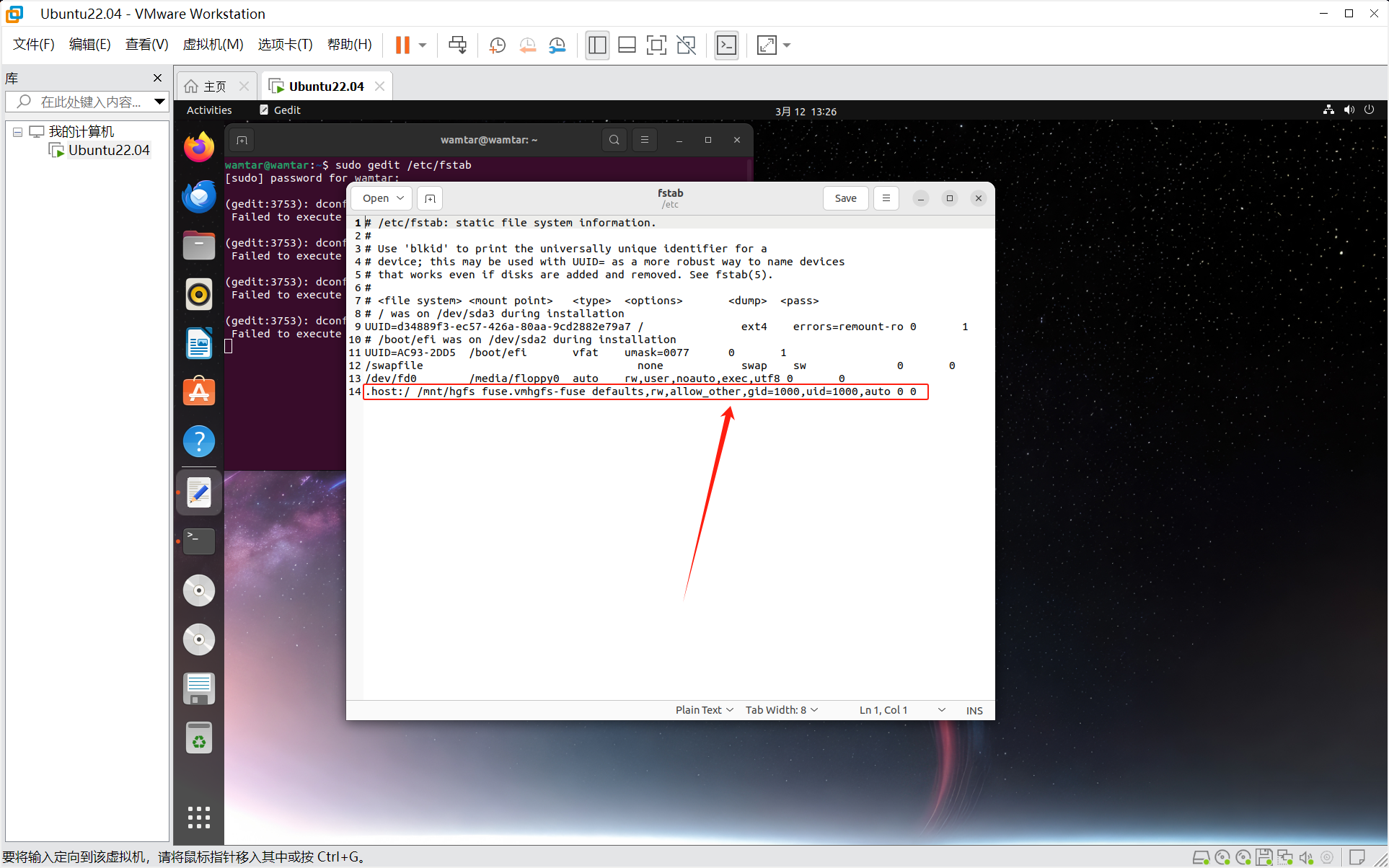

配置环境

代码案例

import time

from selenium import webdriver

from selenium.webdriver.common.by import By# 将谷歌换成Edge

# driver = webdriver.Chrome()

driver = webdriver.Edge()

# 打开一个网页进行测试

driver.get("https://www.baidu.com")

content = driver.find_element(By.ID,"kw")

go = driver.find_element(By.ID,"su")

content.send_keys("python")

go.click()time.sleep(6)# 关闭浏览器

# driver.quit()测试结果

感谢观看