1、准备

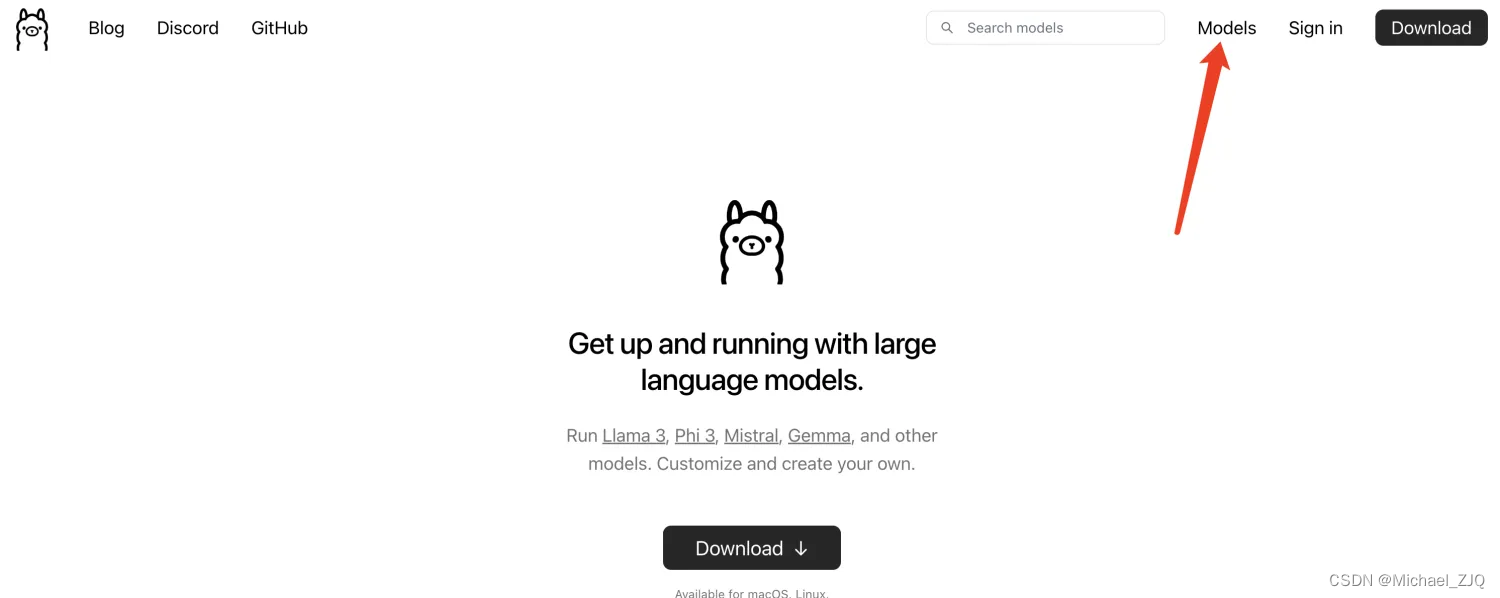

● Ollama:ollama.com

● Docker:https://docs.openwebui.com/

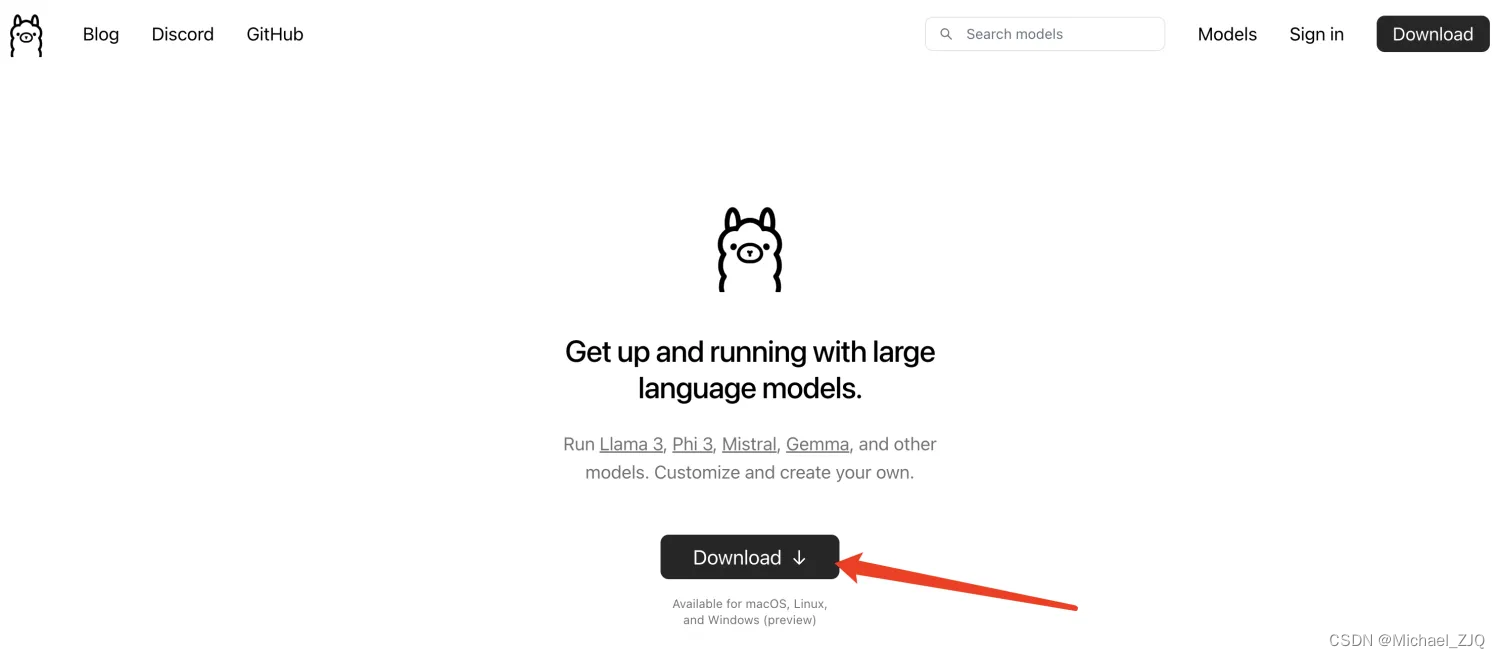

2、下载 Ollama

进入 Ollama 官网,点击 Download 。

下载完成后,双击安装,什么都不需要勾选,直接下一步即可。安装完成,电脑 Mac(右上角)Windows(右下角)出现这个图标就说明安装成功了。

另外:windows 电脑还需要设置一下环境变量(mac 不需要)。因为Ollama 默认将模型安装在 c 盘,会造成电脑资源紧张。配置如下:

我的电脑-右键-属性中的高级系统设置找到环境变量

系统环境变量名OLLAMA_MODELS,值就是你要把大模型安装的位置,这里我使用 G:\Ollama(换成你自己的)。

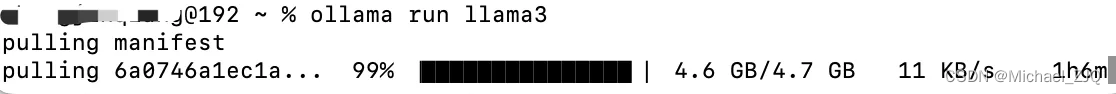

3、安装大模型

● 打开电脑终端

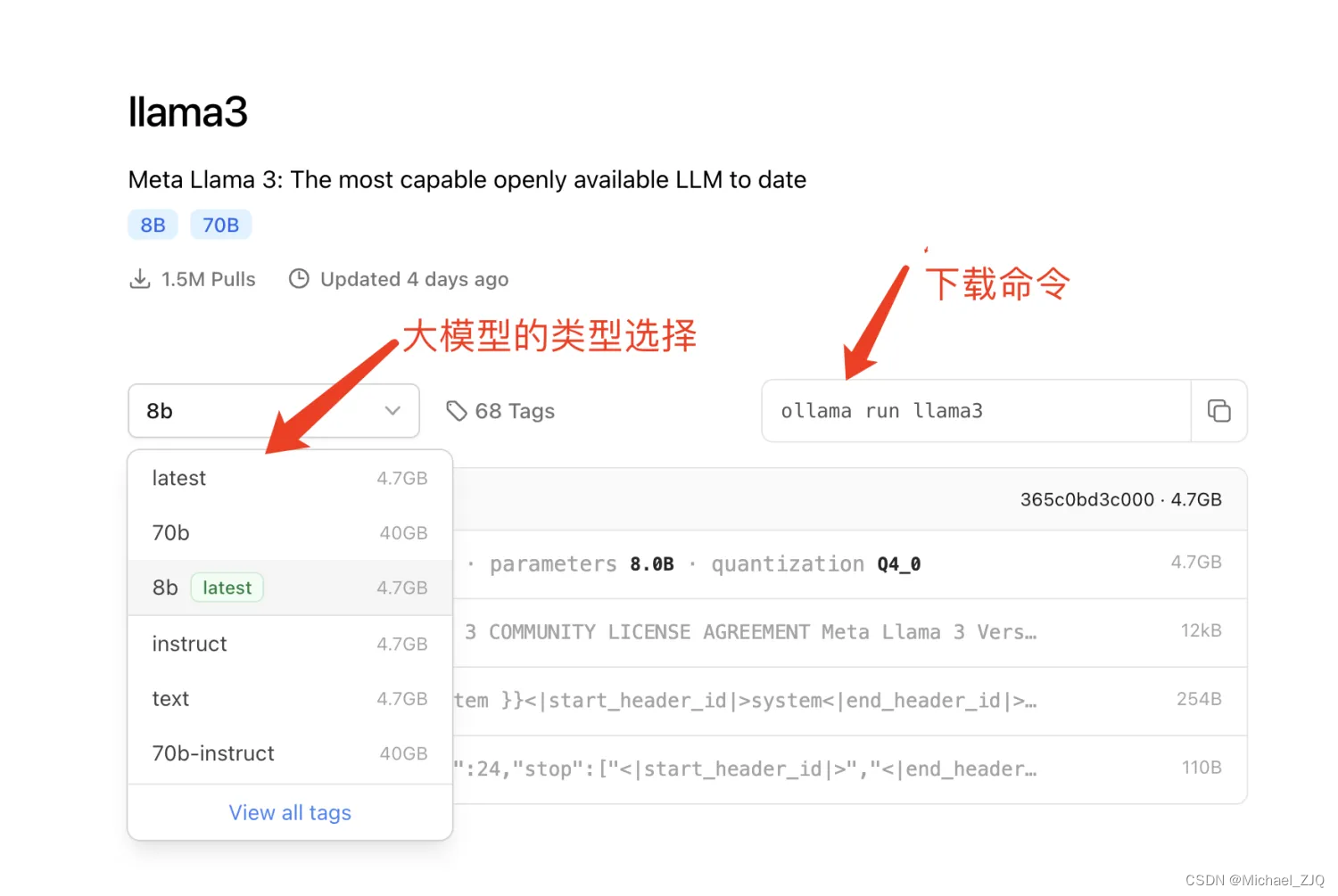

● 运行命令 ollama run llama3

● 接下来等待安装完成即可

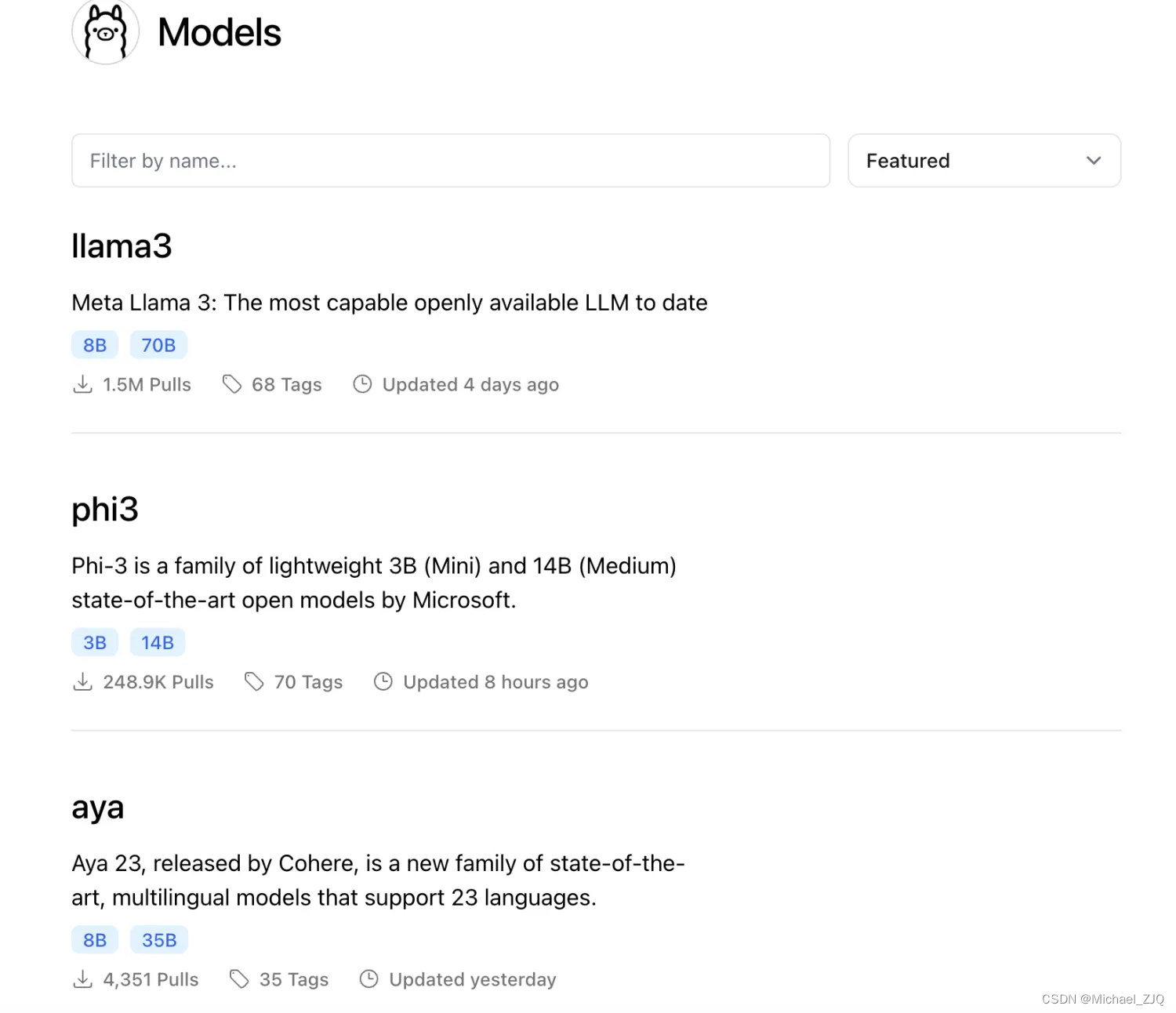

点击Ollama 官网的 Models

可以看到支持很多的模型

随便选择一个,点击进去

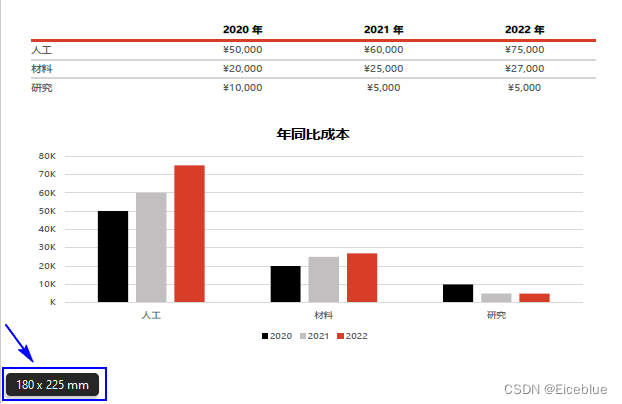

我们在下拉框可以看到,不同的类型,需要不同的电脑磁盘空间,当然越大的,模型就越聪明

4、Ollama的常用操作

● ollama list:列出已安装的本地大型模型信息

● ollama pull xxx:version:更新模型

● ollama rm xxx:删除不再使用的模

● ollama -h:帮助

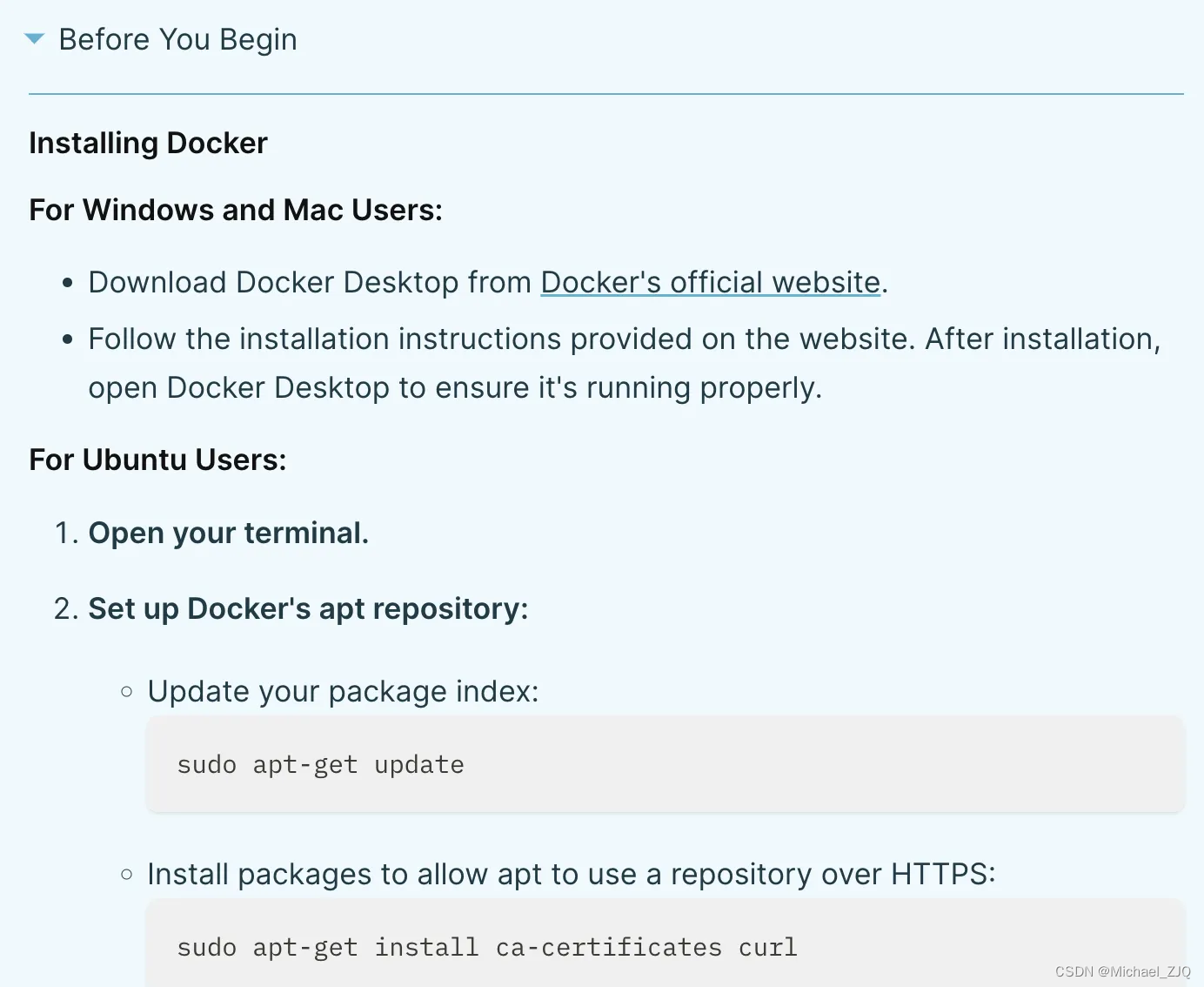

5、安装Docker

打开官网,点击Getting Started。看Before You Begin的内容,不同的系统下载 docker 的方式

点击进入docker下载

下载完成后,双击安装即可

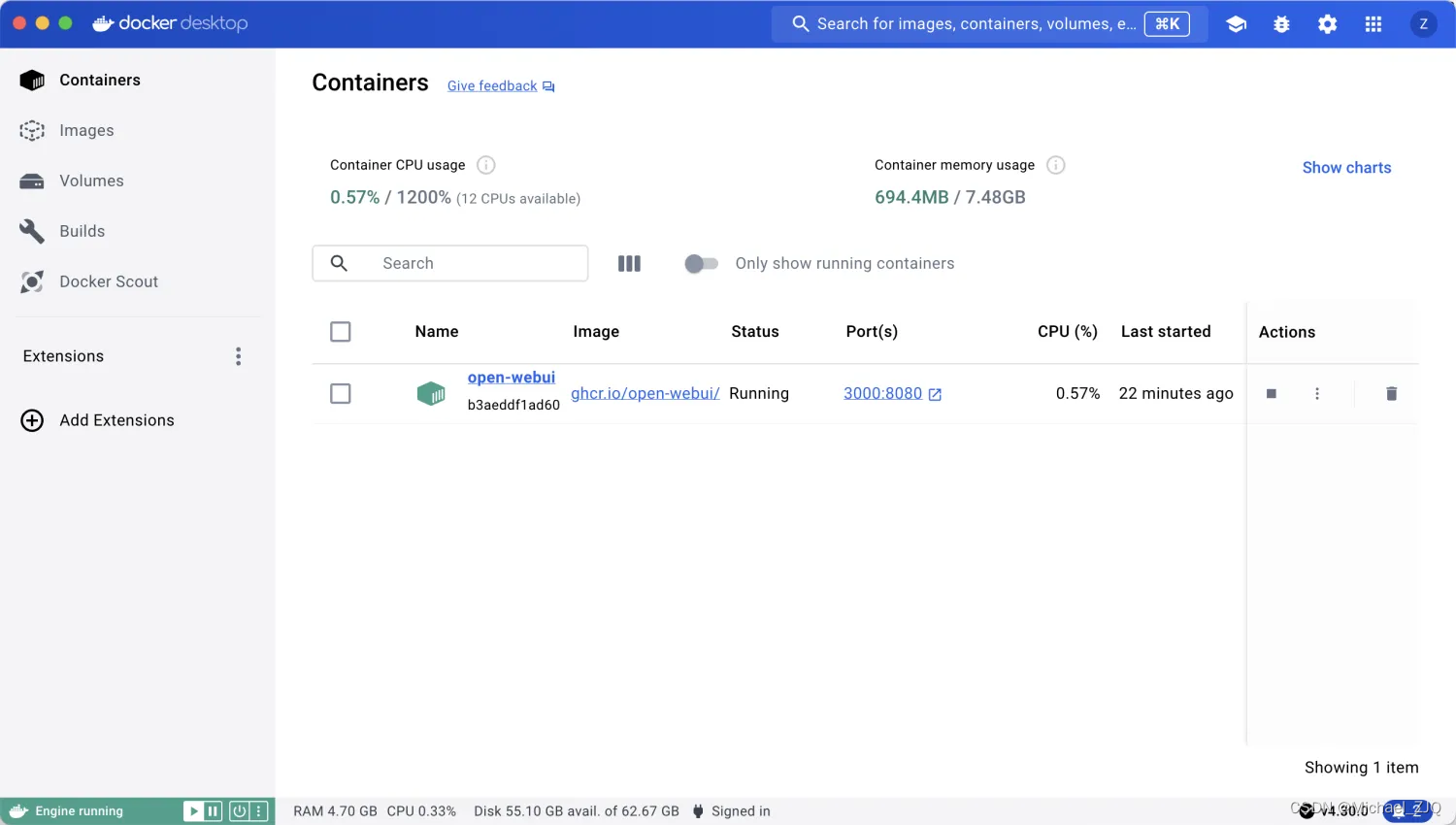

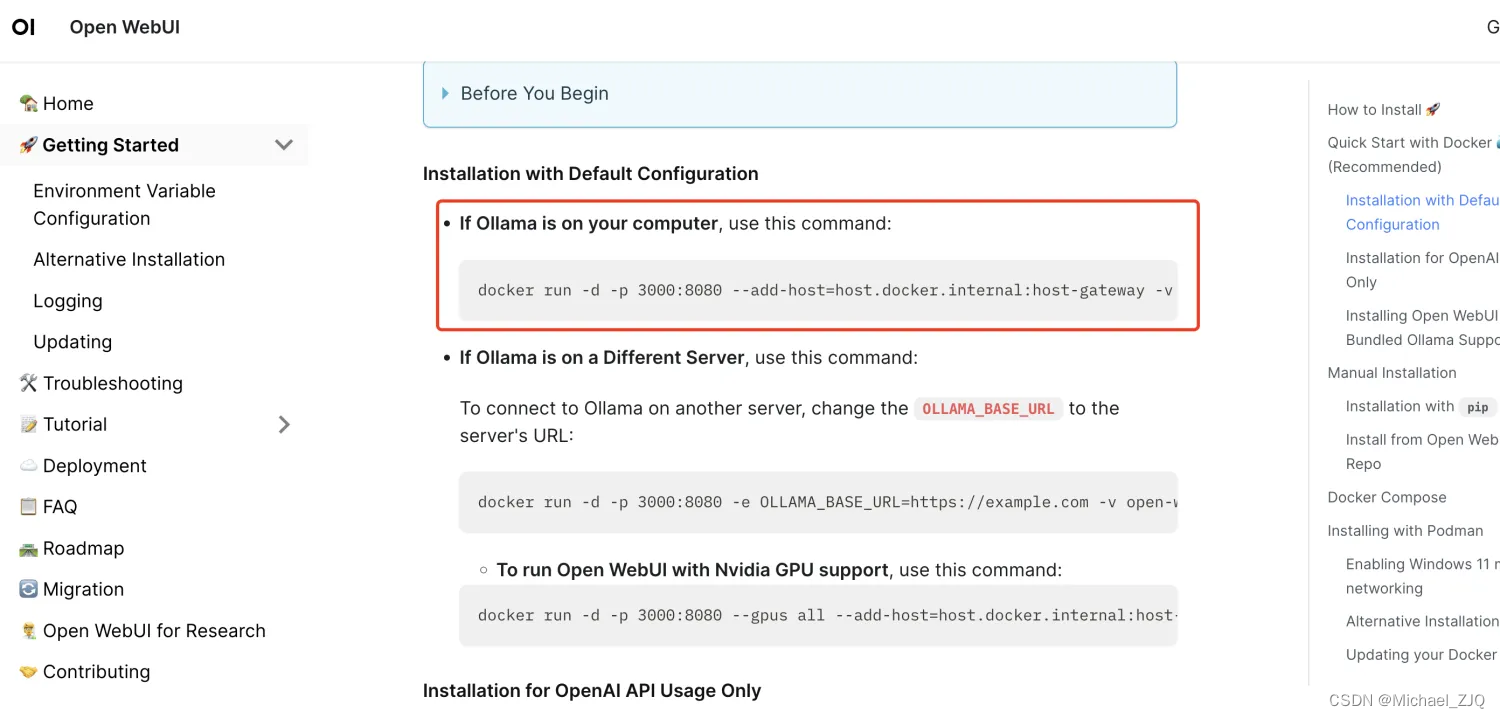

接下来是安装 open-webui,有几种安装配置,ollama 安装在你的电脑、安装在不同的服务器上

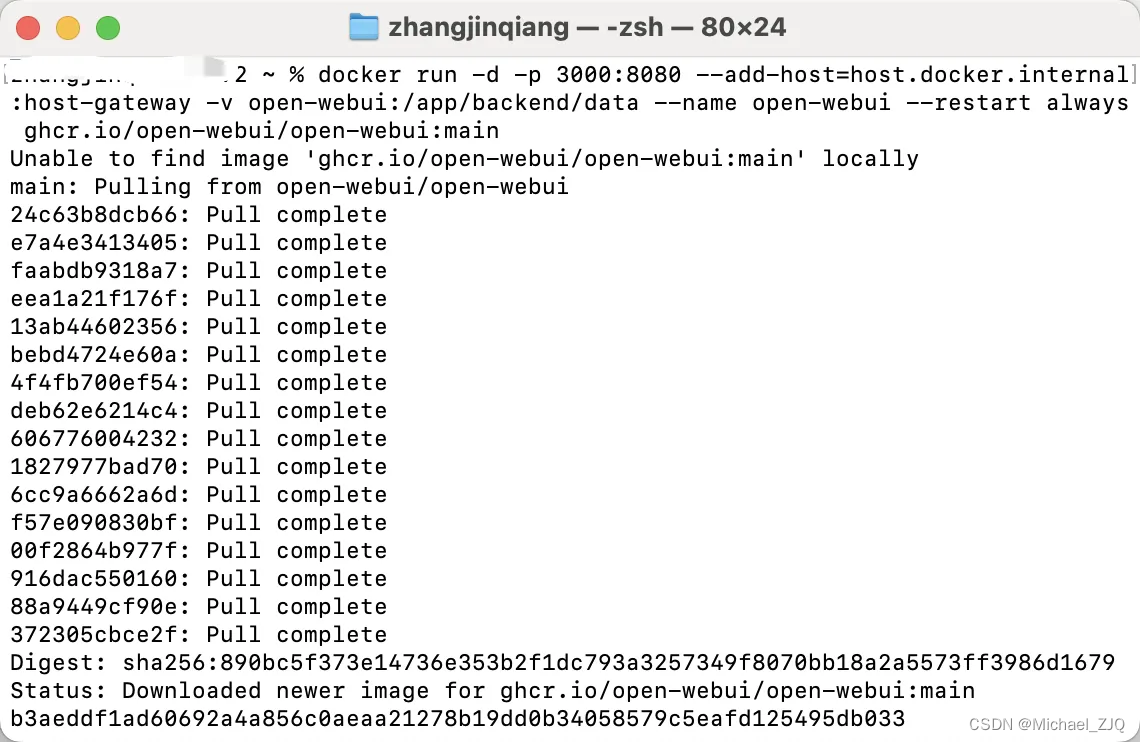

打开终端,运行命令

然后访问:http:localhost:3000

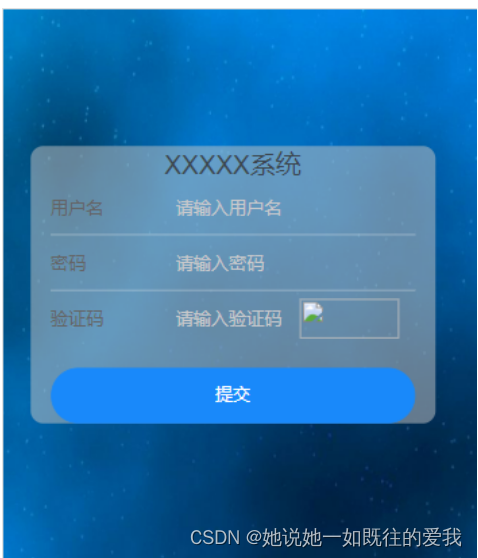

注册一个账号(注册的数据都是存储在本地的)

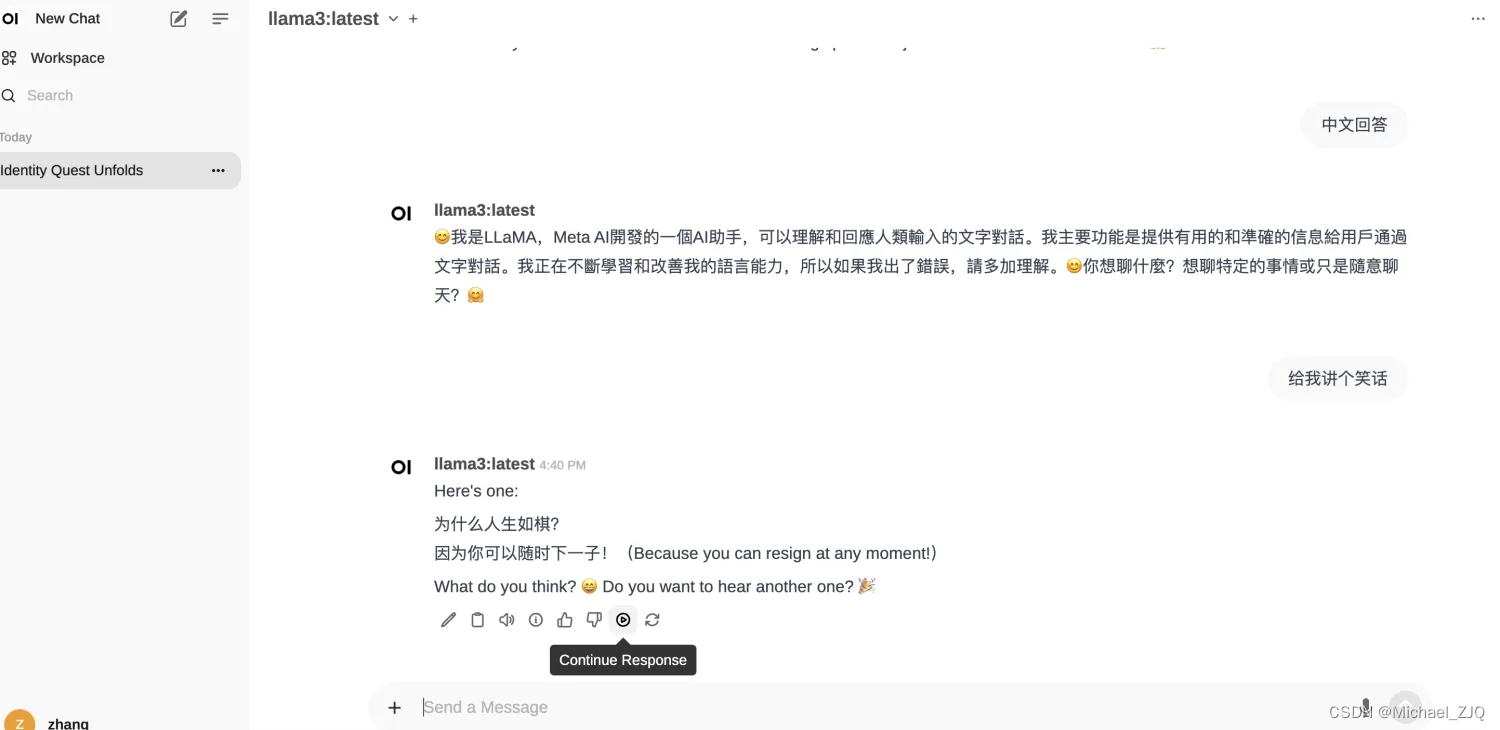

登录进去

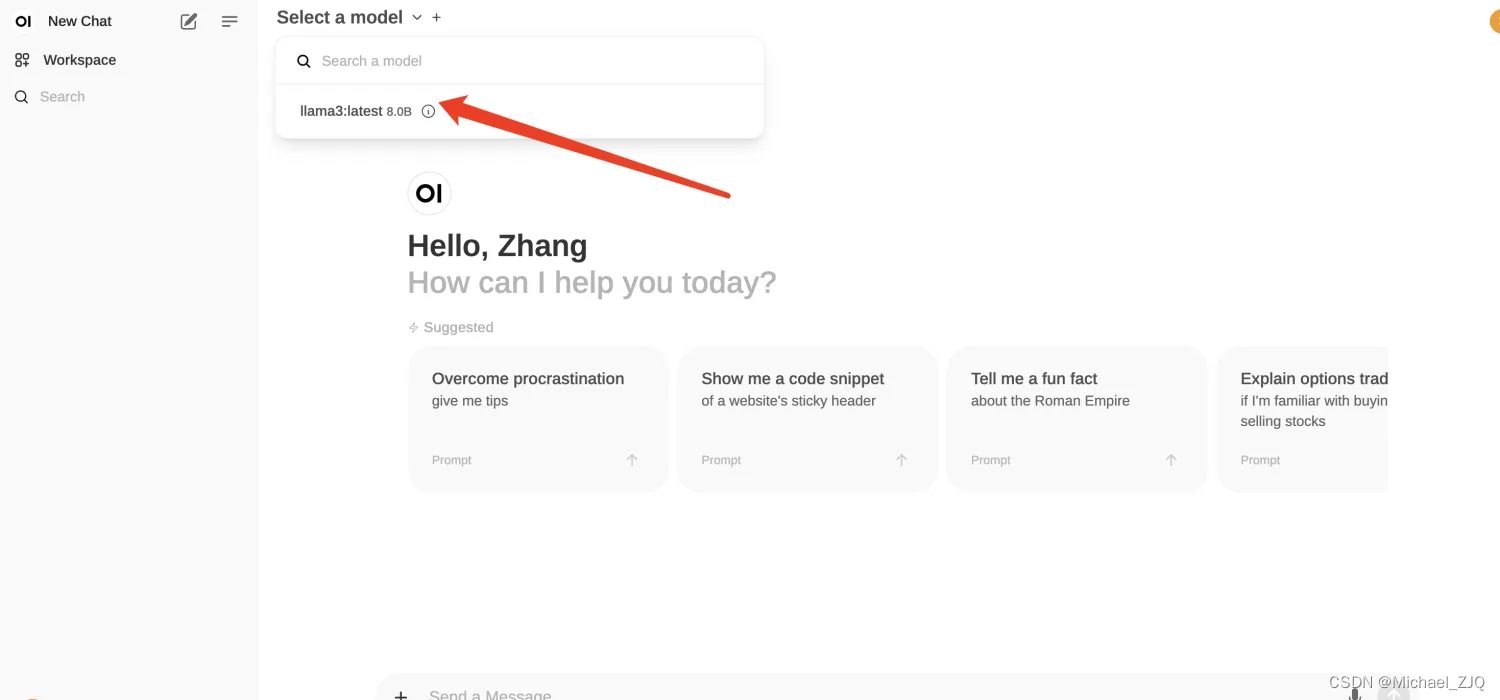

选择你安装的模型,你可以安装多个,来回切换

接下来,你就可以玩起来了