每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

随着生成式AI领域的竞争转向多模态模型,Meta推出了一款名为Chameleon的新模型家族,以回应前沿实验室发布的各类模型。Chameleon被设计为原生多模态模型,而非将不同模态组件拼凑在一起。

虽然Meta尚未发布这些模型,但据报告显示,Chameleon在图像描述和视觉问答(VQA)等任务中表现出色,同时在纯文本任务中也具竞争力。

早期融合多模态模型

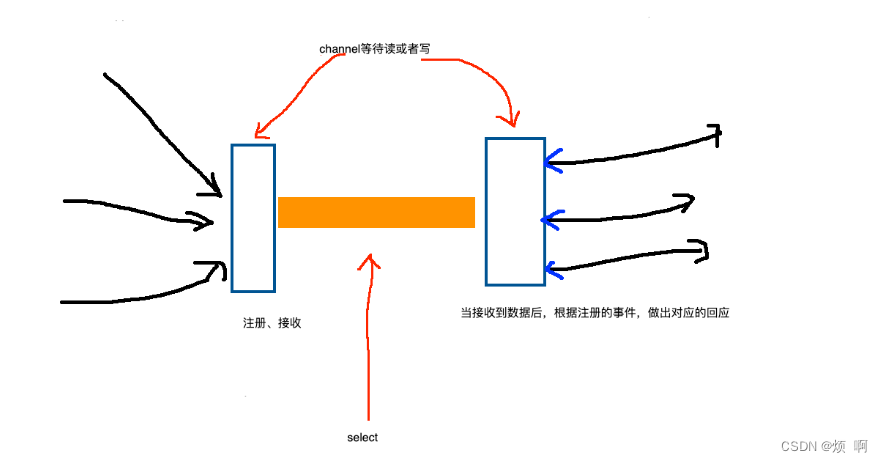

目前,创建多模态基础模型的流行方式是将为不同模态训练的模型拼凑在一起。这种方法称为“后期融合”,即AI系统接收不同的模态,用单独的模型编码它们,然后融合编码进行推理。尽管后期融合效果不错,但它限制了模型跨模态整合信息和生成交错图像与文本序列的能力。

Chameleon采用了“早期融合基于token的混合模态”架构,这意味着它从一开始就设计为从交错的图像、文本、代码和其他模态中学习。Chameleon将图像转换为离散的token,就像语言模型处理单词一样。它还使用了由文本、代码和图像token组成的统一词汇表,使得能够对包含图像和文本token的序列应用相同的transformer架构。

据研究人员介绍,与Chameleon最相似的模型是谷歌的Gemini,它也采用了早期融合token的方法。然而,Gemini在生成阶段使用了单独的图像解码器,而Chameleon则是一个端到端模型,既处理又生成token。

“Chameleon的统一token空间使其能够无缝推理并生成交错的图像和文本序列,无需模态特定的组件,”研究人员写道。

Chameleon的架构和训练

尽管早期融合非常有吸引力,但在训练和扩展模型时会面临重大挑战。为了克服这些挑战,研究人员采用了一系列的架构修改和训练技术。在论文中,他们分享了不同实验的细节及其对模型的影响。

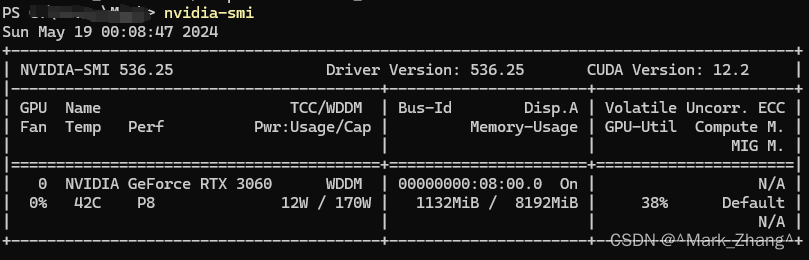

Chameleon的训练分两个阶段进行,数据集包含4.4万亿个文本、图像-文本对以及交错的文本和图像序列。研究人员在超过500万小时的Nvidia A100 80GB GPU上训练了一个7-billion和一个34-billion参数版本的Chameleon。

Chameleon的表现

根据论文中报告的实验,Chameleon能够执行多种纯文本和多模态任务。在视觉问答(VQA)和图像描述基准测试中,Chameleon-34B达到了最先进的性能,超越了Flamingo、IDEFICS和Llava-1.5等模型。

研究人员表示,Chameleon在预训练和微调模型评估中,以更少的上下文训练示例和更小的模型尺寸达到了其他模型的性能。

多模态的一个折衷是单模态请求中的性能下降。例如,视觉-语言模型在纯文本提示上的性能往往较低。但Chameleon在纯文本基准测试中仍具竞争力,在常识推理和阅读理解任务中与Mixtral 8x7B和Gemini-Pro等模型相匹敌。

有趣的是,Chameleon能够为混合模态推理和生成解锁新能力,特别是在提示预期混合模态响应时。实验显示,用户总体上更喜欢Chameleon生成的多模态文档。

上周,OpenAI和谷歌都发布了提供丰富多模态体验的新模型。然而,他们并未发布有关模型的详细信息。如果Meta继续按照其策略发布Chameleon的权重,它可能成为私人模型的开放替代方案。

早期融合还可以为更高级的模型研究开辟新方向,特别是随着更多模态的加入。例如,机器人初创公司已经在实验将语言模型整合到机器人控制系统中。早期融合如何改进机器人基础模型也将是一个有趣的研究方向。

“Chameleon代表了实现能够灵活推理并生成多模态内容的统一基础模型愿景的重大一步,”研究人员写道。