文章目录

- 笔记-RAG

- 课程结构

- 为什么要用 RAG?

- 定义

- 工作原理

- 向量数据库

- RAG 工作流程

- 发展历程

- 常见优化

- RAG vs 微调

- LLM 优化方法比较

- RAG的评价

- 总结

- 笔记-茴香豆

- 什么是茴香豆

- 茴香豆实战

笔记-RAG

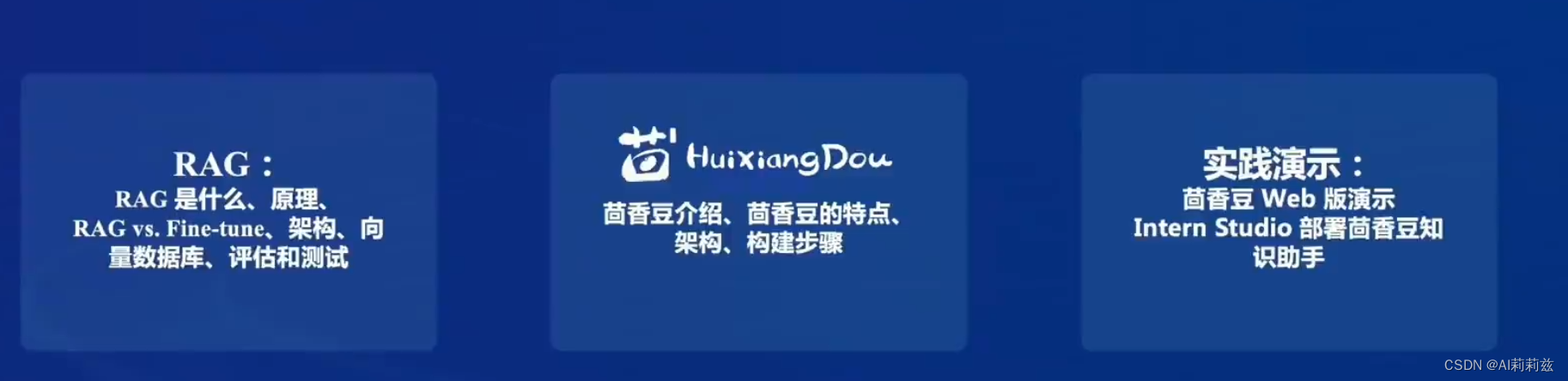

课程结构

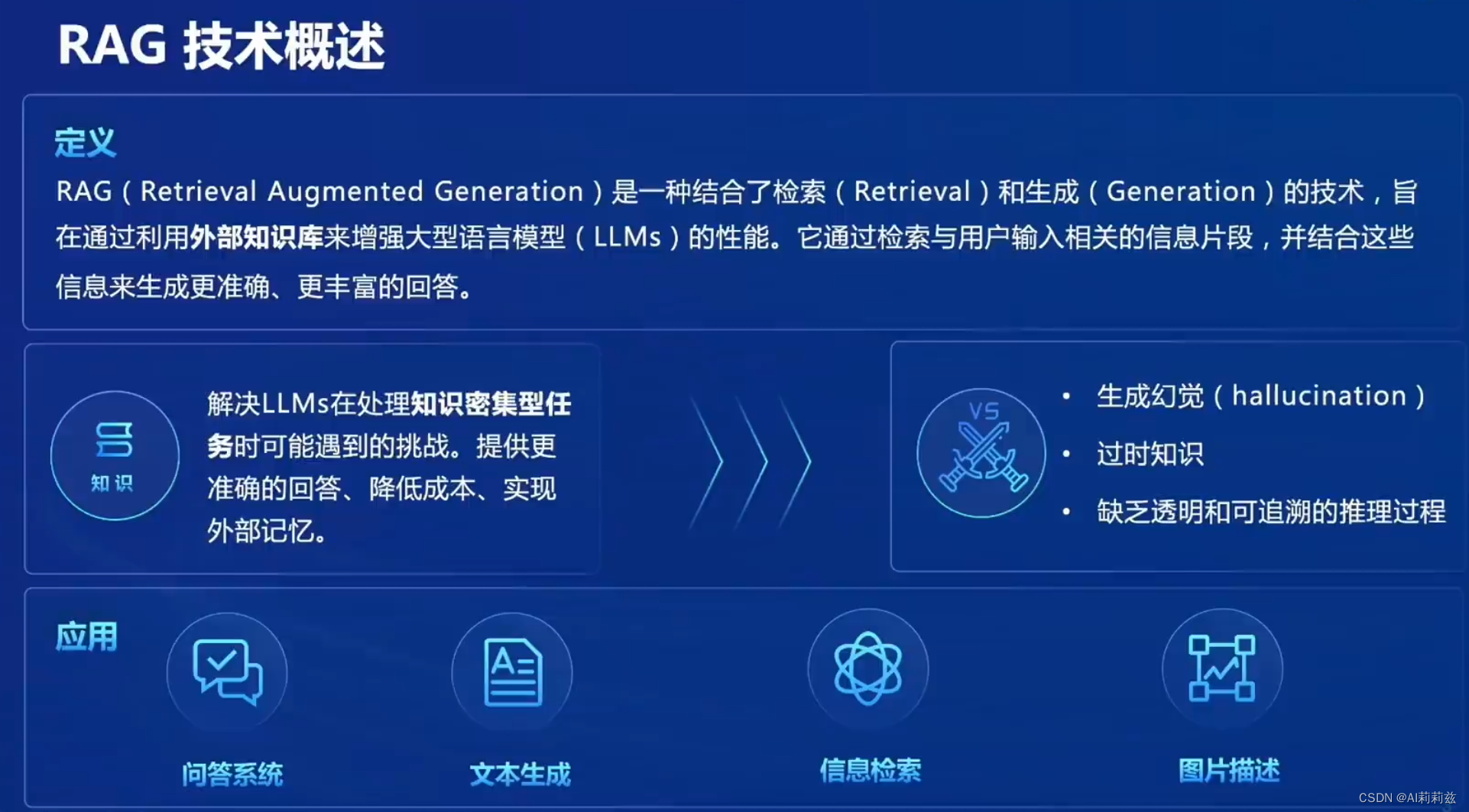

为什么要用 RAG?

新增知识,尤其是高频变动且精确度要求高的知识,其实比较难通过微调的方式注入模型,而在模型的输入窗口中添加基于相关性的召回段落,能够比较有效地缓解这个问题。RAG 就是对一类方案的概括。

定义

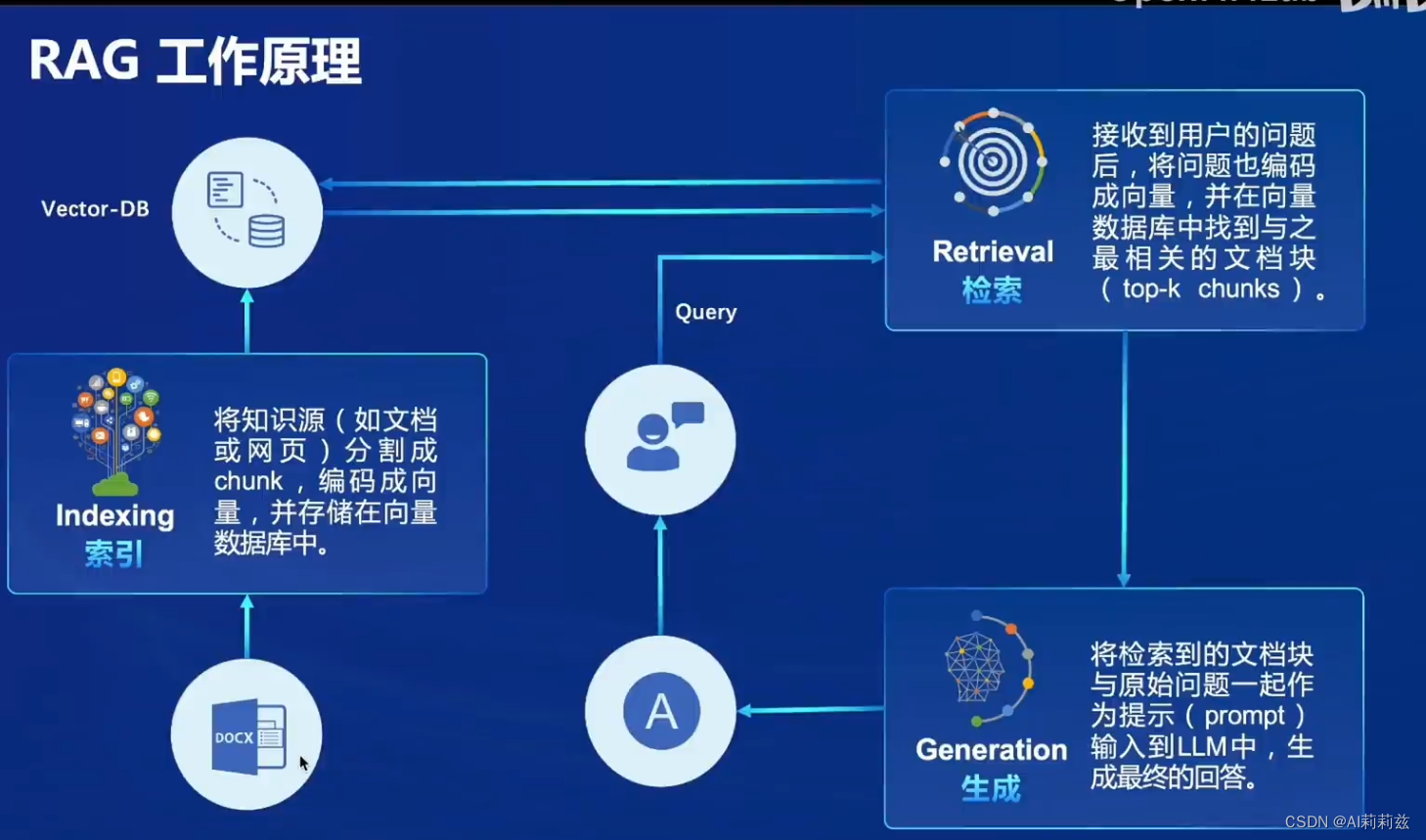

工作原理

Indexing 部分,llamaIndex 是目前比较火的框架。

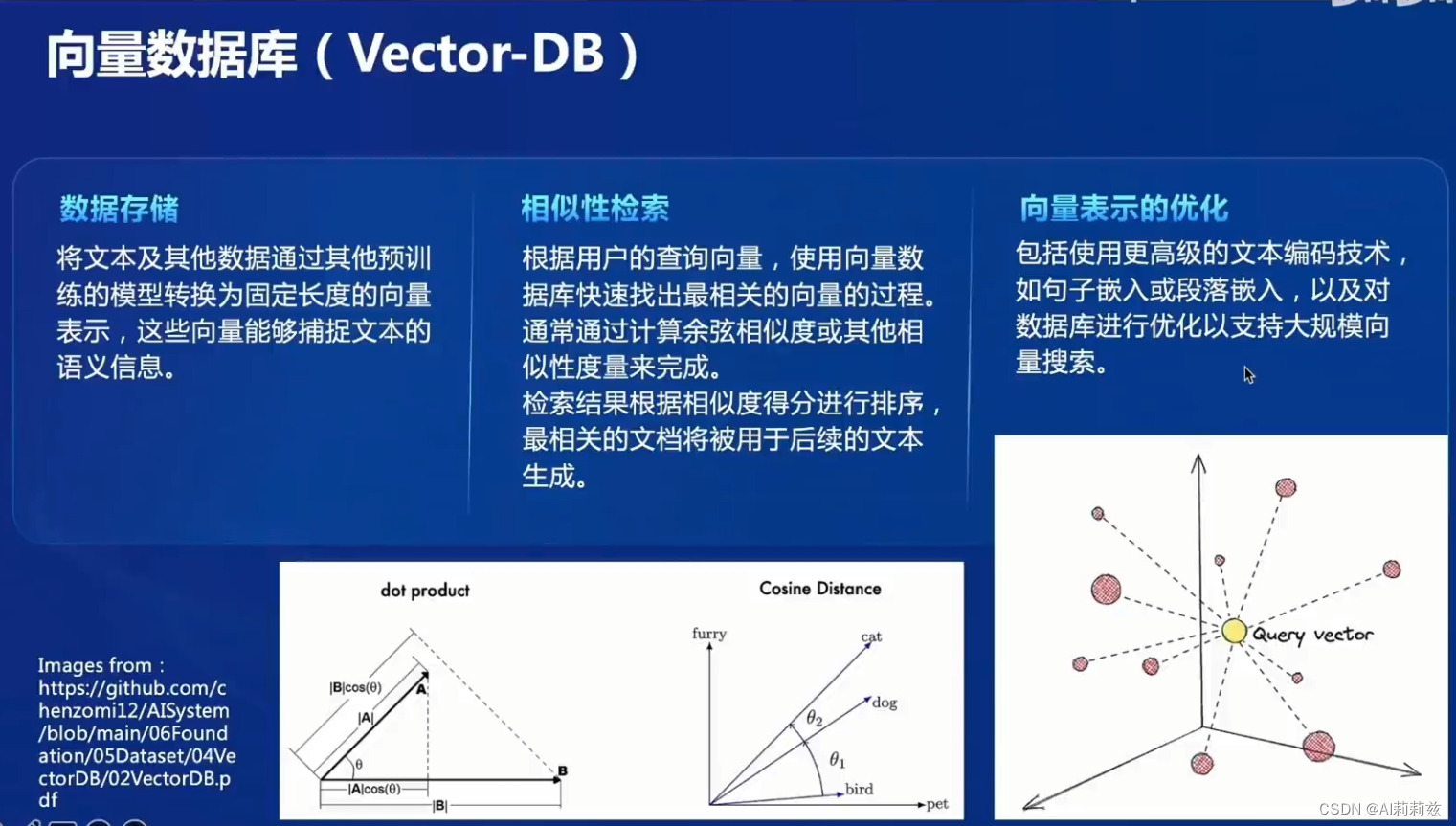

向量数据库

实践中召回部分一般需要基于 term + 基于表示的向量多路召回,尤其在一些医疗不充分、embedding 很难训好的领域,传统方法例如 BM25等等还是需要的。

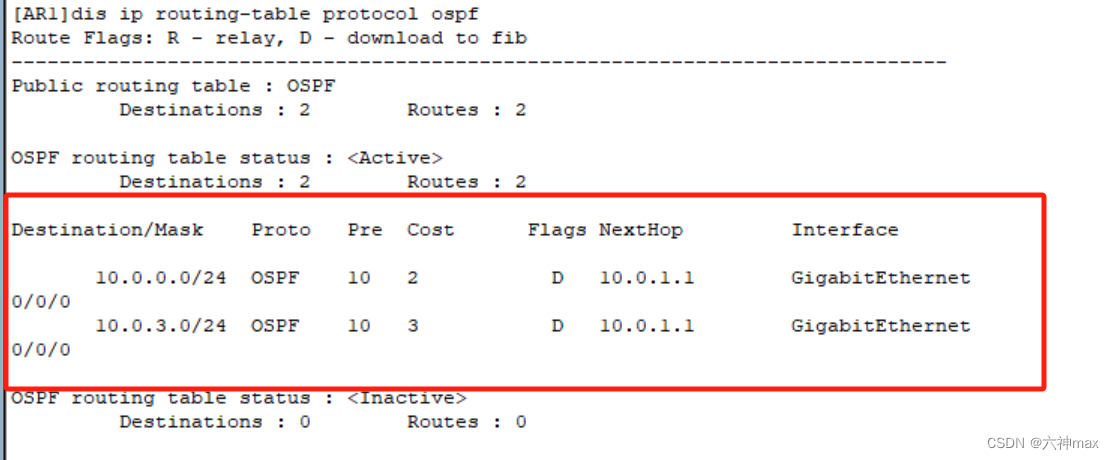

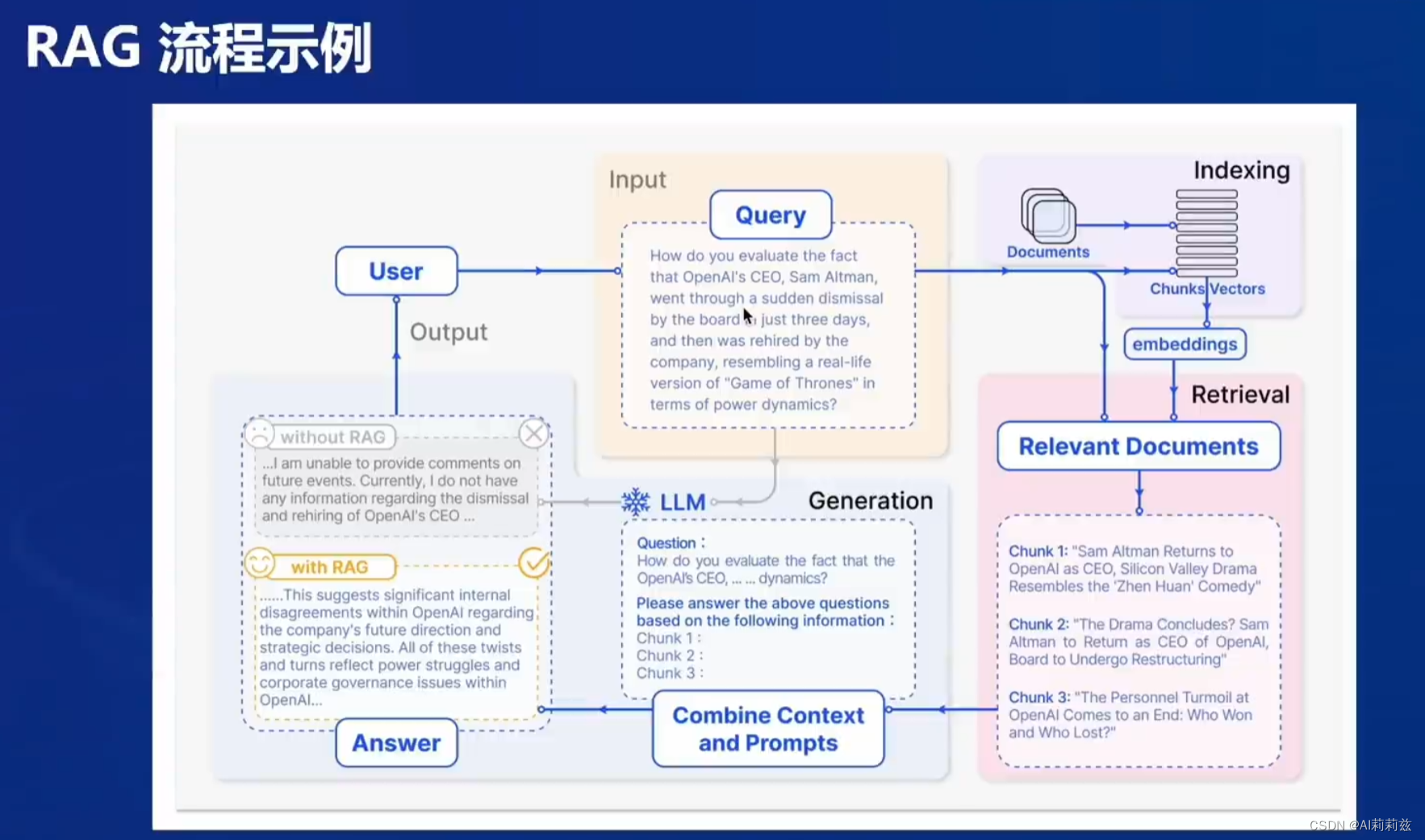

RAG 工作流程

图上例子很典型,尤其具有时效性的事实性的信息,很难通过微调处理。

发展历程

其实后面有点像之前的检索系统了,各个模块逐渐独立出来,分别优化。

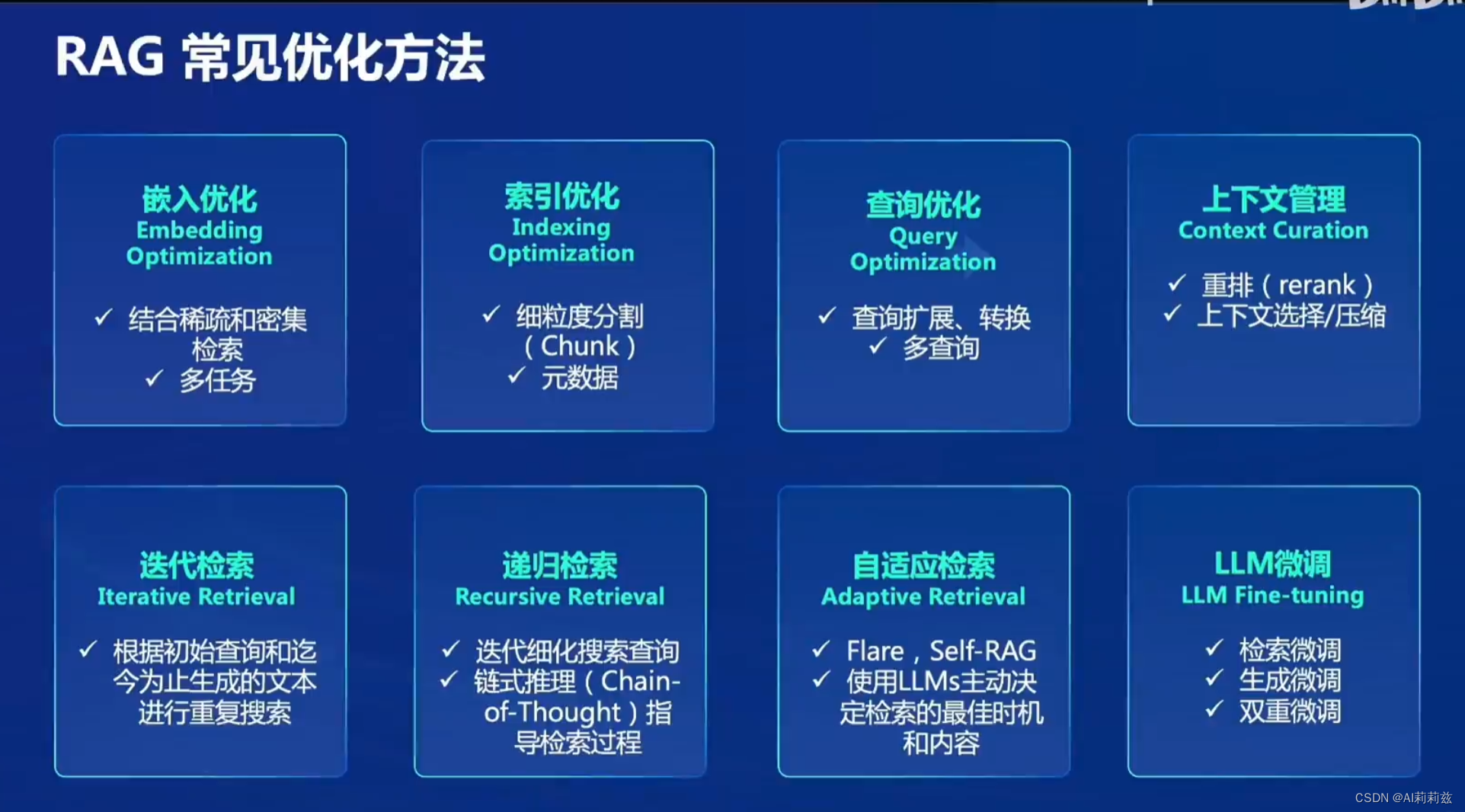

常见优化

可以看到这里总结的 RAG 优化,主要优化部分放在了 R 的部分

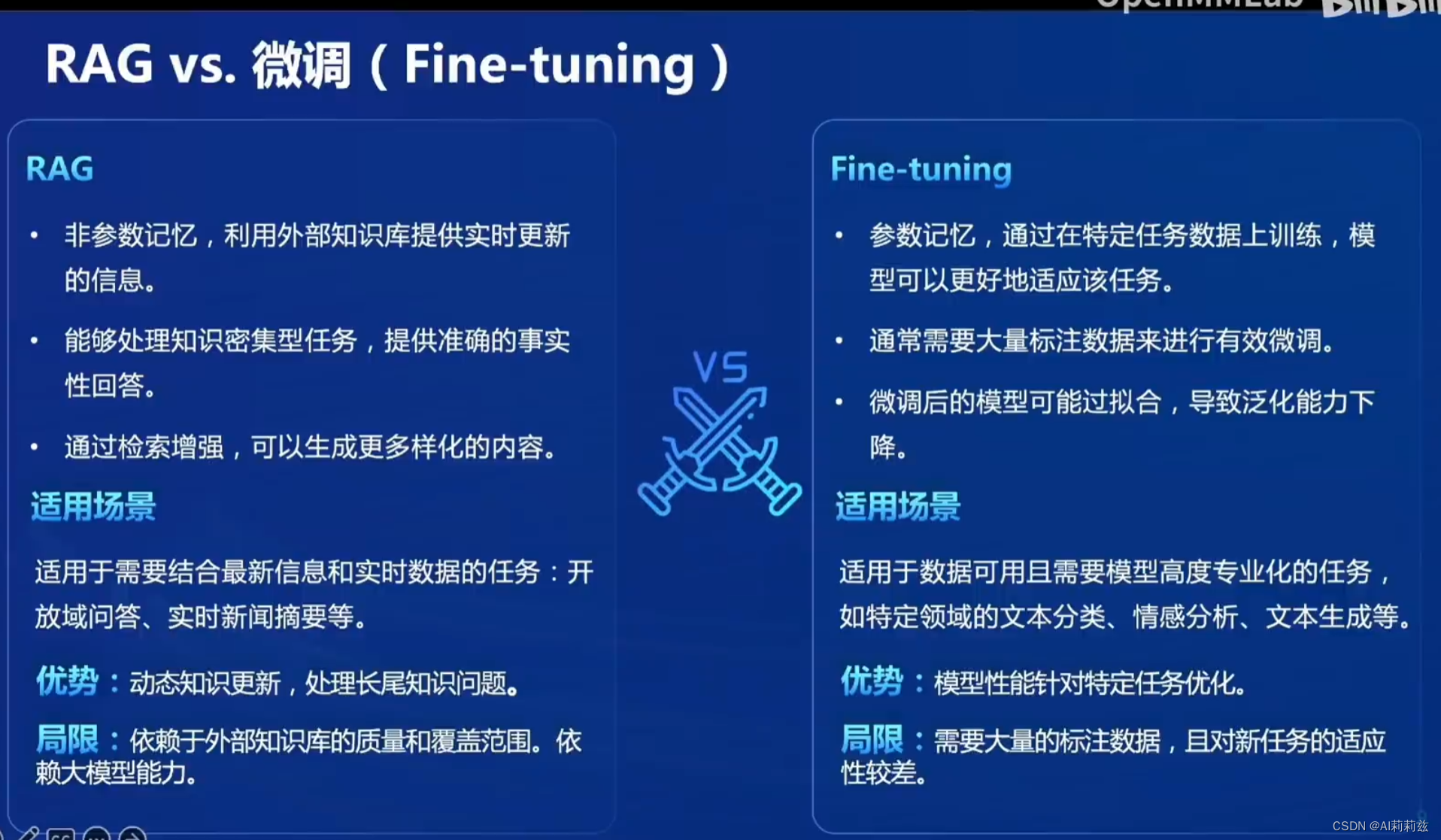

RAG vs 微调

微调相对存在一些不可控情形,如果是信息密集且需要高保真度的场景,一般不推荐上来就做微调。

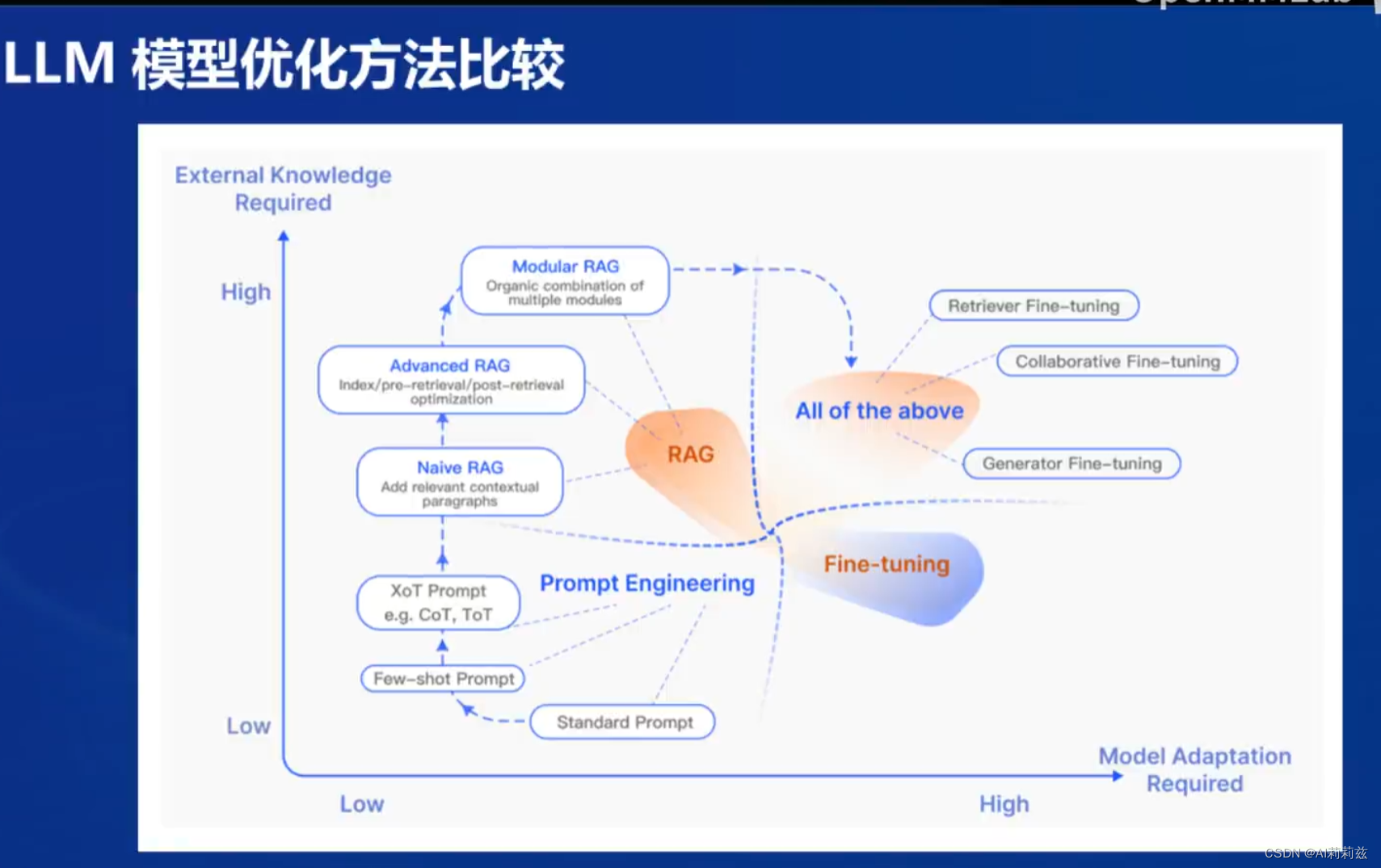

LLM 优化方法比较

这里的总结也挺全的,基本上生产环境开发,可以考虑这样的优化链路。

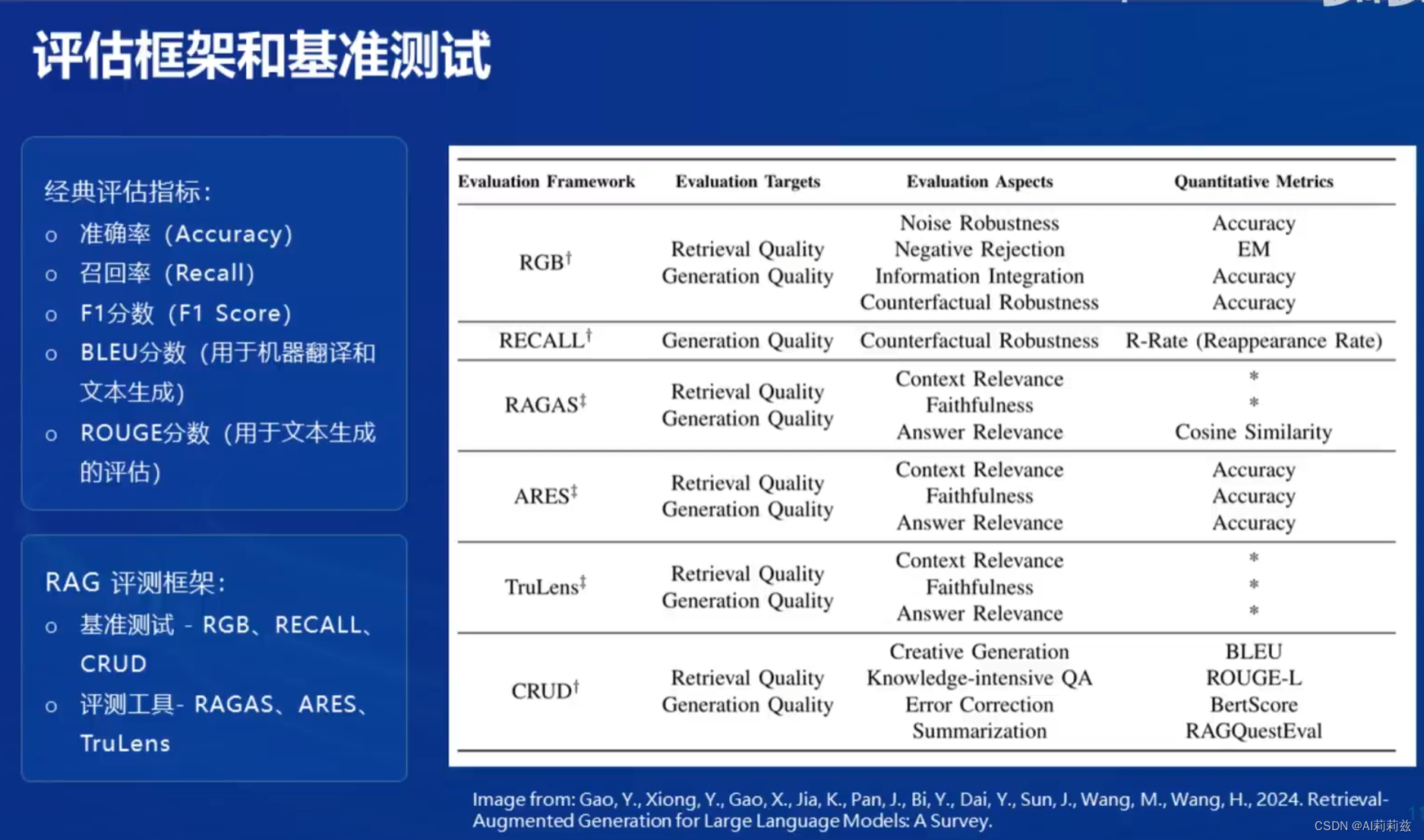

RAG的评价

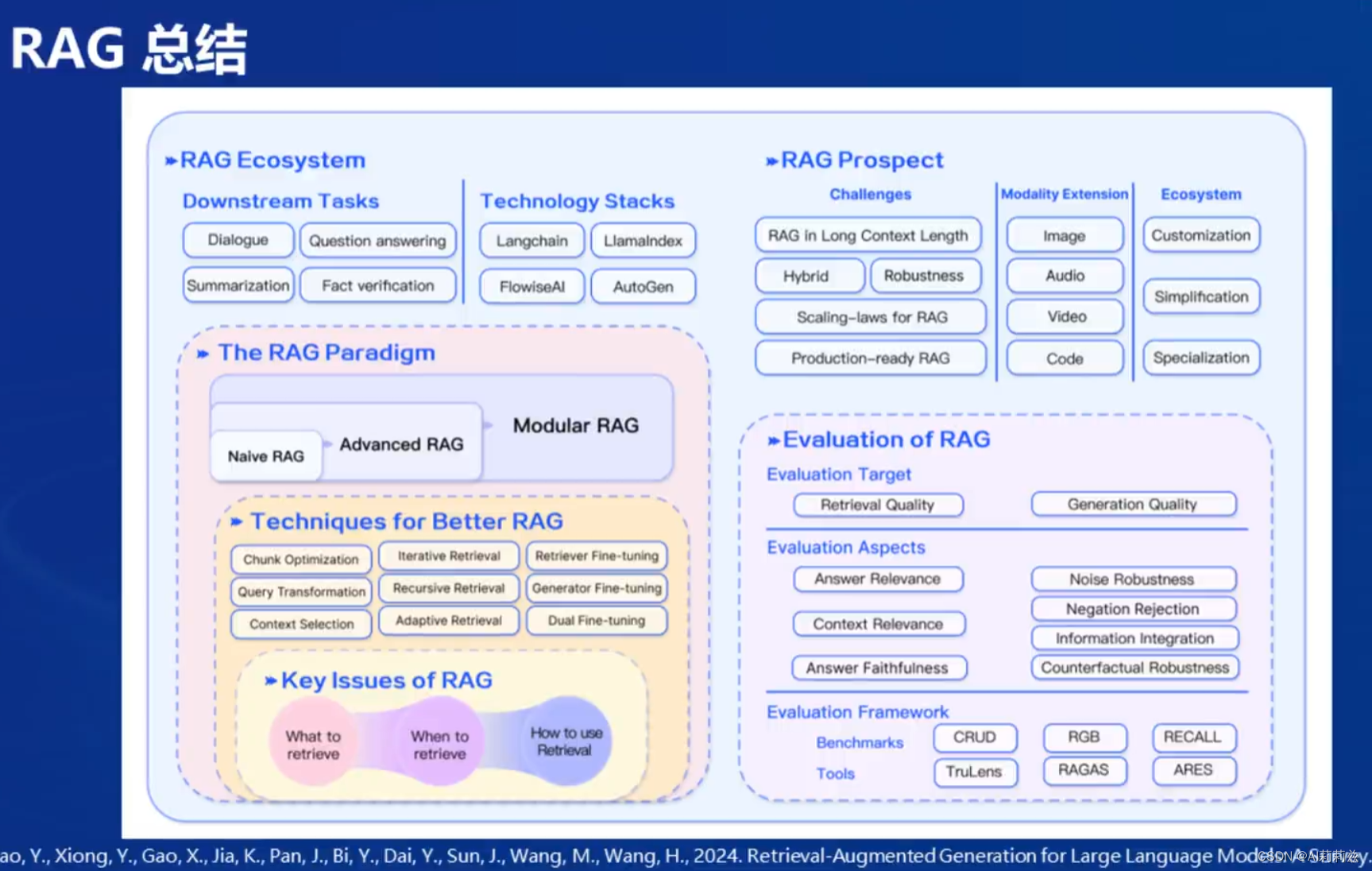

总结

笔记-茴香豆

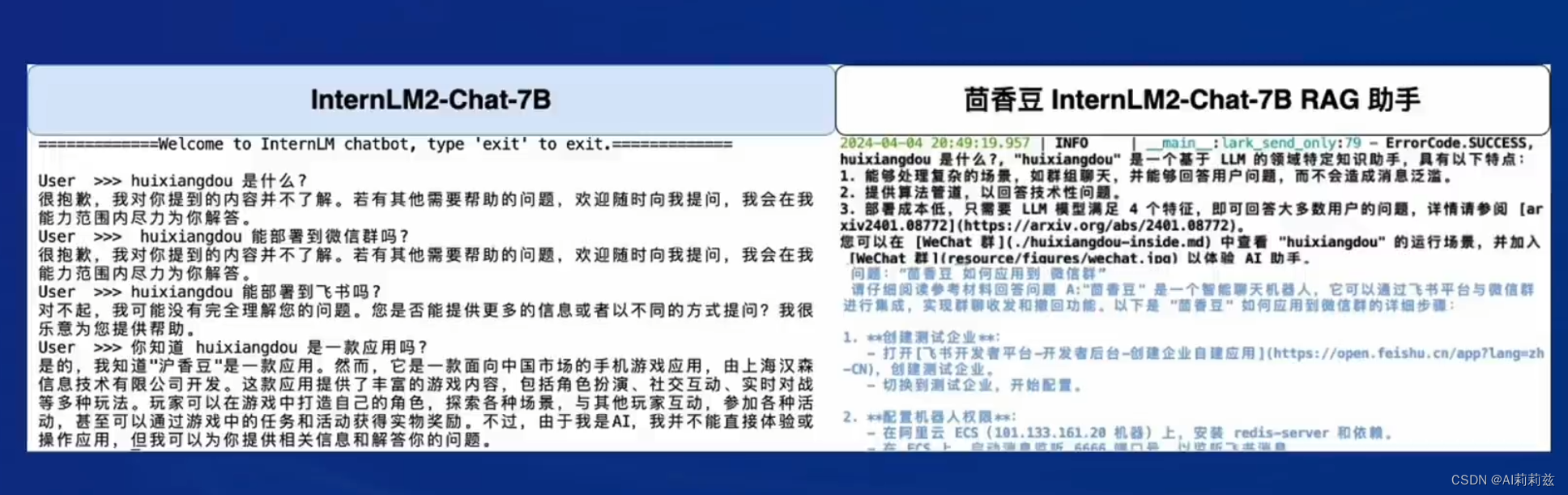

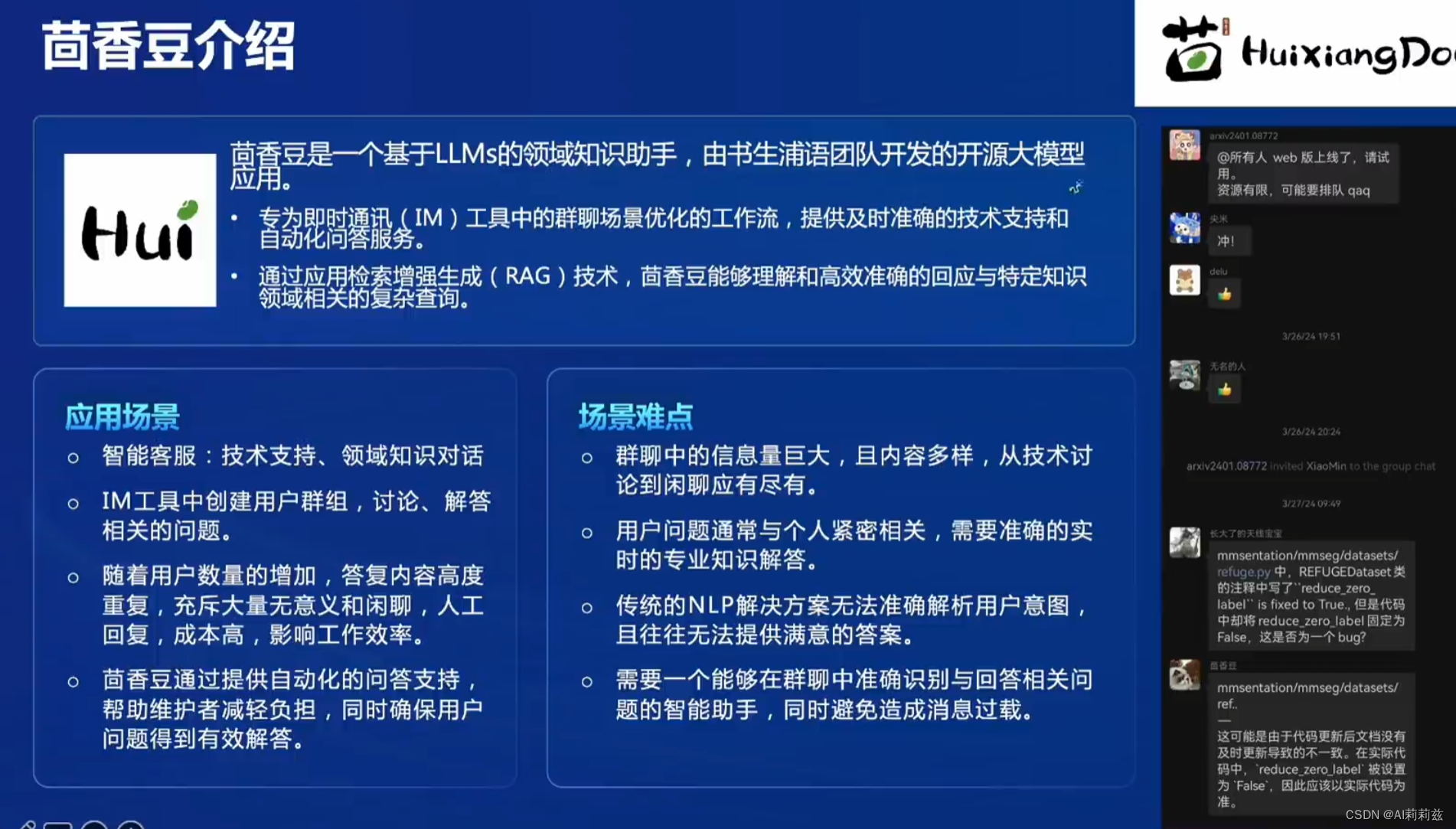

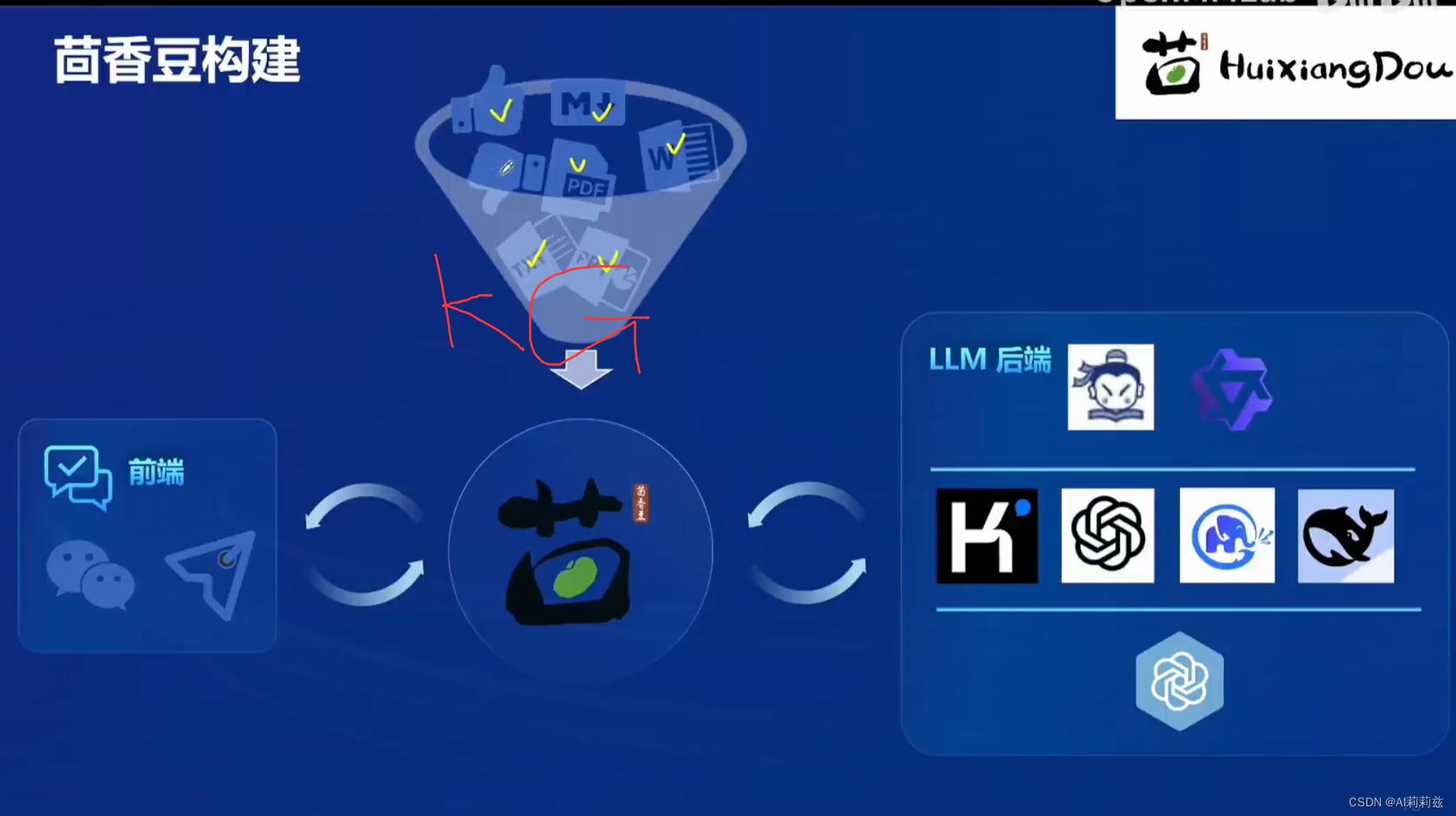

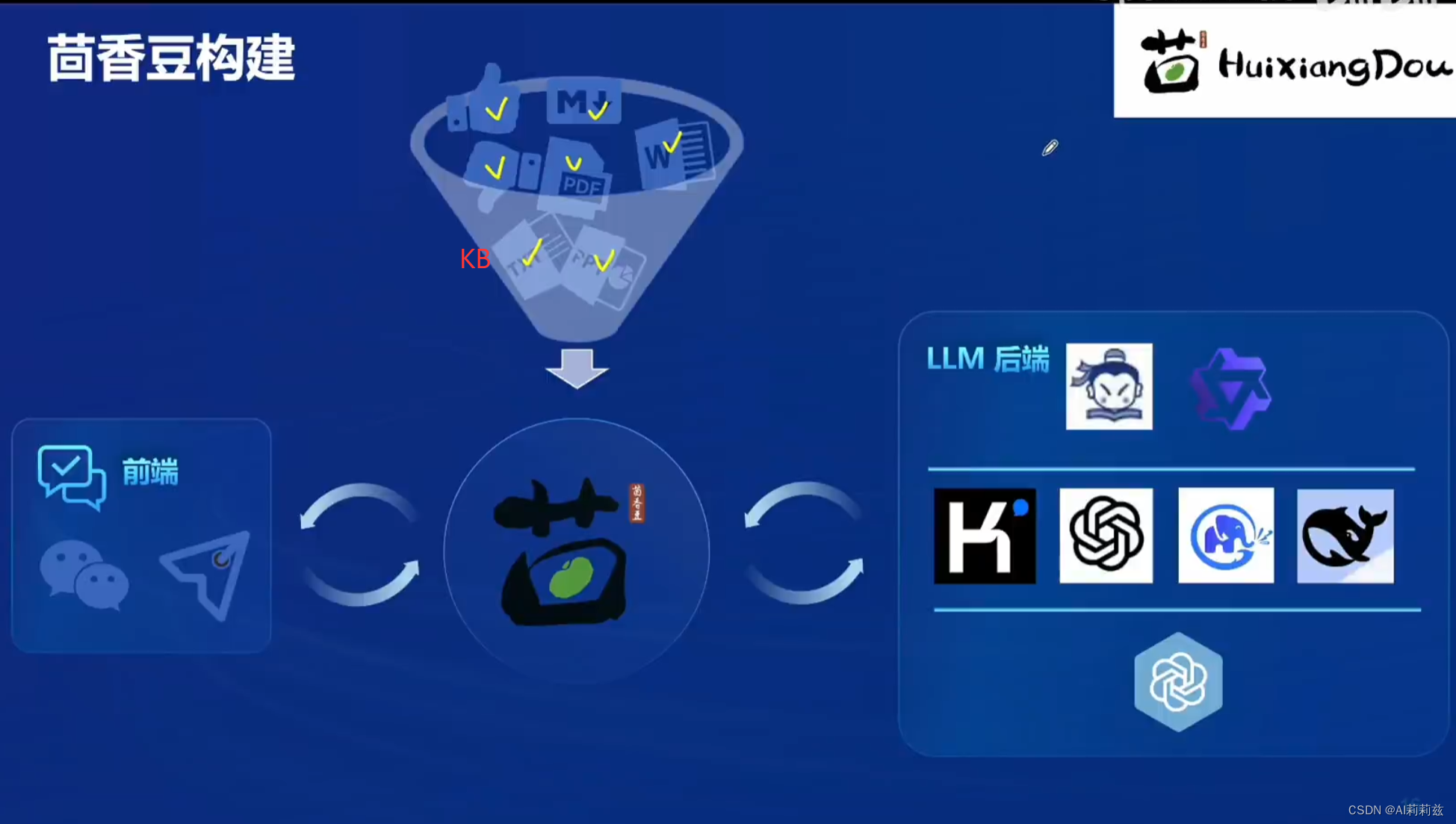

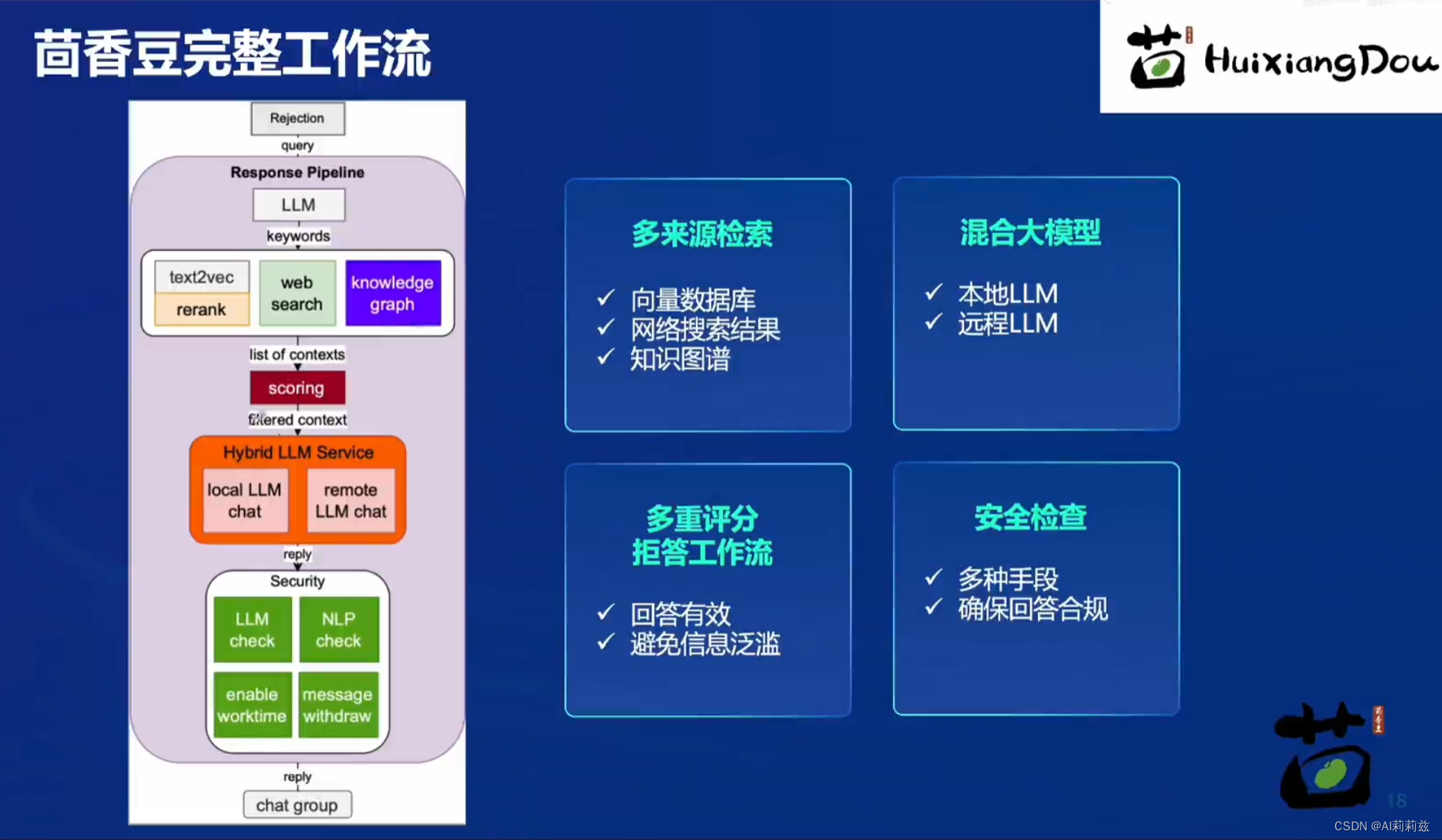

什么是茴香豆

两篇技术报告写得很好,推荐开发者去读一下,很多问题并不是新问题,但在新技术场景下可以尝试不同的解决方案。

看来浦语对茴香豆的定位升级成平台性产品了。

茴香豆实战

视频中视频,笑死。这是白牛老师的真声吗?

跟教程同步做部署,第一步又是要了命的准备环境。猜猜这次需要多久……

对了发现如果是配环境比较花时间,可以先启动一个算力点消耗更少的开发机,全部装完后再切换过去。

……一路按照教程运行至向量化

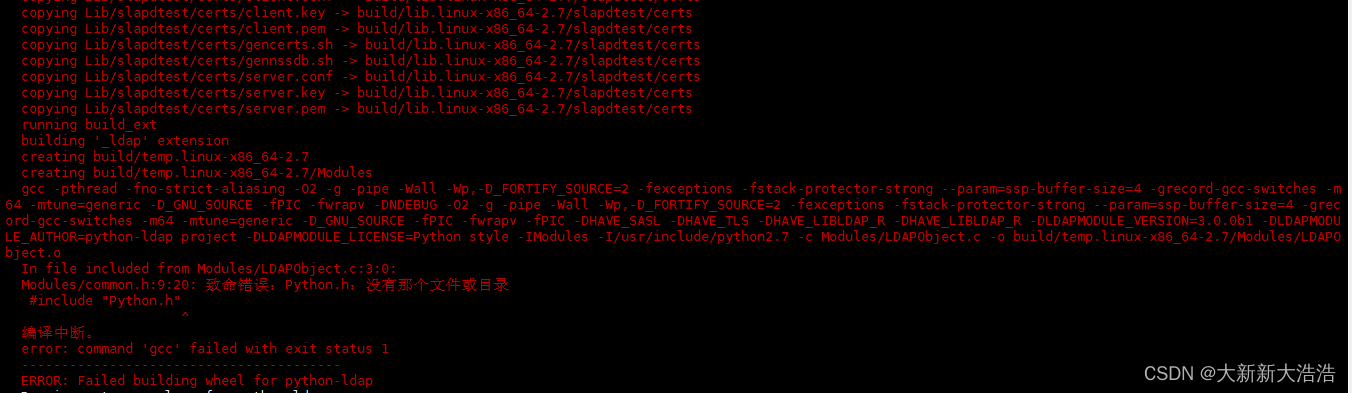

python3 -m huixiangdou.service.feature_store --sample ./test_queries.jsonTraceback (most recent call last):File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/runpy.py", line 187, in _run_module_as_mainmod_name, mod_spec, code = _get_module_details(mod_name, _Error)File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/runpy.py", line 110, in _get_module_details__import__(pkg_name)File "/root/huixiangdou/huixiangdou/__init__.py", line 4, in <module>from .service import ChatClient # noqa E401File "/root/huixiangdou/huixiangdou/service/__init__.py", line 17, in <module>from .web_search import WebSearch # noqa E401File "/root/huixiangdou/huixiangdou/service/web_search.py", line 11, in <module>from duckduckgo_search import DDGS

ModuleNotFoundError: No module named 'duckduckgo_search'

是教程没更新吗?安装这个包再试试,又出现了新的错误:

python3 -m huixiangdou.service.feature_store --sample ./test_queries.json

/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/runpy.py:126: RuntimeWarning: 'huixiangdou.service.feature_store' found in sys.modules after import of package 'huixiangdou.service', but prior to execution of 'huixiangdou.service.feature_store'; this may result in unpredictable behaviourwarn(RuntimeWarning(msg))

Traceback (most recent call last):File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/runpy.py", line 196, in _run_module_as_mainreturn _run_code(code, main_globals, None,File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/runpy.py", line 86, in _run_codeexec(code, run_globals)File "/root/huixiangdou/huixiangdou/service/feature_store.py", line 531, in <module>cache = CacheRetriever(config_path=args.config_path)File "/root/huixiangdou/huixiangdou/service/retriever.py", line 220, in __init__config = pytoml.load(f)['feature_store']File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/site-packages/pytoml/parser.py", line 11, in loadreturn loads(fin.read(), translate=translate, object_pairs_hook=object_pairs_hook, filename=getattr(fin, 'name', repr(fin)))File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/site-packages/pytoml/parser.py", line 43, in loadserror('duplicate_keys. Key "{0}" was used more than once.'.format(k))File "/root/.conda/envs/InternLM2_Huixiangdou/lib/python3.10/site-packages/pytoml/parser.py", line 27, in errorraise TomlError(msg, pos[0], pos[1], filename)

pytoml.core.TomlError: config.ini(31, 1): duplicate_keys. Key "local_llm_path" was used more than once.

看来今天的探索要暂时告一段落了……