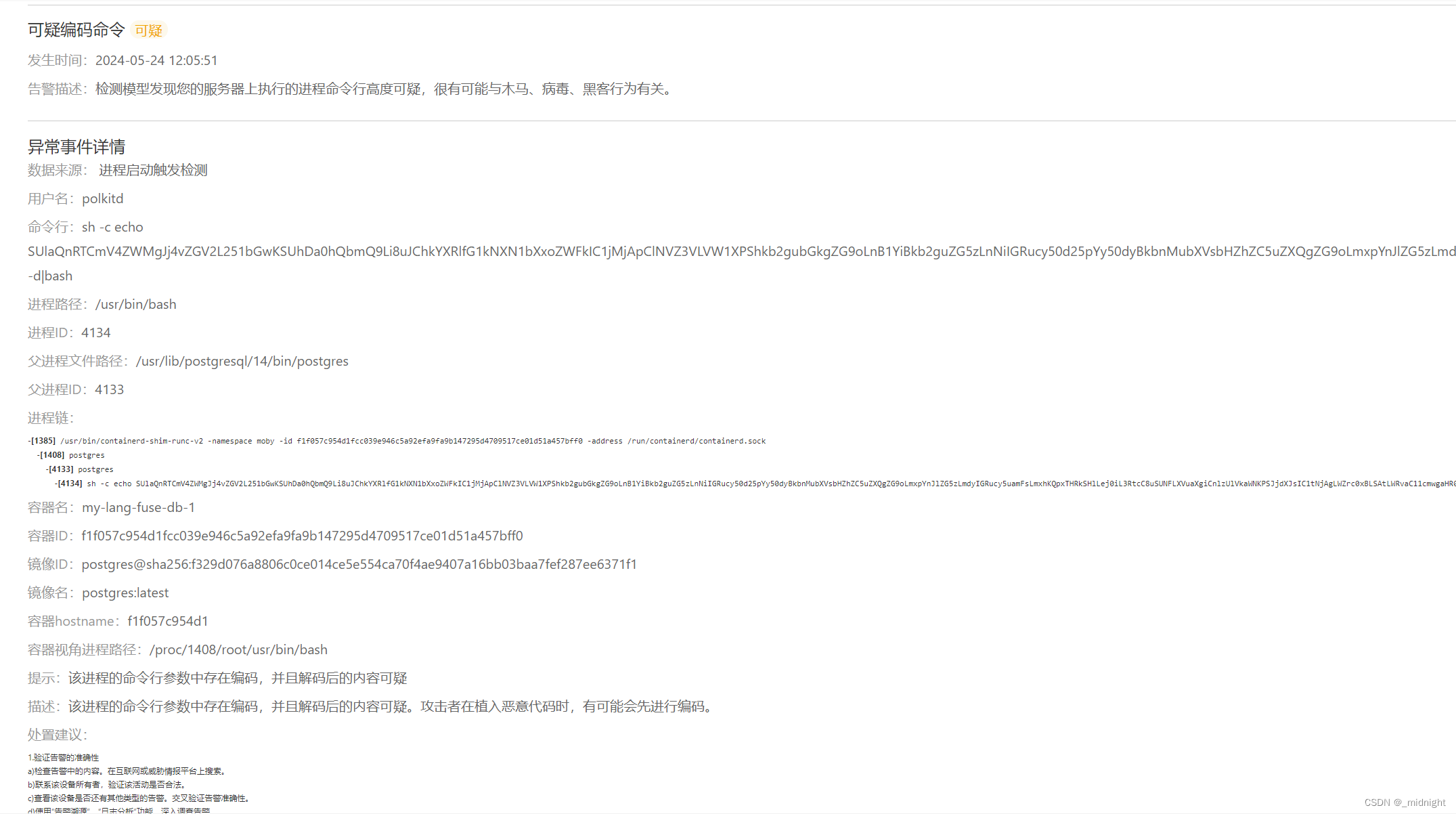

引言

在当今商业环境中,客户流失分析是至关重要的一环。随着市场竞争的加剧,企业需要更加注重保持现有客户,并深入了解他们的离开原因。本文探讨了用户流失分析的核心概念以及如何构建客户流失预测模型的案例。通过分析用户行为数据和交易模式,以及利用机器学习算法,企业可以更好地预测潜在的流失风险,并采取相应措施提高客户满意度。随着持续性的监控和迭代,企业将能够建立智能化的流失分析体系,为业务发展提供持续支持。

什么是用户流失分析?

用户流失分析是企业用户分析中至关重要的一环。在商业环境中,获得一个新客户的成本远高于维持一个老客户的成本。因此,每当企业失去一个客户时,需要花费更多的成本去获取一个新的客户。

造成客户流失的原因有很多,可能包括对产品服务质量不满意、同行竞争以及客户需求的变化等。用户流失分析旨在帮助企业分析用户流失的原因。

通过识别流失背后的原因,企业可以制定有针对性的策略,以保留客户并增强整体客户满意度。

要完成客户流失分析,首先需要明确一些关键的概念和定义,包括:

- 谁是用户?

- 如何定义流失?

谁是用户?

在用户流失分析中,用户的定义非常重要。

广义上来说,用户可以是任何人。用户可以是直接为企业提供利润的付费用户,也可以是使用企业服务和产品但没有直接付费的免费用户,还包括潜在客户,即可能在未来成为付费用户的人。

然而,在流失分析中,我们主要关注的是企业提供服务和产品的免费用户和付费用户。

从企业利润的角度来看,我们更关注付费用户的流失,因为他们直接影响企业的收入。但同时,免费用户也同不能忽视,因为他们可能会在未来转化成付费用户。

付费和免费用户的区分主要存在于现代互联网软件等企业中。

不同行业或业务对用户的定义可能有所不同。例如,对于会员制的精品超市,可能更关注会员流失的情况;而银行和金融机构则更直接,只要账户仍处于激活状态,就被视为正常用户。

如何定义流失?

流失用户的定义同样会因行业和业务而异。

在付费软件行业,流失用户可能是会员期已过、服务终止,即用户未续费或未购买企业的服务和产品。在游戏行业,流失用户可能根据多久没有登录游戏来划分,比如七天、一个月或一年。在银行和金融行业,流失用户可能是在一定时间内没有任何交易记录且个人信息过期。

不同的判定标准,直接影响分析的结果。因此,分析师需要根据对行业和业务的了解,识别出合适的流失指标。确定流失用户的定义是进行用户流失分析的关键问题之一。

流失分析不是一次性的任务

流失分析是一个持续性的工作,需要长期监控和迭代。

我们需要定期监控客户的行为和异常指标,并根据数据反馈及时调整用户策略。商业环境和市场需求不断变化,包括行业中的其他产品也在不断更新,因此分析方法和结论也会持续改变。

此外,我们也要意识到数据存在一定的延迟性。从产品服务的调整,到用户接受反馈,在到数据收集和指标变化,整个过程需要一定的时间。因此,除了依赖数字,我们还需要具备商业前瞻性和敏感度,深入了解用户需求和情况,以便在数据之前进行判断和预测。

分析流程概述

作为数据分析师,我们的目标是尽可能地获取与流失客户相关的数据。收集整理好这些数据后,我们可以有针对性地进行挖掘和分析。首先,我们会执行一系列数据分析流程,比如探索性数据分析和相关性分析,从而理解数据背后的故事。通过分析交易数据和用户行为数据,我们可以初步了解问题的集中点,比如可能流失用户集中在特定产品、特定客服团队,或者属于某一类人群。

除了数据分析,我们还可以借助客户反馈进行深入调研。通过审查客户反馈、评论和投诉,我们可以了解客户的痛点和不满之处。此外,我们还可以通过问卷调查或直接沟通,与客户交流,获取他们离开的具体原因。

最后,我们可以利用历史数据构建预测模型,预测未来可能流失的用户。通过提取和处理关键性特征,我们可以建立一个准确的预测模型,帮助我们提前发现潜在的流失风险,并采取措施去激活和挽回这些用户。

流失分析可以帮助企业更全面地了解客户流失的原因,并采取有效的措施来提高客户满意度,减少流失率。

步骤1:数据收集

- 收集相关数据: 在这一步骤中,我们需要收集与客户互动、交易和行为相关的数据。这包括购买历史、使用模式、客户互动以及人口统计信息等。

- 数据来源: 数据的来源多种多样,我们可以利用现有的客户关系管理系统、交易日志、客户调研等渠道。这些数据源的整合将为我们提供更加全面和准确的数据视角。

步骤2:定义流失

- 定义流失指标: 明确定义客户流失,如一段时间内未进行购买、取消订阅或表示不满意的反馈。

- 流失时间范围: 确定衡量流失的时间范围,如每月、每季度或每年,具体取决于业务的特性和需求。

步骤3:数据清理和预处理

- 包括处理缺失数据、删除重复值、去除异常值等预处理操作,识别并去除可能扭曲分析结果的异常值,以确保分析的准确性。

步骤4:特征选择

- 确定相关特征: 确定与流失分析相关的主要数据特征,如使用频率、购买历史、客户人口统计信息和客户服务。将一些次要的、无关的数据特征删除,例如用户ID,用户姓名等。

- 相关性分析: 分析特征之间的相关性,以确定它们对流失的影响程度。

步骤5:探索性数据分析(EDA)

- 可视化数据: 使用直方图、散点图等数据可视化技术探索客户行为的模式和趋势。

- 描述性统计: 计算关键变量的描述性统计,了解它们的分布和中心趋势。

步骤6:构建预测模型

- 训练/测试集分割: 将数据分成训练集和测试集,用于训练和评估预测模型的性能。

- 选择模型: 选择适用于流失分析的预测模型,如逻辑回归、决策树或机器学习算法。

- 特征重要性: 分析特征的重要性,了解哪些因素对于预测流失最为关键。

步骤7:模型评估

- 指标选择: 使用准确度、精确度、召回率和F1分数等指标评估模型的性能,并根据需要调整。

步骤8:解释结果

- 确定流失因素: 通过解读模型的输出,我们可以确定影响流失的关键因素以及它们的影响程度。这有助于我们深入理解客户流失的原因,并制定相应的应对策略。

步骤9:实施缓解策略

- 制定留存策略: 根据分析结果制定有针对性的留存策略是流失分析的目标之一。这可能包括个性化服务、会员计划、产品服务改进等措施,旨在提高客户满意度,减少流失率。

步骤10:监控和迭代

- 持续监控: 定期监控流失指标和客户行为,并根据持续的数据分析调整留存策略。

- 迭代分析: 不断迭代流失分析过程,以适应新数据的到来或业务状况的变化。这意味着我们需要不断学习和改进,以建立更加智能和适应性的流失分析体系。

用户流失分析与其他分析的差异

在进行流失分析时,与其他用户或销售分析的不同之处在于其侧重点和分析角度。

-

侧重点的不同:

销售数据和整体用户数据分析通常侧重于了解当前的销售趋势、客户行为和整体市场表现。 这些分析主要用于评估业绩和市场份额,帮助企业制定营销策略和销售计划。用户流失分析更专注于探索客户流失的原因和模式。它是一种以特定问题为导向的分析方式,关注的是为何客户选择离开,以及如何防止或减少这种流失。用户流失分析致力于识别潜在的问题点,并采取措施挽留现有客户。

-

分析角度的不同:

产品销售分析,都是从产品和销售业绩的角度出发,关注产品特性、市场趋势和竞争情况等方面。 而缺乏从客户角度出发的视角。 在产品维度上,我们可以发现产品的表现如何以及销售成绩是否受欢迎。

然而,从用户个人的角度来看,他们是否想要继续与我们交易或使用我们的服务,可能会受到多种因素的影响。 当确定是否退出游戏或停止使用某项服务时,通常并非由于单一产品的表现不佳,而可能是多种因素的综合作用。比如,售后服务不佳加上产品本身存在问题,这些因素的累积可能导致客户流失。

另外,用户个人生活和工作的变化也可能导致他们不再需要某项服务,这种变化并不代表产品或服务的质量有问题。在这种情况下,企业优化自身产品或服务可能并不是解决问题的最佳途径,而更重要的是了解市场需求并满足市场需求。

总结来说,用户流失分析是从以客户的视角出发,关注客户体验、满意度和忠诚度。 它更注重理解客户需求、行为和反馈,以提高客户保留率和忠诚度。因此,在进行用户分析时,我们需要尽可能收集更多的数据,这些数据不仅涵盖产品方面,还包括客户的个人信息、用户体验等情况。这些数据是用户和企业之间所有互动交流的记录。

用户流失分析的特点和独特价值:

- 深入挖掘潜在问题: 用户流失分析通过深入挖掘客户流失的原因和模式,帮助企业发现潜在的问题点,从而及时采取措施加以解决。

- 提升客户体验: 通过理解客户需求和行为,用户流失分析有助于优化产品和服务,提升客户体验和满意度,从而增强客户忠诚度和长期价值。

- 降低成本风险: 防止客户流失比吸引新客户更经济高效。用户流失分析可以帮助企业降低客户流失率,减少市场推广和客户获取的成本。

- 提高竞争力: 通过持续改进产品和服务,以及保持客户满意度和忠诚度,企业能够提高其在竞争激烈的市场中的地位和竞争力。

案例:电信行业的客户流失预测模型

项目背景: 在电信行业,顾客可以从各种服务提供商中选择。顾客流失被定义为顾客停止与公司或服务进行业务往来的情况。项目任务是使用提供的其余数据建立一个预测客户流失的模型。

数据集介绍: 此数据集包括电信公司的客户数据,包括服务使用情况、人口统计数据以及客户是否流失。

import pandas as pd

import numpy as np

from sklearn.model_selection import train_test_split, cross_val_score, KFold

from sklearn.preprocessing import StandardScaler, OneHotEncoder,LabelEncoder

from sklearn.impute import SimpleImputer

from sklearn.pipeline import Pipeline

from sklearn.ensemble import RandomForestClassifier

from xgboost import XGBClassifier

from catboost import CatBoostClassifier

from sklearn.metrics import accuracy_score

from sklearn.compose import ColumnTransformer

import matplotlib.pyplot as plt

import seaborn as snsdata==pd.read_csv('WA_Fn-UseC_-Telco-Customer-Churn.csv')

target='Churn'y = data[target]

X=data.drop(target,axis=1)if not all(isinstance(val, int) for val in y):label_encoder = LabelEncoder()y = label_encoder.fit_transform(y)

else:ynumerical_cols = X.select_dtypes(include=[np.number]).columns.tolist()

categorical_cols = X.select_dtypes(include=[object]).columns.tolist()# Preprocessor Pipeline setup

numerical_transformer = Pipeline([('imputer', SimpleImputer(strategy='mean')),('scaler', StandardScaler())

])categorical_transformer = Pipeline([('imputer', SimpleImputer(strategy='most_frequent')),('onehot', OneHotEncoder(handle_unknown='ignore'))

])preprocessor = ColumnTransformer(transformers=[('num', numerical_transformer, numerical_cols),('cat', categorical_transformer, categorical_cols)])# train test split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# Model training pipeline

models = {'RandomForest': RandomForestClassifier(),'XGBoost': XGBClassifier(),'CatBoost': CatBoostClassifier(verbose=0)

}pipeline_results = {}for name, model in models.items():pipeline = Pipeline([('preprocessor', preprocessor),('classifier', model)])kf = KFold(n_splits=5, shuffle=True, random_state=42)cv_results = cross_val_score(pipeline, X_train, y_train, cv=kf, scoring='accuracy')pipeline_results[name] = cv_results.mean()# print results

print(pipeline_results)

![![[2F 用户流失分析-20240512211312509.webp|688]]](https://img-blog.csdnimg.cn/direct/69e28fddeed94b12b4b6ca95bb71b021.png)

三种模型的准确度都在80%左右,其中catboost 表现最好,RF其次,XGB最后。

# Select the best model

best_model_name = max(pipeline_results, key=pipeline_results.get)

best_pipeline = Pipeline([('preprocessor', preprocessor),('classifier', models[best_model_name])

])

best_pipeline.fit(X_train, y_train)

![![[2F 用户流失分析-20240512211356463.webp]]](https://img-blog.csdnimg.cn/direct/2328a46c774943c08d140d91c2f63220.png)

# Printing the accuracy of the best model

y_pred = best_pipeline.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f'Best Model: {best_model_name}')

print(f'Accuracy: {accuracy}')

![![[2F 用户流失分析-20240512211417933.webp]]](https://img-blog.csdnimg.cn/direct/0e30f8481cd94acfb50d129f516ca8fd.png)

在测试集上的结果显示准确率是81%左右,使用的是catboost模型

# Get column names

numerical_cols = preprocessor.named_transformers_['num'].get_feature_names_out(input_features=numerical_cols)

categorical_cols_encoded = preprocessor.named_transformers_['cat'].named_steps['onehot'].get_feature_names_out(input_features=categorical_cols)

all_columns = list(numerical_cols) + list(categorical_cols_encoded)# get feature importance

feature_importance = model.feature_importances_# dataframe

feature_importance_df = pd.DataFrame({'Feature': all_columns, 'Importance': feature_importance})

feature_importance_df = feature_importance_df.sort_values(by='Importance', ascending=False)

feature_importance_df= feature_importance_df.head(10)# visualise top 10 features

plt.figure(figsize=(10, 6))

sns.barplot(x='Importance', y='Feature', data=feature_importance_df)

plt.title('Feature Importance')

plt.xlabel('Importance')

plt.ylabel('Feature')

plt.show()

![![[2F 用户流失分析-20240512211641791.webp]]](https://img-blog.csdnimg.cn/direct/69824ec14fa84539b83a191ce3bebf6d.png)

总结

每个企业的流失分析过程可能会有所不同,具体的方法和模型选择取决于业务的性质、可用的数据以及分析的目标。在实施过程中,密切关注数据的质量和实时性是确保分析有效性的关键因素。通过不断学习和改进,企业可以建立更加智能和适应性的客户流失分析体系,为保持客户忠诚度和提高业务绩效提供有力支持。

数据集下载方式见:🔍原文 或《用户流失分析数据资料》