晴数智慧(Magic Data)联合西北工业大学音频语音与语言处理研究组(ASLP@NPU)、新加坡资讯通讯研究院(I2R)、深圳大数据研究院(SRIBD)、香港中文大学(深圳)等多家单位在2024年中文口语语言处理国际会议(ISCSLP2024)上推出对话语音克隆挑战赛(Conversational Voice Clone Challenge — CoVoC),在开源1万小时的WenetSpeech4TTS数据集和180小时的普通话自然对话语音数据的基础上,参加赛事将获得100小时的高质量对话数据。快来报名参赛吧!

背景

文语转换(TTS)旨在生成听起来尽可能自然且类似人类的语音。随着语音合成技术的飞速发展,合成音频的质量和自然度得到了显著的提高,促进了TTS系统在诸多场景中的广泛应用。大规模数据和大模型(LLM、Diffusion)的应用(例如:VALL-E,NaturalSpeech,TorToise等)让零样本TTS (Zero-shot TTS)在生成质量以及音色相似度上取得显著突破,引起了学术界和工业界的广泛关注。同时,合成语音的自然度达到真人水平。OpenAI、11Labs、微软和字节等科技巨头均已上线超自然的对话TTS。然而,语音生成中自发行为和对话方面尚未得到充分研究。具体而言,主要挑战在于如何有效控制生成语音中的韵律细节,以区分自发语音和朗读语音间的多样化和复杂自发行为。大规模TTS系统具有强大的上下文学习能力,有望在零样本TTS以及对话场景中取得更好的效果。但在零样本TTS研究领域,当下各个方案采用的训练/测试数据集无法完全对齐,以及缺乏效果的标准评估。这一问题阻碍了不同系统间的直接对比,使得公平评估各种系统的性能变得十分迫切。

为了推动零样本场景下富有表现力的、具有自发行为风格的语音合成技术的发展,我们在2024年中文口语语言处理国际会议(ISCSLP2024)上推出对话语音克隆挑战赛(Conversational Voice Clone Challenge — CoVoC)。该赛事基于多个训练数据集,包括1万小时的WenetSpeech4TTS数据集,180小时的普通话自然对话语音数据以及100小时的高质量口语对话数据。此外,我们将提供一个标准测试数据集,包括多个克隆说话人和多样化的文本,旨在提供一个中文音色克隆的测试基准。

ISCLP2024官网:http://www.iscslp2024.com

CoVoC竞赛官网:https://www.magicdatatech.com/iscslp-2024

数据

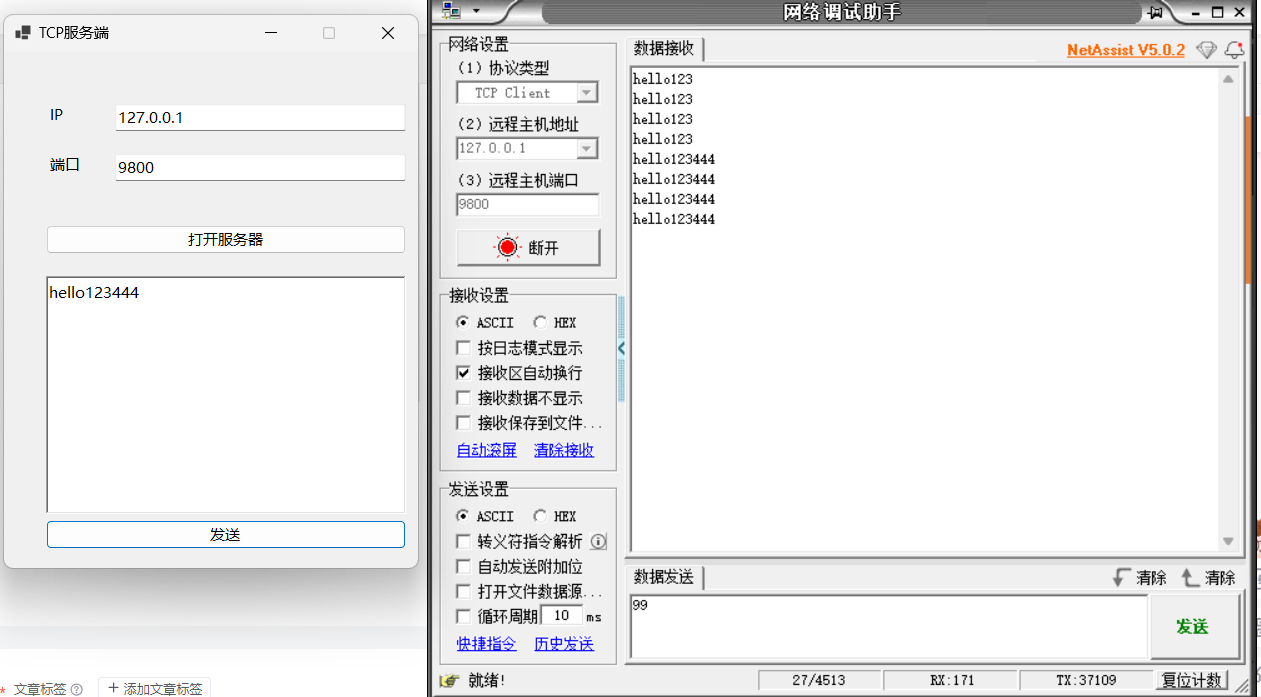

竞赛组织方为参赛者在不同阶段提供四个音频/文本数据集。所有音频数据将采用单声道WAV格式,采样率为16KHz,采用16位编码。

在训练阶段,参赛者可以使用大规模的WenetSpeech4TTS数据集,以及两个较小规模的数据集,即MAGICDATA和HQ-Conversations。参赛者可以自由地利用这些数据集进行模型训练或微调。

-

WenetSpeech4TTS:是一个源自开源的WenetSpeech数据集处理得到的适合TTS任务的多领域普通话语料库。针对TTS任务,通过调整片段边界、增强语音质量、去除多说话人片段等一系列操作对 WenetSpeech 进行了处理。经过更精确的语音识别获取文本标签,以及质量过滤之后,得到共包含12800小时的音频及对应文本标签,根据数据质量划分为Premium、Standard、Basic和Rest多个子集。

数据获取链接:https://huggingface.co/datasets/Wenetspeech4TTS/WenetSpeech4TTS

-

MAGICDATA:180小时的移动端录制的对话语音数据。来自国内不同地域的663说话人参与录制。录音在安静的室内环境中进行。所有语音数据都经过人工标注,并由专业检查员验证以确保标注质量。

数据获取链接:https://www.openslr.org/123/

-

HQ-Conversations: 该数据集包含200名说话人100小时高质量对话数据,其中男性75名,女性125名。这些对话涉及日常生活场景,自然且富有表现力。所有语音数据都经过人工标注,并由专业检查员验证以确保标注质量。

在竞赛评估阶段,参赛者需要在Clone-Speaker数据集上测试其模型的零样本音色克隆性能,生成Test-Text内目标文本对应的语音。

-

Clone-Speaker:我们将为竞赛评估提供20个测试说话人,每个说话人若干秒钟语音作为克隆的Prompt。

-

Test-Text:我们将提供全面测试文本,包括普通测试文本、具有自发行为的对话文本等。

赛道设置

CoVoC挑战设有两个赛道。

-

限制赛道:在训练阶段只允许使用上述提及的语料库。如果系统中使用了预训练模型,也必须是开源模型,并且使用的模型情况必须在最终提交中清楚地说明。在这个赛道中,排名靠前的团队将被邀请提交论文到ISCSLP会议中。

-

无限制赛道:除了我们提供的数据外,其他开源或内部语料库都可以在训练阶段使用。参赛者应该在与提交的技术报告中清楚描述所使用的数据规模和情况。参与这个赛道的团队需要填写一个表格,提供有关方案的详细信息。

规则

所有参赛者应遵守以下规则:

-

在竞赛中,发布的数据集仅供参赛者在竞赛期间和赛后研究目的使用,不允许商业使用。主办方将在赛后开源数据,数据的使用应遵守相应的开源许可。

-

在限制赛道中可以使用公开可用的预训练模型,而额外的训练数据只能在无约束赛道中使用。

-

最终解释权归竞赛组织者所有。组织者保留更改规则的权利。在特殊情况下,竞赛组织者将负责协调解释。

评估

主观评估

我们会组织专业测听人员进行平均意见分数(MOS)测试,以评估语音质量、语音自然度、说话者相似度和语音自发风格。主观评估标准:

-

语音自然度(Naturalness):在每次测评中,测听人员听取每个样本,并从1【完全不自然】到5【完全自然】的分数中选择评分。

-

语音质量(Quality):在每次测评中,测听人员将听取一个样本,并选择一个代表语音听起来质量好坏的分数,范围从1【质量极低】到5【质量高】。

-

说话者相似度(Similarity):在每次测评中,测听人员将听取原始说话人的两个参考样本和一个合成样本,他们将给出一个分数,代表合成语音与参考样本中的说话人声音之间的相似程度,分数从1【听起来像不同人的声音】到5【听起来像同一个人的声音】。

-

语音自发风格(Spontaneous):在这个测试中,我们会使用含有自发行为的文本进行测试。测听人员将听取每个样本,并在1【语音中的自发行为效果不好】到5【语音中的自发行为效果很好】的分数上选择一个评分。

客观评估

-

字符错误率(CER):对合成语音进行语音识别,识别结果与真实抄本计算字错误率。

-

说话人嵌入余弦相似度(SECS):通过提取说话者嵌入并计算余弦相似度来得到SECS度量。

客观评估结果将对所有提交团队进行评估和发布。主观评估仅针对客观得分高的前若干提交队伍进行。

时间线

| 时间 | 议程 |

| 2024年6月3日 | 竞赛注册开放和HQ-Conversations数据发布 |

| 2024年6月10日 | 基线系统发布 |

| 2024年6月30日 | 评估阶段开始;Clone-Speaker和Test-Text数据发布;挑战注册截止日期 |

| 2024年7月2日 | 评估结束;测试音频和系统描述提交截止日期 |

| 2024年7月12日 | 向参赛者发布评估结果 |

| 2024年7月20日 | ISCSLP2024论文提交截止日期(仅限受邀团队) |

注册参赛

注册ISCSLP CoVoC挑战,参赛者需要在2024年6月30日之前填写以下Google表单:

https://docs.google.com/forms/d/e/1FAIpQLSf-vZzn9DMEaYyIGvKE3qXpTLeTJ74aAnZYPbEftLTyCKE7sw/viewform?usp=pp_url

欢迎来自学术界和工业界的团队参加。

如果您在注册过程中遇到任何问题,请联系 xkx@mail.nwpu.edu.cn 寻求帮助。

组织者

-

谢磊,西北工业大学

-

张晴晴,晴数智慧

-

王帅,深圳大数据研究院(SRIBD)

-

罗磊,晴数智慧

-

董明会,新加坡资讯通讯研究院 (I2R)

-

薛浏蒙,香港中文大学(深圳)

-

姚继珣,西北工业大学

-

郭大可,西北工业大学

-

李函昭,西北工业大学

-

夏康翔,西北工业大学

声明

本次竞赛仅供促进学术研究之用,我们反对克隆声音的非法用途,同时积极推动Deepfake检测方面的研究。