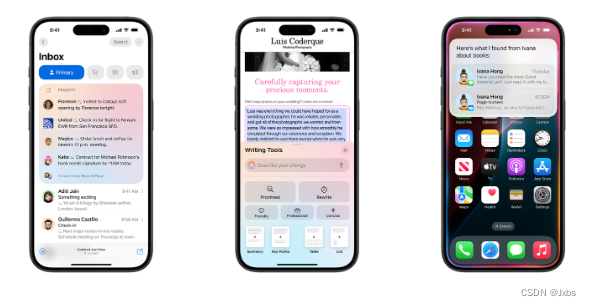

苹果智能和人工智能最大化

除了苹果公司,还没有人真正使用过苹果的智能功能。它要到秋天才会分阶段发布,即使到那时,它也无法在80%或90%的iPhone安装基础上运行,因为它需要只有iPhone 15 Pro才能使用的设备上处理功能。没有什么能像演示一样好(除了最初的iPhone),苹果可能会再次搞砸开发者的激励措施,而这一切可能并不像看起来那么好。我们会找到答案的。

但与此同时,如果你从演示和截图中退后一步,看看苹果真正想做的是什么,你会发现苹果指出了生成式人工智能中的大多数关键问题和杠杆点,并提出了一个与所有炒作和宣传截然不同的理论。

“AI Maximalist”的观点是,具有多模式和“多代理”能力的通用聊天机器人将能够接管各种复杂的多阶段任务和问题,这些任务和问题目前需要许多不同的专门编写的软件,并且还能够在一个单一的通用界面中自动完成以前无法在软件中完成的全新复杂任务。聊天机器人可能会用“软件已死”的提示取代所有的软件。正如我在这里所写的,我对此持怀疑态度,但苹果提出了相反的观点:生成式人工智能是一种技术,而不是一种产品。

我认为,苹果是在传递一种观点,即生成式人工智能和ChatGPT本身是一种大宗商品技术,在以下情况下最有用:

嵌入到一个系统中,提供关于用户的更广泛的上下文(可能是搜索、社交、设备操作系统或垂直应用程序)

分解成单独的功能(同上),这些功能本质上更容易作为小型节能模型在边缘的小型节能设备上运行(由用户支付,而不是您的资本支出预算)——这也很好,因为……

如果每次用户按下“OK”时我们都有边际成本,而且我们需要一群新的核电站来为所有这些提供动力,那么这些东西永远不会适用于大众市场。

首先,苹果已经建立了一个没有聊天机器人的LLM。苹果已经建立了自己的基础模型,(在它发布的基准测试中)可以与市场上的任何其他模型相媲美,但是你无法将原始提示直接插入模型并获得原始输出-总是有一组按钮和选项来塑造你的要求,并且它们以不同的方式呈现给用户不同的功能。在大多数这些功能中,根本没有可见的bot。你不会问一个问题然后得到回复:相反,你的邮件会被优先处理,或者你按下“摘要”,摘要就会出现。你可以在Siri中输入一个请求(Siri本身只是苹果模型的众多功能之一),但即使这样,你也不会得到原始模型的输出:你得到的是GUI。LLM被抽象为API调用。

这意味着苹果的基础模型不会像Gemini那样建议在披萨上涂胶水,因为你根本无法让它回答这类开放式问题。苹果将其视为一种能够实现新特性和功能的技术,在这种技术中,设计和产品管理决定了技术的功能和用户看到的东西,而不是你要求的神谕。

相反,“oracle”只是一个功能。苹果正在划分“环境模式”和“世界模式”。苹果的模型可以访问你手机上关于你的所有内容,为这些功能提供动力,这些都是私有的,无论是在设备上还是在苹果的“私有云”上。但是,如果你想知道如何处理你在杂货店购物的照片,那么这就不再是关于你的背景了,苹果将把它发送给第三方世界模型——今天的ChatGPT。一个世界模型确实有一个开放式的提示,它会给你原始的输出,它可能会告诉你在披萨上涂胶水,但这显然是不同的体验,你应该有不同的期望,当然,这也是OpenAI的品牌风险,而不是苹果的。与此同时,这个世界模型没有得到你的背景,只有你的一次性提示。

我们还没有看到苹果的上下文模型到底有多有效,但原则上它看起来确实很站得住脚。OpenAI和其他新公司的云模型(Anthropic, Mistral等)都没有你的电子邮件,信息,位置,照片,文件等等。如果你使用Android,谷歌确实有一个世界模型,并且可以访问你的环境,但这在美国显然是少数(而Android基地比iPhone基地更少能够在当地做任何事情)。微软的人工智能个人电脑有一些这样的背景,尤其是在工作环境中,但对大多数人来说,智能手机是拥有所有真实背景的主要设备,而不是个人电脑。Meta有这样的背景吗?也许是其中的一部分。在某个时候,这里将会有一场有趣的反垄断对话。但杠杆的关键在于,你需要先有自己的十亿规模的平台,然后才能建立这个平台:你不可能从零开始,用一个网站。

另一方面,OpenAI在这种关系中的立场有多站得住脚?不是很。

去年5月,一份泄露的谷歌备忘录声称LLMs没有护城河,因为每个人基本上都有相同的访问训练数据的权限,而且会有很好的开源模型。这就是目前的情况:唯一的护城河就是资本和英伟达的芯片(目前),而且根据你的计算方式,有六到十几个顶级模型,OpenAI领先,但还不够。苹果并没有声称它的新款基础机型在所有方面都是最好的,但对于它想提供的功能来说,它似乎已经足够好了。这不会像搜索或操作系统那样发挥作用——目前还没有明显的赢家通吃的迹象。苹果可以建立自己的基础模型——这只是钱的问题。

因此,OpenAI被(显然)“免费”分发给数亿苹果用户,为此它承担了所有的推论成本,作为交换,OpenAI有机会向付费订阅用户追加销售(尽管看看苹果在WWDC上的所有演示,我们还不清楚它将如何做到这一点)。但它也被视为一个可互换的插件。这与谷歌每年向苹果支付200亿美元成为默认搜索引擎的做法非常相似。苹果的人工智能主管John Giannandrea在本周的发布会结束后明确地做了这样的比较——“我认为这有点像Safari处理搜索引擎的方式”——Craig Federighi说他认为可能会有不同的“世界模型”用于不同的问题。通过暗示,苹果可能会向一个世界模型发送航班问题,向另一个世界模型发送烹饪问题。

但是,网络搜索是正确的比较,还是我们应该看看地图?苹果认为,试图打造一个像谷歌一样优秀的搜索引擎毫无意义,而且其他公司也没有真正做到这一点。另一方面,苹果确实开发了地图,虽然一开始搞砸了,但苹果地图现在至少“足够好”,因为除了资本之外,没有真正的护城河。很明显,OpenAI不是新的谷歌:不会有一个赢家。

当然,苹果自己构建的运行在私有云上的基础模型是一个“世界模型”,你可以向它索要披萨食谱——只是到目前为止,苹果还决定不提供那个UI。苹果让OpenAI承担了创造披萨胶配方、制造错误率和滥用他人问题的品牌风险,而苹果则在安全距离之外观察。下一步,可能是接受必应和谷歌对默认位置的竞标,但与此同时,越来越多的用例将悄悄地从第三方转移到苹果自己的模式上。毕竟,是苹果自己的软件决定了查询的去向,以及哪些查询需要第三方的帮助。

当然,这些都不是什么新鲜事物——很明显,当Llama 3问世时(如果不是更早的话),llm将是以边际成本出售的商品,问题将是你在上面构建什么产品——因此OpenAI聘请了Kevin Weil作为产品主管。但苹果也认为,一整类LLMs产品将被构建在云LLMs无法到达的地方,或者它们只是一个API调用的地方。

这让我想到了一个更广泛的问题。有句老话说,科技行业的每个人都在试图将别人的产品商品化,或者免费赠送自己的产品,或者两者兼而有之。Meta将免费提供Llama(包括模型和权重,目前甚至在其应用程序中嵌入免费查询),而超规模化者则希望对模型收费,因为Meta希望这是廉价的商品基础设施,并且它将在服务和功能上脱颖而出。苹果也在做类似的事情。运行Apple Intelligence的许多计算都在终端用户设备中,由用户付费,而不是苹果的资本支出预算,而且Apple Intelligence是免费的。(我们不知道苹果私有云的成本是多少,也不知道本地查询和云查询的可能组合。)英伟达上季度销售了250亿美元的人工智能芯片,超大规模厂商今年可能会在数据中心上花费1500亿美元左右,但全球智能手机市场超过4000亿美元,个人电脑市场超过2000亿美元,你的用户为此付出代价。这些数字显然没有直接可比性,但这是一个相关的比较。没有人能确切地知道几年后会是什么样子——模型会变得更大,效率也会更高,边缘会变得更快——但有一些非常强大的动机会让设备上尽可能多的东西。

商品化往往也是一种整合。曾经有一段时间,“拼写检查”是一个独立的产品,你必须花几百美元购买,市场上有几十个竞争产品,但随着时间的推移,它首先被集成到文字处理器中,然后是操作系统。同样的事情也发生在机器学习的最后一波浪潮中——风格转移或图像识别在五分钟内是产品,然后成为功能。今天“总结这个文档”是人工智能,你需要一个每月20美元的云LLMs,但明天操作系统将免费提供这些服务。“人工智能就是一切还不能用的东西。”

我也很好奇这对英伟达意味着什么。正如我经常仔细指出的那样,实际的芯片和数据中心分析师经常谈论英伟达的护城河,无论是在芯片本身,还是在为开发人员构建的软件上。苹果足够大,可以走自己的路,就像它把Mac搬到自己的芯片上一样:它控制着芯片上的软件和api,这些是开发者网络效应的基础,它拥有世界级的芯片团队,并有与台积电合作的特权。今天还有谁能与之相比?谷歌tpu吗?许多其他科技公司,甚至是大公司,似乎不太可能构建自己完全定制的从硅到gui的AI堆栈。改变的地方在于模型运行的地方:完整的基础模型还不适合一部手机,但是,从构建模型和“预言”到功能的实际用例越多,推理就越能更快地转移到边缘。苹果再次指出了这个问题。

最后,所有这些仍然只是论文。这些在18个月前都行不通,我们的产品还不适合市场。在许多发达国家,多达一半的人口已经尝试过生成人工智能,但其中一半从未尝试过第二次。这是对新事物的伟大认识,但这不是牵引力。我们不知道产品是什么,也不知道市场是什么,也不知道科学是什么,一切都在快速变化。在代理或错误率方面可能会有新的突破,从而完全改变用例。

与此同时,在位者总是试图把新事物变成一种特色。谷歌和微软花了18个月的时间在他们的产品上到处都是LLMs,每家企业SaaS公司也是如此:我的老同事Steven Sinofsky说,“互联网上的每个文本框都将获得LLMs”。苹果正在做一些稍微不同的事情——它为你在手机上做的所有事情提出了一个单一的上下文模型,并以此为基础提供功能,而不是在公司的各个不相关的地方添加不相关的llm功能。但它仍在努力将这种“颠覆性”的新技术变成一种功能,并试图将ChatGPT放在一个盒子里,限制在一组相当狭窄的用例中,并与Anthropic或Gemini互换。

正如我一开始所说的,这是关于生成式人工智能未来的核心问题——这是一种新的通用工具,一家公司的一款产品可以完成数百家公司的数百个软件的工作,还是一种通用技术,可以在数百家或数千家公司的产品中实现功能?