一. 词的相似度表示

(1): 用一系列与该词相关的词来表示

(2): 把每个词表示一个独立的符号(one hot)

(3): 利用该词上下文的词来表示该词

(3): 建立一个低维度的向量空间,用深度学习方法将该词映射到这个空间里(Word Embedding)

二:语言模型

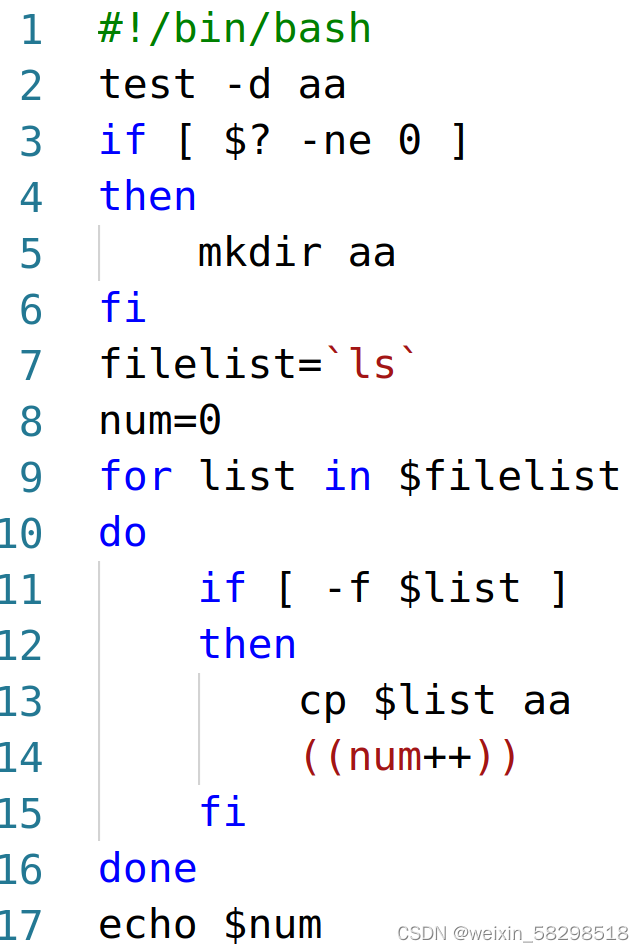

(1): 根据前面的词序列,预测下一个词出现的概率

![]()

(2): 根据一个已经生成的词的序列,判断是合法句子的概率

![]()

(3): 联合概率和条件概率的关系

![]()

(4): 语言模型,一个句子联合的概率等于它里面的每个词基于它前面出现词的条件概率乘积

![]()

(5): N-gram Model

![]()

(6):Neural Language Model , 比如要预测下一个词出现的概率,就要对前文出现的词表示成向量, 把向量拼成一起形成一个上下文向量,然后经过一个非线性转换,然后就可以用这个向量预测下一个词到底是什么。