点一下关注吧!!!非常感谢!!持续更新!!!

目前已经更新到了:

- Hadoop

- HDFS

- MapReduce

- Hive

- Flume

- Sqoop

- Zookeeper

- HBase 正在···

章节内容

上节我们完成了:

- HBase的由来介绍

- HBase的基础架构

- ZK在HBase中解决

- HBase中的各个组件的角色

背景介绍

这里是三台公网云服务器,每台 2C4G,搭建一个Hadoop的学习环境,供我学习。

之前已经在 VM 虚拟机上搭建过一次,但是没留下笔记,这次趁着前几天薅羊毛的3台机器,赶紧尝试在公网上搭建体验一下。

- 2C4G 编号 h121

- 2C4G 编号 h122

- 2C2G 编号 h123

下载项目

我们到官网对HBase进行下载:

http://archive.apache.org/dist/hbase/1.3.1/

你也可以使用 wget 工具进行下载:

wget https://archive.apache.org/dist/hbase/1.3.1/hbase-1.3.1-bin.tar.gz

解压配置

目前我在 h121 的机器上

tar -zxvf hbase-1.3.1-bin.tar.gz -C /opt/servers

拷贝依赖

我们需要修改配置文件,把 Hadoop 目录下的:

- core-site

- hdfs-site

这两个文件拷贝到HBase目录下

ln -s /opt/servers/hadoop-2.9.2/etc/hadoop/core-site.xml /opt/servers/hbase-1.3.1/conf/core-site.xml

cp /opt/servers/hadoop-2.9.2/etc/hadoop/hdfs-site.xml /opt/servers/hbase-1.3.1/conf/hdfs-site.xml

修改配置

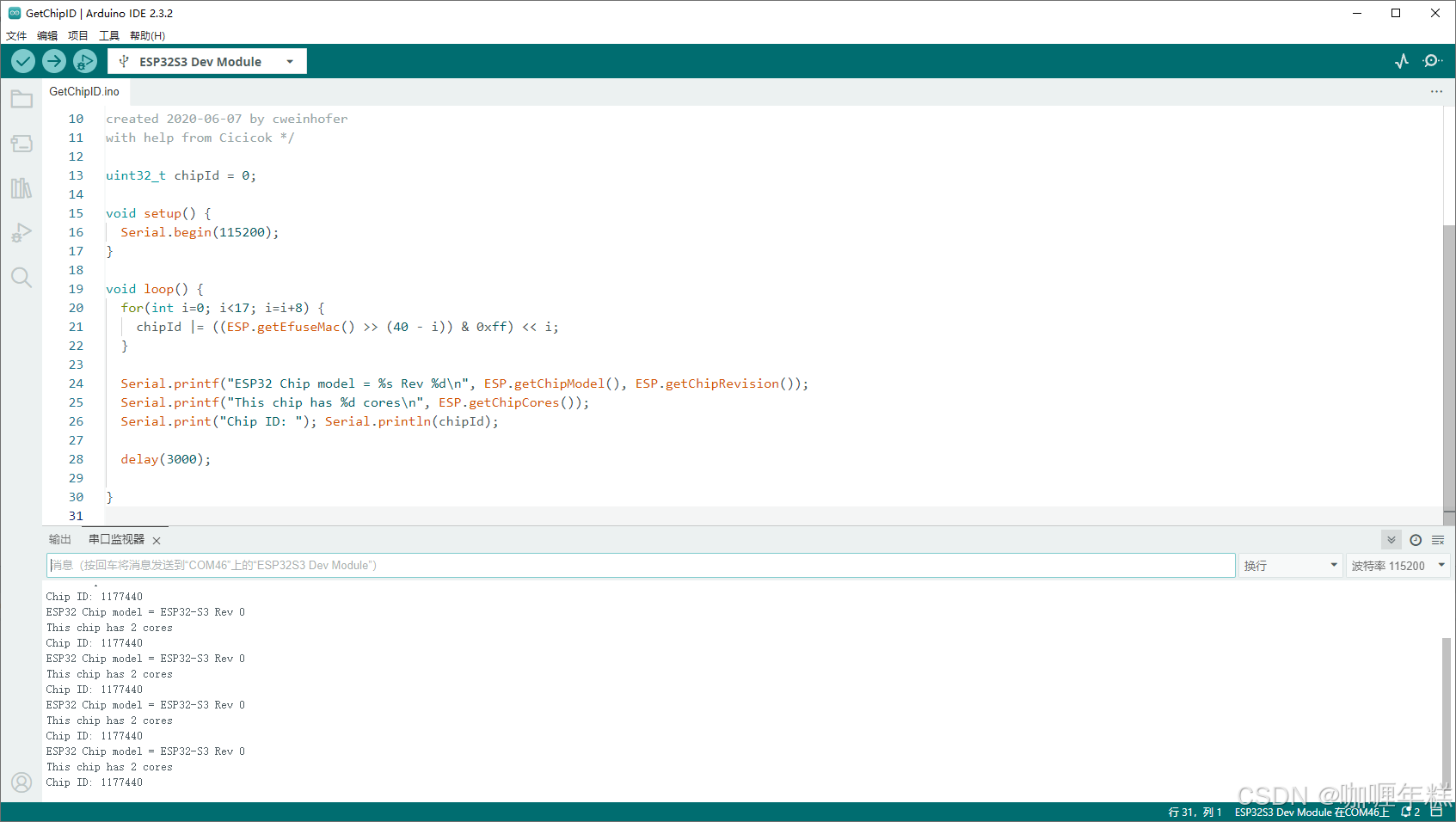

hbase-env

#添加java环境变量

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

#指定使用外部的z

export HBASE_MANAGES_ZK=FALSE

修改内容截图如下:

hbase-site

<configuration><!-- 指定hbase在HDFS上存储的路径 --><property><name>hbase.rootdir</name><value>hdfs://h121.wzk.icu:9000/hbase</value></property><!-- 指定hbase是分布式的 --><property><name>hbase.cluster.distributed</name><value>true</value></property><!-- 指定zk的地址,多个用“,”分割 --><property><name>hbase.zookeeper.quorum</name><value>h121.wzk.icu:2181,h122.wzk.icu:2181,h123.wzk.icu:2181</value></property>

</configuration>

servers

修改 regionservers 文件

h121.wzk.icu

h122.wzk.icu

h123.wzk.icu

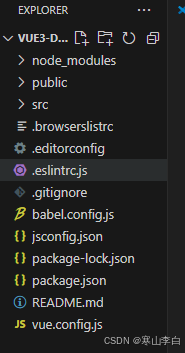

环境变量

export HBASE_HOME=/opt/servers/hbase-1.3.1

export PATH=$PATH:$HBASE_HOME/bin

记得刷新环境变量,配置的截图如下: