文章目录

- 论文地址

- Abstract

- Motivation

- 技术细节

- 多尺度backbone特征

- MSDeformAttention

- 小结

论文地址

Deformable DETR

推荐视频:bilibili

Abstract

DETR消除对目标检测中许多手工设计的组件的需求,同时表现出良好的性能。然而,由于Transformer注意模块在处理图像特征映射方面的局限性,它收敛速度慢,特征空间分辨率有限。为了缓解这些问题,提出了 Deformable DETR,其注意力模块只关注参考周围的一小组关键采样点。可变形 DETR 可以比 DETR(尤其是在小物体上)获得更好的性能,训练时间减少了 10 倍。

代码 。

Motivation

DETR的问题:

(1)它需要更长的训练时期才能收敛到现有的对象检测器。例如,在 COCO基准测试中,DETR 需要 500 个 epoch 才能收敛,这比 Faster R-CNN 慢大约 10 到 20 倍 。

(2) DETR在检测小物体时性能相对较低。现代目标检测器通常利用多尺度特征,从高分辨率特征图中检测小物体。同时,高分辨率特征图导致 DETR 的不可接受的复杂性。

上述问题主要归因于 Transformer 组件将几乎均匀的注意力权重转换为特征图中的所有像素。学习注意力权重以专注于稀疏有意义的位置,需要长时间的训练 epoch。另一方面,Transformer 编码器中的注意力权重计算是像素数的二次计算。因此,处理高分辨率特征图具有非常高的计算和内存复杂性。

可变形卷积 是一种强大且高效的机制来关注稀疏的空间位置。它自然避免了上述问题。但是它缺乏元素关系建模机制。

论文提出了Deformable DETR,它缓解了DETR收敛速度慢、复杂度高的问题。它结合了可变形卷积的稀疏空间采样和 Transformer 的关系建模能力的优点。提出了Deformable attention模块,该模块将一小组采样位置作为从所有特征图像素中突出关键元素的预过滤器。该模块可以自然地扩展到聚合多尺度特征,而无需 FPN (Lin et al., 2017a) 的帮助下。在Deformable DETR中,利用(多尺度)可变形注意模块代替Transformer注意模块处理特征映射。

技术细节

总的来说就是 利用了backbone多尺度的特征信息,用MSDeformAtten 替换了encoder/decoder中的MHAttention。

多尺度backbone特征

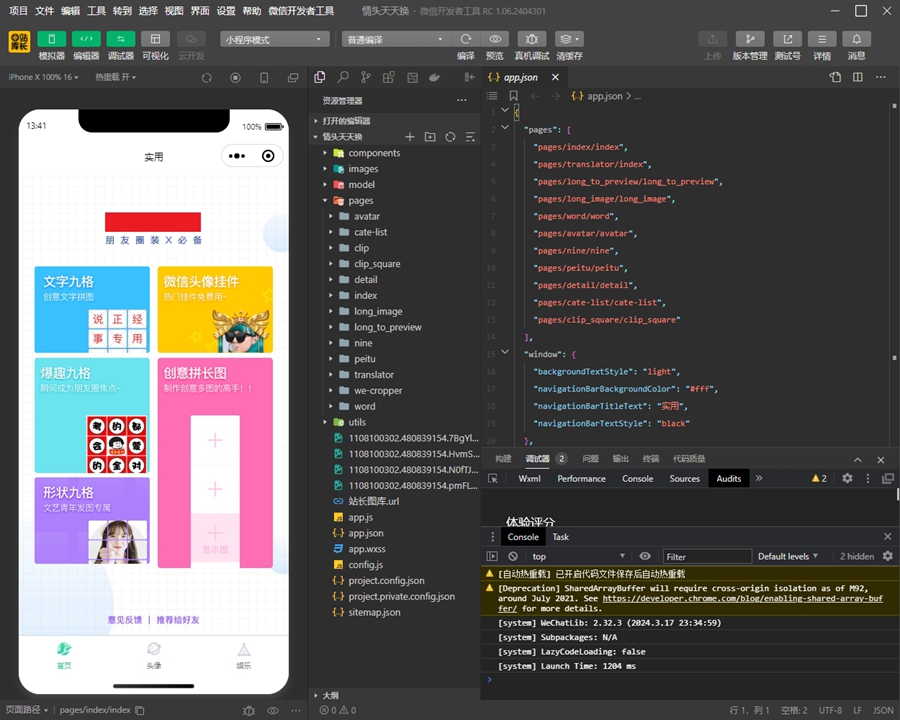

获取三个不同尺度的特征,构建类似FPN的操作,然后对齐到相同的channel数进行concat。

MSDeformAttention

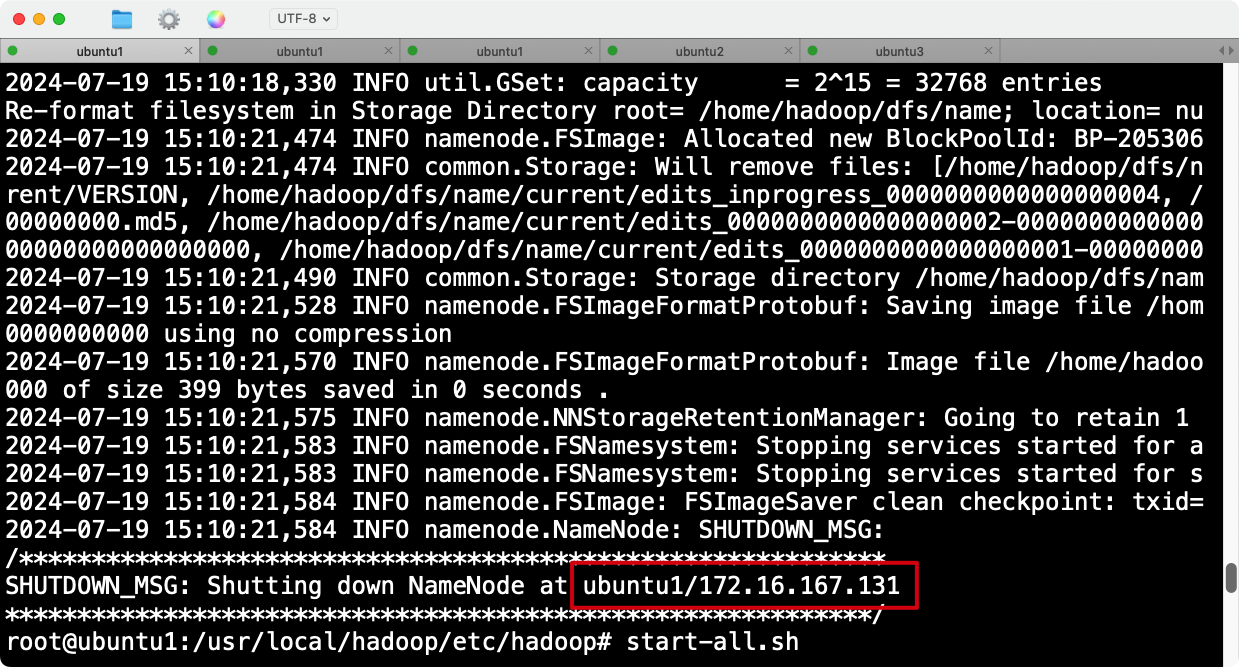

1.原始的query feature 分别经过两个线性分支得到 位置偏移量和attention权重

2.通过位置偏移量算出采样点在特征图上的位置

3.由采样点的位置 获得对于特征点的value

4.attention权重和采样点的value相乘

相对于原始transformer attention的Q,K,V。attention权重不再由Q,K获得,而是直接通过query feature 算出来的。

有个要注意的点,由于有4个不同尺寸的feature map。其anchor坐标都是先经过归一化的。

小结

Deformable attention这个idea 确实挺好的,大幅度减少了计算量。巧妙的运用了多尺寸的信息。经典之作。