Llama 3.1的诞生标志着人工智能领域的一个重要里程碑,它不仅是Meta在大型语言模型(LLM)研发上的一次重大突破,也代表了开源AI模型在技术进步和应用潜力上的新高度。以下是对Llama 3.1的炼成过程、观点阐述以及未来发展趋势的分析。

Llama 3.1炼成过程的关键要素:

-

大规模训练:Llama 3.1在超过15万亿个token的数据集上训练,这要求Meta优化训练流程并利用大量GPU资源。

-

架构选择:选择了纯解码器transformer架构,并通过微调提高了模型的稳定性和效率。

-

数据质量和规模:通过改进数据预处理和管理流程,以及严格的质量控制体系,确保了训练数据的高质量。

-

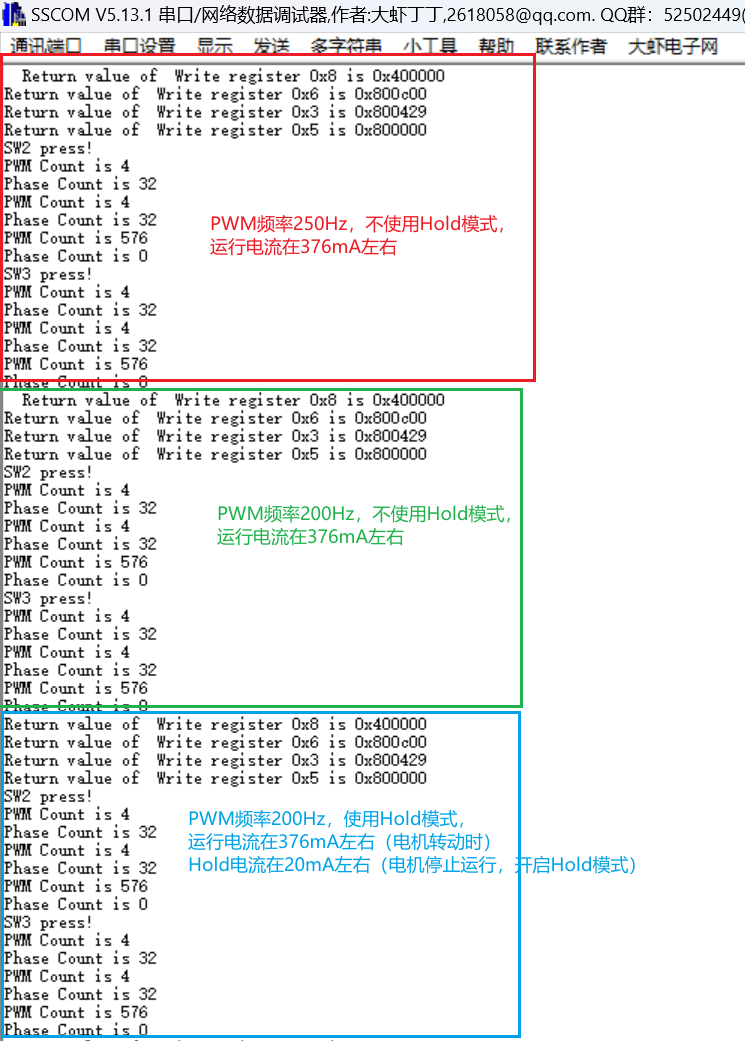

后训练优化:采用监督微调、拒绝采样和直接偏好优化等技术,提高了模型在特定任务上的性能。

-

量化技术:通过将模型量化为8位数值精度,降低了计算需求,使模型能在更广泛的硬件上运行。

-

模型评估:面对模型评估的复杂性,Meta尝试了多种方法,包括使用奖励模型和多样化的基准测试。

-

合成数据:大量使用合成数据进行训练,提高了数据的质量和多样性。

观点阐述:

-

开源的重要性:Llama 3.1的开源特性使得更广泛的研究者和开发者能够访问和利用这一强大的模型,推动了社区的创新和协作。

-

技术的可扩展性:Meta在Llama 3.1上展示的技术进步,如模型量化和后训练优化,为未来更大规模模型的训练和部署提供了可行的路径。

-

对社区的推动作用:Llama 3.1的发布激发了社区对大型语言模型的进一步研究和应用开发,加速了AI技术的发展。

发展趋势:

-

模型规模的增长:随着硬件资源的增加和训练技术的进步,未来的模型可能会达到更高的参数规模。

-

多模态能力:Llama 4可能会集成多模态能力,处理图像、视频和文本等多种类型的数据。

-

强化学习与Agent技术:未来的模型可能会更加注重强化学习和Agent技术,以实现更复杂的任务和更高级的自主决策能力。

-

安全性和伦理考量:随着模型能力的提升,如何确保模型的安全性和遵循伦理标准将成为重要议题。

-

跨领域应用:Llama 3.1及其后续版本可能会在医疗、法律、教育等多个领域发挥更大的作用,推动行业变革。

-

社区驱动的创新:开源模型将继续促进社区驱动的创新,通过众包的方式解决模型训练和评估中的挑战。

Llama 3.1的成功炼成不仅是技术上的胜利,也是开源精神的胜利。随着Llama 4训练的开启,我们可以期待Meta在AI领域带来更多的创新和突破。

BuluAI是一个创新型的算力云平台,算力使用灵活,可为开发者提供强大计算资源和全面支持。帮助BuluAI的使用者能够更专注于技术、应用的研究和优化。产品预计9月份正式公测上线,敬请期待!

现可报名免费领取算力,报名入口:BuluAI