本文作为大模型综述第一篇,介绍大模型技术基本情况。

目录:

1.大模型技术的发展历程

2.大模型技术的生态发展

3.大模型技术的风险与挑战

1.大模型技术的发展历程

2006 年 Geoffrey Hinton 提出通过逐层无监督预训练的方式来缓解由于梯度消失而导致的深层网络难以训练的问题, 为神经网络的有效学习提供了重要的优化途径。此后,深度学习在计算机视觉、语音、自然语言处理等众多领域取得了突破性的研究进展,开启了新一轮深度学习的发展浪潮。总结过去十多年的技术发展, 基于深度学习的人工智能技术主要经历了如下的研究范式转变: 从早期的“标注数据监督学习”的任务特定模型,到“无标注数据预训练+标注数据微调”的预训练模型,再到如今的“大规模无标注数据预训练+指令微调+人类对齐”的大模型, 经历了从小数据到大数据,从小模型到大模型,从专用到通用的发展历程,人工智能技术正逐步进入大模型时代。

2022 年底,由 OpenAI 发布的语言大模型 ChatGPT 引发了社会的广泛关注。在“大模型+大数据+大算力”的加持下, ChatGPT 能够通过自然语言交互完成多种任务,具备了多场景、多用途、跨学科的任务处理能力。 以 ChatGPT 为代表的大模型技术可以在经济、 法律、社会等众多领域发挥重要作用。大模型被认为很可能像 PC 时代的操作系统一样, 成为未来人工智能领域的关键基础设施,引发了大模型的发展热潮。

本次大模型热潮主要由语言大模型(亦称为大语言模型)引领。语言大模型通过在海量无标注数据上进行大规模预训练,能够学习到大量的语言知识与世界知识,并且通过指令微调、人类对齐等关键技术拥有面向多任务的通用求解能力。在原理上,语言大模型旨在构建面向文本序列的概率生成模型,其发展过程主要经历了四个主要阶段:

1) 统计语言模型:

统计语言模型主要基于马尔可夫假设建模文本序列的生成概率。特别地, N-gram 语言模型认为下一个词汇的生成概率只依赖于前面出现的 N 个词汇(即 N 阶马尔可夫假设)。此类语言模型的问题在于容易受到数据稀疏问题的影响,需要使用平滑策略改进概率分布的估计,对于文本序列的建模能力较弱。

2)神经语言模型:

针对统计语言模型存在的问题,神经语言模型主要通过神经网络(MLP、 RNN)建模目标词汇与上下文词汇的语义共现关系, 能够有效捕获复杂的语义依赖关系,更为精准建模词汇的生成概率。进一步, word2vec简化了神经语言模型的网络架构,可以从无监督语料中学习可迁移的词表示(又称为词向量或词嵌入),为后续预训练语言模型的研究奠定了基础。

3)预训练语言模型:

预训练语言模型主要是基于“预训练+微调”的学习范式构建,首先通过自监督学习任务从无标注文本中学习可迁

移的模型参数,进而通过有监督微调适配下游任务。早期的代表性预训练语言模型包括 ELMo、 GPT-1和 BERT等。其中, ELMo模型基于传统的循环神经网络(LSTM)构建,存在长距离序列建模能力弱的问题;随着 Transformer的提出,神经网络序列建模能力得到了显著的提升, GPT-1 和 BERT 都是基于 Transformer 架构构建的,可通过微调学习解决大部分的自然语言处理任务。

4)语言大模型(探索阶段):

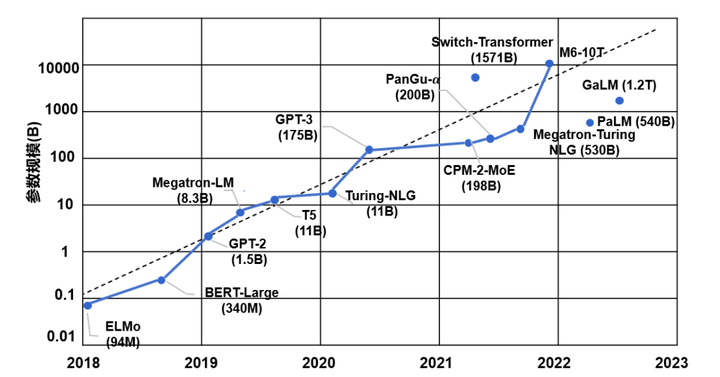

在预训练语言模型的研发过程中,一个重要的经验性法则是扩展定律(Scaling Law) :随着模型参数规模和预训练数据规模的不断增加,模型能力与任务效果将会随之改善。图 1-1 展示了 2018 至 2023 年间典型预训练模型的参数量变化趋势。 OpenAI 在研发 GPT 系列模型过程中,主要探索了 GPT-1(1.1 亿参数)、 GPT-2(15 亿参数)、以及 GPT-3(1750 亿参数)三个不同参数规模的模型,谷歌也推出了参数规模高达 5400 亿参数的 PaLM 模型。当模型参数规模达到千亿量级,语言大模型能够展现出多方面的能力跃升。例如, GPT-3 在没有微调的情况下, 可以仅通过提示词或少数样例(In-context learning,上下文学习) 完成多种任务,甚至在某些任务上超过当时最好的专用模型。学术界引入了“语言大模型”(Large language models)来特指这种超大规模的预训练语言模型,以突出与早期预训练语言模型的不同。

图 1-1 2018-2023 年模型参数规模变化图

5)语言大模型(提升阶段):

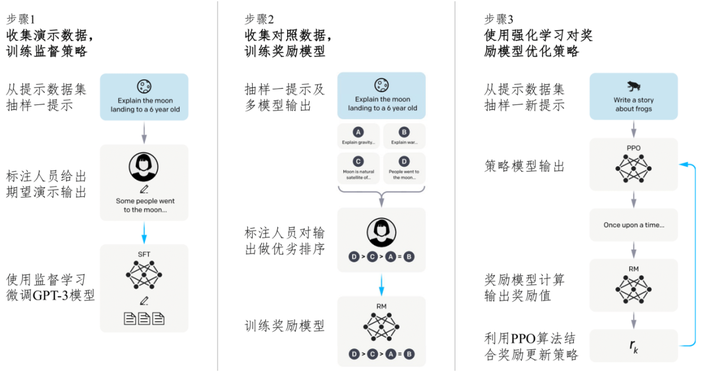

虽然早期的语言大模型表现出一定的少样本学习能力, 但是其学习目标主要通过预测下一个单词实现,仍不能很好地遵循人类指令,甚至会输出无用的、有害的信息, 难以有效对齐人类的偏好。 针对这些问题,主要有两种大模型改进技术,包括指令微调(Instruction Tuning) 以及基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF) 。指令微调利用格式化(指令和回答配对)的训练数据加强大模型的通用任务泛化能力;基于人类反馈的强化学习(如图 1-2 所示)将人类标注者引入到大模型的学习过程中,训练与人类偏好对齐的奖励模型,进而有效指导语言大模型的训练, 使得模型能够更好地遵循用户意图,生成符合用户偏好的内容。 在大模型使用过程中,可以使用各种提示技术( 包 括 思 维 链 (Chain-of-Thoughts, CoT ) 、 思 维 树(Tree-of-Thoughts, ToT)等),从而更好地利用大模型的潜在能力,提升大模型解决实际问题的能力。进一步,语言大模型主要是基于文本数据形式进行训练与推理,存在一些特定能力的不足,例如数值计算等。针对这一问题,可以使用外部工具(如计算器、搜索引擎等)扩展大模型的能力边界。

图 1-2 基于人类反馈强化学习的算法示意图

作为重要前沿探索力量, OpenAI 对于语言大模型的研发工作主要是在 Transformer 架构推出后开展,形成了一系列的技术进展。其中, GPT-1 探索了解码器 Transformer 架构(decoder-only Transformer)在“预训练+微调”范式下的自然语言任务求解能力; GPT-2 初步验证了扩大模型参数规模的有效性(扩展法则),并且探索了基于自然语言提示的多任务解决能力; GPT-3 首次探索了千亿参数规模的语言模型效果,提出了基于“上下文学习”的任务解决方法; CodeX使用代码数据对 GPT-3 进行微调,从而提升代码能力和复杂推理能力; InstructGPT基于人类反馈的强化学习技术(RLHF),能够强化对于人类指令的遵循能力和人类偏好的对齐能力; ChatGPT 与InstructGPT 的技术原理相似,进一步引入了对话数据进行学习,从而加强了多轮对话能力; GPT-4能够处理更长的上下文窗口,具备多模态理解能力,在逻辑推理、复杂任务处理方面的能力得到显著改进,但其他相关技术细节未予披露。随着 GPT-4 的成功,语言大模型对于多模态领域也产生了重要影响,它从单调的文本交互,升级为可以接受文本与图像组合的多模态输入,相比传统的单模态大模型,多模态大模型更加符合人类的多渠道感认知方式,能够应对更加复杂丰富的环境、场景和任务。 GPT-4表明在多模态大模型中引入基于人类知识的自然语言能够带来模型在多模态理解、生成、交互能力上的。

2.大模型技术的生态发展

大模型服务平台正向个人开放及商业落地应用延伸,不同公司互有侧重,为用户提供了多种获取大模型能力的途径。 OpenAI API 较早地面向公众开放的大模型服务平台,用户可以通过 API 访问不同的GPT 模型来完成下游任务。 Claude 系列模型是由 Anthropic 开发的闭源语言大模型,目前包含 Claude 和 Claude-Instant 两种模型可供选择。该系列模型通过无监督预训练 、基于人类反馈的强化学习和Constitutional AI 技术(包含监督训练和强化学习)进行训练,旨在改进模型的有用性、诚实性和无害性。 Claude 最高支持 100K 词元的上下文,而 Claude-2 更是拓展到了 200K 词元的上下文。文心一言是基于百度文心大模型的知识增强语言大模型,提供 APP、网页版、API 接口等多种形式的开放服务。文心一言还建设了插件机制,通过外部工具、服务的调用,拓展大模型的能力的边界。讯飞星火认知大模型具有开放式知识问答、多轮对话、逻辑和数学能力,并且具有较强的对代码和多模态的理解能力。讯飞和华为还联合重磅发布了国内首款支持大模型训练私有化的全国产化产品“星火一体机”,可支持企业快速实现讯飞星火大模型的私有化部署、场景赋能和专属大模型训练优化。大模型的开源生态也“百花齐放”,主要包括开源框架与开源大模型。开源框架可以有效地支撑大规模模型的训练,如: PyTorch提供了分桶梯度、通信计算重叠、跳过同步等技术,支持大规模的分布式数据并行训练;飞桨是国产的深度学习框架,早在内部就支持了大规模分布式训练,覆盖了计算机视觉、自然语言处理等多个领域的模型,其中 4D 混合并行策略,可训练千亿规模模型; OneFlow 将分布式集群抽象成逻辑上的超级设备,支持动静态图灵活转换,以数据+模型混合并行提升性能; DeepSpeed[29]是微软推出的大模型训练框架,其中 ZeRO 技术减少冗余内存访问,使得可以训练万亿级模型。开源大模型可降低大模型研究的门槛,促进大模型应用的繁荣。其中典型代表有:LLaMA系列是 Meta 研发的开源大模型,参数规模从 7B到 65B 不等,仅依赖公开数据集进行预训练,通过数据过滤和并行优化实现高效训练。 Falcon系列来自阿布扎比的 TII 研究院,最大规模达 180B 参数,基于开源许可发布,性能与 GPT-4 和 PaLM2 相当,参数量却较小。GLM系列采用空白填充等多任务联合训练方式,提升了模型的生成能力。 Baichuan 系列模型由百川智能开发, 支持中英双语,使用高质量训练数据,在多个基准测试上表现优秀,该系列模型还开源了多种量化版本。 Baichuan 2 在保留原有模型优势的基础上,增强了逻辑推理等方面的能力。 CPM系列采用经典的语言模型自回归训练方式,在各类中文 NLP 任务上均表现卓越。大模型技术具有广泛的应用场景, 可以用来赋能不同行业。 大模型+传媒可以实现智能新闻写作, 降低新闻的生产成本;大模型+影视可以拓宽创作素材,开拓创作思路,激发创作灵感,提升作品质量;大模型+营销可以打造虚拟客服,助力产品营销;大模型+娱乐可以加强人机互动,激发用户参与热情,增加互动的趣味性和娱乐性;大模型+军事可以增强军事情报和决策能力,可以实现实时战场翻译,快速准确的威胁评估、作战任务规划和执行、战场感知、战术决策支持、改进态势感知等;大模型+教育可以赋予教育教材新活力,让教育方式更个性化、更智能;大模型+金融可以帮助金融机构降本增效,让金融服务更有温度;大模型+医疗可以赋能医疗机构诊疗全过程。总之,大模型的发展将给人类带来了非常强大的助推力,让数字世界和现实世界的共生变得更为便捷、更为有效。大模型的通用性使其被认为是可以成为未来人工智能应用中的关键基础设施,就像 PC 时代的操作系统一样,赋能百业,加速推进国民经济的高质量发展。向上,大模型可带动上游软硬件计算平台的革新,形成高性能软硬件与大模型的协同发展,构建“大模型+软硬件+数据资源”上游发展生态;向下,大模型可以打造“大模型+应用场景”的下游应用生态,加速全产业的智能升级,对经济、社会和安全等领域的智能化升级中形成关键支撑。

3.大模型技术的风险与挑战

尽管以 ChatGPT 为代表的大模型技术取得关键性突破,但当前大模型技术仍存在诸多风险与挑战。首先,大模型的可靠性无法得到有效保障。 例如, 基于海量数据训练的语言大模型, 尽管其生成的内容符合语言规则、通顺流畅且与人类偏好对齐,但其合成内容在事实性、时效性方面等仍存在较多问题, 尚无法对所合成内容做出可靠评估。其次,大模型的可解释性存在不足。大模型基于深度神经网络,为黑盒模型,其工作机理仍难以理解。语言大模型的涌现能力、规模定律,多模态大模型的知识表示、逻辑推理能力、泛化能力、情景学习能力等方面有待展开深入研究,为大模型的大规模实际应用提供理论保障。再次,大模型应用部署代价高。 大模型参数规模和数据规模都非常巨大, 存在训练和推理计算量大、功耗高、应用成本高、端侧推理存在延迟等问题, 从而限制了其落地应用。提高推理速度降低大模型使用成本是大规模应用的关键。此外, 大模型在小数据情景下的迁移能力存在不足。 大模型基于数据驱动深度学习方式,依赖训练数据所覆盖的场景,由于复杂场景数据不足,大模型存在特定场景适用性不足的问题,面临鲁棒性和泛化性等挑战。提升大模型对小数据的高效适配迁移能力是未来研究的重点。最后,大模型还存在伴生技术风险问题。 例如,语言大模型具有通用的自然语言理解和生成能力, 其与语音合成、图像视频生成等技术结合可以产生人类难以辨别的音视频等逼真多媒体内容,可能会被滥用于制造虚假信息、恶意引导行为,诱发舆论攻击、 甚至危害国家安全。此外,大模型存在安全与隐私问题,目前针对大模型安全漏洞的典型攻击方式包括:数据投毒攻击、对抗样本攻击、模型窃取攻击、后门攻击、指令攻击。大模型的安全漏洞可能被攻击者利用, 使得大模型关联业务面临整体失效的风险,威胁以其为基础构建的应用生态。大模型利用海量的互联网数据进行训练, 包括个人、企业甚至国家的敏感数据可能被编码进大模型参数中,因而存在数据隐私问题。例如,通过提示信息可能诱发大模型隐私数据泄露问题。