- Paper:https://arxiv.org/abs/2310.01852

- Github:https://github.com/PKU-YuanGroup/LanguageBind

- Huggingface:https://huggingface.co/spaces/LanguageBind/LanguageBind

- Author:Bin Zhu et al. 北大袁粒团队

文章目录

- 1 LanguageBind总结(省流版)

- 1.1 LanguageBind是什么?

- 1.2 LanguageBind能干什么?

- 1.2.1 Zero-shot X-Language classification

- 1.2.2 Zero-shot X-Language retrieval

- 2 Method

- 3 VIDAL-10M

- 4 训练细节

- 参考资料

核心工作:

● 提出一个LanguageBind框架,将多种模态都映射到一个共享特征空间,实现多模态语义对齐;

● 开源了一个VIDAL-10M数据集,包含Video、Infrared、Depth、Audio、Language;短视频。

1 LanguageBind总结(省流版)

1.1 LanguageBind是什么?

LanguageBind是北大袁粒团队提出的一个多模态语义对其的方法,通过将各种模态(图像、视频、红外、音频、深度)映射到一个共享的特征空间,与文本实现对齐。同时该论文还开源了一个VIDAL-10M的数据集,包含多种模态(≥3)的数据。

1.2 LanguageBind能干什么?

与CLIP类似,CLIP只对齐了图像和文本,而LanguageBind对齐了更多的模态,可以看成是CLIP的加强版。

1.2.1 Zero-shot X-Language classification

零样本分类,即根据文本对图像、视频、音频等进行分类。

1.2.2 Zero-shot X-Language retrieval

零样本检索,即根据文本检索图像、视频、音频等;

2 Method

LanguageBind的三个部分:

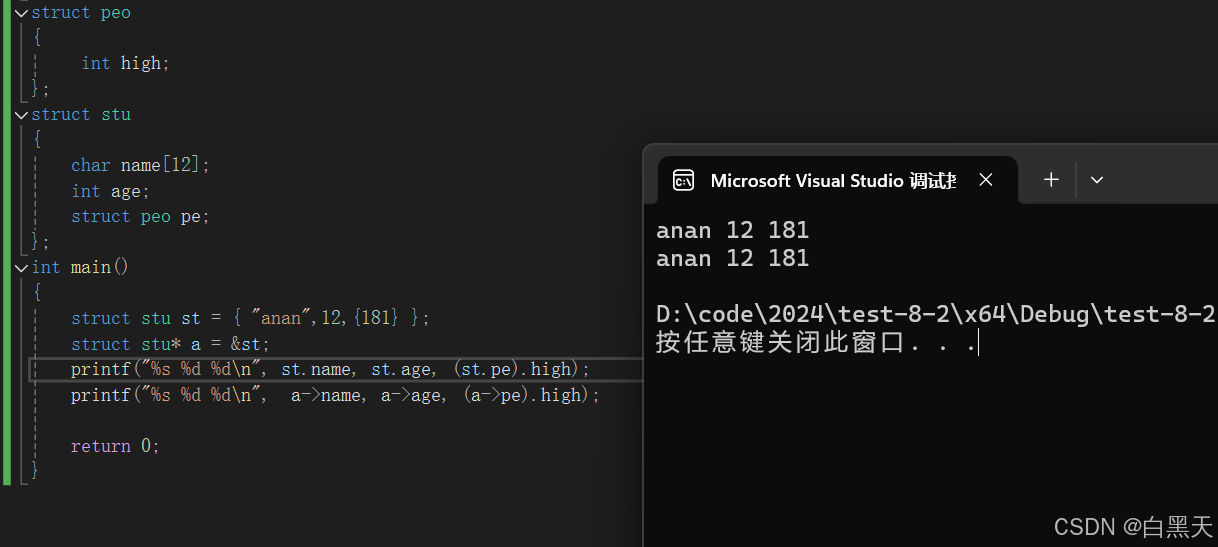

- Multi-modal encoders: LoRA微调

- 24-layers、1024 dimension ViT/14,OpenCLIP-Large初始化;

- Depth和infra数据在维度上复制3次,当作RGB数据处理

- Audio数据被转换成10s音频数据的频谱图,最后在channel复制3次,少于10s用0补全,超过10s做裁剪;

- Language encoder: 参数冻结

- 12-transformers、768-dimension的OpenCLIP

- 文本tokenizer:BPE tokenizer

- Multi-modal joint learning:各模态与text进行contrastive learnin

3 VIDAL-10M

VIDAL-10M数据集:

- video-text pairs:3M(Youtube shorts:根据搜索词下载、过滤)

- audio-text pairs:1M(Freesound:根据搜索词下载、过滤)

- infrared-text pairs:3M(sRGB-TIR:生成视频关键帧对应的红外数据)

- depth-text pairs:3M(GLPN:生成视频关键帧对应的深度数据)

4 训练细节

- epoch:LoRA,3epoch

- batchsize:1024

- Rank of LoRA:2(增大性能反而会下降)

- temperature for loss:0.07

- masked ratio:0.5

参考资料

[1] 自然语言模型(LM)之Tokenizer的介绍(1)–BPE