卫星图像检测,分割,跟踪,超分辨率,数据集调研

- 超分辨率

- Image super-resolution: A comprehensive review, recent trends, challenges and applications

- A Review of GAN-Based Super-Resolution Reconstruction for Optical Remote Sensing Images

- Remote Sensing Image Super-Resolution via Multiscale Enhancement Network

- 跟踪

- High-resolution Satellite Video Object Tracking Based on ThickSiam Framework(2023 简称 ThickSiam 用于SOT)

- MBLT: Learning Motion and Background for Vehicle Tracking in Satellite Videos(2022 简称XDU-BDSTU 用于SOT)

- Deep Learning-Based Object Tracking in Satellite Videos: A comprehensive survey with a new dataset(2022 简称sv248s 用于SOT )

- Detecting and Tracking Small and Dense Moving Objects in Satellite Videos: A Benchmark(2022 VISO 检测+SOT+MOT)

- Satellite video single object tracking: A systematic review and an oriented object tracking benchmark(2024重点)

- SatSOT: A Benchmark Dataset for Satellite Video Single Object Tracking(2022 SatSOT 单目标跟踪)

- Multi-Object Tracking in Satellite Videos with Graph-Based Multi-Task Modeling(2022 简称AIR-MOT 多目标跟踪)

- Advancing Multi-Object Tracking for Small Vehicles in Satellite Videos: A More Focused and Continuous Approach

- Satellite Video Object Tracking Based on Location Prompts

- 检测

- Vehicle Perception From Satellite(2024 TPAMI 车辆检测+车流量监控)

- Object Detection in Optical Remote Sensing Images: A Survey and A New Benchmark(2019 简称DIOR 目标检测)

- Tiny Object Detection in Aerial Images(2020 简称 AI-TDO 小目标检测)

- Random Access Memories: A New Paradigm for Target Detection in High Resolution Aerial Remote Sensing Images( 2018 LEVIR数据集 目标检测)

- Recent Advances in Intelligent Processing of Satellite Video: Challenges, Methods, and Applications(2024重点)

- Hierarchical and robust convolutional neural network for very high-resolution remote sensing object detection(2019 HRRSD 目标检测)

- A multitask benchmark dataset for satellite video: Object detection, tracking, and segmentation(简称SAT-MTB 2023重点)

- Object Knowledge Distillation for Joint Detection and Tracking in Satellite Videos(2024 多目标跟踪)

- 其他

- WHU-Stereo: A Challenging Benchmark for Stereo Matching of High-Resolution Satellite Images

- 遥感图像语义分割

- SISP: A Benchmark Dataset for Fine-grained Ship Instance Segmentation in Panchromatic Satellite Images

- Graph Dynamic Earth Net: Spatio-Temporal Graph Benchmark for Satellite Image Time Series

- Satellite Component Semantic Segmentation: Video Dataset and Real-Time Pyramid Attention and Decoupled Attention Network

- Satellite Component Semantic Segmentation: Video Dataset and Real-Time Pyramid Attention and Decoupled Attention Network

- zp

- Unsupervised Satellite Video Deep Intrinsic Decomposition Using Physical Prior Constraints

- MP2Net: Mask Propagation and Motion Prediction Network for Multi-Object Tracking in Satellite Videos

- 数据集

- 视频单/多标签分类

- Satellite Video Multi-Label Scene Classification With Spatial and Temporal Feature Cooperative Encoding: A Benchmark Dataset and Method(2024 多标签分类+数据集)

- Enhancing Image Annotation With Object Tracking and Image Retrieval: A Systematic Review

- Enhancing Image Annotation With Object Tracking and Image Retrieval: A Systematic Review

- 总结

超分辨率

Image super-resolution: A comprehensive review, recent trends, challenges and applications

A Review of GAN-Based Super-Resolution Reconstruction for Optical Remote Sensing Images

Remote Sensing Image Super-Resolution via Multiscale Enhancement Network

跟踪

High-resolution Satellite Video Object Tracking Based on ThickSiam Framework(2023 简称 ThickSiam 用于SOT)

数据源:吉林卫星1号

现有的遥感和自然场景目标检测数据集被用来共同训练ThickSiam框架,以实现不同领域之间的适应性,并从静态图像到动态跟踪任务的可行性。我们构建了一个用于卫星视频单目标跟踪(SOT)任务的公开测试数据集,其中包括八个视频中的十二个目标,覆盖飞机、船舶、火车和车辆四个类别。在该数据集上与其他19个跟踪器进行了对比实验,结果显示ThickSiam框架表现优越。

在本研究中,建立了一个手动标注的测试数据集,用于进行消融实验并验证跟踪器的性能。该数据集包括从八个视频中提取的12个目标,总共包含5550帧,涵盖飞机、船舶、火车和车辆四个类别。跟踪的目标在每一帧中都用水平边界框手动标注。考虑到目标外观的轻微变形,同一目标在不同帧中的边界框范围有所不同。构建的测试数据集的缩略图如图6所示。

视频1、2、4、5、6、7和8来自由长光卫星技术有限公司提供的“吉林1号”卫星。序列图像的地面采样距离(GSD)为0.92米。视频3是从国际空间站(ISS)下载的,由Deimos Imaging和UrtheCast提供。序列图像的GSD为1米。每个视频都标记了SS、PO、PoV、PTBD、SD和PGFI属性,这些属性代表了卫星视频单目标跟踪(SOT)任务中的挑战。这些实验数据集的详细描述见表2。

MBLT: Learning Motion and Background for Vehicle Tracking in Satellite Videos(2022 简称XDU-BDSTU 用于SOT)

为了定量评估所提方法的性能,从由吉林一号拍摄的九个城市中选择了20个具有代表性的卫星视频目标(车辆)并用矩形框标注,进一步形成一个数据集。这九个城市分别是:巴林-穆哈拉格、利比亚-德尔纳、西班牙-瓦伦西亚、突尼斯、土耳其-阿达纳01、土耳其-阿达纳02、美国-明尼阿波利斯01、美国-明尼阿波利斯02,以及美国-旧金山(分别在阿达纳和明尼阿波利斯选取了两个场景)。我们以这九个城市的首字母将该数据集简称为XDU-BDSTU1。表I列出了XDU-BDSTU在所选城市、图像大小、目标大小、帧数以及具有挑战性的属性方面的详细信息。XDU-BDSTU中的目标涵盖了卫星视频中车辆跟踪可能遇到的大多数情况。图6展示了XDU-BDSTU在特定帧中的目标。图5展示了这九个城市以及从这些城市中选取的XDU-BDSTU的各个目标位置。由于卫星视频的低分辨率(约1米),车辆尺寸相对较小(见表I),且车辆外观高度相似(见图6)。卫星相机覆盖范围广,视频中每帧的尺寸约为2160 × 4096或2160 × 3840(见表I)。因此,较少特征(LF)、低分辨率(LR)、大小比例失衡(SO)和背景复杂性(BC)是该数据的挑战性方面。由于复杂的道路条件,遮挡(OCC)也是一个挑战因素。此外,光照变化(IV)也是一个挑战点。车辆旋转也是一种可能情况,因此平面内旋转(IPR)也是一个挑战。在所有这些属性中,除了我们在介绍部分总结的内容外,我们还参考了[6]、[7]、[41]和[4]的分类结果。

除了来自吉林一号卫星的视频外,我们还选择了由SkySat卫星于2014年3月25日在美国内华达州拉斯维加斯拍摄的卫星视频。该视频分辨率为1米,帧率为30 fps。该卫星视频场景的第一帧如图7所示。我们选择了该视频中两个典型区域的车辆目标,并对其进行了标注,形成了两个数据集SkySat1和SkySat2。红色框对应SkySat1,绿色框对应SkySat2。表II和表III总结了这两个数据集在图像大小、目标大小、帧数和挑战性属性方面的详细信息。这些数据集也在[42]–[44]中使用。

Deep Learning-Based Object Tracking in Satellite Videos: A comprehensive survey with a new dataset(2022 简称sv248s 用于SOT )

数据源:吉林1号

单位:西安电子科技大学

Detecting and Tracking Small and Dense Moving Objects in Satellite Videos: A Benchmark(2022 VISO 检测+SOT+MOT)

数据源:吉林卫星1号

单位:国防科大

具体:

如上所述,VISO 数据集 [18] 也支持卫星视频中的目标跟踪,提供了 3,159 个单目标跟踪任务的序列和 47 个包含 3,711 个单独实例的多目标跟踪任务序列,目标类别包括飞机、汽车、船只和火车。数据集中原始场景的分辨率为 12,000 × 5,000 像素,视频帧率为 10 FPS。

VISO [18] 数据集:由国防科技大学于 2022 年发布,是一个移动物体检测和跟踪数据集,包含 47 个视频序列,这些序列由吉林一号卫星拍摄,逐帧标注了车辆、飞机、船只和火车,共 1,646,038 个标注实例。数据集只标注了移动物体,其中超过 90% 的物体是车辆。

Satellite video single object tracking: A systematic review and an oriented object tracking benchmark(2024重点)

摘要:卫星视频(SV)中的单个物体跟踪(SOT)能够连续获取任意物体的位置和距离信息,在遥感应用中具有广阔的前景。 然而,现有的跟踪器和数据集很少关注 SV 中定向物体的 SOT。 为了弥补这一差距,本文全面回顾了涵盖普通视频和卫星视频领域的各种跟踪范例和框架,随后提出了定向物体跟踪基准(OOTB),以推动视觉跟踪领域的发展。 OOTB 包含来自 110 个视频序列的 29,890 个帧,涵盖常见的卫星视频对象类别,包括汽车、轮船、飞机和火车。 所有帧都人工标注了定向边界框,每个序列都标注了 12 个细粒度属性。 此外,我们还提出了一个高精度评估协议,以便对跟踪器进行全面、公平的比较。 为了验证现有的跟踪器并探索适合 SV 跟踪的框架,我们对 33 种最先进的跟踪器进行了基准测试,这些跟踪器共有 58 个模型,具有不同的功能、骨干和跟踪器标签。 最后,我们还提供了广泛的实验和深刻的思考,以帮助理解它们的性能,并为未来的研究提供基准结果。 OOTB 可在 https://github.com/YZCU/OOTB 上查阅。

使用的卫星图像:

目前,视频卫星仍处于发展阶段,数量有限。如表2所示,SV主要由SS、JL、ISS和Carbonite-2(CB)提供。CB由Surrey Satellite Technology(SSTL)开发,提供1.2米GSD RGB视频,能够捕捉大约120秒的视频。表1展示了一些视频卫星的详细配置和参数。如表2所示,大多数跟踪器使用JL SVs,因为其质量较高。被跟踪的对象主要是汽车、船只和飞机,因为这些对象常见且具有适中的长宽比。相比之下,火车对象具有较大的长宽比,这增加了跟踪的难度。因此,火车的跟踪非常具有挑战性,需要在未来的研究中给予更多关注。

VISO(Yin等,2022)是一个大规模数据集,具有广泛的HBB标注,适用于各种SV任务,包括移动对象检测、SOT和多对象跟踪。其中,SOT数据集提供了3,159个跟踪段,约1.12M帧。SatSOT(Zhao等,2022)特别关注SV中的SOT,包含105个序列,27,664个HBB标注,11个属性和四类典型对象(即汽车、船只、飞机和火车)。SV248S(Li等,2022c)提供了来自JL的六个SVs中的248个对象,包含10个属性和三种对象类别(即汽车、飞机和船只)。它使用紧密多边形来标注对象,特别有效地表示具有相对复杂轮廓的飞机对象。XDUBDSTU(Zhang等,2022)包含11个属性和来自九个JL SVs的20个对象,专门用于SV中的车辆跟踪。对象标注使用HBB。ThickSiam_D(Zhang等,2023)包括从八个SVs中获得的12个对象,总共有5.55K帧,标注为HBB。此外,SAT-MTB(Li等,2023),一个最新的多任务基准数据集,已被提出用于SV中的目标检测、跟踪和分割。所提出的OOTB包含110个序列,涵盖典型的对象类别,如汽车、船只、飞机和火车,具有12个挑战性属性和总共29,890帧。它是针对SV中SOT的特定数据集,并包括了(He等,2022;Yin等,2022;Zhao等,2022)中的一小部分数据。值得注意的是,这是第一个应用细致OBB标注的基准,以尽可能确保对象的尺度、中心、方向和运动方向的准确性。

标注格式:

具体来说,OBB描述包括四个角点的坐标。我们使用roLabelImg软件,并放大10倍以进行准确的注释。图5展示了一个火车的注释示例。roLabelImg的标注格式为(x, y, w, h, θ),其中(x, y)表示中心点,w、h和θ分别表示边界框的宽度、高度和旋转角度。为了符合通用描述,我们将注释格式转换为四位小数的浮点类型,

测试的几个属性

总结

这个数据集专用于单目标跟踪,标注有方向的框,还测试了多种通用sot目标跟踪方法在自己数据集上的性能,注意通用数据集的cle=20,但是卫星图像中目标更小,cle设置为5,文章结果显示,siam系列的跟踪器相较于trnasformer,在卫星图像上的性能更好。这个数据集对象主要是4种:车,火车,飞机,船。

SatSOT: A Benchmark Dataset for Satellite Video Single Object Tracking(2022 SatSOT 单目标跟踪)

图像源:吉林卫星

官方介绍链接

SatSOT 包含 105 个卫星视频序列: SatSOT 的平均视频长度为 263 帧,最短的视频为 120 帧,最长的视频为 750 帧。 SatSOT 包含卫星视频目标跟踪中的重大挑战,如小目标、复杂背景和严重遮挡。

SatSOT 数据集 [17]:由中国科学院空间利用技术与工程中心于 2022 年发布,是一个专注于卫星视频单目标跟踪的数据集。它包含 105 个视频序列,共 27,664 帧,数据来源于三种商业卫星:吉林一号、Skybox 和 Carbonite-2。数据集中的目标类别包括汽车、飞机、船只和火车。数据集中原始场景的分辨率为 12,000 × 5,000 像素,视频帧率为 10–25 帧/秒(FPS)。

Multi-Object Tracking in Satellite Videos with Graph-Based Multi-Task Modeling(2022 简称AIR-MOT 多目标跟踪)

数据来源:吉林一号

摘要:

摘要— 近年来,卫星视频已成为地球观测的一种新兴手段,提供了跟踪移动目标的可能性。然而,现有的多目标跟踪器通常为自然场景设计,未考虑遥感数据的特性。此外,大多数跟踪器由检测和重识别(ReID)两个独立阶段组成,这意味着它们无法相互促进。为此,我们提出了一种名为TGraM的端到端在线框架,用于卫星视频中的多目标跟踪。该框架从多任务学习的角度将多目标跟踪建模为图信息推理过程。具体而言,我们提出了基于图的时空推理模块,以挖掘视频帧之间潜在的高阶关联。此外,考虑到检测和重识别之间优化目标的不一致性,我们设计了一种多任务梯度对抗学习策略来规范每个任务特定的网络。此外,针对该领域数据稀缺的问题,我们构建了一个大规模、高分辨率的吉林一号卫星视频数据集(AIR-MOT)用于多目标跟踪实验。与最先进的多目标跟踪器相比,TGraM在检测和重识别之间实现了高效的协同学习,将跟踪精度提高了1.2多个目标跟踪精度。代码和数据集将在线提供(https://github.com/HeQibin/TGraM)。

数据集:

AIR-MOT总共包含5736个实例,来自149个视频,这些视频是由“吉林一号”卫星在2017年10月至2020年10月期间从世界不同地区收集的十个完整场景。如表I所示,这些视频有超过70个时间戳,帧率为5–10 FPS,分辨率为1920 × 1080像素。此外,由于这些视频是在全球范围内拍摄的,即使是相似的目标,其背景也复杂且多样,目标具有多尺度特性。如图7所示,尽管每个视频中的实例数量反映了该地区目标的自然分布,但实例的变化(包括持续时间和位置变化)反映了目标运动的多样性,有助于验证跟踪器的鲁棒性。在实验中,原始视频的70%被随机选作训练集,其余30%为测试集。

Advancing Multi-Object Tracking for Small Vehicles in Satellite Videos: A More Focused and Continuous Approach

Satellite Video Object Tracking Based on Location Prompts

检测

Vehicle Perception From Satellite(2024 TPAMI 车辆检测+车流量监控)

Object Detection in Optical Remote Sensing Images: A Survey and A New Benchmark(2019 简称DIOR 目标检测)

“DIOR”是一个用于光学遥感图像目标检测的大规模基准数据集。数据集包含23463个图像和192472个实例,涵盖20个对象类。这20个对象类是飞机、机场、棒球场、篮球场、桥梁、烟囱、水坝、高速公路服务区、高速公路收费站、港口、高尔夫球场、地面田径场、天桥、船舶、体育场、储罐、网球场、火车站、车辆和风磨。

这个帖子介绍的相当不错

Tiny Object Detection in Aerial Images(2020 简称 AI-TDO 小目标检测)

单位:武汉大学

数据源:吉林卫星

AI-TOD [23] 数据集:由武汉大学于 2020 年发布,是一个专注于小目标检测的航拍图像数据集,包含 700,621 个目标实例,涵盖飞机、桥梁、储罐、船只、游泳池、车辆、人员和风车,共 28,036 张航拍图像。AI-TOD 中的目标平均尺寸约为 12.8 像素,比其他数据集要小得多。在 AI-TOD-v2 [24] 中,缺失标注和位置误差问题得到显著缓解,便于更可靠的训练和验证过程。

Random Access Memories: A New Paradigm for Target Detection in High Resolution Aerial Remote Sensing Images( 2018 LEVIR数据集 目标检测)

单位:北航

数据源:谷歌地图

LEVIR数据集由大量 800 × 600 像素和0.2m〜1.0m /像素的高分辨率Google Earth图像和超过22k的图像组成。LEVIR数据集涵盖了人类居住环境的大多数类型地面特征,例如城市,乡村,山区和海洋。数据集中未考虑冰川,沙漠和戈壁等极端陆地环境。数据集中有3种目标类型:飞机,轮船(包括近海轮船和向海轮船)和油罐。所有图像总共标记了11k个独立边界框,包括4,724架飞机,3,025艘船和3,279个油罐。每个图像的平均目标数量为0.5。

Recent Advances in Intelligent Processing of Satellite Video: Challenges, Methods, and Applications(2024重点)

Hierarchical and robust convolutional neural network for very high-resolution remote sensing object detection(2019 HRRSD 目标检测)

单位:中科院

数据源:谷歌地图

摘要:

物体检测是超高分辨率遥感图像(RSI)自动标注物体的基本问题。 目前,深度学习尤其是基于卷积神经网络(CNN)的遥感物体检测方法已逐渐取得竞争优势。 现有方法大多使用全连接特征向量中的全局信息,而忽略卷积特征立方体中的局部信息。 然而,局部信息可以提供空间信息,有助于准确定位。 此外,旋转和缩放等可变因素也会影响 RSI 中的物体检测精度。 为了解决这些问题,本文提出了一种分层鲁棒 CNN。 首先,提取多尺度卷积特征来表示分层空间语义信息。 其次,将多个全连接层特征堆叠在一起,以提高旋转和缩放的鲁棒性。 两个数据集的实验证明了我们方法的有效性。 此外,我们还建立了大规模高分辨率遥感物体检测数据集,以弥补现有数据集不足或太小的现状。 该数据集可在 https://github.com/CrazyStoneonRoad/TGRS-HRRSD-Dataset 上查阅。

TGRS-HRRSD-Dataset是一个庞大的遥感图像数据库,包含从Google Earth和Baidu Map收集的21,761张图片,分辨率范围在0.15-m到1.2-m之间。这些图像中共有55,740个对象实例,涉及13个不同类别,如船舶、桥梁、机场等。为了方便研究,数据集被分为训练(5401张)、验证(5417张)和测试(10943张)三个子集。

A multitask benchmark dataset for satellite video: Object detection, tracking, and segmentation(简称SAT-MTB 2023重点)

数据集官方地址

摘要:

卫星视频可以持续成像大范围区域,并提供热点和物体的动态实时监控。卫星视频的智能处理和分析已成为遥感领域的研究热点。然而,高质量卫星视频数据集的缺乏限制了相关的物体检测、物体跟踪和物体分割的发展。本文构建了规模最大的卫星视频数据集,支持最多的任务类型和物体类别,命名为卫星视频多任务基准(SAT-MTB)。首先,在249个卫星视频中,对飞机、船只、汽车、火车及其对应的14类细粒度物体进行多任务标注,标注形式包括水平边界框(HBBs)、定向边界框(OBBs)和掩模,覆盖了超过50,000帧和1,033,511个标注物体实例。然后,我们回顾了基于卫星视频的物体检测、物体跟踪和物体分割任务,提供了相关数据集和算法研究进展的全面概述。最后,我们建立了首个公开的卫星视频物体检测、物体跟踪和物体分割的多任务算法基准,评估和分析了总共47种代表性算法在构建的数据集上的不同任务表现。提出的SAT-MTB将显著推动卫星视频智能处理和分析及相关应用领域的研究。

其他数据集对比:

A. 光学遥感目标检测数据集

- 光学遥感图像目标检测数据集:

遥感图像中的地面目标具有尺度多样、视角特异、尺寸小和方向任意等特点。随着检测技术的发展和空间分辨率的持续提高,可以对目标进行更精细的表示,遥感目标检测已经从 HBB(水平边界框)和粗粒度发展到 OBB(定向边界框)和细粒度检测。目前的遥感目标检测数据集可以分为 HBB 检测和 OBB 检测,适用于不同的地球观测平台,包括卫星和机载平台。

a) 基于 HBB 的目标检测:与 ImageNet、MS-COCO 和 Pascal VOC 等大规模目标检测数据集相比,由于地面典型目标的稀疏分布和类别数量有限,遥感图像的目标检测数据集规模要小得多,主要以 HBB 注释形式呈现。近年来,代表性的遥感图像目标检测数据集主要包括以下几种:

-

DIOR [19] 数据集:由西北工业大学于 2020 年发布,是一个大规模光学遥感图像目标检测基准数据集,包含 23,463 张图像和 192,472 个实例,涵盖 20 个物体类别:飞机、机场、棒球场、篮球场、桥梁、烟囱、大坝、高速公路服务区、高速公路收费站、港口、高尔夫球场、地面运动场、立交桥、船只、体育场、储罐、网球场、火车站、车辆和风车。DIOR-R [20] 数据集是 DIOR 的扩展版本,使用 OBB 进行注释,与 DIOR 共享相同的图像。

-

HRRSD [21] 数据集:由中国科学院大学于 2020 年发布,包含来自 Google Earth 和百度地图的 21,761 张图像,空间分辨率范围为 0.15 至 1.2 米,总计 55,740 个目标实例,每个类别大约 4,000 个,类别包括飞机、棒球场、篮球场、桥梁、交叉路口、运动场、港口、停车场、船只、储罐、交叉路口、网球场和汽车。

-

LEVIR [22] 数据集:由北航大学于 2018 年发布,包含来自 Google Earth 的超过 22,000 张 800 × 600 像素图像,空间分辨率范围为 0.2 至 1 米。数据集覆盖大多数地面场景类型,如城市、乡村、山区和海洋,包括三种物体类别:飞机、船只和油罐,共有 11,000 个实例,包括 4,724 个飞机、3,025 个船只和 3,279 个油罐。

-

AI-TOD [23] 数据集:由武汉大学于 2020 年发布,是一个专注于小目标检测的航拍图像数据集,包含 700,621 个目标实例,涵盖飞机、桥梁、储罐、船只、游泳池、车辆、人员和风车,共 28,036 张航拍图像。AI-TOD 中的目标平均尺寸约为 12.8 像素,比其他数据集要小得多。在 AI-TOD-v2 [24] 中,缺失标注和位置误差问题得到显著缓解,便于更可靠的训练和验证过程。

b) 基于 OBB 的目标检测:由于大多数地面目标在遥感影像的俯视图中是有方向性的,研究团队开始使用定向矩形进行目标标注,以更准确地表示目标。近年来的代表性数据集主要包括以下几种:

-

FAIR1M [25] 数据集:由中国科学院航空航天信息研究院于 2022 年发布,是一个大规模细粒度遥感目标检测数据集,包含 42,796 张标注图像,涵盖五个主要物体类别:飞机、船只、车辆、球场和道路,这些类别进一步细分为 Boeing737、Boeing747、Boeing787、C919、A220、A321、A330、A350、ARJ21、客船、摩托艇、渔船、拖轮、工程船、液体货船、干货船、军舰、小轿车(SC)、公共汽车、货车、垃圾车、面包车、拖车、拖拉机、挖掘机、卡车-拖车、篮球场、网球场、足球场、棒球场、交叉路口、环形交叉路口、桥梁和其他 37 种细粒度目标,总实例数量超过 100 万个;图像的空间分辨率为 0.3 米到 0.8 米;图像的最小尺度为 1000 × 1000,最大尺度为 10,000 × 10,000,包含大量小而稀疏的目标。

-

DOTA 数据集:是一个大规模的航拍图像目标检测数据集,由武汉大学于 2018 年发布。图像来自不同的传感器和平台,每张图像的尺寸范围从 800 × 800 到 20,000 × 20,000 像素,包含具有各种尺度、方向和形状的目标。DOTA 数据集中的实例由航拍图像解读专家用任意(8 自由度)四边形进行标注。DOTA 有三个版本:DOTA-v1.0 [26] 包含 15 个常见类别、2,806 张图像和 188,282 个实例。DOTA-v1.5 [27] 使用与 DOTA-v1.0 相同的图像,但对极小的实例(少于 10 像素)也进行了标注,共包含 403,318 个实例。DOTA-v2.0 [28] 收集了更多来自 Google Earth、GF-2 卫星和航拍图像的数据。DOTA-v2.0 包含 18 个常见类别、11,268 张图像和 1,793,658 个实例。DOTA 被分为训练集、验证集、测试开发集和测试挑战集。训练集包含 1,830 张图像和 268,627 个实例。验证集包含 593 张图像和 81,048 个实例。测试开发集包含 2,792 张图像和 353,346 个实例。测试挑战集包含 6,053 张图像和 1,090,637 个实例。

-

SODA-A [29] 数据集:由西北工业大学于 2020 年发布,是一个专门针对小目标检测任务的基准数据集,具有 872,069 个带有定向矩形框标注的实例,包括飞机、直升机、小型车辆、大型车辆、船只、集装箱、储罐、游泳池和风车。数据集包含从 Google Earth 提取的 2,513 张高分辨率图像。实例的平均绝对尺寸仅为 14.75 像素。

- 卫星视频目标检测数据集:

与静态遥感图像相比,卫星视频主要关注如何融合帧之间的时空特征,以实现有效的检测。目前,卫星视频领域的目标检测数据集相对较小,数据规模和物体类别比遥感图像检测数据集更为分散,主要集中在移动车辆上。近年来的代表性数据集如下:

-

VISO [18] 数据集:由国防科技大学于 2022 年发布,是一个移动物体检测和跟踪数据集,包含 47 个视频序列,这些序列由吉林一号卫星拍摄,逐帧标注了车辆、飞机、船只和火车,共 1,646,038 个标注实例。数据集只标注了移动物体,其中超过 90% 的物体是车辆。

-

2020 年,澳大利亚新南威尔士大学基于 Sky-sat 卫星数据制作了一个车辆检测数据集 [30]。从相同的视频中提取了两个接近区域,分别为 400 × 400 像素和 600 × 400 像素,每个区域有 700 帧,总共包含 80,278 个车辆实例。

-

2019 年,复旦大学发布了基于吉林一号卫星拍摄的瓦伦西亚地区的移动车辆目标检测数据集 [31]。数据集包括吉林一号卫星拍摄的瓦伦西亚地区的三个视频片段,共包含 33,640 帧逐帧标注的移动车辆对象。

B. 卫星视频目标跟踪数据集

先前的研究表明,有几个数据集可以用于卫星视频目标跟踪,以便公平和标准化地评估跟踪算法。

SatSOT 数据集 [17]:由中国科学院空间利用技术与工程中心于 2022 年发布,是一个专注于卫星视频单目标跟踪的数据集。它包含 105 个视频序列,共 27,664 帧,数据来源于三种商业卫星:吉林一号、Skybox 和 Carbonite-2。数据集中的目标类别包括汽车、飞机、船只和火车。数据集中原始场景的分辨率为 12,000 × 5,000 像素,视频帧率为 10–25 帧/秒(FPS)。

如上所述,VISO 数据集 [18] 也支持卫星视频中的目标跟踪,提供了 3,159 个单目标跟踪任务的序列和 47 个包含 3,711 个单独实例的多目标跟踪任务序列,目标类别包括飞机、汽车、船只和火车。数据集中原始场景的分辨率为 12,000 × 5,000 像素,视频帧率为 10 FPS。

AIR-MOT 数据集 [7]:由中国科学院航天信息研究所于 2022 年发布,包含由吉林一号卫星采集的 10 个完整场景的 149 个视频。数据集使用轴对齐的边界框标注了 5,736 个实例,包含飞机和船只对象。每个视频的帧率为 5–10 FPS,分辨率为 1,920 × 1,080 像素。

C. 卫星视频目标分割数据集

视频目标分割是一个更高级的任务,结合了目标检测和语义分割。在航空航天领域,基于卫星俯视图的视频目标分割受到了更多关注。

遥感目标分割数据集和一般图像分割数据集的数据采集方法存在明显差异:一般图像分割数据集的数据来源丰富,多为手持相机、车载相机、监控摄像头等,视角大多为平面视角,物体尺度较大,场景尺度较小。遥感数据通常为鸟瞰视角,可以获取更大面积的信息,在土地利用领域具有更大的利用价值。卫星遥感数据源的图像高度较高,包含更多的个体目标,但单个目标信息更模糊,目标类别显著少于一般领域。视频目标分割数据集可以持续观察某一区域内的目标区域,在交通和安全领域具有更重要的应用价值。与一般分割数据集相比,遥感目标分割数据集存在目标尺寸小、纹理信息少、光照影响大、背景干扰等问题。代表性的数据集如下:

SatSOS 数据集:由中国科学院空间利用技术与工程中心于 2022 年发布,是一个基于卫星视频的单目标分割数据集,包含六种类别:飞机、火车、船只、汽车、建筑物和云。数据集包含 125 个对象和 15,000 帧像素级标注。该数据集关注地面典型目标的运动,涵盖了视频目标分割中遇到的传感器抖动、目标遮挡和目标旋转等问题,以及卫星视频中存在的目标纹理弱、特征不明显和光照变化强等问题,为相关分割方法的研究提供了基准。

iSAID 数据集 [32]:由武汉大学于 2019 年发布,包含 15 个类别,总计 655,451 个实例和 2,806 张图像,每张图像中最多有 8,000 个实例,平均每张图像 239 个实例,充分反映了遥感图像的常见特征和尺度分布差异,使其成为首个大规模的遥感实例分割数据集。

本文数据集介绍

A. 数据收集与标注

- 数据来源与场景选择:SAT-MTB 数据集由

吉林一号03卫星从2017年到2021年在全球各个地区收集,包括中国、美国、墨西哥、法国、意大利、西班牙、澳大利亚、日本、土耳其、印度、泰国、沙特阿拉伯和阿联酋。所有图像序列均以真实色彩呈现,光谱频道分别为 B1:580∼723 nm、B2:489∼585 nm 和 B3:437∼512 nm,空间分辨率为 0.92 米(在卫星点)。视频覆盖区域大小为 11 公里 × 4.6 公里,帧率为 10 FPS。

所有原始数据经过精心选择,最终创建了 249 个视频,以覆盖尽可能多的目标实例。这些视频包含地形场景的连续帧,如机场、港口、道路、桥梁、铁路车站和湖泊,并包括不同的光照和天气条件。典型目标,如飞机、船只、汽车和火车,处于高速运动、慢速运动、转弯、静止、遮挡、视野内外等不同状态,使得数据集对多种任务更具挑战性。此外,每个场景区域都被裁剪到最佳尺寸,以涵盖尽可能多的目标类型和运动状态,从而确保数据集的多样性和丰富性。图1展示了包含飞机、船只、汽车和火车的视频帧示例。

- 分类标准与多任务标注:我们仔细分析了每个视频中目标的外观和运动特征,以评估类别内的区分性。结合细粒度目标的常见分类标准,我们最终设计了两级类别标准。第一级包括四个粗粒度类别:飞机、船只、汽车和火车。第二级包括 14 个细粒度类别:宽体飞机(WA)、窄体飞机(NA)、后置发动机飞机(RA)、四引擎飞机(FA)、公务机(CA)、快艇(SB)、游艇(YH)、游轮(CS)、货轮(FH)、军舰(NV)、其他船只(OS)、大型汽车(LC)、小型汽车(SC)和火车(TN)。图2展示了细粒度标注的目标类别示例。

根据定义的分类标准,我们对卫星视频中的每一帧实例进行了三项任务的标注:目标检测、目标跟踪和目标分割。对于目标检测,我们提供了 HBB(水平边界框)和 OBB(方向边界框)标注,如图3所示。标注文件记录了每帧的序列号、相同目标在帧之间的识别号等。根据视频目标检测的定义,需要检测每帧中出现的所有感兴趣目标。考虑到汽车在卫星视频中的尺寸小、外观弱,目标检测任务不包括这些对象。

对于目标跟踪,我们使用了领域内常用的标准标注格式。标注记录了帧序列号、目标编号、左上角坐标、边界框的宽度和高度、得分、粗粒度类别、细粒度类别,以及目标是否被截断或遮挡等信息。与目标检测不同,跟踪任务仅关注移动目标。视频中的静态目标不被标注。值得注意的是,基于目标跟踪标注,可以生成检测14类移动目标的标注,包括汽车。

与目标检测任务一致,目标分割任务也提供了所有感兴趣的目标标注,这些目标出现在卫星视频的每一帧中,无论是否在运动。目标分割任务使用掩膜来表示每个实例的边界区域。每帧的卫星视频对应一个标注文件。标注信息也可以索引以获取视频序列中对应的帧编号,并在不同帧之间唯一识别相同目标。数据集中包含飞机、船只和火车的视频场景标注了多项任务,如 HBB 检测、OBB 检测、移动目标跟踪和目标分割,而包含汽车的视频场景则仅标注了移动目标跟踪任务。任务和目标场景的统计数据如表 I 所示,标注结果的可视化示例如图4–6所示。

B. 统计数据

-

统计概况:数据集中每个任务和标注格式的统计结果见表 II。我们还在表 III 中与同类数据集进行关键指标比较。

-

统计分析:由于飞机、船只、汽车和火车在原始视频中的空间分布和运动范围的差异,数据集中的视频尺寸并不统一,以最大化类别、多种运动状态、目标方向和背景的多样性。例如,包含火车的视频由于其固有规模较大,而对应于汽车的视频则较小,且密集分布在局部区域,如道路和桥梁。数据集中视频尺寸的统计见图7。此外,我们还展示了 HBB 标注中类别尺度分布和实例绝对大小的图示,如图8和表 IV。

数据集按 6:4 比例分为训练集和验证集,基于飞机、船只、汽车和火车的视频数量,以及细粒度目标的分布。值得注意的是,目标检测、目标跟踪和目标分割都遵循一致的数据分布,为多任务的综合分析和算法评估提供了可靠的基准。训练集包含 37、42、6 和 62 部分别对应于飞机、船只、汽车和火车的卫星视频。验证集包括 25、28、4 和 30 部卫星视频。训练和验证集中细粒度目标实例数量的统计分布如图9所示。数据集可以在 http://www.csu.cas.cn/gb/kybm/sjlyzx/gcxx_sjj/sjj_wxxl/ 下载。

C. 数据集特点

本文构建的数据集具有独特的任务特性和优势,为各种卫星视频视觉任务提供了基础数据支持。同时,它也为该领域的研究人员提出了新的挑战。数据集的特点总结如下:

-

多任务:该数据集首次提供了同一场景下的目标检测、目标跟踪和目标分割三项视觉任务的数据标注。多任务数据集为该领域的各种研究方向提供了丰富的标注,并为卫星视频算法开发提供了良好的实验数据条件。

-

大规模:据我们所知,这是目前公开的最大规模的卫星视频标注数据集,支持三种任务类型,视频场景范围广泛。数据集包括来自不同地区的 249 部视频,超过 50,000 帧的视频帧和总计 1,033,511 个标注实例。大量标注数据支持模型训练所需的高质量数据样本。

-

细粒度:该数据集首次提供了卫星视频的细粒度类别标注。对于三种基本目标类别(飞机、船只和汽车),根据外观和运动特征的区分性,进一步细分为五类飞机、六类船只和两类汽车。细粒度类别为更具挑战性的任务提供了基准数据,如细粒度检测、识别和跟踪。

-

定向:针对卫星视频目标检测和跟踪,我们首次创新性地提出了领域内的 OBB 标注,这为后续面向定向对象的网络设计和实验评估提供了数据支持。

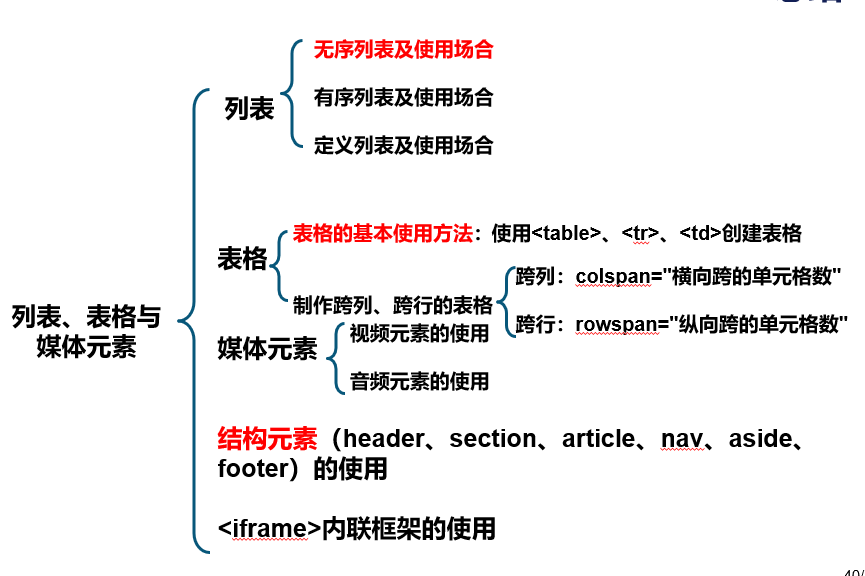

方法综述:

A. 目标检测

- 目标检测方法概述:

a) 基于 HBB 的遥感图像目标检测:根据是否需要预定义的锚点,深度学习基础的图像目标检测方法可以分为基于锚点的方法 [8],[9],[34],[35],[36],[37](单阶段和两阶段)和无锚点方法 [38],[39]。基于锚点的方法将目标检测任务建模为候选区域的分类和回归问题,其中候选区域通过单阶段检测中的滑动窗口或两阶段检测中的区域生成网络生成。由于大量的锚点引入了许多超参数,基于锚点的方法在计算上复杂。随后的方法通过识别目标检测的关键点显著减少了网络的超参数数量 [38]。近年来,Transformer 在自然语言处理(NLP)领域取得了巨大的成功。受到 Transformer 强大的关系建模表示能力的启发,研究人员提出了将 Transformer 适配到遥感图像目标检测任务 [39],[40]。与传统自然图像相比,遥感图像具有其独特的特点,因此研究人员关注于遥感图像的特定问题来开发算法。R2-CNN [41] 通过轻量级骨干网络提取特征,并通过判断性定位策略过滤掉不包含对象的子图块。为了解决遥感图像中目标尺度变化大的问题,Zhang 等 [42] 采用了多尺度候选区域网络和多尺度检测器来检测不同尺度的目标。为了解决遥感图像中小目标无法检测的问题,YOLT [43] 通过增加上采样、将中间浅层特征映射到输出,并融合多个尺度来找到更小的目标。Long 等 [44] 提出了无监督的基于分数的边界框回归,并结合非极大值抑制来提高密集分布目标的位置准确性。Li 等 [45] 在特征图融合过程中设计了显著性金字塔融合策略,以削弱背景的影响并增强目标的特征表示。他们还将全局注意力与遥感图像的复杂背景结合起来。

b) 基于 OBB 的遥感图像目标检测:遥感图像中的大多数目标是方向性的,OBB(方向边界框)可以提供比 HBB(水平边界框)更准确的轮廓。对于基于 OBB 的遥感图像目标检测,计算目标角度是主要挑战之一。表示 OBB 的常见解决方案有两种,即五参数方法和八参数方法 [46]。五参数方法包括目标中心的坐标、宽度、高度以及表示旋转矩形的目标角度,其中角度的周期通常选择为 180° 或 90°。八参数方法包括 OBB 四个角点的坐标,允许更灵活的四边形回归,但也导致参数过多。大多数现有的 OBB 目标检测框架主要通过上述参数表示来改进。Xia 等 [26] 在 Faster R-CNN 中引入了新的回归参数,基于上述参数表示解决方案来检测旋转框。Ma 等 [46] 设计了 RRPN,通过手动定义具有角度的锚框来回归目标的旋转框,同时在检测过程中使用设计的旋转特征池化操作来规范化特征,从而实现了定向目标的检测和表示。Jiang 等 [47] 提出了 R2CNN,通过区域提议网络(RPN)生成旋转候选区域,并使用多尺度池化操作增强检测识别特征的泛化能力。Ding 等 [27] 提出了 RoI Transformer,该方法在 RPN 和 RCNN 之间插入一个轻量级模块,将 RPN 生成的水平区域转换为旋转区域,以最小化与旋转目标检测相关的计算复杂性。为了进一步改善特征表示,Cao 等 [48] 同时回归 HBB 和 OBB,以提高彼此的准确性。

c) 卫星视频目标检测:与基于图像的目标检测相比,视频目标检测最重要的特点是添加了上下文信息,其中每一帧都有上下文连接的对应关系和相似性。通过使用前后帧的检测结果,可以提高当前帧的检测准确性,因为存在子上下文关系。由于前后帧具有类似的连续性,可以利用冗余信息加快每一帧的检测。当前基于深度学习的视频目标检测可以分为结合检测和跟踪的算法,以及基于运动信息的算法。对于前者,视频中的每一帧都进行目标检测,然后使用跟踪算法跟踪目标帧,并利用跟踪结果来修正之前的检测结果。代表性算法包括 T-CNN [49],该算法结合了从视频目标跟踪任务中学到的时间信息与从静态目标检测任务中学到的空间特征,以提高视频目标检测任务的性能。基于运动信息的视频目标检测算法利用时间域中图像序列中的像素变化和相邻帧之间的相关性来寻找前后帧之间存在的对应关系。FAGA [50] 基于 FlowNet [51] 提取视频的光流信息,并根据提取的光流融合相邻帧的特征,增强特征的区分性。Association LSTM [52] 是一种在线视频目标检测算法,使用运动信息,主要由静态图像目标检测算法 SSD [53] 和 LSTM [54] 组成。通过堆叠 SSD 检测结果提取目标特征,并利用 LSTM 的记忆属性保持目标的时空一致性。STMM [55] 是一种双向递归卷积网络,通过对多个相邻连续帧进行卷积堆叠来获取空间特征,然后将输出发送到分类和回归子网络。该算法可以利用相邻帧之间的目标运动信息,并学习目标在长时间段内的运动和外观变化。

当前基于卫星视频的目标检测主要基于传统算法,如背景建模,主要关注移动车辆。基于深度学习的卫星视频目标检测研究仍处于初级阶段。Jie 等 [56] 提出了跨帧关键点检测网络(CKDNet),并设计了一个跨帧模块来辅助关键点检测,充分利用帧之间的互补信息。提取了同一帧的空间信息,并考虑了相邻车辆的相对空间关系。Xiao 等 [57] 提出了一个由 2D 主干网络(具有来自单个帧的静态上下文信息和轻量级)和 3D 主干网络(提取连续动态运动帧)组成的双流动态和静态融合网络(DSFNet)。Pi 等 [58] 设计了一个特征帧间差异模块,以获得邻近的运动信息并提取语义特征。他们进一步引入了 Transformer 来细化语义特征,以有效检测卫星视频中不明显的车辆目标。

C. 目标分割

- 目标分割方法概述:根据网络框架,视频目标分割方法可以分为基于 CNN 的分割方法和基于记忆的分割方法。基于 CNN 的分割方法在单独的视频帧上进行,而基于记忆的分割方法直接对视频进行分割。

a) 基于 CNN 的分割方法:He 等人 [79] 提出了 Mask R-CNN,这是一种 Faster R-CNN [8] 的扩展。Mask R-CNN 包括掩码分割分支,并结合了 RoIAlign,一种通过双线性插值消除感兴趣区域(RoI)与提取特征之间错位的方法。Cascade Mask 是一个结合了 Cascade R-CNN 和 Mask R-CNN 优势的目标检测和分割框架。在 Cascade Mask 中,采用增量 IoU 阈值策略生成高质量的边界框和分割掩码。Huang 等人 [80] 提出了 Mask Scoring R-CNN,通过添加 MaskIoU 头来回归实例掩码和真实标签之间的 IoU,避免掩码质量与分类置信度分数之间的差距。Chen 等人 [81] 提出了混合任务级联(HTC),通过结合掩码信息流来增强 Cascade Mask R-CNN 的性能。这种方法涉及构建一个联合的多阶段模型,将边界框和掩码分支编织在一起,以提高目标检测和分割的准确性。受到数据增强(即 Crop-and-Paste [82])有效性的启发,Fang 等人 [83] 提出了 InstaBoost,该方法使用抠图 [84] 和修补 [85] 算法将前景与背景分离,然后通过考虑前景的外观相似性识别合适的位置进行粘贴。为改善分割方法的粗略边缘,Kirillov 等人 [86] 引入了 PointRend,将分割任务视为图像渲染过程。该方法利用自适应选择过程来选择前 N 个不确定点,然后迭代预测这些点以生成高质量和精细的掩码。受到视觉和认知过程的启发,Qiao 等人 [87] 将递归特征金字塔(RFP)和可切换的膨胀卷积(SAC)集成到 HTC 架构中,创建了 DetectoRS。RFP 利用来自 FPN 的反馈连接到自下而上的骨干层,而 SAC 利用具有不同卷积核大小的膨胀卷积来捕捉多尺度的感受野。Vu 等人 [88] 开发了样本一致性网络(SCNet),作为对 Cascade Mask R-CNN 的扩展。SCNet 在最后的边界框回归阶段后引入了一个掩码分支,以确保样本一致性。Fang 等人 [89] 提出了 QueryInst,该方法将基于查询的检测引入实例分割任务。该方法采用多头注意力机制和动态卷积来从查询中学习实例特征。受到一阶段目标检测的启发,也出现了一些代表性的一阶段实例分割方法。Bolya 等人 [90] 提出了名为 YOLACT 的单次、无锚点、实时实例分割方法。YOLACT 使用特征金字塔网络从输入图像中提取不同尺度的特征,然后通过一系列卷积层处理这些特征,为每个检测到的对象生成类别特定的分割掩码和边界框。YOLACT 的主要优点之一是其效率。它能够在保持实时性能的同时实现高准确性,使其适用于视频目标分割应用。考虑到 MS COCO 数据集中实例中心位置和尺度比的分布特征,Wang 等人 [91] 提出了一个名为 SOLO 的一阶段方法,该方法将实例分割转化为语义分类和像素级掩码分类。SOLOv2 [92] 是 SOLO 的演变,采用动态实例分割策略来构建统一的高分辨率掩码特征表示。此外,SOLOv2 引入了矩阵 NMS,利用矩阵并行操作加速 NMS 过程。

b) 基于记忆的分割方法:多模态跟踪 Transformer(MTTR)[93] 是一种简单的基于记忆的参考视频目标分割方法。MTTR 将任务表述为序列预测问题,不依赖于与文本相关的归纳偏置模块。它通过简单的交叉熵损失来对齐视频和文本。VisTR [94] 是一种基于记忆的视频实例分割框架,将视频实例分割任务视为简单的端到端并行序列解码或预测问题。它采用高效的实例序列匹配和分割策略,在整个序列级别进行监督和分割。通过采用相似性学习作为核心概念,VisTR 简化了整个过程,并使其与现有方法区分开来。EfficientVIS [95] 是一个专注于高效训练和推理的端到端框架。其核心组件是跟踪查询和跟踪建议,它们通过迭代查询视频交互在空间和时间上协作分割 RoIs。与 VisTR 相比,EfficientVIS 在训练时间上减少了 15 倍,同时在 YouTubeVIS 基准测试中实现了最新的准确性。Mask Transfiner [96] 通过提出一种掩码转换器,利用四叉树表示图像区域,而不是在规则的密集张量上操作,从而引入了一种新颖的实例分割方法。该方法允许仅处理错误概率高的树节点,同时并行自我纠正错误。该方法在三个流行的基准测试中优于现有实例分割方法,并显著改善了两阶段基于查询的框架。SeqFormer [97] 是另一种旨在提高视频中的实例分割准确性的方法。与现有算法不同,SeqFormer 为视频中的每个对象创建一个特征,并引入查询分离机制以提取每帧中的对象位置信息,然后将其汇总以更高效地表示每个实例在视频级别。Idol [98] 是另一种实例分割方法,它嵌入实例并利用视频历史信息以确保算法稳定性,结果性能水平与或高于离线模型。

Object Knowledge Distillation for Joint Detection and Tracking in Satellite Videos(2024 多目标跟踪)

其他

WHU-Stereo: A Challenging Benchmark for Stereo Matching of High-Resolution Satellite Images

遥感图像语义分割

这个帖子介绍了很多分割的数据集

SISP: A Benchmark Dataset for Fine-grained Ship Instance Segmentation in Panchromatic Satellite Images

Graph Dynamic Earth Net: Spatio-Temporal Graph Benchmark for Satellite Image Time Series

Satellite Component Semantic Segmentation: Video Dataset and Real-Time Pyramid Attention and Decoupled Attention Network

Satellite Component Semantic Segmentation: Video Dataset and Real-Time Pyramid Attention and Decoupled Attention Network

zp

Unsupervised Satellite Video Deep Intrinsic Decomposition Using Physical Prior Constraints

MP2Net: Mask Propagation and Motion Prediction Network for Multi-Object Tracking in Satellite Videos

数据集

视频单/多标签分类

Satellite Video Multi-Label Scene Classification With Spatial and Temporal Feature Cooperative Encoding: A Benchmark Dataset and Method(2024 多标签分类+数据集)

视频多标签分类旨在通过学习视频内容的高质量潜在表示,预测预定义类别集中最相关的标签[1][2]。这一过程在视频检索[3]、视频问答[4]和视频理解[5][6]中扮演着重要角色。随着卫星成像技术和视频卫星的发展,现在可以获取高分辨率的连续观测视频来监测特定地面区域[7]。广阔的观测视野和丰富的空间及时间信息使得连续的卫星观测视频适用于土地规划、海洋观测和智慧城市[8]等应用,这些应用需要生成卫星视频中包含的静态和动态语义信息。这一过程被定义为卫星视频多标签场景分类任务。

深度学习的进步推动了通用视频理解的发展,特别是视频多标签分类。大多数现有研究专注于长期视频序列特征的编码,这些方法可以分为两种模式:基于时间和有序特征编码的分类(CB-TOE)[9][10][11][12][13] 和基于时间和无序特征编码的分类(CB-TDE)[14][15][16]。CB-TOE 和 CB-TDE 方法都将视频多标签分类的流程分为两个步骤:帧特征提取和长期帧特征编码。CB-TOE 方法将帧特征视为有序序列,通过捕捉视频的有序和时间结构生成视频级表示。而 CB-TDE 方法将帧特征视为集合,通过学习视频中显著特征的分布生成视频级表示。最终,视频级特征用于多标签分类。

摘要:

摘要— 卫星视频多标签场景分类预测多个地面内容的语义标签,以描述给定的卫星观测视频,这在海洋观测、智慧城市等应用中发挥着重要作用。然而,高质量和大规模数据集的缺乏阻碍了任务的进一步改进。此外,现有针对一般视频的方法在直接应用于卫星视频时难以有效表示地面内容的局部细节。本文的贡献包括:(1) 我们开发了第一个公开的大规模卫星视频多标签场景分类数据集。该数据集包含18类静态和动态地面内容,3549个视频和141960帧。(2) 我们提出了一种基线方法,采用了新颖的空间和时间特征协同编码(STFCE)。该方法利用局部空间和时间特征之间的关系,并对隐藏在帧间变化中的长期运动信息进行建模。通过这种方式,它能够增强局部细节特征,并获得强大的视频场景级特征表示,从而有效提升分类性能。实验结果表明,我们提出的STFCE在全球平均精度(GAP)达到0.8106,超越了13种最先进的方法,并且空间、时间和运动特征的细致融合和联合学习有助于实现更强健和准确的模型。此外,基准测试结果显示,所提出的数据集非常具有挑战性,我们希望它能促进卫星视频多标签场景分类任务的进一步发展。

为什么:

当现有的通用视频方法直接应用于卫星视频观测场景时,通常会导致低质量的预测,从而造成分类性能较差。这是因为卫星视频观测场景广阔,局部地面内容包括一些小物体,如停车场中的车辆或港口中的船只,其尺寸小于15像素[18],这使得特征表示变得困难。此外,长期运动表示和某些动态物体(例如火车)的特征编码也带来了极大的挑战。大多数现有的 CB-TOE 和 CB-TDE 方法直接编码视频帧中的外观特征,这些方法在卫星视频观测场景中由于缺乏有效的局部细节和运动信息表示,导致预测质量较低,从而影响分类准确性。

为了解决这些问题,本文考虑了局部细节的特征增强和运动特征编码,以实现对卫星视频观测场景的准确和高质量预测。基于这些动机,我们首先开发了第一个公开的大规模卫星视频多标签场景分类数据集,该数据集基于吉林一号卫星观测视频,包含18个类别的静态和动态地面内容,3549个视频和141960帧。然后,我们提出了一种基于新型空间和时间特征协同编码 (STFCE) 策略的基线方法。STFCE 方法基于 CB-TOE 方法,通过表示强大的局部细节特征和编码动态物体的潜在运动信息,准确高效地预测卫星视频观测场景的语义标签。具体而言,我们提出了全球空间和时间特征编码 (GSTE) 和双向差分运动特征编码 (BDME) 模块。GSTE 通过全球特征交互和聚合来提升局部细节特征,尤其是小物体的特征。BDME 模块通过双向编码长期外观特征和帧间差异,建模动态物体的强大运动特征,从而获得稳健的视频场景级特征表示用于分类。

其他数据集:

目前,主要有两个公开的卫星视频单标签场景分类数据集,SVSC [8],[17],它们使用单一标签来描述卫星视频观测场景中最显著的地面内容。

SVSC 是由哈尔滨工业大学团队于2020年发布的第一个卫星视频单标签场景分类数据集,基于吉林一号卫星观测视频,包含8个类别的静态场景,包括飞机、跑道、桥梁、港口、高速公路、交叉口、高架桥、停车场。该数据集包括7209个卫星视频,其中5630个用于训练,1579个用于测试。

基于SVSC,[17] 提取了包含动态物体的18类场景,通过事件关注 (EOI) 提取方法[20],包括繁忙的桥梁、繁忙的高速公路、繁忙的交叉口、繁忙的高架桥、繁忙的停车场、繁忙的圆环、繁忙的跑道、自由桥梁、自由高速公路、自由交叉口、自由高架桥、自由停车场、自由圆环、自由跑道、繁忙的港口、中等繁忙的高速公路、繁忙的水域和自由水域,并构建了一个包含797个视频用于训练和1569个视频用于测试的新数据集。尽管该数据集考虑了动态物体,但无法生成其语义信息。

SVSC 和 [17] 数据集均未公开。

[8]Deep feature extraction and motion representation for satellite video scene classification

[17]Satellite video scene classification using low-rank sparse representation two-stream network

Enhancing Image Annotation With Object Tracking and Image Retrieval: A Systematic Review

Enhancing Image Annotation With Object Tracking and Image Retrieval: A Systematic Review

总结

目标检测,针对物体有很多类如桥,烟囱,罐子等,有静态图像下的检测,也就是图像源头多来自谷歌地图,但是前后帧没有任何联系,并且谷歌地图相对来说比较清楚,难度小一点,也有粗粒度以及较细粒度的检测,然后卫星视频的数据集较少,则可以通过前后帧的联系来辅助检测,并且卫星帧基本上只对车,船,飞机,火车进行检测,没有进行细粒度的检测即将车辆分类为卡车,皮卡,小轿车,但是关船,则可以分类为货船以及军舰,因为目前的卫星视频中小车实在太少了,难以进行更细粒度的检测。

luojia 三号卫星