目录

第12章 广告数仓全流程调度

12.2 新数据生成

12.2.1 广告监测日志

12.2.2 广告管理平台数据

12.3 工作流调度实操

12.3.1 DolphinScheduler集群模式

12.3.2 DolphinScheduler单机模式

第12章 广告数仓全流程调度

12.1 调度工具Dolphinscheduler

DolphinScheduler的安装和使用可参考以下文档。

大数据技术——DolphinScheduler的集群部署-CSDN博客

12.2 新数据生成

12.2.1 广告监测日志

1)启动日志采集通道,包括Kafka、Flume等

(1)启动Zookeeper

[atguigu@hadoop102 ~]$ zk.sh start

(2)启动Kafka

[atguigu@hadoop102 ~]$ kf.sh start

(3)启动Flume

[atguigu@hadoop102 ~]$ ad_f1.sh start

[atguigu@hadoop102 ~]$ ad_f2.sh start

2)修改日志模拟器配置文件

修改hadoop102和hadoop103两台节点中的/opt/module/ad_mock/nginxLogGen.setting文件,修改模拟数据时间参数如下。

#生成数据的开始时间

startTime = 2023-01-08 00:00:00

#生成数据的结束时间

endTime = 2023-01-09 00:00:00

3)执行日志生成脚本

[atguigu@hadoop102 ~]$ ad_mock.sh

4)观察HDFS上是否有2023-01-08的日志数据生成

12.2.2 广告管理平台数据

广告管理平台的数据主要作为维度信息,此处不再生成或修改,后续直接全量同步即可。

12.3 工作流调度实操

由于DolphinScheduler集群模式启动进程较多,对虚拟机内存要求较高。故下面提供两种方式,可根据虚拟机内存情况进行选择。

12.3.1 DolphinScheduler集群模式

1)启动DolphinScheduler

[atguigu@hadoop102 dolphinscheduler]$ bin/start-all.sh

2)使用普通用户登录

3)向DolphinScheduler资源中心上传工作流所需脚本

(1)创建文件夹

(2)上传工作流所需脚本

将工作流所需的所有脚本上传到资源中心ad_scripts路径下,结果如下。

4)向DolphinScheduler资源中心上传工作流所需jar包

(1)创建文件夹

(2)上传工作流所需脚本

注:jar包名不能过长,若上传失败,请改名重试。

5)向DolphinScheduler的WorkerServer节点分发脚本依赖的组件

由于工作流要执行的脚本需要调用Hive、DataX等组件,故在DolphinScheduler的集群模式下,需要确保每个WorkerServer节点都有脚本所依赖的组件。

[atguigu@hadoop102 ~]$ xsync /opt/module/hive/

[atguigu@hadoop102 ~]$ xsync /opt/module/spark/

[atguigu@hadoop102 ~]$ xsync /opt/module/datax/

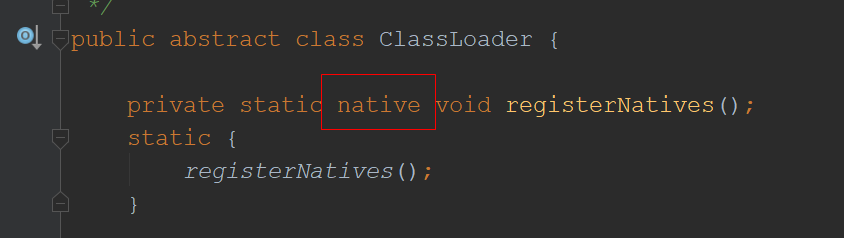

6)创建所需环境

(1)切换到admin用户

(2)点击环境管理/创建环境

(3)配置环境

注:具体环境变量如下,其中的SPARK_HOME1和SPARK_HOME2供后续的SPARK类型的任务使用。

export HADOOP_HOME=/opt/module/hadoop

export HADOOP_CONF_DIR=/opt/module/hadoop/etc/hadoop

export SPARK_HOME=/opt/module/spark

export SPARK_HOME1=/opt/module/spark

export SPARK_HOME2=/opt/module/spark

export JAVA_HOME=/opt/module/jdk1.8.0_212

export HIVE_HOME=/opt/module/hive

export DATAX_HOME=/opt/module/dataxexport PATH=$PATH:$HADOOP_HOME/bin:$SPARK_HOME/bin:$JAVA_HOME/bin:$HIVE_HOME/bin:$DATAX_HOME/bin

6)创建工作流

(1)切换到普通用户

(2)创建项目ad

(3)在ad项目下创建工作流

(4)各任务节点配置如下

①ad_mysql_to_hdfs_full

②ad_hdfs_to_ods

③ad_ods_to_dim

④ad_ods_to_dwd

⑤hive_to_clickhouse

(5)各节点依赖关系如下

(6)保存工作流

注:定时调度时,全局参数值应设置为$[yyyy-MM-dd-1]或者空值。

7)上线工作流

8)运行工作流

12.3.2 DolphinScheduler单机模式

1)启动DolphinScheduler

[atguigu@hadoop102 dolphinscheduler]$ bin/dolphinscheduler-daemon.sh start standalone-server

2)其余操作

其余操作与集群模式基本一致,其中分发Hive、Spark、DataX这一步可以省略。

前面章节:

大数据项目——实战项目:广告数仓(第一部分)-CSDN博客

大数据项目——实战项目:广告数仓(第二部分)-CSDN博客

大数据技术——实战项目:广告数仓(第三部分)-CSDN博客

大数据技术——实战项目:广告数仓(第四部分)-CSDN博客

大数据技术——实战项目:广告数仓(第五部分)-CSDN博客

大数据技术——实战项目:广告数仓(第六部分)-CSDN博客