文章目录

- 1. 【2023CoRL】A Universal Semantic-Geometric Representation for Robotic Manipulation

- 针对痛点和贡献

- 引言

- 模型框架

- 思考不足之处

- 2. Leveraging Locality to Boost Sample Efficiency in Robotic Manipulation

- 摘要和结论

- 引言

- 模型框架

- 实验

- 思考不足之处

1. 【2023CoRL】A Universal Semantic-Geometric Representation for Robotic Manipulation

针对痛点和贡献

痛点:

- 尽管RGB相机记录了富含语义信息的2D图像,但缺少精确的空间信息;而深度相机提供了关键的3D几何数据,但语义理解有限。因此,整合这两种模态对于学习机器人感知和控制的表征至关重要。

贡献:

- 作者提出了一种名为Semantic-Geometric Representation (SGR) 的通用感知模块,利用大规模预训练的2D模型的丰富语义信息,并继承了3D空间推理的优势。

引言

使用RGB相机捕获高分辨率的2D图像来推理复杂的空间关系是困难的。

另一方面,深度相机提供了3D几何信息,这对于精确的细粒度操控至关重要。尽管如此,它们在语义理解方面有限。

在利用预训练的大型视觉模型来学习视觉表征的越来越多的研究中,这些模型通过预训练获得了对世界的一般性知识。** 我们的世界本质上是三维的。面对现实世界环境的复杂性,只有2D先验知识的机器人可能会面临诸如部分遮挡和几何形状理解的挑战。** 因此,开发能够有效处理3D视觉数据的模型对于使机器人进行有效的空间推理至关重要。

一个自然而直观的解决方案是开发预训练的3D视觉模型。然而,尽管在视觉界有一些尝试[18, 19, 20, 21],但由于两个主要原因,当前的模型还没有足够的迁移性到机器人操控任务。(i)昂贵的数据获取和劳动密集型的注释过程导致缺乏大规模的3D数据集[22, 23]。(ii)具有稀疏结构模式的3D点云与多彩的2D图像相比,没有提供多样化的语义,从而限制了3D预训练的泛化能力[24]。

为了解决单独使用2D或3D视觉模型所带来的挑战,我们提出了语义几何表征(Semantic-Geometric Representation, SGR),这是一种混合感知模块。

我们首先使用一个大型视觉基础模型,在大量的互联网数据上预训练,以从2D图像中编码语义特征图。其次,这些内容丰富的2D特征向量被重新投影到3D空间,并与使用基于点的网络从点云中提取的点云特征相结合。这些融合的特征被送入多个集合抽象(Set Abstraction, SA)块,这些块共同模拟2D语义和3D几何信息之间的跨模态交互。最后,基于SA块的输出表征,我们预测要执行的机器人动作。

模型框架

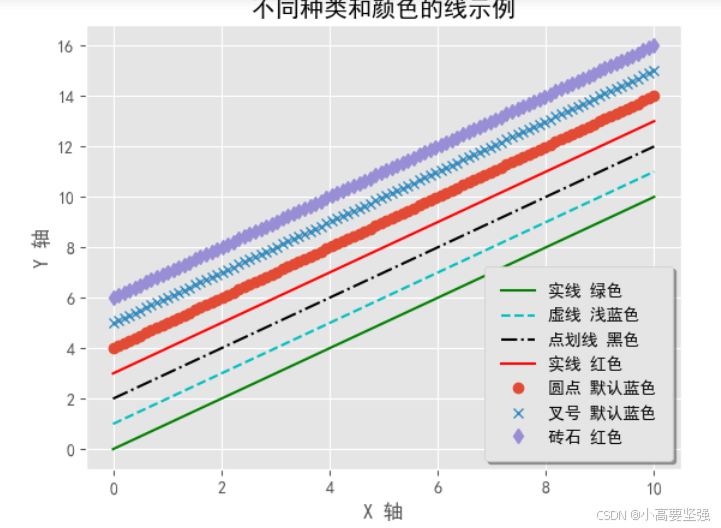

-

我们首先使用一个冻结的预训练2D模型G(例如,CLIP的视觉编码器)从多视图图像中提取特征{G(Ii)}K i=1。如果任务提供了语言指令S,我们使用预训练的语言模型H(例如,CLIP的语言编码器)获得语言编码H(S)。 视觉锚定模块 接下来,我们通过双线性插值将视觉特征图{G(Ii)}K i=1(或对齐的特征图{Mi}K i=1)上采样到与输入图像相同的尺寸,并使用1×1卷积将通道降采样,得到一组特征{Fi}K i=1,其中Fi ∈ RH×W ×C1,H, W代表图像尺寸。这些编码的2D特征包含了丰富的高级语义,被重新投影回3D空间,为点云生成逐点的语义特征。

-

使用多视图深度图像和已知的相机参数(即相机内参和外参)生成原始点云。随后,我们使用基于点的网络(例如,分层的PointNeXt)处理点云P′。这一处理步骤产生了下采样的点几何特征。表示为G ∈ RM×C2,其中M < N。虽然这些几何特征有效地捕获了局部3D结构和空间特征,但它们缺乏对语义信息的理解。

-

为了整合这两个互补的分支,我们首先使用与几何分支相同的点子采样过程处理逐点语义特征F3D。接下来,我们通过通道级联的方式将语义特征和几何特征融合在一起,表示为F 3D fuse = Concat(F 3D sub, G) ∈ RM×(C1+C2)。最后,融合的特征经过几个集合抽象块[30],这使得2D语义和3D几何信息之间的跨模态交互得以共同建模。所得到的全局特征代表了我们的语义几何表征,它被用于动作预测。

-

平移是回归,其余均为分类。(与Q function一样)

思考不足之处

- 多模态 Transformer,能够以更优雅的方式对各种模态进行编码和融合。

- 线性插值来生成每个点的rgb特征效果可能没那么好。

- 仅使用encoder来编码点云,丢掉了很多细节。

文章目录

- 1. 【2023CoRL】A Universal Semantic-Geometric Representation for Robotic Manipulation

- 针对痛点和贡献

- 引言

- 模型框架

- 思考不足之处

- 2. Leveraging Locality to Boost Sample Efficiency in Robotic Manipulation

- 摘要和结论

- 引言

- 模型框架

- 实验

- 思考不足之处

2. Leveraging Locality to Boost Sample Efficiency in Robotic Manipulation

摘要和结论

旨在通过改进视觉和动作表示来提高样本效率。SGRv2的核心设计是引入了一个关键的归纳偏差——动作局部性(action locality),它认为机器人的动作主要受目标物体及其与局部环境的交互影响。

引言

在机器学习中,引入归纳偏差是提高样本效率的一种标准策略。例如,卷积神经网络(CNNs)[4, 5]在每一层中都嵌入了空间层次结构和平移等变性,而循环神经网络(RNNs)[6]和长短期记忆网络(LSTMs)[7]在其架构中加入了时间依赖性。

在机器人操控领域,一个关键的归纳偏差是动作局部性,它认为机器人的动作主要由目标物体及其与周围局部环境的关系决定。然而,以前关于机器人操控表示学习的研究并没有有效地利用这种偏差。通常,这些研究[8, 9, 10, 11]旨在开发一种全局表示,涵盖整个场景,然后直接用于预测机器人动作。这些方法表现出了显著的低样本效率。

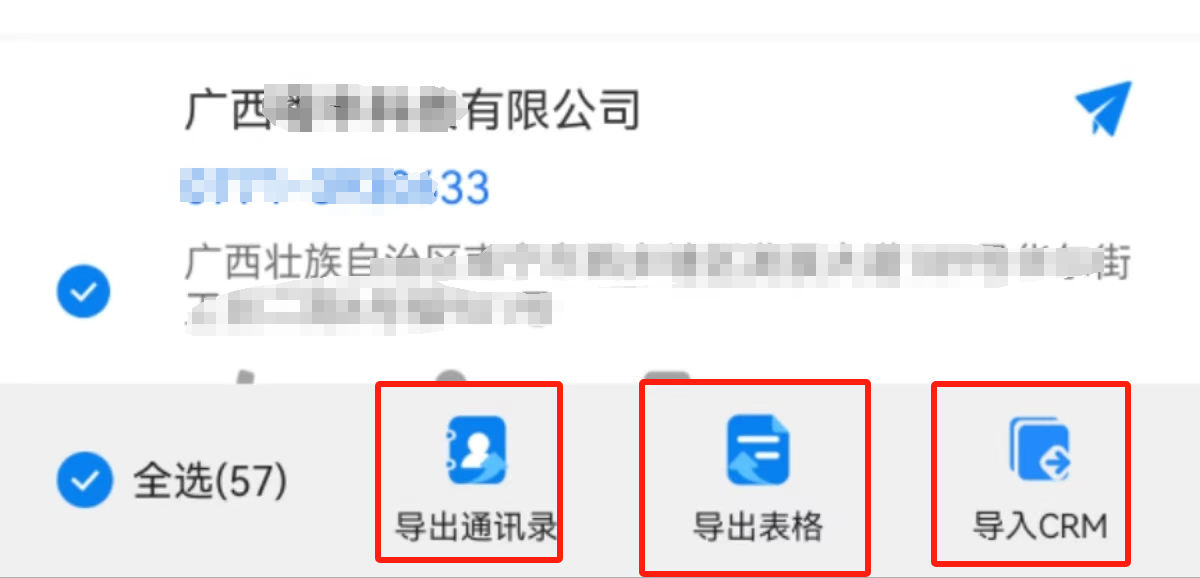

模型框架

- Encoder-Decoder Architecture. 请注意,如 PointNeXt [15] 中设计的,输出特征仅依赖于相对坐标,确保逐点特征 fi 对输入坐标的平移变换保持不变。这个逐点特征作为我们位置感知动作建模的基石。

- Relative Position Predictions 使用逐点特征,我们可以预测每个点的动作。我们的关键见解是,末端执行器通常在每个执行阶段向靠近特定对象的目标移动。因此,预测目标相对于每个点的位移是很自然的。对于关键帧,我们通过pi+∆p(fi)表示关键帧动作apos的位置分量,其中pi和fi分别是第i个点的坐标和逐点特征,∆p是多层感知器(MLP)

- Weighted Average Actions. 在获得逐点动作预测后,我们需要将这些预测整合到一个聚合的动作预测中。我们采用了一个简单但有效的策略,即加权平均。对于每个组成部分,包括位置(在密集控制中被分解为方向和大小)、旋转、夹爪开启状态和碰撞指示器,我们为每个点使用一个学习到的权重w*(fi)。这里,w*表示每个组成部分的单独MLP(应用softmax进行归一化)。这种设计背后的动机是,点云内只有少数区域对于完成任务至关重要。例如,在拾取立方体的任务中,位于立方体上的点比周围桌子上的点更具信息量。通过学习这些权重,我们使聚合预测集中于最具预测性的局部区域,从而提高整体准确性和样本效率。

实验

思考不足之处

- 一步一步的预测必定会导致累计误差

- 相比于现在大火的diffusion policy,损失了动作的多模态性。