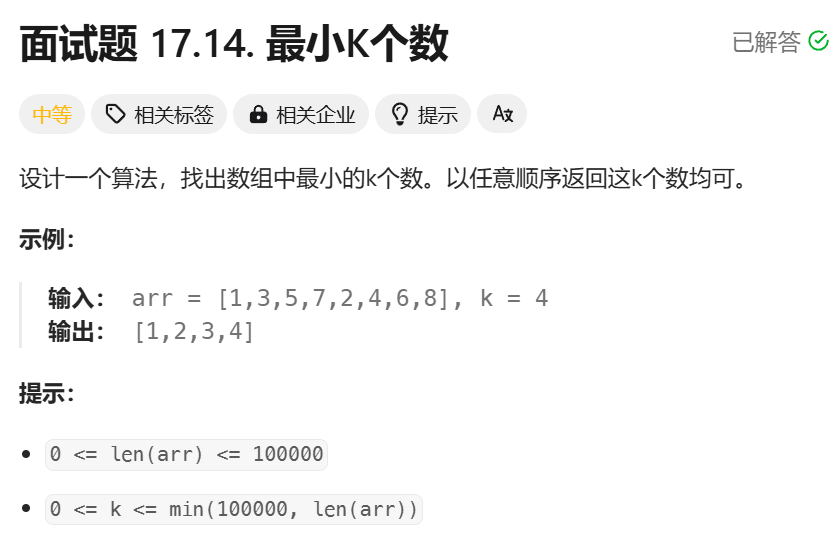

发表时间:22 Dec 2023

论文链接:https://readpaper.com/pdf-annotate/note?pdfId=4836882796542689281¬eId=2413286807916664832

作者单位:Google DeepMind

Motivation:受视觉和语言基础模型的最新进展的启发,我们提出了一种用于机器人操作的多任务通用agent。这个名为 RoboCat 的agent是一个视觉目标条件决策转换器,能够消耗动作标记的视觉经验。这些数据跨越了来自模拟和真实机械臂的大量运动控制技能,具有不同的观察和动作集。

解决方法:我们最终旨在为操纵奠定基础agent,它是在大量机器人情景经验上训练的multi-embodiment agent,使其能够通过微调快速适应广泛的新下游任务。作为实现这一目标的步骤,我们在非常大的不同操作行为数据集上训练 RoboCat:精确和灵巧的基于视觉的任务,使用具有不同自由度、各种观察和动作规范的实施例执行,并在不同的控制频率下操作。

我们的agent通过利用转换器基于上下文的输入和输出可变长度序列的能力,在本地处理这些变化,而不需要常见的动作或观察表示。它能够成功地适应多个新任务——包括新的机器人实施例、看不见的行为、物体和感知变体,以及模拟到真实的——通过对 100 到 1000 个演示的新情景经验的一小部分数据集进行微调。这显著减少了获取新技能和实施新实施例的成本。

我们进一步使用微调的 RoboCat 模型来收集额外的数据,这些数据后来被添加以训练我们的agent的新迭代。

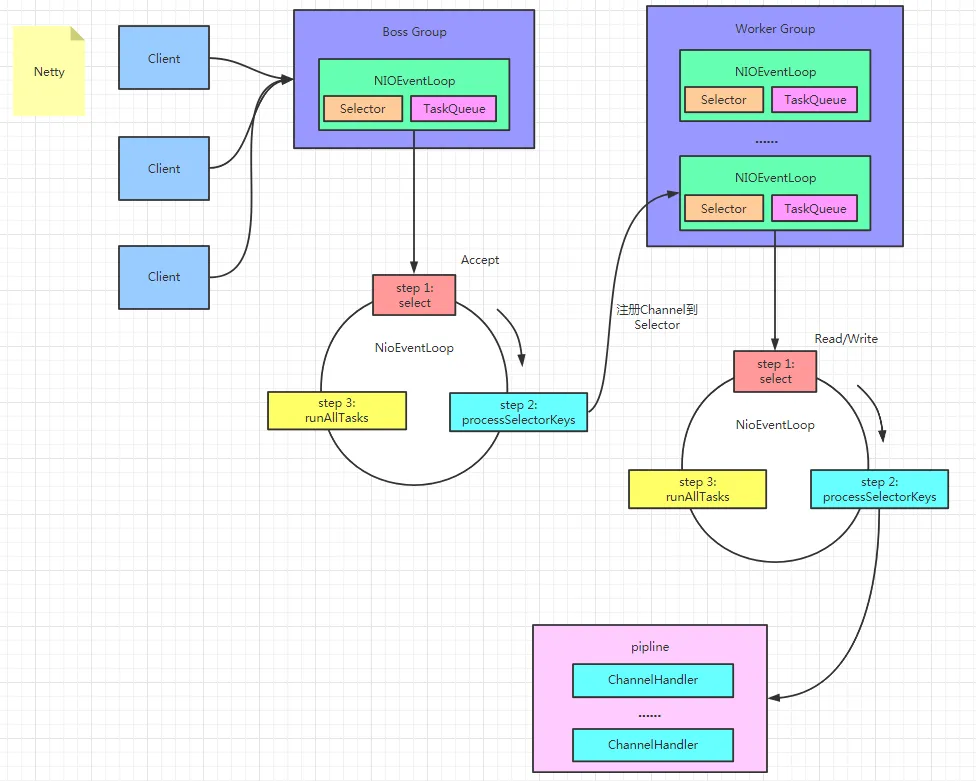

实现方式:RoboCat is based on the Gato architecture with a VQ-GAN encoder。

The majority of the experimental results are based on models with a 1.18Bparameter decoder-only transformer (Vaswani et al., 2017) with 24 layers。

(1)我们首次证明,大型transformer序列模型可以在具有不同观察和动作规范的多个真实机器人实施例上解决大量灵巧任务;

(2)我们研究了RoboCat在适应看不见的任务方面的能力,with just a small dataset of expert demonstrations,与基线相比,降低了学习新技能的门栏;

(3)我们表明,通过简单但有效的self-improvement过程(指的是收集新的数据),可以将这些技能纳入通才;

(4)我们表明,通过缩放和扩大训练数据,RoboCat在培训任务上表现更好,在微调时效率更高。

是如何进行self-improvement的?

先自己收集少量数据,对policy进行微调。然后将微调后的policy进行部署,然后让机械臂自己去收集。并且 perform hindsight goal relabelling,这也是本文能利用少量的demonstrations适应新的任务进行小样本学习的关键。

训练过程: In the training phase, the VQ-GAN tokeniser is pre-trained, and then the RoboCat generalist agent is trained on a wide dataset covering multiple domains and embodiments, specifying tasks via visual goals。

The generalist is then finetuned on a small set of human-teleoperated demonstrations to specialise to a new task, and deployed to collect on-policy data autonomously。

This data is finally added to the original data to train the next, self-improved RoboCat.

实验:We trained and evaluated 59 different VFM baselines; 36 real robots in this work

RoboCat 在专家和非专家数据上进行训练。数据的不同子集以不同的方式收集。我们使用三种类型的数据生成:

(i) 专家 RL 代理产生的数据,特别是在模拟中使用;

(ii) 人类远程操作的专家数据,主要用于物理世界任务;

(iii) 自我生成的数据。两种专家轨迹类型的主要区别在于,由于 RL 代理在现实世界中的行为方式,代理数据提供了相当平滑和高效的轨迹,而远程操作数据通常包括暂停,因为远程操作者使用类似于 bang-bang 控制器的行为。

结论:A key contribution of our work is our study into how RoboCat agents can be fine-tuned and self-improved given a relatively small number of demonstrations.(关键在于Fine-tuned agent self-generates much more training data,是小样本学习的关键)

在这个微调步骤结束时,我们获得了一个专门用于新任务的代理,但可能会丢失原始训练任务的性能(可能会有灾难性遗忘的问题)。