声明:笔记是做项目时根据B站博主视频学习时自己编写,请勿随意转载!

温馨提示:对于我的电脑没有Nvidia的独显,只有Intel的集显,最后导出时无法识别Nvidia显卡设备!!就没成功!! 如果你的torch与我一样之前安装的CPU版本,那么很可能最后与我一样!

一、模型部署概述

算法要落地到实际应用,这就叫模型部署!

模型部署是将训练好的机器学习或深度学习模型集成到实际应用中,使其能够对外提供服务的过程。只有将模型部署到实际应用中,才能发挥其作用,为企业或个人带来实际效益。

主要包括在线部署和离线部署两种。

- 在线部署:是指将训练好的模型直接部署到实时应用场景中,以实时处理和预测数据。其主要优势在于实时性和高效性。其算法原理是将训练好的模型加载到内存中,然后通过输入数据流进行处理和预测。

具体步骤:①加载训练好的模型文件、②将输入数据流转换为模型所需的格式、③通过模型进行处理和预测,④输出预测结果。

- 离线部署:则是将训练好的模型部署到非实时应用场景中,以批量处理和预测数据。它的主要优势在于数据安全和计算资源利用率。离线部署的算法原理是将训练好的模型保存到磁盘中,然后通过批量输入数据进行处理和预测。

具体步骤包括:①训练好的模型保存到磁盘中、②将批量输入数据加载到内存中、③通过模型进行处理和预测,④将预测结果保存到磁盘中。

大模型和小模型的部署方式区别:

- 大模型通常参数较多、层数较深,因此具有更强的表达能力和更高的准确度。但是,这也意味着大模型需要更多的计算资源和时间来训练和推理。在部署大模型时,往往需要考虑到服务器的性能、内存和存储等要求。

常见的部署方式包括将模型部署为Web服务,或者将模型打包成Docker镜像后部署到云服务器上。这些方式可以充分利用云端的强大计算资源,满足大模型对性能的需求。

- 小模型通常参数较少、层数较浅,具有轻量级、高效率、易于部署等优点。这些模型适用于数据量较小、计算资源有限的场景,例如移动端应用、嵌入式设备等。

在部署小模型时,可以考虑将模型直接部署到这些设备上,或者使用一些轻量级的框架来实现。这样既可以节省计算资源,又可以实现快速响应和实时处理。

训练框架和推理引擎的不同角色:

- 训练框架主要用于模型的训练阶段,它提供了构建、训练和验证机器学习模型的工具和方法。训练框架通常包含了大量的优化算法和技巧,以及丰富的数据处理和模型调优功能,帮助研究人员和开发者更高效地训练出高质量的模型。

- 当模型训练完成后,需要将其部署到实际应用中进行推理时,就需要使用推理引擎了。

推理引擎是实施问题求解的核心执行机构,它主要负责在设备端高效地运行模型,进行前向推理。与训练框架相比,推理引擎更关注于模型的执行效率和性能优化,以满足实际应用中对于实时性、准确性和资源消耗等方面的要求。

二、TensorRT推理引擎

TensorRT是NVIDIA开发的一种高性能深度学习推理优化器和运行时加速库(引擎),主要用于加速深度学习应用在生产环境中的部署。

目标是为深度学习应用提供低延迟、高吞吐率的部署推理。TensorRT可以支持TensorFlow、Caffe、Mxnet、Pytorch等几乎所有的深度学习框架,与NVIDIA的GPU结合,它能在这些框架中进行快速和高效的部署推理。

模型部署时不再使用训练时的Torch框架,主要有以下几个原因:

- 资源消耗与性能:训练阶段,为了加快训练速度,通常会使用多GPU分布式训练,这在资源消耗上是非常大的。然而,在实际部署时,出于成本考虑,往往不会使用过多的GPU资源,甚至会选择使用CPU进行模型的推理。

TensorRT正是针对这种情况,通过优化内存使用和网络结构,减少推理过程中的内存消耗,提高系统整体效率,从而实现低延迟和高吞吐量的推理。

- 跨平台支持:TensorRT支持主流的GPU架构,如NVIDIA的CUDA架构,这使得它可以在不同平台上部署和运行优化后的模型,增加了模型的灵活性和可移植性。

- 模型优化:TensorRT提供了灵活的API和工具,可以根据需求进行网络结构的剪枝、融合和量化,实现模型的定制化优化。此外,它还能针对特定的硬件平台(如NVIDIA GPU)优化模型,从而实现更快的推理速度。

1、环境安装

①CUDA

下载链接如下:

CUDA-11-6-0下载![]() https://developer.nvidia.com/cuda-11-6-0-download-archive

https://developer.nvidia.com/cuda-11-6-0-download-archive

选择对应电脑系统的版本,右下角下载,下载后安装一直点“Next”即可!这样安装完一般都在C盘的以下文件路径:

②CUDNN

下载链接如下:

CUDNN下载![]() https://developer.nvidia.com/rdp/cudnn-archive

https://developer.nvidia.com/rdp/cudnn-archive

这里下载上面这个压缩包,解压复制里面的4个文件:

将这4个文件粘贴在CUDA的路径下:

若前两步安装正确,在终端中输入nvcc -V会显示如下:

③TensorRT

TensorRT安装![]() https://developer.nvidia.com/nvidia-tensorrt-download

https://developer.nvidia.com/nvidia-tensorrt-download

下载解压后里面的文件如下:

这里的python文件夹里面有一些预编译好的库文件,需要根据我们的python版本用pip进行安装。具体操作如下:

- 查看我们的python版本为3.8.19,则需要pip安装第三个cp38的版本

- 从文件路径处输入“cmd”回车直接可进入目标目录的cmd窗口:

- 激活环境后直接输入pip命令+文件名即可安装对应cp38版本的tensorrt:

此外lib文件夹中的文件如下,需要把它们复制粘贴在刚才CUDA安装位置的bin文件夹里:

粘贴位置如下(C盘):

④zlibwapi.dll

若之前训练安装的是CU116版本的Pytorch,可不必这一步!!其他版本的似乎没有这个文件

zLibDll文件![]() https://www.winimage.com/zLibDll/

https://www.winimage.com/zLibDll/

将压缩包里zlibwapi.dll这个应用扩展程序也粘贴在CUDA的bin文件夹中:

2、模型导出

①pip install onnx

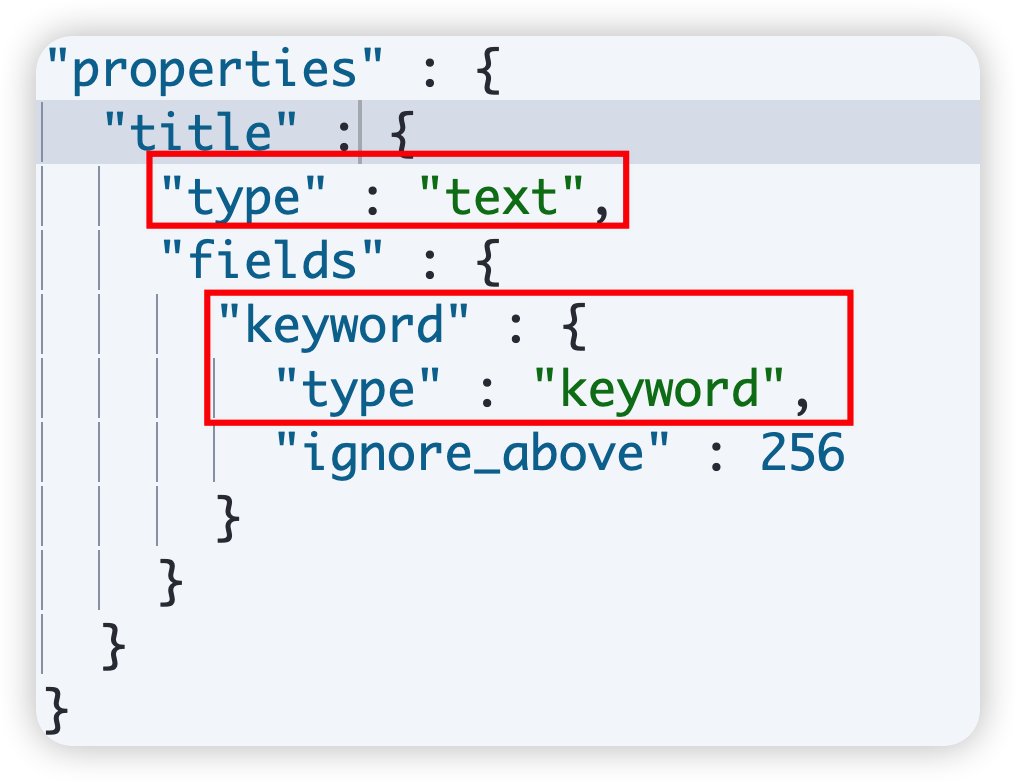

打开yolov5的项目文件夹的export.py文件,可见上面注释“Format”支持导出很多种格式,默认的模型格式是Pytorch。

“Requirements”提示我们需要安装requirements.txt和onnx,requirements.tx之前已经有了,onnx可以理解为一个“中间格式适配器”,很多格式都可以先转换为onnx格式然后再转换为其他格式:

下面安装下onnx:

pip install onnx

②导出命令

export.py的导出使用方法注释“Usage”中也有,include后面的根据“Format”第二列中选择对应格式的字段,比如TensorRT格式对应engine:

终端中输入以下代码运行导出,发现报错说“必须运行在GPU”上:

再代码后指定设备--device 0即可:

python export.py --weights yolov5s.pt --include engine --device 0对于我的电脑没有Nvidia的独显,只有Intel的集显,所以这里无法识别设备!!就没成功!!

某站作者大大(@你可是处女座啊)导出完成后的界面如下,给出了不同的用法如detect.py、val.py、torchhub用法等:

yolov5s.pt权重文件所在目录会出现一个名为yolov5s.engine的对应tenorrt格式的权重文件。

③torch和tensorrt效果对比

- 使用torch运行detect.py

运行速度:

- 使用tensorrt运行detect.py(权重文件改为yolov5s.engine即可)

运行效果:

发现使用tensorrt的时间还臂用torch的时间慢了0.7ms,这是为什么呢?

因为torch的输入维度是384x640,而tensorrt的输入维度是640x640(模型在部署落地应用时一般输入维度都是固定的,所以tensorrt在加速时维度是定死的,不可改的),之所以是640x640是因为导出tensorrt格式时为指定维度:

python export.py --weights yolov5s.pt --include engine --device 0若想导出tensorrt格式时将维度定为384x640以便与torch的检测速度对比,则重新导出:

python export.py --weights yolov5s.pt --include engine --device 0 img 384 640- 重新使用tensorrt运行detect.py文件(注意指定对应的权重文件),结果如下,可见速度提升了不少:

拓:若想导出tensorrt格式时指定半精度推理,可用下面导出方法:

python export.py --weights yolov5s.pt --include engine --device 0 img 384 640 --half导出后,再次运行detect.py文件(注意指定对应的权重文件),结果如下,速度又提升了点:

不只是导出tensor格式时可指定img大小,运行detect.py时也可指定img的维度,只是该维度不能超过导出时最大的384x640,例如运行detetc.py时指定img192x640:

可发现检测速度又有了提升:

三、基于Flask的YOLOv5项目部署

1、基于文件的模型检测

主要文件:

2、基于图像的模型检测

这里由于上面受显卡限制,不再详细写过程,可参考原视频:

基于Flask的模型部署 http:// https://www.bilibili.com/video/BV1Mk4y1i7v1/?share_source=copy_web&vd_source=8f7729bb666414c7bb823ad003dc6e38

http:// https://www.bilibili.com/video/BV1Mk4y1i7v1/?share_source=copy_web&vd_source=8f7729bb666414c7bb823ad003dc6e38

往期精彩

STM32专栏(9.9)![]() http://t.csdnimg.cn/A3BJ2

http://t.csdnimg.cn/A3BJ2

OpenCV-Python专栏(9.9)![]() http://t.csdnimg.cn/jFJWe

http://t.csdnimg.cn/jFJWe

AI底层逻辑专栏(9.9)![]() http://t.csdnimg.cn/6BVhM

http://t.csdnimg.cn/6BVhM

机器学习专栏(免费)![]() http://t.csdnimg.cn/ALlLlSimulink专栏(免费)

http://t.csdnimg.cn/ALlLlSimulink专栏(免费)![]() http://t.csdnimg.cn/csDO4电机控制专栏(免费)

http://t.csdnimg.cn/csDO4电机控制专栏(免费)![]() http://t.csdnimg.cn/FNWM7

http://t.csdnimg.cn/FNWM7