英伟达 DGX 云:

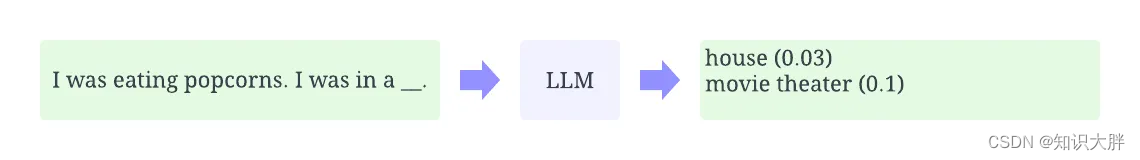

Nvidia DGX Cloud——上周,我们从彭博社获悉——微软斥资数亿美元购买了数万个 Nvidia A100 图形芯片,以便合作伙伴 OpenAI 可以训练Bing 的 AI 聊天机器人和 ChatGPT背后的大型语言模型 (LLM) .

无法为您自己的 LLM 项目获得所有硬件的所有资金或空间?Nvidia 的 DGX Cloud试图出售对同一事物的远程网络访问。

Nvidia GPU技术大会:

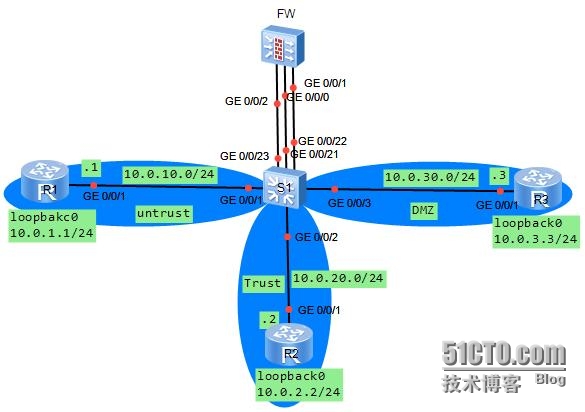

今天在该公司的 2023 年 GPU 技术大会上宣布,该服务租用其 DGX 服务器盒的虚拟版本,每个版本包含八个 Nvidia H100 或 A100 GPU 和 640GB 内存。该服务包括可扩展到 32,000 个 GPU 附近的互连、存储、软件,以及“直接访问优化代码的 Nvidia AI 专家”,A100 层的起价为每月 36,999 美元。

想知道 Nvidia 向 Microsoft 支付了多少费用才能将其硬件租给您。

同时,如果您直接购买相同的硬件,物理 DGX 服务器盒的成本可能高达 200,000 美元,这还不包括微软等公司所说的围绕该技术构建工作数据中心的努力。

您借用的某些 GPU 甚至有可能正是微软用来帮助训练 OpenAI 模型的 GPU——Microsoft Azure 是将托管 DGX Cloud 的组织之一。然而,N