AI入门

故事

- 图灵测试

测试者和被测试者(人和机器) 隔开,通过一些装置互相随意提问,如果(5min内)超过30%的测试者不能确定是人还是机器,那么这台机器就认为具有人类智能。

- 达特茅斯会议-人工智能的起点

1956-8, 美国汉诺斯-达特茅斯学院,初次定义的会议名称-人工智能,这一年也称为人工智能元年

80年代正式形成期,无影响力

90年代-2010年 蓬勃发展期

2012年后深度学习期

2022年chatGPT

机器学习是人工智能的实现路径,深度学习是机器学习的一个方法发展而来

通讯,感知,行动是现代人工智能的三个关键能力,而这三个技能对应三种技术:计算机视觉(CV) 自然语言处理(NLP)和机器人,

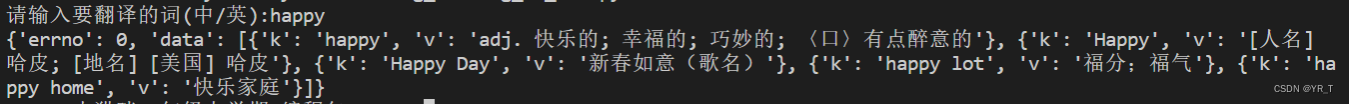

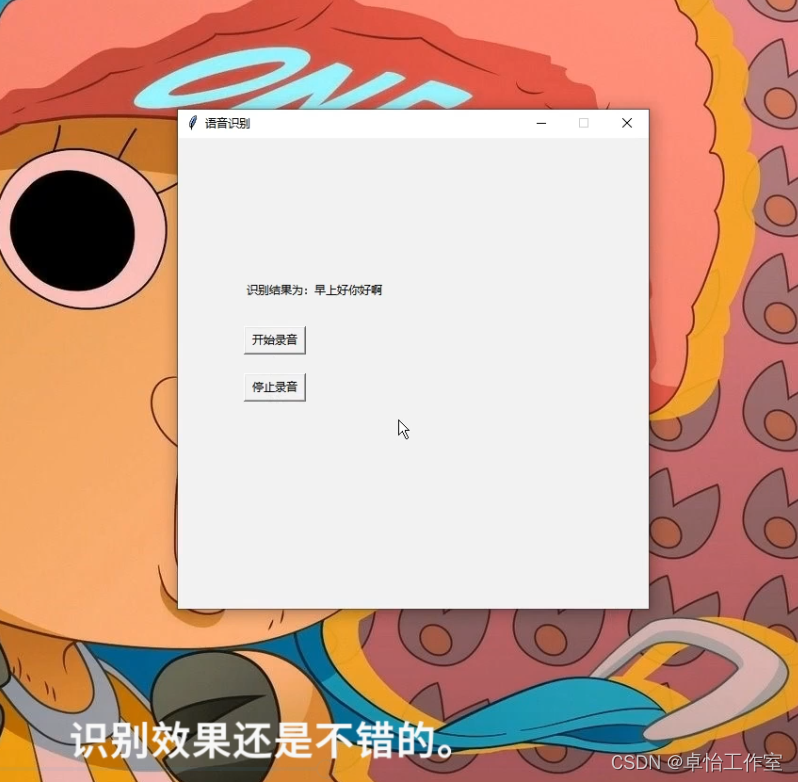

在NLP领域中,将覆盖文本挖掘,机器翻译和语音识别。

故事: 鸡尾酒会效应(语音识别)

人可以屏蔽,但是机器不行

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ukQh9xdk-1681036462671)(/Users/haoranzhang/Library/Application Support/typora-user-images/image-20230409153508837.png)]

一、入门了解篇

机器学习五步走

- 获取数据

- 数据基本处理

- 特征工程

- 机器学习(模型训练)

- 模型评估

- 我们习惯一行数据称为一个样本,一列数据称为一个特征。

- 有些数据有目标值,有些数据则没有

有目标值的推倒: 例如根据以往多年的房屋价格变动预测来年的房屋价格

无目标值的推倒: 给出一组图片,说让给予分类,但是图片样本中的人物,有戴帽子的和没戴的,有拿着工具的也有没有拿着的,还有穿衣服的和没穿的等等,不包括服装颜色,进而更复杂的可能还有面部表情等等,而没有具体目标。

1.数据集的专有名词

- 样本

- 特征

- 目标值

- 特征值

2.数据类型构成

- 类型一: 特征值+目标值(目标值为离散还是连续)

- 类型二: 只有特征值,没有目标值

3.数据分割

- 机器学习一般分成两个部分

- 训练数据: 用于训练和模型构建

- 测试数据: 在模型检验的时候,用于模型评估

- 划分比例

- 训练集 70/ 80/ 75/

- 测试集: 30/ 20/ 25/

4.数据处理

- 剔除异常值,转换异常值等等

机器学习中的数据处理场景和手段非常多样化,下面举几个例子:

- 数据清洗:数据清洗是指处理原始数据中的噪声、缺失值、异常值、重复值等问题,以提高数据的质量和可用性。常见的数据清洗手段包括删除缺失值、插补缺失值、平滑数据、去除离群值等。

- 数据集划分:在进行机器学习任务时,需要将原始数据集划分成训练集、验证集和测试集。训练集用于训练模型,验证集用于调整模型超参数和评估模型性能,测试集用于评估模型的泛化能力。常见的数据集划分方法包括随机划分、分层划分等。

- 特征工程:特征工程是将原始数据转化为可供模型使用的特征的过程。它是机器学习任务中非常重要的一环,能够显著影响模型的性能和准确度。常见的特征工程手段包括特征提取、特征选择、特征转换、特征降维等。

- 数据归一化:数据归一化是将不同尺度的数据转换为同一尺度的数据,以提高模型的性能和收敛速度。常见的数据归一化手段包括最大-最小归一化、Z-Score归一化等。

- 数据增强:数据增强是指通过对原始数据进行变换和扩充,增加数据集的大小和多样性,从而提高模型的泛化能力和鲁棒性。常见的数据增强手段包括旋转、平移、缩放、镜像等。

总之,机器学习中的数据处理场景和手段非常多样化,可以根据具体任务需求选择相应的处理手段。常见的数据处理手段包括数据清洗、数据集划分、特征工程、数据归一化、数据增强等。

5.特征工程

特征工程是指将原始数据转换成适合机器学习模型的特征的过程。它是机器学习模型中非常重要的一环,决定了模型的性能和准确度。特征工程的目的是将原始数据中的有用信息提取出来,并将其表示为一组有意义的特征,以便机器学习算法能够对其进行学习和预测。以下是特征工程的一些常见步骤:

- 数据清洗:在进行特征工程之前,需要对原始数据进行清洗,包括处理缺失值、异常值和重复值等。

- 特征提取:特征提取是将原始数据转换成可供模型使用的特征的过程。这可以通过数学方法、统计分析或数据挖掘算法来实现。例如,可以使用PCA等方法对数据进行降维,或者使用文本分析技术提取关键词等。

- 特征选择:特征选择是从提取的特征中选择最有用的特征的过程。这可以通过统计方法或机器学习算法来实现。例如,可以使用相关性分析、方差分析等方法来选择最相关的特征,或者使用正则化方法来减少过拟合。

- 特征转换:特征转换是将特征转换成模型可以处理的形式的过程。这可以通过标准化、归一化或离散化等方法来实现。例如,可以将数据缩放到相同的范围内,或将连续变量转换为离散变量。

总之,特征工程是将原始数据转换为适合机器学习算法的特征的过程。特征工程的目的是提高模型的性能和准确度,需要经过多个步骤的处理,包括数据清洗、特征提取、特征选择和特征转换等。

使用专业知识和技巧处理知识成为机器更容易识别的数据,使得特征可以在机器学习发挥更好的作用。

意义 : 会直接影响机器学习的效果

数据和特征决定了机器学习的上限,而模型和算法只是逼近这个上限而已。

1. 提取特征

将任意数据转化为可以用于机器学习的数字特征

比如: 你好---->. 00000010. 00000020

2.特征预处理

特征预处理是机器学习中的一个重要步骤,它的主要作用是对原始数据进行处理和转换,以便于算法更好地处理和理解数据。具体来说,特征预处理包括以下几个方面:

- 数据清洗:数据清洗是指对原始数据中的错误、不完整或重复的数据进行处理和清理。例如,去除空值或缺失值,去除异常值等。

- 特征选择:特征选择是指从原始数据中选择最相关的特征,以便于机器学习算法更好地理解数据。例如,根据统计分析或领域知识选择最相关的特征。

- 特征变换:特征变换是指对原始数据进行数学变换,以便于机器学习算法更好地处理数据。例如,对数据进行归一化、标准化、对数变换等。

- 特征降维:特征降维是指将高维数据转换为低维数据,以便于机器学习算法更好地处理数据。例如,使用主成分分析(PCA)将数据降到低维空间。

举例来说,对于一个房价预测的问题,原始数据可能包含了房屋的面积、卧室数量、距离市中心的距离等多个特征。在特征预处理中,可以进行数据清洗,去除异常值或空值;特征选择,选择与房价相关的特征;特征变换,对数据进行归一化或对数变换等;特征降维,使用PCA将数据降到二维或三维空间中。这些处理都可以提高机器学习算法的准确性和效率。

3. 特征降维

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-xBA1tP0r-1681036462672)(/Users/haoranzhang/Library/Application Support/typora-user-images/image-20230409161857418.png)]

如图: ----

机器学习

机器学习依赖于多种因素,包括算力、算法、数据质量和模型选择等。具体来说,以下是机器学习所依赖的主要因素:

- 算力:机器学习需要大量的计算资源来处理和分析数据。随着数据量和模型复杂度的增加,算力对机器学习的重要性越来越大。算力的提升可以通过增加硬件资源(如GPU)或使用云计算服务来实现。

- 算法:机器学习算法是机器学习的核心,决定了模型的性能和准确度。不同的机器学习算法适用于不同的数据类型和应用场景。例如,决策树、支持向量机、神经网络等。算法的选择需要考虑到数据类型、数据量、模型复杂度等多个因素。

- 数据质量:机器学习模型的性能和准确度直接取决于数据的质量和可靠性。因此,数据清洗、特征工程和数据预处理等步骤非常重要。同时,数据量的大小也会影响机器学习的性能和准确度。

- 模型选择:机器学习需要选择适合问题和数据类型的模型。不同的模型具有不同的优缺点和应用场景。例如,线性回归、逻辑回归、卷积神经网络等。模型选择需要考虑到算法的适用性、模型的复杂度、训练和推理的时间成本等多个因素。

总之,机器学习依赖于算力、算法、数据质量和模型选择等多个因素。这些因素的协同作用可以提高机器学习的性能和准确度。

模型评估

- 关注的指标

- 准确率: 正确预测占全部样本的比例

- 精确率:正确预测为正的占正样本的比例

- 召回率: 正确预测为正的占全部正样本的比列

- F1-score: 评估模型的稳健性

- AUC指标:评估样本不均衡的情况

- 回归模型评估

- 均方根误差: RMSE

- 真实值和预测值的差的平方,然后所有样本求和 然后和样本相除,开根号得到的结果

-

- 真实值和预测值的差的平方,然后所有样本求和 然后和样本相除,开根号得到的结果

- 相对方误差RSE

- 实际值和真实值的差的平方,然后所有样本求和 实际值和实际平均值的差的平方,所有样本的和。 二者相比得到的结果

-

- 绝对误差MAE

-

- 决定系数

-

- 均方根误差: RMSE

拟合

欠拟合

过拟合

在机器学习中,模型的目标是通过学习样本数据中的模式和规律,从而对新的数据进行预测或分类。为了评估模型的拟合能力和泛化能力,通常需要定义一些拟合标准(也称为损失函数或评价指标),用来衡量模型预测结果和真实值之间的差距。

下面是一些常见的拟合标准:

- 均方误差(Mean Squared Error, MSE):均方误差是回归问题中最常用的拟合标准之一。它衡量模型预测结果与真实值之间的平方误差,然后取平均值。MSE值越小,模型的拟合能力越好。

- 交叉熵损失(Cross Entropy Loss):交叉熵损失是分类问题中常用的拟合标准之一。它衡量模型对样本的分类准确程度,越接近真实分类标签,损失值越小。交叉熵损失适用于二分类和多分类问题。

- 对数似然损失(Logarithmic Loss):对数似然损失也是分类问题中常用的拟合标准之一。它衡量模型在给定样本下预测每个类别的概率分布与真实的概率分布之间的距离。对数似然损失越小,模型的拟合能力越好。

- 准确率(Accuracy):准确率是分类问题中最简单的评价指标之一,它衡量模型预测正确的样本数占总样本数的比例。准确率越高,模型的拟合能力越好。

- F1-Score:F1-Score是分类问题中常用的综合评价指标,它结合了精确率和召回率。F1-Score越高,说明模型在预测正例和负例时都表现良好。

学习目标

-

监督学习

如果数据是离散的就是分类

如果数据是连续的就是回归

- 目的: 预测

- 分类: k-近邻算法、 贝叶斯算法、决策树、随机森林、逻辑回归、神经网络

- 回归: 线性回归,岭回归

-

无监督学习

- 目的: 发现潜在结构

- 聚类:k-means,降维

- 无标签无反馈

-

半监督学习

- 一些数据有目标值,一些数据没有目标值

-

强化学习

- 目的: 长期利益最大化,回报函数

- 算法: 马尔可夫决策,动态规划

有监督和无监督的对比

监督学习 : (分类/回归) 输入有特征,有标签的数据,既有标准答案

无监督学习: (聚类) 输入有特征,有标签的数据,既无标准答案

Azure:机器学习平台

深度学习(了解篇:TODO)

神经网络发展而来,比较有代表的是卷积神经网络

伸手去摸杯子,很快就会反馈,烫不烫,然后逃离判定等

层数: 器官层,分子层,原子层

节点数: