文章中文化系列目录

文章目录

- 文章中文化系列目录

- 摘要

- CCS概念:

- 关键词:

- 1 引言

- 2 相关工作

- 2.1 多模态预训练

- 2.2 知识图谱增强的预训练模型

- 3 方法

- 3.1 模态编码层

- 3.1.1 图像初始特征

- 3.1.2 文本初始特征

- 3.1.3 知识的表面形式特征

- 3.2 模态交互层

- 3.2.1 图像模态和文本模态之间的交互

- 3.2.2 知识模态与其他两个模态的交互

- 3.3 模态任务层

- 3.3.1 掩码语言建模(MLM)

- 3.3.2 掩码对象建模(MOM)

- 3.3.3 链接预测建模(LPM)

- 4 实验

- 4.1 预训练(Pretraining)

- 4.1.1数据集。

- 2、

- 3、

- 5 结论和今后的工作

摘要

本文研究了电子商务领域中产品数据的多模态预训练问题.针对图像和文本模态的多模态预训练方法在面对模态缺失和模态噪声这两真实的电子商务场景中多模态产品数据普遍存在的问题时缺乏鲁棒性。为此,本文提出了一种在多模态预训练中引入知识模态的K3M方法,以修正图像和文本模态中的噪声和缺失。该方法具有良好的鲁棒性和鲁棒性。模态编码层提取每个模态的特征。模型交互层能够有效地对多模态的交互进行建模,其中设计了初始交互特征融合模型以保持图像模态和文本模态的独立性,并设计了结构聚合模块以融合图像、文本和知识模态的信息。我们使用三个预训练任务对K3M进行预训练,包括屏蔽对象建模(MOM)、屏蔽语言建模(MLM)和链接预测建模(LPM)。在一个真实的电子商务数据集和一系列基于产品的下游任务上的实验结果表明,当存在模态噪声或模态缺失时,K3M的性能比基线和现有方法有显著的提高.

CCS概念:

计算方法→信息提取;语义网络。

关键词:

知识图,多模态预训练,模态缺失,模态噪声

1 引言

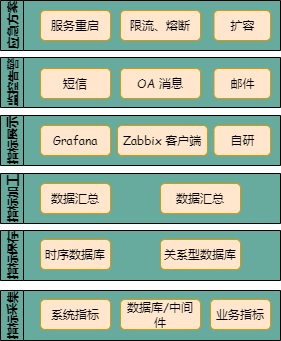

电子商务的兴起极大地便利了人们的生活。在电子商务场景中,存在大量基于商品的应用任务,例如商品分类 [1,2]、商品对齐 [3]、推荐系统 [2,4,5] 等。如图1所示,通常商品会包含图片、标题和结构化的知识,这是一个典型的多模态场景。

近年来,多模态预训练受到了广泛关注 [6–15],这些方法致力于挖掘图像(或视频)模态和文本模态信息之间的关联。考虑到广泛的下游电子商务应用,我们专注于商品多模态数据的预训练。然而,直接将这些多模态预训练方法应用于电子商务场景会导致问题,因为模态丢失和模态噪声是电子商务场景中的两个挑战,这将严重降低多模态信息学习的性能 [16]。在实际的电子商务场景中,一些卖家没有上传商品图片(或标题)到平台,一些卖家提供的商品图片(或标题)主题不明确或语义不准确,使得信息特别令人困惑。图1中的Item-2和Item-3分别展示了我们场景中的模态噪声和模态丢失示例。

为了解决这个问题,我们引入了产品知识图谱(PKG) [17],并将其视为一种新模态,称为知识模态。如图1所示,PKG以三元组形式表示,例如<Item-1, Material, Cotton>表示Item-1的材质是棉花。我们引入PKG主要有两个原因:(1) PKG具有高质量。PKG描述了商品的客观属性,结构化且易于管理,通常会进行维护和标准化工作,因此PKG相对干净且可信。(2) PKG与其他模态的信息存在重叠。以图1中的Item-1为例,一方面,图片、标题和PKG都说明Item-1是一件长袖T恤。另一方面,PKG显示这件长袖T恤不仅适合秋季,也适合春季,这在图片或标题中是无法得知的。因此,当存在模态噪声或模态丢失时,PKG可以对其他模态进行纠正或补充。因此,针对商品数据的预训练,我们考虑了三种模态的信息:图像模态(商品图片)、文本模态(商品标题)和知识模态(PKG)。

本文中,我们提出了一种新颖的电子商务应用中的知识感知多模态预训练方法,称为K3M。具体来说,K3M通过两个步骤学习商品的多模态信息:(1) 编码每个模态的单独信息,(2) 建模模态之间的交互。在编码每个模态的单独信息时,对于图像模态,使用基于Transformer的图像编码器提取图像的初始特征;对于文本模态,使用基于Transformer的文本编码器提取文本的初始特征;对于知识模态,使用相同的文本编码器提取PKG中的关系和尾实体的表面形式特征。

在建模模态之间的交互时,有两个过程。第一个过程是文本模态和图像模态之间的交互,类似于之前的工作 [12];第二个过程是知识模态与其他两个模态之间的交互。在第一个过程中,基于图像和文本模态的初始特征,通过共注意力Transformer学习交互特征。为了保持单个模态的独立性,我们设计了一个初始-交互特征融合模块,将图像和文本模态的初始特征与其交互特征融合。在第二个过程中,图像和文本模态的交互结果用于初始化目标商品实体的表示,该实体是PKG中三元组的头实体,关系和尾实体的表面形式特征则作为它们的初始表示。然后,通过结构聚合模块,将实体和关系的信息传播和聚合到目标商品实体上。最后,知识引导的商品实体表示可以用于各种下游任务。

针对图像模态、文本模态和知识模态的预训练任务分别是掩码对象建模(MOM)、掩码语言建模(MLM)和链接预测建模(LPM)。

在多个下游任务上的实验结果表明,我们的K3M在实体建模中比现有的多模态预训练方法更具鲁棒性。我们的主要贡献如下:

- 我们将PKG的结构化知识引入电子商务中的多模态预训练,能够在大规模多模态数据集中纠正或减弱模态噪声和模态丢失问题。

- 我们提出了一种新颖的多模态预训练方法K3M。在K3M中,我们将图像和文本模态的初始特征与其交互特征融合,以进一步提高模型性能。

- 在真实世界的电子商务数据集上进行的实验显示了K3M在多个下游任务中的强大能力。我们的代码和数据集可以在https://github.com/YushanZhu/K3M获取。

图1:产品的多模态数据示例。每个项目都有一个标题、一个图像和一个PKG,PKG通过三元组(<item,property,value>)描述产品的客观属性。

2 相关工作

2.1 多模态预训练

预训练技术在计算机视觉 (CV) 领域的成功应用,如VGG [18]、Google Inception [19] 和ResNet [20],以及在自然语言处理 (NLP) 领域的成功应用,如BERT [21]、XLNet [22] 和GPT-3 [23],激发了多模态预训练的发展。最近,提出了一系列多模态预训练方法,这些方法致力于不同模态信息之间的互补。

VideoBERT [6] 是第一个提出多模态预训练的工作,该方法通过BERT训练了大量未标注的视频-文本对。目前,用于图像和文本的多模态预训练模型主要有两种架构。B2T2 [15]、VisualBERT [7]、Unicoder-VL [8]、VL-BERT [9] 和UNITER [24] 提出了单流架构,在该架构中,单个Transformer同时应用于图像和文本。另一方面,LXMERT [10]、ViLBERT [12] 和FashionBERT [11] 引入了双流架构,其中图像和文本的特征首先独立提取,然后使用更复杂的机制(共注意力)来完成它们的交互。为了进一步提升性能,VLP [14] 对编码和解码使用了共享的多层Transformer,用于图像字幕生成和视觉问答 (VQA)。基于单流架构,InterBERT [13] 在单流模型的输出上添加了两个独立的Transformer流,以捕捉模态的独立性。这些多模态预训练方法无法解决模态丢失和模态噪声的问题。与之前的工作相比,K3M有几个显著的不同。我们提出的模型架构能够有效利用结构化知识来提高模型对模态丢失和模态噪声的鲁棒性。此外,我们提出将模态的初始特征和交互特征进行融合,以保持文本和图像模态的独立性,从而使模型更有效。

2.2 知识图谱增强的预训练模型

最近,越来越多的研究人员开始关注知识图谱 (KG) 和预训练语言模型 (PLM) 的结合,以提升PLM的性能。

K-BERT [25] 将三元组注入句子中,以生成统一的富含知识的语言表示。ERNIE [26] 将来自知识模块的实体表示集成到语义模块中,以在统一的特征空间中表示token和实体的异构信息。KEPLER [27] 将实体的文本描述编码为文本嵌入,并将描述嵌入视为实体嵌入。KnowBert [28] 使用集成的实体链接器通过一种单词到实体的注意力机制生成知识增强的实体跨度表示。K-Adapter [29] 通过神经适配器分别注入事实知识和语言知识到RoBERTa中,以增强其性能。DKPLM [30] 可以根据文本上下文动态选择和嵌入知识,既考虑全局知识也考虑局部知识图谱信息。JAKET [31] 提出了一个联合预训练框架,包括一个知识模块,生成实体的嵌入以生成图中上下文感知的嵌入。此外,KALM [32]、ProQA [33]、LIBERT [34] 等研究人员还在不同的应用任务中探索了知识图谱与PLM的融合实验。

然而,当前增强知识图谱的预训练模型仅针对单一模态,尤其是文本模态。据我们所知,这是首次将知识图谱结合到多模态预训练中的工作。

3 方法

在本节中,我们将描述K3M如何联合建模文本、图像和知识模态的信息。给定一组商品数据 D = { C , I , T , K } D = \{C,I,T,K\} D={C,I,T,K},其中 C C C 是一组商品, I I I 是一组商品图片, T T T 是一组商品标题, K = { E , R , T R } K = \{E,R,TR\} K={E,R,TR} 是PKG,其中 E E E、 R R R 和 T R TR TR 分别是实体、关系和三元组的集合, T R = { ⟨ h , r , t ⟩ ∣ h ∈ E , r ∈ R , t ∈ E } TR = \{\langle h, r, t \rangle | h \in E, r \in R, t \in E \} TR={⟨h,r,t⟩∣h∈E,r∈R,t∈E}。对于每个商品 e c ∈ C e_c \in C ec∈C,它有一个商品图片 i c ∈ I i_c \in I ic∈I,一个商品标题 t c ∈ T t_c \in T tc∈T,以及与其相关的一组来自PKG的三元组,即 T R c = { ⟨ e c , p r o p e r t y , v a l u e ⟩ ∣ e c ∈ E , p r o p e r t y ∈ R , v a l u e ∈ E } ⊂ T R TR_c = \{\langle e_c, property, value \rangle | e_c \in E, property \in R, value \in E \} \subset TR TRc={⟨ec,property,value⟩∣ec∈E,property∈R,value∈E}⊂TR。我们的目标是学习一个模型 M ( i c , t c , T R c ) M(i_c, t_c, TR_c) M(ic,tc,TRc),以学习商品 e c ∈ C e_c \in C ec∈C 的跨模态表示,记为 c ∗ c^* c∗。

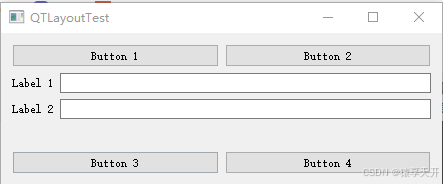

我们的模型由三层组成,如图2所示。第一层称为模态编码层,旨在分别编码每个模态的单独信息。第二层称为模态交互层,旨在建模不同模态之间的交互。第三层是模态任务层,其中为不同模态设定了不同的预训练任务。我们首先描述如何在模态编码层中编码图像初始特征、文本初始特征以及知识的表面形式特征。然后展示模态交互层中两个交互过程的建模方法。最后描述模态任务层中的三个预训练任务。

图2:K3M的模型框架。

3.1 模态编码层

3.1.1 图像初始特征

参考[7,9,10,12,13],我们将给定商品 e c e_c ec 的商品图片 i c i_c ic (像素矩阵)通过对象检测模型转换为对象序列。具体来说,参考ViLBERT [12],我们使用Faster R-CNN [35] 从 i c i_c ic 中检测出一系列对象(RoI,感兴趣区域),并将这些对象的边界框作为它们的位置信息。15%的对象随机掩码,如[12]所述。然后如图2所示,对象嵌入和位置嵌入的总和 [ E i 1 , E i 2 , . . . , E i M 1 ] [E_{i1}, E_{i2}, ..., E_{iM1}] [Ei1,Ei2,...,EiM1] 被输入到基于Transformer的图像编码器中,图像编码器输出图像的初始特征 [ h i 1 0 , h i 2 0 , . . . , h i M 1 0 ] [h_{i1}^0, h_{i2}^0, ..., h_{iM1}^0] [hi10,hi20,...,hiM10],其中 M 1 M_1 M1 是对象序列的最大长度。

3.1.2 文本初始特征

参考BERT [21],商品 e c e_c ec 的标题 t c t_c tc 首先通过WordPieces [36] 被分词为一个token序列,15%的token被随机掩码。然后如图2所示,token嵌入和位置嵌入的总和 [ E t 1 , E t 2 , . . . , E t M 2 ] [E_{t1}, E_{t2}, ..., E_{tM2}] [Et1,Et2,...,EtM2] 被输入到基于Transformer的文本编码器中,文本编码器输出文本初始特征 [ h t 1 0 , h t 2 0 , . . . , h t M 2 0 ] [h_{t1}^0, h_{t2}^0, ..., h_{tM2}^0] [ht10,ht20,...,htM20],其中 M 2 M_2 M2 是token序列的最大长度。

3.1.3 知识的表面形式特征

在此步骤中,我们获取三元组 ⟨ e c , p r o p e r t y x , v a l u e x ⟩ \langle e_c, property_x, value_x \rangle ⟨ec,propertyx,valuex⟩ 中关系和尾实体的表面形式特征,其中 x = 1 , . . . , X c x = 1, ..., X_c x=1,...,Xc, X c X_c Xc 是 T R c TR_c TRc 中三元组的数量。我们不考虑头实体,因为它的表面形式没有语义信息,如图1所示。为了充分利用上下文信息,我们首先将 T R c TR_c TRc 中所有三元组的关系和尾实体拼接成一段长知识文本,如“property1 value1 property2 value2 property3 …”(例如,图1中Item-1的知识文本是“material cotton way to dress pullover season …”),然后根据WordPieces将其分词成一个token序列。接着,使用与3.1.2节中提取文本初始特征的相同文本编码器对知识文本的token序列进行编码。如图2所示,文本编码器输出 [ h k 1 0 , h k 2 0 , . . . , h k M 3 0 ] [h_{k1}^0, h_{k2}^0, ..., h_{kM3}^0] [hk10,hk20,...,hkM30],基于输入嵌入 [ E k 1 , E k 2 , . . . , E k M 3 ] [E_{k1}, E_{k2}, ..., E_{kM3}] [Ek1,Ek2,...,EkM3],其中 M 3 M_3 M3 是知识文本的最大token序列长度。最后,我们计算每个关系和尾实体的表面形式特征,作为其对应token最后隐藏层状态的均值池化值(一个关系或尾实体可能被分割为多个token,如图2所示),记为 p x p_x px 和 v x v_x vx,其中 x = 1 , . . . , X c x = 1, ..., X_c x=1,...,Xc, X c X_c Xc 是 T R c TR_c TRc 中三元组的数量。

3.2 模态交互层

在这一层中,有两个过程来建模模态交互。第一个是图像模态和文本模态之间的交互,第二个是知识模态与其他两个模态之间的交互。我们将分别介绍这两个过程。

3.2.1 图像模态和文本模态之间的交互

首先,图像-文本交互器(Image-text Interactor)应用共注意力Transformer [12],将图像初始特征 [ h t 1 0 , h t 2 0 , . . . , h t M 1 0 ] [h_{t1}^0, h_{t2}^0, ..., h_{tM1}^0] [ht10,ht20,...,htM10] 和文本初始特征 [ h i 1 0 , h i 2 0 , . . . , h i M 2 0 ] [h_{i1}^0, h_{i2}^0, ..., h_{iM2}^0] [hi10,hi20,...,hiM20] 作为输入。具体来说,在共注意力Transformer中,每个模态的“key”和“value”传递到另一个模态的注意力块中,进行图像条件的文本注意力和文本条件的图像注意力。之后,图像-文本交互器生成图像的交互特征 [ h i 1 T , h i 2 T , . . . , h i M 1 T ] [h_{i1}^T, h_{i2}^T, ..., h_{iM1}^T] [hi1T,hi2T,...,hiM1T] 和文本的交互特征 [ h t 1 I , h t 2 I , . . . , h t M 2 I ] [h_{t1}^I, h_{t2}^I, ..., h_{tM2}^I] [ht1I,ht2I,...,htM2I]。

然而,通过共注意力Transformer学习模态交互特征时,忽略了单个模态的独立性 [13]。当某个模态存在噪声或丢失时,模态交互将对另一个模态产生负面影响,从而破坏模态的交互特征。因此,保持单个模态的独立性是必要的。为了解决这个问题,我们提出保留在模态编码层中学习到的图像初始特征和文本初始特征,并设计一个初始-交互特征融合模块(IFFM),将图像和文本模态的初始特征与它们的交互特征融合。IFFM将对象(或token)的初始特征和交互特征作为输入,并将这两个特征向量融合为一个输出向量,表示为: h t a = f u s i o n ( h t a 0 , h t a I ) , ( a = 1 , 2 , . . . , M 1 ) h_{ta} = fusion(h_{ta}^0, h_{ta}^I), (a = 1, 2, ..., M1) hta=fusion(hta0,htaI),(a=1,2,...,M1)

h i b = f u s i o n ( h i b 0 , h i b T ) , ( b = 1 , 2 , . . . , M 2 ) h_{ib} = fusion(h_{ib}^0, h_{ib}^T), (b = 1, 2, ..., M2) hib=fusion(hib0,hibT),(b=1,2,...,M2)

其中,函数 f u s i o n ( ⋅ ) fusion(\cdot) fusion(⋅) 是融合算法,K3M中有三种融合算法:(1) 均值:计算两个输入向量的均值,模型记为“K3M(mean)”。(2) 软采样(Soft-Sampling):[37]中提出的一种用于特征融合的高级采样方法,模型记为“K3M(soft-spl)”。(3) 硬采样(Hard-Sampling):[37]中提出的另一种用于特征融合的高级采样方法,模型记为“K3M(hard-spl)”。

3.2.2 知识模态与其他两个模态的交互

首先,图像和文本模态的交互结果用于初始化商品 e c e_c ec 的表示,该商品是 T R c TR_c TRc 中三元组的头实体。我们计算 e c e_c ec 的初始表示为IFFM所有输出的均值池化值: c = m e a n _ p o o l i n g ( h t 1 , . . . , h t M 1 , W 0 h i 1 , . . . , W 0 h i M 2 ) c = mean\_pooling(h_{t1}, ..., h_{tM1}, W0h_{i1}, ..., W0h_{iM2}) c=mean_pooling(ht1,...,htM1,W0hi1,...,W0hiM2)

其中, W 0 W0 W0 是一个线性变换矩阵,用于将所有向量转换为相同维度。因此,三元组 ⟨ e c , p r o p e r t y x , v a l u e x ⟩ \langle e_c, property_x, value_x \rangle ⟨ec,propertyx,valuex⟩( x = 1 , . . . , X c x = 1, ..., X_c x=1,...,Xc)的头实体、关系和尾实体的表示分别初始化为 c c c、 p x p_x px 和 v x v_x vx,其中 p x p_x px 和 v x v_x vx 是在模态编码层中学习到的关系和尾实体的表面特征。

受[38]中思想的启发,该思想改进了GAT [39],旨在捕捉任何给定实体的邻域中的实体和关系特征,我们设计了一个结构聚合模块,用于传播和聚合实体和关系的信息,从而融合图像、文本和知识模态的信息。具体来说,三元组 ⟨ e c , p r o p e r t y x , v a l u e x ⟩ \langle e_c, property_x, value_x \rangle ⟨ec,propertyx,valuex⟩ 的表示首先通过以下公式学习: t x = W 1 [ c ∣ ∣ p x ∣ ∣ v x ] t_x = W1[c || p_x || v_x] tx=W1[c∣∣px∣∣vx]

其中, W 1 W1 W1 是一个线性变换矩阵。然后,通过LeakyReLU非线性函数表示三元组的重要性:

b x = L e a k y R e L U ( W 2 t x ) b_x = LeakyReLU(W2t_x) bx=LeakyReLU(W2tx)

其中, W 2 W2 W2 是线性权重矩阵。每个三元组的注意力值通过Softmax计算得到:

a x = S o f t m a x ( b x ) = e x p ( b x ) ∑ i = 1 X c e x p ( b i ) a_x = Softmax(b_x) = \frac{exp(b_x)}{\sum_{i=1}^{X_c} exp(b_i)} ax=Softmax(bx)=∑i=1Xcexp(bi)exp(bx)

最后,商品 e c e_c ec 的最终表示通过其初始表示 c c c 和所有三元组在 T R c TR_c TRc 中按注意力值加权的表示之和得到:

c ∗ = W 3 c + σ ( 1 M h ∑ m = 1 M h ∑ x = 1 X c a m x t m x ) c^* = W3c + \sigma \left(\frac{1}{M_h}\sum_{m=1}^{M_h} \sum_{x=1}^{X_c} a_mx t_mx \right) c∗=W3c+σ(Mh1m=1∑Mhx=1∑Xcamxtmx)

其中, W 3 W3 W3 是权重矩阵, σ ( ⋅ ) \sigma(\cdot) σ(⋅) 是激活函数, M h M_h Mh 是注意力头的数量, X c X_c Xc 是 T R c TR_c TRc 中三元组的数量。

3.3 模态任务层

在这一层中,我们为三种模态设计了不同的预训练任务。分别是针对文本模态的掩码语言建模(MLM)、针对图像模态的掩码对象建模(MOM)和针对知识模态的链接预测建模(LPM)。

3.3.1 掩码语言建模(MLM)

此任务与BERT预训练中的MLM任务相同,目标是预测被掩码的token。训练时通过最小化交叉熵损失来优化模型:

l M L M = − E t c ∼ T l o g P ( t o k m ∣ t o k m ) l_{MLM} = -E_{tc \sim T}logP(tok_m | tok_m) lMLM=−Etc∼TlogP(tokm∣tokm)

其中, t o k m tok_m tokm 表示被掩码的token, t o k m tok_m tokm 表示已掩码的token序列。

3.3.2 掩码对象建模(MOM)

与MLM类似,MOM的目标是预测图像中被掩码对象的类别。训练通过最小化交叉熵损失来优化:

l M O M = − E i c ∼ I l o g P ( o b j m ∣ o b j m ) l_{MOM} = -E_{ic \sim I}logP(obj_m | obj_m) lMOM=−Eic∼IlogP(objm∣objm)

其中, o b j m obj_m objm 表示被掩码的对象, o b j m obj_m objm 表示已掩码的对象序列。

3.3.3 链接预测建模(LPM)

此任务的目标是评估给定三元组的可信度。参考基于翻译的KG嵌入方法TransE [40],该方法假设如果 ⟨ h , r , t ⟩ \langle h, r, t \rangle ⟨h,r,t⟩ 是一个真实的三元组,那么 h h h 的表示向量加上 r r r 的表示向量应等于 t t t 的表示向量。我们定义三元组 ⟨ e c , p r o p e r t y x , v a l u e x ⟩ \langle e_c, property_x, value_x \rangle ⟨ec,propertyx,valuex⟩ 的得分为:

S x c = ∣ ∣ c ∗ + p x − v x ∣ ∣ 1 , x = 1 , . . . , X c S_xc = ||c^* + p_x - v_x||_1, x = 1, ..., X_c Sxc=∣∣c∗+px−vx∣∣1,x=1,...,Xc

LPM的目标是使正确三元组的得分较低,而错误三元组的得分较高。训练通过最小化边缘损失进行优化:

l L P M = E T R c ∼ K 1 X c ∑ x = 1 X c m a x { S x c − S x c + γ , 0 } l_{LPM} = E_{TRc \sim K} \frac{1}{X_c} \sum_{x=1}^{X_c} max\{S_xc - S_xc + \gamma, 0\} lLPM=ETRc∼KXc1x=1∑Xcmax{Sxc−Sxc+γ,0}

其中, γ \gamma γ 是边界超参数, S x c S_xc Sxc 是正三元组 ⟨ e c , p r o p e r t y x , v a l u e x ⟩ \langle e_c, property_x, value_x \rangle ⟨ec,propertyx,valuex⟩ 的得分, S x c S_xc Sxc 是通过随机替换头实体 e c e_c ec 或尾实体 v a l u e x value_x valuex 生成的负三元组 ⟨ e c ′ , p r o p e r t y x , v a l u e x ⟩ \langle e'_c, property_x, value_x \rangle ⟨ec′,propertyx,valuex⟩ 或 ⟨ e c , p r o p e r t y x , v a l u e x ′ ⟩ \langle e_c, property_x, value'_x \rangle ⟨ec,propertyx,valuex′⟩ 的得分。

K3M的最终预训练损失是上述三个任务的损失之和:

L p r e = l M L M + l M O M + l L P M L_{pre} = l_{MLM} + l_{MOM} + l_{LPM} Lpre=lMLM+lMOM+lLPM

4 实验

4.1 预训练(Pretraining)

4.1.1数据集。

我们的K3M是在淘宝上的数百万件商品(40132418)上经过训练和验证的,每件商品都包含一个标题、一张图片和一组来自PKG的与之相关的三元组。预训练数据集的统计量见表1。

我们的K3M在训练和有效数据集上进行了预训练,我们在测试数据集上评估了预训练的K3M,测试数据集用作下游任务的微调数据集。

2、

3、

5 结论和今后的工作

本文将PKG的结构化知识引入到电子商务的多模态预训练中,提出了一种新的方法K3 M。该模型体系结构包括模态编码层,用于提取每个模态的特征,模态交互层,用于对多个模态的交互进行建模,以及模态任务层,包含不同模态的预训练任务。在模态交互层,设计了结构聚合模块,对PKG的实体节点和关系边信息进行传播和聚合;设计了初始交互特征融合模块,对图像和文本模态的初始特征和交互特征进行融合,进一步提高模型性能。在真实电子商务数据集上的实验表明了K3 M的强大能力。在未来的工作中,我们希望将K3 M应用于更多的下游任务,并在更一般的数据集上探索其性能。