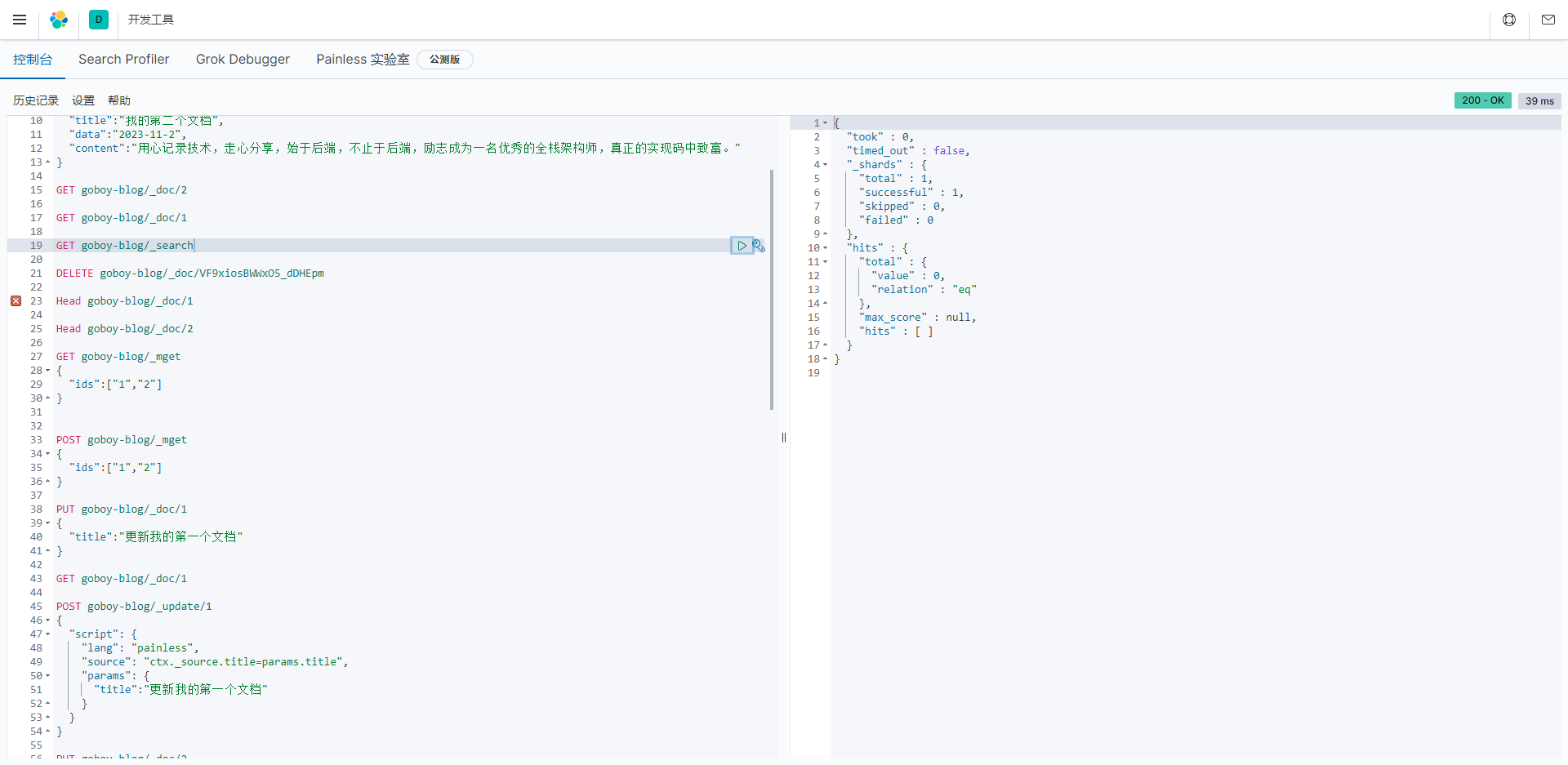

注:在此前提我已经准备好了环境 - 文章中大部分命令我都会有说明 进阶命令就需要友友们在研究了

miniconda 安装

gpu 显卡驱动安装

xinference使用命令什么的我就不放了官方文档中很简单易懂 xinference 官方文档地址

注:此文章不叙述docker版安装(docker安装很简单 配置一个好的docker镜像源 然后执行已下命令即可)

docker pull xprobe/xinference:latest

docker run -p 9997:9997 --gpus all xprobe/xinference:latest xinference-local -H 0.0.0.0

环境准备-显卡驱动

nvidia-smi

环境准备-conda

conda -V

创建conda的Xinference环境

# 使用conda创建一个 python3.10 的环境

conda create --name xinference python=3.10# 进入conda 环境

conda activate xinference安装指定 cupy, cudnn, cutensor, nccl 并指定 cuda 版本

cuda版本指定 根据显卡信息指定

conda install -c conda-forge cupy cudnn cutensor nccl cuda-version=12.4安装 Xinference

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple "xinference[all]"验证安装(true)

python -c "import torch; print(torch.cuda.is_available())"

问题记录

llama-cpp-python 构建失败

方案一:取消xinference的全部环境,只安装自己需要的

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple "xinference[all]"

将此命令中的 all 修改为 [transformers,vllm] 即可正常安装

方案二:使用如下命令尝试重新安装

#非conda环境执行

sudo apt-get update

sudo apt-get install python3-dev build-essential cmake libcudart-dev gcc g++ libgomp1

#进入conda 空间执行

conda activate xinference

conda install -c conda-forge libgomp

conda install -c conda-forge gxx_linux-64

conda install -c conda-forge openmp

conda install -c nvidia cudatoolkit=12.4 cuda-version=12.4CMAKE_ARGS="-DGGML_CUDA=on" pip install llama-cpp-python -U注:

sudo apt-get install python3-dev build-essential cmake libcudart-dev gcc g++ libgomp1

此命令有可能提示 libcudart-dev 不存在 那就去掉这个重新执行此命令的版本号注意和你的保持一致

conda install -c nvidia cudatoolkit=12.4 cuda-version=12.4

命令执行完 (我的系统版本是24.04(太高了)) 大概率还是会报错但是重新执行

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple "xinference[all]"

会使llama-cpp-python这个环境构建成功(不懂为什么) (后续我会出几个大模型部署文章,如果有机会我在出个这个问题的怎么解决的文章)