文章目录

- 吴恩达教你写提示词 ChatGPT prompt engineering

- 1. 关键提示(prompt)原则

- 1. 基础

- 2. 编写明确和具体的提示词

- 3. 给模型时间“思考”

- 4. 模型的限制

- 5. 迭代式提示(prompt)开发过程

- 2. 提示(prompt)一些功能

- 1. 总结(summarizing)

- 2. 推理(inferring)

- 3. 转换(transforming)

- 4. 扩展(expanding)

吴恩达教你写提示词 ChatGPT prompt engineering

1. 关键提示(prompt)原则

1. 基础

- 大数据模型(LLM)分为两类

- 基础大模型(Base LLM):基于大量文本训练数据来预测最可能出现的词,可看做”成语接龙“

- 调整型大模型(Instruction Tuned LLM):在基础大模型的基础上,使用人类反馈强化学习(RLHF)来微调、使模型更好的遵循指令

2. 编写明确和具体的提示词

- 明确不代表短,更长的提示实际上提供了更多的清晰度和上下文

- 使用分隔符清楚的隔离输入的不同部分

- ”“”

- ’‘’

- —

- :

- <>

- XML

- 要求结构化输出

- HTML、JSON 等

- HTML、JSON 等

- 要求模型检查是否满足条件

- 根据检测自然语言是否满足条件,比如将首先、其次、然后以及最后等自然语言转化为步骤

- 根据检测自然语言是否满足条件,比如将首先、其次、然后以及最后等自然语言转化为步骤

- 少量样本训练提示(Claude 不能很好的完成、换成 New Bing 。。。)

- 在 Prompt 中提供成功执行的示例,然后问新的问题、让 ChatGPT 提供对应的回答

- 在 Prompt 中提供成功执行的示例,然后问新的问题、让 ChatGPT 提供对应的回答

3. 给模型时间“思考”

- 如果你给模型太复杂的任务,在短时间或者少量词完成它,他可能猜测结果、这可能导致不正确。此时你可以指示模型多花时间解决

- 明确的指示模型做出推理之前推理出自己的解决方案,然后进行对比

4. 模型的限制

- 幻觉:当它尝试回答晦涩主题的问题时,可能会编造听起来合理但实际不正确的内容

- 一个可能得解决策略:要求模型找到相关的引用,然后基于引用回答问题

5. 迭代式提示(prompt)开发过程

- 想要完成任务的想法(Idea)

- 编写一个清晰、具体且让系统有足够时间的提示(Prompt)

- 运行它并查看结构,如果第一次效果不够好

- 通过找出为什么说明不清晰,或没有足够时间思考

- 重复上述过程

2. 提示(prompt)一些功能

1. 总结(summarizing)

-

可以总结评论、新闻等文案,生成简短的摘要

-

也可以根据实际需求,生成对应部分的摘要

2. 推理(inferring)

- 输入文本,执行某种分析任务,可能是:提取标签、提取名称、理解文本情感

3. 转换(transforming)

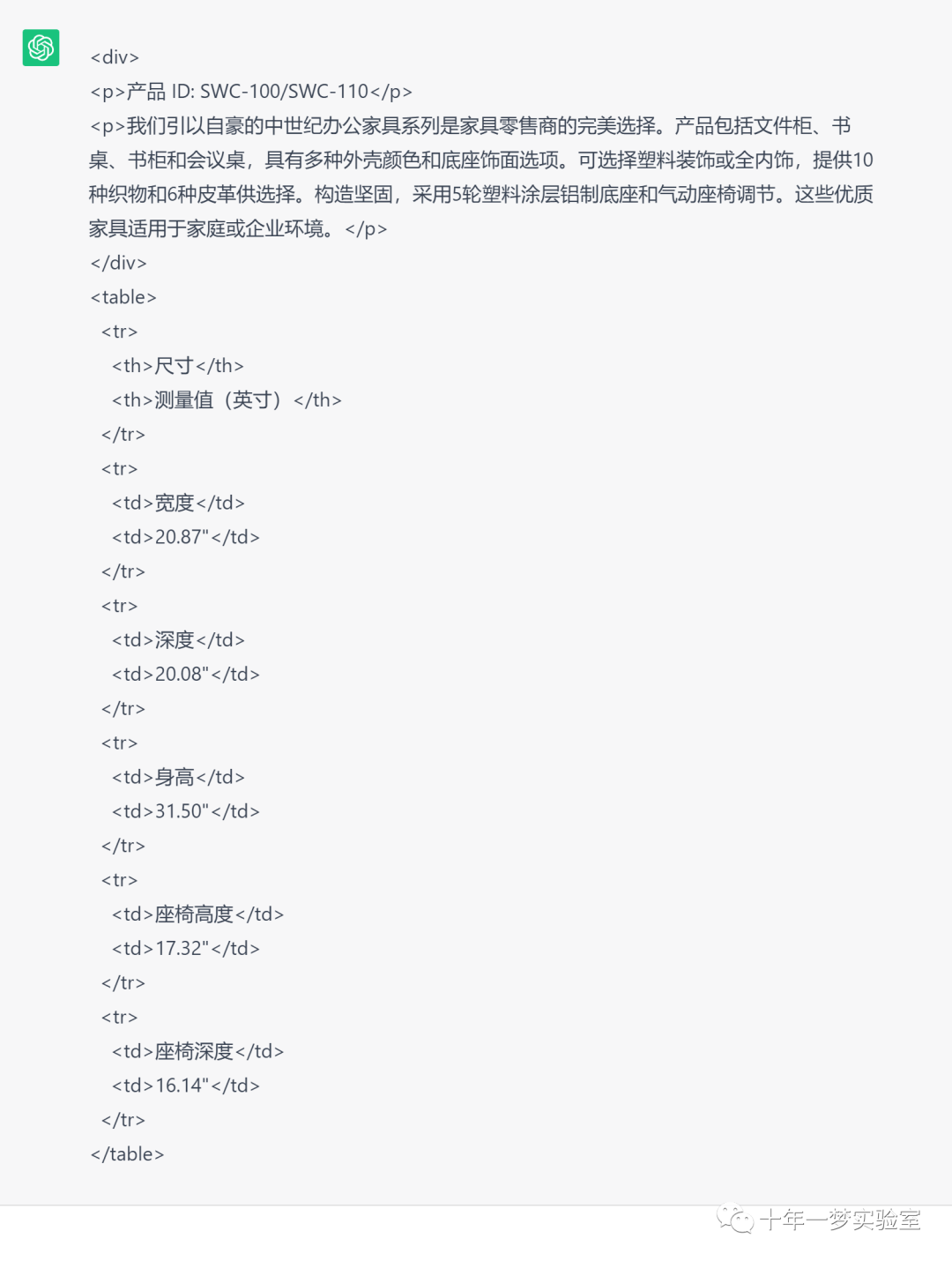

- 擅长讲输出转化为不同格式,比如从一种语言翻译成另一种语言,帮助拼写、语法纠正以及编写正则表达式

- Translate the following English text to Chinese:”“” “”“

- Proofread and correct the following text and rewrite the corrected version:”“” “”“

4. 扩展(expanding)

- 扩展是将短文本或主题列表转化为更长的文本,例如:电子邮件或某个主题的文章

- Temperature:被叫做“温度”的关键参数,可视为模型的探索程度或随机性

- 如果是 0 则趋向于同一个问题多次询问返回相同答案,大于 0 则趋向于同一个问题多次询问返回完全不同的答案

- 如果需要系统可靠与可预测,应该将其设置为 0

- 如果需要更有创意的方式输出,应该设置其大于 0

- Temperature:被叫做“温度”的关键参数,可视为模型的探索程度或随机性

参考:

ChatGPT提示工程师|AI大神吴恩达教你写提示词|prompt engineering