循环神经网络(Recurrent Neural Network, RNN)是一类用于处理序列数据的神经网络,擅长处理具有时间依赖或顺序结构的数据。RNN通过循环连接的结构,使得当前时刻的输出可以受之前时刻信息的影响,因此被广泛应用于自然语言处理、时间序列分析等领域。下面将详细介绍RNN的结构、工作原理、优势与不足、改进和应用场景。

一、RNN的基本结构

RNN的核心特点在于它的循环结构。与传统神经网络不同,RNN在每个时刻的隐状态(hidden state)中保留了之前时刻的信息,因此在输入序列的每一个位置,RNN都能利用之前的输入信息进行更新。

1. 基本组成

RNN的每个时间步都包含以下几个组成部分:

- 输入层(Input Layer):输入序列数据的每一个元素。对于文本来说,每个元素可以是一个词、字符或其他特征表示。

- 隐藏层(Hidden Layer):隐藏层的神经元能够保存来自前一个时间步的信息,并与当前输入共同决定当前的输出。隐藏层状态通常通过递归公式来更新。

- 输出层(Output Layer):根据隐藏状态生成输出。对于分类问题,输出通常是类别的概率分布;对于回归问题,输出是预测值。

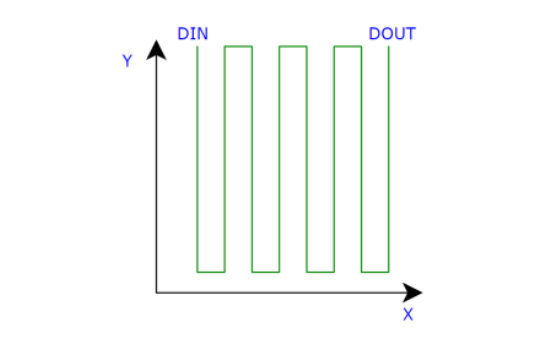

2. 信息传递机制

二、RNN的工作原理

RNN的运算是按时间步进行的。假设我们有一个长度为 ( T ) 的输入序列 ( (x_1, x_2, \dots, x_T) ),RNN的运算步骤如下:

- 输入:将序列的第一个元素 ( x_1 ) 输入RNN。

- 递归计算:在每个时间步,根据当前输入 ( x_t ) 和前一个隐藏状态 ( h_{t-1} ) 计算当前隐藏状态 ( h_t )。

- 输出:在每个时间步根据隐藏状态生成输出(或在序列结束时输出)。

- 状态传递:隐藏状态不断传递,直到序列结束。

由于RNN的这种循环机制,信息在时间步之间流动,使得模型能够捕捉序列中的依赖关系。

三、RNN的优势

- 捕捉序列依赖性:RNN可以处理任意长度的输入序列,擅长学习序列中的依赖关系和上下文信息。

- 参数共享:不同时间步使用相同的参数,这种参数共享使得模型更高效,并减少了参数量。

- 适合序列数据:在自然语言处理、语音识别、时间序列预测等任务中,RNN比传统神经网络更适合。

四、RNN的不足

- 梯度消失和梯度爆炸:在长序列中,随着时间步的增加,梯度会变得非常小(梯度消失)或非常大(梯度爆炸),导致训练困难,模型难以记住较远的上下文信息。

- 计算效率低:由于每个时间步都依赖上一个时间步的输出,因此无法并行化,导致训练速度较慢。

- 长期依赖问题:传统RNN只能处理短期依赖关系,而在长序列上效果不佳。

五、RNN的改进模型

为了克服RNN的不足,出现了多种改进模型,其中最常见的是长短期记忆网络(LSTM)和门控循环单元(GRU)。

- 简单循环神经网络:是最基本的 RNN 形式,结构相对简单,对于短序列数据的处理效果较好,但在处理长序列数据时容易出现梯度消失或梯度爆炸的问题,导致无法有效地学习长期依赖关系。

- 长短期记忆网络(LSTM):为了解决简单 RNN 的长期依赖问题,LSTM 被提出。LSTM 引入了门控机制,包括输入门、遗忘门和输出门。输入门控制新信息的流入,遗忘门决定是否遗忘之前的信息,输出门控制信息的输出。这种门控机制使得 LSTM 能够更好地处理长序列数据,有效地避免了梯度消失和梯度爆炸的问题,在语言建模、机器翻译等任务中取得了很好的效果。

- 门控循环单元(GRU):GRU 是另一种改进的 RNN 结构,它将 LSTM 的输入门和遗忘门合并为一个更新门,并引入了重置门。更新门用于控制当前状态的更新,重置门用于控制是否忽略上一时刻的隐藏状态。GRU 的结构相对简单,计算效率较高,在一些任务中与 LSTM 表现相当。

- 双向循环神经网络:在一些序列学习任务中,当前时刻的输出不仅依赖于之前的信息,还可能依赖于未来的信息。双向循环神经网络通过同时使用正向和反向的 RNN 来捕捉序列的双向信息。正向 RNN 按照序列的顺序进行处理,反向 RNN 按照序列的逆序进行处理,最后将两个方向的输出进行合并,得到最终的输出。这种结构可以提高模型对序列数据的理解能力,在语音识别、文本情感分析等任务中得到了广泛应用。

六、RNN的应用场景

-

自然语言处理:RNN被广泛应用于文本分类、情感分析、语言建模、文本生成等任务。LSTM和GRU尤其适合用于序列到序列(seq2seq)模型,比如机器翻译。

-

时间序列预测:用于股票价格预测、气象预测、销售预测等基于时间序列的数据。

-

语音识别:将音频信号转化为文字,RNN能有效处理语音信号中的时间依赖关系。

-

视频分析:分析视频中的动态场景,RNN可以从帧序列中提取信息。

-

手写识别:用于识别手写字符或签名,由于字符的书写具有顺序性,RNN能很好地处理这种序列信息。

七、RNN的实现与训练

在训练RNN时,通常使用反向传播算法来调整权重,即通过**反向传播通过时间(BPTT, Backpropagation Through Time)**对网络进行优化。BPTT在时间轴上展开,将梯度反向传播,然而在长序列上容易导致梯度消失或爆炸问题,因此通常使用LSTM和GRU等变种。

总结

RNN是一种强大的序列建模工具,适合处理各种时间序列和自然语言数据。然而,传统RNN在处理长序列时存在梯度消失问题,随着LSTM和GRU等改进模型的引入,RNN的性能得到了极大提升。无论是在自然语言处理、语音识别,还是时间序列分析等领域,RNN都发挥了重要作用。