我自己的原文哦~ https://blog.51cto.com/whaosoft/12617524

#诺奖得主哈萨比斯新作登Nature,AlphaQubit解码出更可靠量子计算机

谷歌「Alpha」家族又壮大了,这次瞄准了量子计算领域。

今天凌晨,新晋诺贝尔化学奖得主、DeepMind 创始人哈萨比斯参与撰写的新论文登上了 Nature,主题是如何更准确地识别并纠正量子计算机内部的错误。

我们知道,量子计算机有潜力彻底改变药物发现、材料设计和基础物理学。不过前提是:我们得让它们可靠地工作。

虽然对于传统计算机花费数十亿年才能解决的某些问题,量子计算机在几小时内就可以搞定。然而,量子计算机比传统计算机更容易受到噪声的影响。如果想要量子计算机更可靠,尤其是在大规模情况下,则需要更准确地识别和纠正内部的错误。

因此,谷歌 DeepMind 联合谷歌量子 AI 团队发表了一篇论文,推出了 AI 解码器 AlphaQubit,它能够以 SOTA 准确性识别并纠正量子计算的错误。据介绍,这项工作汇集了谷歌 DeepMind 的机器学习知识和谷歌量子 AI 的纠错专业知识,从而加速构建可靠量子计算机的进程。

两支团队表示,准确识别量子计算机错误是促使它们能够大规模执行长时间计算的关键一步,将为科学突破和更多新领域的发现打开大门。

Nature 论文的标题为《Learning High-accuracy Error Decoding for Quantum Processors》,即《学习量子处理器的高准确性错误解码》。

- Nature 地址:https://www.nature.com/articles/s41586-024-08148-8

谷歌 CEO 桑达尔・皮查伊表示,「AlphaQubit 使用了 Transformers 解码量子计算机,从而达到量子纠错准确性新 SOTA。这是 AI + 量子计算的激动人心的交集。」

我们接下来看 AlphaQubit 的技术细节和实验结果。

量子计算纠错的原理

量子计算机利用最小尺度上物质的独特属性,例如叠加和纠缠,以比传统计算机少得多的步骤解决某些类型的复杂问题。该技术依赖于量子比特,它们可以利用量子干涉筛选大量可能性以找到答案。

不过,量子比特的自然量子态很脆弱,可能受到各种因素的干扰,包括硬件中的微观缺陷、热量、振动、电磁干扰甚至宇宙射线,可以说无处不在。

量子纠错通过使用冗余提供了一种解决方案:将多个量子比特分组为单个逻辑量子比特,并定期进行一致性检查。AlphaQubit 解码器通过利用这些一致性检查来识别逻辑量子比特中的错误,从而保留量子信息,并进行纠错。

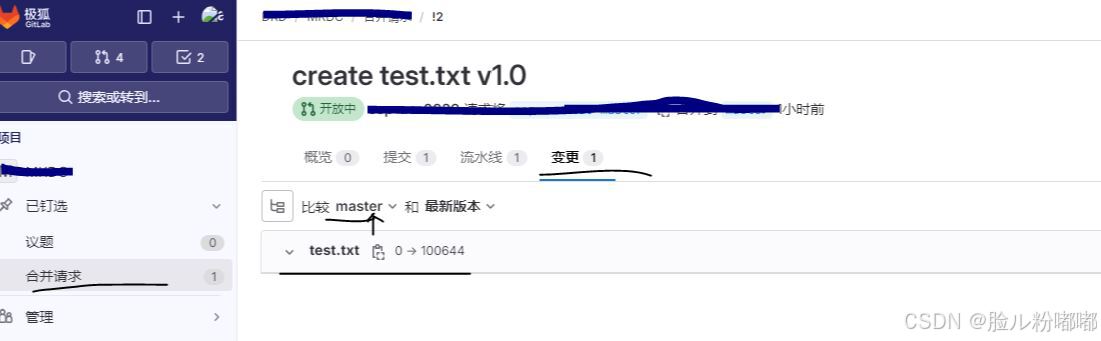

如下动图展示了边长为 3(码距离)的量子比特网格中 9 个物理量子比特(小灰色圆圈)如何形成逻辑量子比特。

其中,在每个步骤中,另外 8 个量子比特在每个时间步骤执行一致性检查(正方形和半圆形区域,失败时为蓝色和品红色,否则为灰色),以通知神经网络解码器(AlphaQubit)。在实验结束时,AlphaQubit 确定发生了哪些错误。

谷歌构建了一个神经网络解码器

AlphaQubit 是一个基于神经网络的解码器,基于 Transformers 构建,而该架构也是当今许多大型语言模型的基础。

下图为 AlphaQubit 的纠错和训练流程。a 为表面码的一轮纠错。b 为解码训练阶段。预训练样本要么来自数据无关的 SI1000 噪声模型,要么来自使用 p_ij 或 XEB 方法从实验数据得出的误差模型。

AlphaQubit 使用一致性检查(consistency checks)作为输入,旨在预测逻辑量子比特在实验结束时的状态是否与初始准备状态发生了翻转。通过一致性检查,可以识别并纠正计算过程中出现的错误,确保逻辑量子比特状态保持正确。

最终,AlphaQubit 可以报告其预测的置信度,从而有助于提高整体量子处理器的性能。

实验及结果

实验测试了 AlphaQubit 对量子处理器 Sycamore 中的逻辑量子比特的保护效果。谷歌使用量子模拟器在各种设置中生成了数亿个示例。然后,通过为 AlphaQubit 提供来自特定 Sycamore 处理器的数千个实验样本,针对特定解码任务对其进行微调。

在对 Sycamore 量子处理器的新数据进行测试时,AlphaQubit 在准确率方面设立了新的标准。在规模最大的 Sycamore 实验中,AlphaQubit 的错误率比张量网络方法低 6%。此外,AlphaQubit 的错误率比相关匹配方法低 30%。

在 Sycamore 量子处理器的实验中,解码准确性因实验规模而异。对于小规模实验(距离 3,对应 17 个物理量子比特)和大规模实验(距离 5,对应 49 个物理量子比特),AlphaQubit 的解码准确性均优于其他方法。

具体而言,AlphaQubit 的表现超过了张量网络(TN)方法,后者在大规模实验中难以扩展。同时,AlphaQubit 也优于相关匹配方法,尽管该方法在准确性和扩展性方面表现良好,但在解码准确性上仍不及 AlphaQubit。

在一系列实验中,解码器 AlphaQubit 犯的错误最少。

良好的泛化能力

为了评估 AlphaQubit 在更大规模且错误率更低的量子计算机上的适应性,研究人员使用模拟的量子系统数据对其进行了训练,规模达到 241 个量子比特,超出了 Sycamore 平台的现有能力。

结果显示,AlphaQubit 的性能优于现有的主要算法解码器,表明其在未来中型量子设备上也将具备良好的适用性。

在不同规模的实验中,即从距离 3(17 个量子比特)到距离 11(241 个量子比特)的实验中,AlphaQubit 的解码准确性始终优于相关匹配方法。需要注意的是,张量网络解码器由于在大规模实验中运行速度过慢,未在此图中显示。

最后,该系统还展示了一些高级功能,例如能够接收和报告输入和输出的置信度。这些信息丰富的界面有助于进一步提高量子处理器的性能。

当谷歌研究员在包含多达 25 轮纠错的样本上训练 AlphaQubit 时,它在多达 100,000 轮的模拟实验中保持了良好的性能,表明它能够泛化到训练数据之外的场景。

迈向更实用的量子计算

AlphaQubit 在利用机器学习进行量子误差纠错方面取得了重要的里程碑。但谷歌表示他们仍然面临速度和可扩展性方面的重大挑战。

例如,在一个快速的超导量子处理器中,每秒需要进行上百万次一致性检查。虽然 AlphaQubit 在准确识别错误方面表现出色,但目前还无法实时纠正超导处理器中的错误。谷歌还需要找到更高效的数据训练方法,用于支持基于 AI 的解码器。

目前,谷歌正在结合机器学习和量子误差纠错的前沿技术,努力克服这些挑战,为实现可靠的量子计算机铺平道路,这些技术将有能力解决世界上一些最复杂的问题。

参考链接:

https://blog.google/technology/google-deepmind/alphaqubit-quantum-error-correction/

https://x.com/GoogleDeepMind/status/1859273143157657735

#Inevitable Trade-off between Watermark Strength and Speculative Sampling Efficiency for Language Models

水印与高效推理如何两全其美?最新理论:这做不到

本文第一作者为毕业于马里兰大学计算机系的博士胡正冕,其导师为 Heng Huang。他的主要研究方向是采样与机器学习理论,曾在 ICML、NeurIPS、ICLR、EMNLP 等顶会上发表多篇论文。邮箱: huzhengmian@gmail.com

近日,DeepMind 团队将水印技术和投机采样(speculative sampling)结合,在为大语言模型加入水印的同时,提升其推理效率,降低推理成本,因此适合用于大规模生产环境。这项研究发表在了 Nature 杂志上,给出了两种具体的结合方法,分别在水印检测效果和生成速度上达到了现有最优水平,但无法同时兼顾两者。

无独有偶,另一组来自马里兰大学的研究人员针对同一个问题进行了理论角度的深入分析。他们发现了一个「不可行」定理,证明了不存在一个算法可以同时达到最优的推理效率和最高的水印强度。因此,任何水印系统都必须在这两个目标之间进行权衡。这项名为「Inevitable Trade-off between Watermark Strength and Speculative Sampling Efficiency for Language Models」的研究已被 NeurIPS 2024 会议接收。

- 论文地址: https://arxiv.org/pdf/2410.20418

- 代码仓库: https://github.com/xiaoniu-578fa6bff964d005/AcceleratedUnbiasedWatermark

无偏水印与投机采样方法

无偏水印方法 [1] 是一种将水印嵌入到生成文本的技术,它在理论上保证不影响生成文本的质量和多样性,并让水印无法被人察觉。这种水印方法可用于版权保护和来源追踪。其核心思想是在生成过程中对候选 token 的概率进行重新加权,并要求调整后的概率分布在对水印的随机私钥进行平均后,在数学期望上与原始分布相同,从而避免引入偏差。

投机采样方法 [2,3] 是一种加速大语言模型推理的技术。此方法利用较小的草稿模型快速生成草稿序列,再通过目标模型对这些草稿进行验证和修正。草稿模型规模较小,生成速度更快但质量较低;目标模型并行进行验证,接受符合条件的部分。这种方法可以在保持生成质量的同时,显著提升推理效率,降低计算成本,已成为大规模应用中不可或缺的工具。

「不可行」定理

研究者提出了一个两次重加权框架,分别对草稿模型和目标模型的输出分布进行重加权。这个框架具有很高的自由度,两次重加权函数可以不同,验证算法也可以任意选择,只要满足最终算法保持输出概率分布,从而维持输出质量即可。

在此框架下,研究者严格描述并证明了一个「不可行」定理:当词汇表大小大于 2 时,任何试图同时保持水印强度和加速效果的方法都必然使用两个平凡的重加权函数。

这个定理揭示了水印强度和投机采样效率之间存在一个不可避免的权衡,必须在两者之间做出选择。任何潜在的方法都无法同时达到在不考虑加速情况下最好的水印技术的检测效率,和在不考虑水印情况下最好的投机技术的加速效果。此结果也为未来的研究指明了方向:在设计新算法时研究者需要考虑这个理论限制,根据应用需求在两个目标之间进行平衡。

两种结合方法

即便「不可行」定理揭示了水印强度和采样效率之间存在不可避免的权衡,此研究给出了两种具体的结合水印和投机采样的方法,使得其分别满足以下两点性质:

1. 保持水印强度的方法优先确保水印的可检测性,即使这可能会牺牲一定的采样效率。这种方法首先对目标模型和草稿模型的输出概率分布进行重加权并从中采样,然后基于两个重加权分布进行投机采样。

2. 保持采样效率的方法优先保证生成速度,即使水印的强度可能有所降低。这种方法仍然对目标模型和草稿模型的输出概率分布进行重加权并从中采样,但接下来基于两个未经过重加权的分布进行投机采样。

这两种方法体现了不同的取舍,使用者可以根据具体应用场景和需求进行选择。

实验结果

研究人员在多种文本生成任务以及多种语言模型上进行了实验。他们引入了两个指标:平均每步接受的 token 数(AATPS)衡量投机采样效率,每个 token 的平均负对数 P 值(ANLPPT)衡量水印强度。

实验结果验证了理论分析的正确性,证实了水印强度和采样效率之间确实存在权衡。保持水印强度的方法在水印强度上与传统无偏水印方法相当,但采样效率相比原始投机采样方法有所下降;保持采样效率的方法在采样效率上与原始投机采样方法相当,但水印强度有明显降低。这表明根据实际需求,可以选择优先保证水印强度或采样效率的策略。

总结

此研究从理论角度证明了水印可检测性和投机采样效率之间存在根本冲突,这种冲突并不仅限于现在已有的方法,而是一个普遍规律。鉴于投机采样已经成为降低推理成本不可或缺的工具,高可检测水印系统带来的推理成本增加在未来将持续存在。

将水印技术与投机采样结合这个行为虽然可以让水印更接近实用,但同时也可能带来一些伦理问题,如未经披露的跟踪行为。在实际应用中,人们应当谨慎、合乎伦理地应用无偏水印方法,并向用户明确说明其存在,工作原理和意义。

#神级项目训练GPT-2仅需5分钟

Andrej Karpathy都点赞

租用 H100 的钱只需 233 美元。

还记得 Andrej Karpathy 纯 C 语言复现 GPT-2 大模型的项目吗?

今年 4 月,AI 领域大牛 Karpathy 一个仅用 1000 行代码即可在 CPU/fp32 上实现 GPT-2 训练的项目「llm.c」曾经引发机器学习社区的热烈讨论。

llm.c 旨在大幅简化大模型的训练,ta 使用纯 C 语言 / CUDA,不需要 245MB 的 PyTorch 或 107MB 的 cPython。不过即使是这样的优化,复现 GPT-2 级别的模型也需要在 8 块 H100 上花费 45 分钟进行训练。

没想到几个月过去,业界水平居然有了指数级的提升,让 Karpathy 本人都感到惊叹:

在 GitHub 上出现了一个新项目「Modded-NanoGPT」,对技术进行了大幅度的迭代,现在实现相同的结果只需要 5 分钟。该研究的作者 Keller Jordan 曾在 Hive AI 工作,一直以来的研究方向都着重于模型训练的优化。他在本周三表示,利用具有大序列长度的 FlexAttention,他已把速度的记录从 7.2 分钟提升到了 5 分钟。

现在有了 FlexAttention 和较大的 seqlen,文档的拆分更少了,因此语言建模在训练和验证时都变得更容易。该记录在 HellaSwag 上的准确率略有降低,约为 29%,而之前的记录和 Andrej Karpathy 的原始训练准确率约为 30%。

让我们看看他是怎么做的:

项目链接:https://github.com/KellerJordan/modded-nanogpt/tree/master

Modded-NanoGPT

该项目名为「Modded-NanoGPT」,它是 llm.c 存储库的 PyTorch GPT-2 训练器的改进变体:

- 10B tokens-->1B tokens

- 8xH100 上花 45 分钟训练 -->8xH100 上花 5 分钟训练

Modded-NanoGPT 采用如下技术:

- 先进的架构:旋转嵌入、QK-Norm 和 ReLU^2;

- 新优化器:Muon;

- 嵌入中的 Untied Head;

- 投影和分类层初始化为零(muP-like);

- 架构 shortcut:值残差和嵌入 shortcut(部分遵循论文《Value Residual Learning For Alleviating Attention Concentration In Transformers》);

- 动量(Momentum)warmup;

- Tanh soft logit capping(遵循 Gemma 2);

- FlexAttention。

要进行训练,请运行以下三个命令:

pip install -r requirements.txt

pip install --pre torch --index-url https://download.pytorch.org/whl/nightly/cu124 —upgrade # install torch 2.6.0

python data/cached_fineweb10B.py 10 # downloads only the first 1.0B training tokens to save time

./run.sh在网络连接良好的 8xH100 上,训练应在 20 分钟内完成。

结果将是一个具有 124M 活跃参数的 transformer,在 10 亿 Fineweb tokens 上训练了 1875 steps,实现了约 3.278 的验证损失。相比之下,默认的 llm.c PyTorch 训练器在 100 亿 tokens 上训练了 19560 steps 后,验证损失 >3.28。

值得一提的是,要在更少的 GPU 上运行 Modded-NanoGPT,只需修改 run.sh 以获得不同的 --nproc_per_node。如果内存不足,只需在 train_gpt2.py 中将 device_batch_size 缩小到 16 或 32。

这里有一个适用于全新 8xH100 实例的启动脚本:

sudo apt-get update

sudo apt-get install vim tmux python3-pip python-is-python3 -y

git clone https://github.com/KellerJordan/modded-nanogpt.git

cd modded-nanogpt

tmuxpip install numpy==1.23.5 huggingface-hub tqdm

pip install --upgrade torch &

python data/cached_fineweb10B.py 18如果 CUDA 或 NCCL 版本与你当前的系统设置不兼容,Docker 可以成为一种有用的替代方案。这种方法标准化了 CUDA、NCCL、CUDNN 和 Python 的版本,减少了依赖性问题并简化了设置。注意:系统上必须已安装 NVIDIA 驱动程序。

sudo docker build -t modded-nanogpt .

sudo docker run -it --rm --gpus all -v $(pwd):/modded-nanogpt modded-nanogpt python data/cached_fineweb10B.py 18

sudo docker run -it --rm --gpus all -v $(pwd):/modded-nanogpt modded-nanogpt sh run.sh有一个问题在于,NanoGPT 训练很快是很好,但它可能无法扩展,只是过拟合了 val 损失?Keller Jordan 表示,这很难反驳,因为「按规模」是一个无限类别(如果这些方法对 >100T 的模型就不奏效了怎么办?),因此无法完全证明。此外,作者也同意快速运行中使用的一些方法不太可能扩展。但如果读者关心 1.5B 模型,他们可能会被这个结果说服:

直接将快速运行(10/18/24 版本)扩展到 1.5B 参数可以得到一个具有 GPT-2(1.5B)级 HellaSwag 性能的模型,它要比 Karpathy 的基线便宜 2.5 倍(233 美元对比 576 美元):

Muon optimizer

除了在前人的肩膀上探索,新项目也使用了 Keller Jordan 自研的优化方式。比如这个 Muon 优化器,据他所说是目前已知最快的优化器,适用于包括 CIFAR-10 和 GPT-2 规模语言建模在内的各种训练场景。

Muon 的定义如下:

其中 NewtonSchulz5 是 Newton-Schulz 之后的迭代,它近似地用 U @ V.T 替换 G,其中 U, S, V = G.svd ()。

@torch.compile

def zeroth_power_via_newtonschulz5 (G, steps=5, eps=1e-7):assert len (G.shape) == 2a, b, c = (3.4445, -4.7750, 2.0315)X = G.bfloat16 () / (G.norm () + eps)if G.size (0) > G.size (1):X = X.T for _ in range (steps):A = X @ X.TB = b * A + c * A @ AX = a * X + B @ Xif G.size (0) > G.size (1):X = X.T return X.to (G.dtype)对于这种训练场景,Muon 具有以下有利特性:

- 内存使用量比 Adam 低

- 采样效率提高约 1.5 倍

- 挂钟开销小于 2%

总结

作者表示,生成此优化器的许多选择都是通过追求 CIFAR-10 快速运行而通过实验获得的。其中值得一提的经验包括:

- 在更新中使用 Nesterov 动量,在动量之后应用正交化。

- 使用特定的五次 Newton-Schulz 迭代作为正交化方法。

- 使用五次多项式的非收敛系数以最大化零处的斜率,从而最小化必要的 Newton-Schulz 迭代次数。事实证明,方差实际上并不那么重要,因此我们最终得到一个五次多项式,它在重复应用后(快速)收敛到 0.68、1.13 的范围,而不是到 1。

- 在 bfloat16 中运行 Newton-Schulz 迭代(而 Shampoo 实现通常依赖于在 fp32 或 fp64 中运行的逆 pth 根)。

使用 Newton-Schulz 迭代进行正交化的方法可以追溯到 Bernstein & Newhouse (2024),他们建议将其作为计算 Shampoo 预处理器的方法,并从理论上探索了没有预处理器累积的 Shampoo。Keller Jordan 特别感谢了论文作者之一 Jeremy Bernstein 的协助。

如果我们在这里使用 SVD 而不是 Newton-Schulz 迭代,那么这个优化器就会因为太慢而无法使用。Bernstein & Newhouse 还指出,没有预处理器累积的 Shampoo 相当于谱范数中的最陡下降,因此 Shampoo 可以被认为是一种平滑谱最陡下降的方法。所提出的优化器可以被认为是平滑谱最陡下降的第二种方法,与 Shampoo 相比,它具有不同的内存和运行时权衡。

#热门开源大模型集合!

自2022年年底ChatGPT的火爆出圈以来,大模型开发的热潮如雨后春笋般涌现,推动了人工智能技术的飞速发展。本文旨在收集并介绍近两年大热的开源大语言模型,为开发者提供一个快速了解并认识最新、最热大模型的窗口。

此外,社区项目』已经成功引入了多款热门的大语言模型,诚邀广大开发者前来体验与探索。

Llama

Llama 1 在 2023 年 2 月发布,参数量分别有7B、13B、30B 和 65B 四个版本。

同年 7 月发布了 Llama 2,参数量分别有 7B、13B、34B 和 70B 四个版本。相较于一代,二代将预训练的语料 token 数量扩充到了 2T(万亿),同时将模型的上下文长度从 2048 翻倍到了 4096,并引入分组查询注意力机制(grouped-query attention, GQA)技术,更好的权衡了最佳性能最佳性能(multi-query attention,MQA)和最佳模型质量(multi-head attention,MHA)之间的关系。

基于二代,8月份又发布了专注于代码生成的CodeLlama,参数量分别有 7B、13B、34B 和 70B 四个版本。

今年 4 月份,发布了 Llama 3,包括 8B 和70B 两个参数量版本。相比二代,三代支持 8K 长文本,并采用了编码效率更高的 tokenizer,词表的大小为 128K。token 的语料库超过 15T,超二代 7 倍还多。

开源团队:Meta

参考文献:

Llama 1论文:https://arxiv.org/pdf/2302.13971

Llama 1代码:https://github.com/meta-llama/llama

Llama 2论文:https://arxiv.org/abs/2307.09288

Llama 3代码:https://github.com/meta-llama/llama3

一键部署 Meta新开源【Llama3.1-70B-Instruct】聊天

一键部署 【Llama-3.1-8B-Instruct】Llama Factory

Gemma

Gemma 是今年年初谷歌开源的一个小尺寸大语言模型,参数量有 2B 和 7B 两个版本,亮点是与自家最强的大模型 Gemini 共享同一套技术。

年中,又推出 Gemma 2,提供两种规模参数版本:9B 和 27B,每种规模又分为预训练基础版和指令调优版,总共四个版本。其中,27B 模型经过训练处理了 13 万亿个 tokens,而 9B 模型则是 8 万亿个 tokens。

相较于一代,Gemma 2在性能上有了显著提升,而部署要求却大幅降低。

参考文献:

- gemma-2b:https://huggingface.co/google/gemma-2b

- gemma-7b:https://huggingface.co/google/gemma-7b

- gemma-2-2b:https://huggingface.co/google/gemma-2-2b

- gemma-2-9b:https://huggingface.co/google/gemma-2-9b

- 【Gemma2-2B-it】谷歌小模型 轻量级的小型巨人:https://open.virtaicloud.com/web/project/detail/477027980988674048

Qwen

Qwen(通义千问)是阿里开发的大语言模型,自 2023 年 4 月开放测试,8 月开源 7B 模型,12 月开源 72B;

至 2024 年 3 月开放了 Qwen1.5-32B,6 月开放 Qwen2,9 月开放 Qwen2.5,额外增加了 3B、14B 和 32B 参数量版本,

最大限度兼顾性能、效率和内存占用的平衡,Qwen 系列的不断更新,为开源社区做出了贡献。

| 系列名称 | 参数量 | 语言支持种类 | tokens | 最大上下文长度 |

| Qwen 1 | 1.8B、7B、14B 和 72B 四个版本 | 以中文和英文为主 | 达 3 万亿 | 32K |

| Qwen 1.5 | 0.5B、1.8B、4B、7B、14B 和 72B 六个版本 | 12 种语言 | 7T | 32K |

| Qwen 12 | 0.5B、1.5B、7B、57B 和 72B 五个版本 | 达 27 种 | 12 T | 128K |

| Qwen 2.5 | 0.5B、1.5B、3B、7B、14B、32B 和 72B 七个版本 | 超 29 种 | 达 18T | 128K |

参考文献:

- Qwen 1论文:https://arxiv.org/pdf/2309.16609

- Qwen 1代码:https://github.com/QwenLM/Qwen

- Qwen 2论文:https://arxiv.org/pdf/2407.10671

- Qwen 2.5代码:https://github.com/QwenLM/Qwen2.5

- 【Qwen-2.5-3B】甄嬛语气 LoRA 微调:https://open.virtaicloud.com/web/project/detail/495455094385659904

- 【Qwen2.5-LLM】扩展大型语言模型的边界:https://open.virtaicloud.com/web/project/detail/494408714095894528

- 【Qwen2-Audio-7B-Instruct】对话式AI突破,让你“声”临其境:https://open.virtaicloud.com/web/project/detail/478841736102936576

InternLM

2023 年 9 月上海 AI Lab 发布 InternLM-20B,包括 base+chat 两版,同年 12 月更新了 InternLM-7B-Chat 和 InternLM-20B-Chat 模型权重。

2024 年 1 月相继发布了

- InternLM2-7B 和 InternLM2-20B,base+chat;

- InternLM2-Math-7B 和 InternLM2-Math-20B,用于数理逻辑推理,超过ChatGPT;

- InternLM2-1.8B:轻量模型发布,base+chat。

3 月发布 InternLM2 技术报告;6 月发布 InternLM2.5-7B、InternLM2.5-7B-Chat 和 InternLM2.5-7B-Chat-1M;7 月发布了 1.8B、7B 和 20B 大小的 InternLM2-Reward 系列奖励模型;8 月发布了 InternLM2.5-1.8B、InternLM2.5-1.8B-Chat、InternLM2.5-20B 和 InternLM2.5-20B-Chat。

参考文献:

- InternLM2 论文:https://arxiv.org/abs/2403.17297

- 开源地址:https://github.com/InternLM/InternLM

- huggingface:https://huggingface.co/collections/internlm/internlm25-66853f32717072d17581bc13

Baichuan

Baichuan 是百川智能开发的一个开源可商用的大规模预训练语言模型,支持中英双语,上下文窗口长度为 4096。首先开放了 Baichuan-7B 版,随后更新了 Baichuan-13B 版,该版本训练语料 tokens 达 1.4 万亿 ,超过 LLaMA-13B 40%。

至 Baichuan 2 版中,训练语料 tokens 达 2.6 万亿,发布版本包括Base(7B、13B)、Chat(7B、13B)和Chat-4bits(7B、13B)。

参考文献:

- Baichuan-7B:https://github.com/baichuan-inc/Baichuan-7B

- Baichuan-13B:https://github.com/baichuan-inc/Baichuan-13B

- Baichuan2:https://github.com/baichuan-inc/Baichuan2

- 使用【LLaMA Factory】微调【Baichuan2-13B-Chat】:https://open.virtaicloud.com/web/project/detail/460826327575740416

#高中生!NeurIPS 2024开卷

人大附中、北师大实验中学等摘得3篇Spotlight

就在刚刚,NeurIPS 2024首届高中论文录用结果公布了

今年,NeurIPS 2024首次设置了「高中生赛道」,直接将「学好AI要从娃娃抓起」变成了现实。

此举曾在今年4月引发激烈的讨论,有人认为这为有科研潜力的高中生提供了宝贵机会,也有人担心它会进一步加剧教育资源的不平等。甚至有网友戏称,这是「代练家长」的战场,研究生和博士们可能也会被拉下水。

总之,此次大会邀请高中生提交关于「机器学习对社会影响」的研究论文。部分决赛入围者将获得在线展示项目的机会,并将在NeurIPS官网上重点展示他们的研究成果。此外,获奖项目的第一作者将被邀请参加在温哥华举行的NeurIPS 2024颁奖典礼。

研究应用领域包括但不限于以下方面:农业、气候变化、教育、医疗保健、无家可归问题、饥饿、粮食安全、心理健康、贫困、水质。

值得注意的是,每份提交作品必须由高中生作者独立完成。

最终,大会共收到了全球高中生提交的330个项目。

其中,有21篇被选为Spotlight,4篇为获奖论文,接受率6.4%。

值得注意的是,总共约有13位华人学生入选,其中3名国内学生的论文获得Spotlight!

他们分别是来自上海星河湾双语学校的Tianrui Chen、人民大学附属中学的Alan Wu、北京师范大学附属实验中学的Yuhuan Fan。

获奖项目

1. ALLocate: A Low-Cost Automatic Artificial Intelligence System for the Real-Time Localization and Classification of Acute Myeloid Leukemia in Bone Marrow Smears

作者:Ethan Yan

学校:Groton School(美国)

(ALLocate:一种低成本自动化AI系统,用于骨髓涂片中急性髓性白血病的实时定位和分类)

当前临床实践中,准确检测白血病仍面临成本高、耗时长及医疗经验不足等挑战。为解决这一问题,该研究开发了首个用于实时定位和分类骨髓涂片中急性髓系白血病的低成本集成自动人工智能系统——ALLocate。

该系统由自动显微镜扫描系统和图像采样系统组成,并配有基于深度学习的定位和分类系统。研究开发了一种基于卷积神经网络(CNN)的区域分类器,用于从血液和血块区域中筛选可用区域。为了实现实时检测,开发并优化了YOLOv8模型。这些模型表现出高性能,区域分类器的准确率达到96%,YOLOv8的mAP为91%。

此外,研究还使用3D打印组件开发了一种低成本自动显微镜扫描仪系统,该系统由步进电机驱动,并通过基于Arduino的RAMPS控制板进行编程控制。将ALLocate应用于骨髓涂片时,其白血病检测结果与医生的结果相似,但速度明显更快。

这是首次将深度学习系统与低成本显微镜扫描系统集成应用于高性能白血病检测的报告,可惠及小型社区诊所和资源匮乏地区的诊所,从而使医疗服务更加普惠且经济可行。

2. Image Classification on Satellite Imagery For Sustainable Rainwater Harvesting Placement in Indigenous Communities of Northern Tanzania

作者:Roshan Taneja,Yuvraj Taneja

学校:Sacred Heart Preparatory(美国)

(利用卫星图像分类技术在坦桑尼亚北部土著社区进行雨水可持续收集系统选址)

在坦桑尼亚北部偏远地区,马赛部落的妇女和儿童每天需要步行九小时去取水。通过与马赛社区长达四年的合作努力,已安装了多个雨水收集装置,为超过4000人提供了教育机会和经济发展的条件,从而改善了当地的社会经济状况。

本项目采用了一种创新方法,将卫星数据与图像分类相结合,用于识别以独特形状的马赛房屋为标志的人口密集区域。它还将利用密度地图规划最佳的雨水收集装置位置,目标是帮助3万名马赛族人。

该项目的核心是开发了一个图像分类模型,该模型基于1万张手工挑选的 Bomas(马赛居住单位)的卫星图像样本进行训练。通过此模型生成的密度热力图,可以在最关键的位置战略性地放置雨水收集装置,从而最大化其影响。该项目突显了卫星技术与机器学习在解决人道主义需求(如水资源问题)方面的潜力,尤其是在难以建设基础设施的偏远地区。

3. Multimodal Representation Learning using Adaptive Graph Construction

作者:Weichen Huang

学校:St. Andrew’s College(爱尔兰)

(基于自适应图构建的多模态表征学习)

多模态对比学习通过利用图像和文本等异构数据源来训练神经网络。然而,许多当前的多模态学习架构无法泛化到任意数量的模态,并且需要手动构建。

该项目提出了一种新颖的对比学习框架AutoBIND,可以通过图优化从任意数量的模态中学习表示。

研究在阿尔茨海默病检测中评估了AutoBIND,因为它具有现实世界的医学应用价值,并且包含广泛的数据模态。实验结果表明,AutoBIND在这一任务上优于以往的方法,凸显了该方法的泛化能力。

4. PumaGuard: AI-enabled targeted puma mitigation

作者:Aditya Viswanathan,Adis Bock,Zoe Bent,Tate Plohr,Suchir Jha,Celia Pesiri,Sebastian Koglin,Phoebe Reid

学校:Los Alamos High School(美国)

(PumaGuard:基于AI的美洲狮精准防治系统)

该项目训练了一个机器学习分类算法,以检测野外摄像机图像中的美洲狮。这个算法将成为一种专用防范工具的一部分,以阻止美洲狮攻击当地马厩的牲畜。该模型使用Xception算法,训练准确率达99%,验证准确率为91%,并成功识别出马厩附近的美洲狮。

Spotlight项目

1. Predicting Neurodevelopmental Disorders in rs-fMRI via Graph-in-Graph Neural Networks

作者:Yuhuan Fan

学校:The Experimental High School Attached to Beijing Normal University(北京师范大学附属实验中学)

(基于嵌套图神经网络在静息态功能磁共振成像中预测神经发育障碍)

2. GeoAgent: Precise Worldwide Multimedia Geolocation with Large Multimodal Models

作者:Tianrui Chen(陈天睿)

学校:Shanghai Starriver Bilingual School(上海星河湾双语学校)

(GeoAgent:基于大规模多模态模型的全球多媒体精确地理定位)

值得一提的是,陈天睿同学还参加了今年8月举办的第一届国际人工智能奥林匹克(IOAI)。

参赛成员来自全球的34个国家与地区,共44支队伍。其中,陈天睿作为乾队队长,带领团队斩获2枚银牌。另外,坤队也获得了1枚银牌。

3. Vision-Braille: An End-to-End Tool for Chinese Braille Image-to-Text Translation

作者:Alan Wu(吴悠)

学校:The High School Affiliated to Renmin University of China(中国人民大学附属中学)

(Vision-Braille:面向中文盲文图像到文本转译的端到端工具)

论文地址:https://arxiv.org/abs/2407.06048

结合盲文识别算法,该项目开发了首个公开可用的盲文翻译系统。

由于缺乏高度准确的盲文翻译系统,视障群体的盲文作业或考试试卷常常无法被普通教师理解,特别是中文盲文还包含声调标记。为了节省空间,盲文书写者常常省略声调标记,这导致在将具有相同声母和韵母的盲文翻译成中文时容易产生混淆。以往的算法在提取上下文信息方面存在不足,导致盲文翻译成中文的准确率较低。

该项目创新性地对mT5模型进行了信息化微调,采用了编码器-解码器架构,用于实现盲文到汉字的转换。本研究基于Leipzig Corpora创建了盲文与相应中文文本的训练数据集。

通过课程学习的微调方法,本项目显著减少了盲文中的混淆问题,在验证集和测试集上分别达到了62.4和62.3的BLEU分数。

这一系统将为备战中国高考的视障学生及其家庭带来帮助,为他们实现大学梦想提供助力,并推动教育公平的发展。

项目地址:https://vision-braille.com/

北京大学计算机学院的张铭教授在今年9月也分享了吴悠同学的入围消息,并对她表示了祝贺。据张铭教授介绍,吴悠在2022年高一加入她的课题组时,就提出了这个项目的想法。

4. Diagnosing Tuberculosis Through Digital Biomarkers Derived From Recorded Coughs

作者:Sherry Dong

学校:Skyline High School(美国)

5. INAVI: Indoor Navigation Assistance for the Visually Impaired

作者:Krishna Jaganathan

学校:Waubonsie Valley High School(美国)

6. Implementing AI-driven Techniques for Monitoring Bee activities in Hives

作者:Tahmine Dehghanmnashadi

学校:Shahed Afshar High School for Girls(伊朗)

7. AquaSent-TMMAE: A Self-Supervised Learning Method for Water Quality Monitoring

作者:Cara Lee, Andrew Kan,Christopher Kan

学校:Woodside Priory School(美国),Weston High School(美国),Noble and Greenough School(美国)

8. AAVENUE: Detecting LLM Biases on NLU Tasks in AAVE via a Novel Benchmark

作者:Abhay Gupta,Philip Meng,Ece Yurtseven

学校:John Jay Senior High School(美国),Phillips Academy(美国),Robert College(土耳其)

9. FireBrake: Optimal Firebreak Placements for Active Fires using Deep Reinforcement Learning

作者:Aadi Kenchammana

学校:Saint Francis High School(美国)

10. Advancing Diabetic Retinopathy Diagnosis: A Deep Learning Approach using Vision Transformer Models

作者:Rhea Shah

学校:Illinos Mathematics & Science Academy(美国)

11. LocalClimaX: Increasing Regional Accuracy in Transformer-Based Mid-Range Weather Forecasts

作者:Roi Mahns,Ayla Mahns

学校:Antilles High School(美国)

12. HypeFL: A Novel Blockchain-Based Architecture for a Fully-Connected Autonomous Vehicle System using Federated Learning and Cooperative Perception

作者:Mihika A. Dusad,Aryaman Khanna

学校:Thomas Jefferson High School for Science and Technology(美国)

13. Robustness Evaluation for Optical Diffraction Tomography

作者:Warren M. Xie

学校:Singapore American School(新加坡)

14. Translating What You See To What You Do: Multimodal Behavioral Analysis for Individuals with ASD

作者:Emily Yu

学校:Pittsford Mendon High School(美国)

15. SignSpeak: Open-Source Time Series Classification for ASL Translation

作者:Aditya Makkar,Divya Makkar,Aarav Patel

学校:Turner Fenton Secondary School(加拿大)

16. SeeSay: An Assistive Device for the Visually Impaired Using Retrieval Augmented Generation

作者:Melody Yu

学校:Sage Hill School(美国)

17. Realistic B-mode Ultrasound Image Generation from Color Flow Doppler using Deep Learning Image-to-Image Translation

作者:Sarthak Jain

学校:Silver Creek High School(美国)

参考资料:

https://blog.neurips.cc/2024/11/18/announcing-the-neurips-high-school-projects-results/

#宝可梦GO「偷家」李飞飞空间智能

全球最强3D地图诞生,150万亿参数解锁现实边界

5年,5000万个神经网络,这个世界从未被扫描过的角落,我们都能看到了。宝可梦GO团队,竟然抢先实现了李飞飞的「空间智能」?而「Pokémon Go」的玩家可能没想到,自己居然在训练着一个巨大的AI模型。

李飞飞提出的「空间智能」概念,被宝可梦GO团队抢先实现了?

最近,宝可梦GO团队宣布,构建出了一个大规模地理空间模型LGM,让我们距离空间智能更近了一步。

而这一成果也意味着,人类在空间计算和AR眼镜领域,即将进入崭新的时代。

作为Niantic视觉定位系统(VPS)的一部分,团队训练了超过5000万个神经网络,参数规模超过150万亿。

我们可以把LGM想象成一张为计算机准备的超级智能地图,不过,它却能以与人类类似的方式理解空间。

凭借这种对世界的强大3D理解能力,LGM能够非常智能地「填补空白」,甚至包括那些地球上人类尚未全面扫描的领域!

可以说是,让AI终于长出了眼睛

从此,LGM将使计算机不仅能感知和理解空间,还能以新的方式与之互动,这就意味着AR眼镜和机器人、内容创建、自主系统等领域将迎来全新的突破。

随着我们从手机转向与现实世界相连的可穿戴技术,空间智能,将成为未来世界的操作系统!

全球数百万个场景,通过AI相连

这个大规模地理空间模型的概念,是利用大规模机器学习理解场景,然后它就会与全球数百万个其他场景相连。

你是否曾有这样的感觉?

看到一种熟悉的建筑,比如教堂、雕像或城镇广场,我们很容易想象它从其他角度看起来是什么样子,即使这些角度我们从未见过。

这,就是我们人类独有的「空间理解」功能,它意味着,我们可以根据以前遇到的无数相似场景来填补这些细节。

但这种能力对于机器来说,却是难如登天。

即使当今最先进的AI模型,也难以推断出场景中缺失的部分、将其可视化,或者想象出一个地方从全新的角度看起来是什么样子。

如今,LGM打破了AI的这种限制!

这套由宝可梦GO团队训练出的神经网络,可以在超过100万个地点进行操作。

每个本地网络,都会为全球大模型做出贡献,实现对地理位置的贡献理解,包括那些尚未扫描的地方。

什么是大规模地理空间模型

我们都知道,LLM是通过在互联网规模的文本集合上进行训练后,从而理解和生成书面语言。

这种方式,挑战了我们对「智能」的理解。

同样,大规模地理空间模型也是以一种同样先进的方式,帮助计算机感知、理解物理世界,为之导航。

跟LLM类似,它同样是通过大量原始数据构建的——

数十亿张全球各地的图像,全部锚定在地球上的精确位置,被提炼成一个大模型,让计算机能够基于位置去理解空间、结构和物理交互。

从基于文本的模型向基于3D数据的模型的转变,也揭示出近年来AI发展的一条轨迹:从理解和生成语言,到解释和创建静态和动态图像(2D视觉模型),再到对物体的3D外观进行建模(3D视觉模型)。

而现在,地理空间模型甚至比3D视觉模型更进一步,因为它们捕捉的是根植于特定地理位置、并且具有度量特性的3D实体。

与典型的生成式3D模型不同,大规模地理空间模型绑定到了度量空间,因而能够以尺度度量单位进行精确的估算,而前者生成的,只是未缩放的资产。

因此,这些实体代表的是下一代地图,而非任意的3D资产。

虽然3D视觉模型也能创建和理解3D场景,但地理空间模型却理解该场景如何与全球数百万其他场景在地理上相关联。

它实现了一种地理空间智能,让模型从其先前的观察中学习,然后还能将知识转移到新的位置,即使这些位置只是被部分观察到的。

现在,带有3D图形的AR眼镜距离大规模市场化还有几年时间,但地理空间模型已经有机会与纯音频或2D显示的眼镜集成了!

想象一下,这些模型可以引导我们穿越世界,回答问题,提供个性化推荐,提供导航,甚至增强我们与现实世界的互动。

而且,它还可以集成LLM,让理解和空间融合在一起,让人们能更加了解自己周边的环境和社区,并且与之互动。

这种地理空间智能还能生成和操纵世界的3D表示,构建下一代AR体验。

除了游戏之外,在空间规划和设计、物流、观众互动和远程协作上,大规模地理空间模型都将具有无限的潜力。

5000万个神经网络,详细了解整个世界

为了构建视觉定位系统VPS,Niantic团队已经花费了五年。

这个系统仅利用手机上的单张图像,就能让用户在团队的游戏和Scaniverse中有趣的地点构建3D地图,从而确定其位置和方向。

有了VPS,用户就可以以厘米级的精度,在世界中定位自己!

这就意味着,他们可以精确而真实地看到放置到物理环境中的数字内容。

这些内容是持久的,即使你离开后,它们仍然会留在原地,还能与他人共享。

比如,团队最近在Pokémon GO中推出了一项名为Pokémon Playgrounds的实验功能,让用户在特定位置上放置宝可梦,将它们留在原地,供其他人查看和互动

所以,VPS是怎样创建出对世界如此高度详细的理解呢?

原来,Niantic的VPS都是通过用户扫描构建的。

这些用户会通过不同的视角拍摄,并且还会在一天中的不同时间,以及多年来的多次拍摄,同时附有定位信息,从而创建出了对世界高度详细的理解。

这些数据是独一无二的,因为它们是从行人视角获取,包括了汽车无法到达的地方。

如今团队已经在全球范围内拥有1000万个扫描地点,其中超过100万个已激活,可供VPS使用了。

而且,团队每周还在接收约100万次新的扫描,每次扫描都包含数百张独立的图像。

作为VPS的一部分,团队使用运动结构技术构建经典的3D视觉地图,同时也为每个地点构建了一种新型的神经地图。

这些神经模型基于ACE(2023)和ACE Zero(2024)这两篇论文,不再使用经典的3D数据结构来表示位置,而是将它们隐式编码在神经网络的可学习参数中。

这些网络可以快速地将数千张地图图像压缩成精简的神经表示。

给定一张新的查询图像,它们以厘米级的精度,对这个位置进行精确定位。

Niantic训练的超过5000万个神经网络中,多个网络都可以为单个位置做贡献。

所有这些网络结合起来后,总共包含了超过150万亿个通过机器学习优化的参数。

超越本地模型,让空间理解更宏大

而且,团队还有一个宏伟的愿景。

虽然当前的神经地图,已经是一个比较庞大的地理空间模型了,但他们想做的,是一个超越独立本地地图系统的更大规模的模型。

完全本地化的模型,可能无法完整覆盖各自的位置,无论在全球范围内有多少可用数据,局部上它们都是稀疏的。

局部模型的失败之处就在于,它无法超出已经看到的内容和位置进行推断。因此,本地模型只能定位与训练过的视图相似的相机视图。

现在 ,想象一下我们正站在一个教堂后面。

如果本地模型只见过教堂的前门,它是无法告诉你的准确位置的,因为它从未见过教堂的背面。

但是在全球范围内,我们却见过数以千计的教堂,它们都是由其他地方的本地模型捕获。虽然没有哪座教堂完全相同,但许多教堂有共同的特征。

LGM用的正是访问这些分布式知识的方法。

它可以提炼出全球大规模模型中的共同信息,在本地模型之间实现通信和数据共享。

它可以内化教堂的概念,并且进一步理解这些建筑是如何构造的。

即使对于某个特定位置只绘制了教堂入口的地图,LGM也能够根据之前见过的数千座教堂,对教堂的背面做出明智的猜测。

因此,即使是VPS从未见过的视点和角度,LGM也能在定位中实现前所未有的鲁棒性。

可以说,全球模型实现了对世界的集中理解,而且完全是源自地理空间和视觉数据。通过全球插值,它能进行局部推断。

让AI像人一样理解

上述过程,类似于人类感知和想象世界的方式。

对于人类来说,即使是从不同的角度,也能自然而然地识别出我们以前见过的东西。

想象在欧洲老城蜿蜒街道中漫步,你依然能轻而易举地找到返回的路。

这看似理所当然的能力,背后蕴含着惊人的复杂性。尤其是,对于机器视觉技术来说极其困难。

AI若想拥有类人的理解力,便需要了解一些自然法则:

世界由固体物质组成的物体构成,因此有正面和背面。外观会根据一天中的时间和季节而变化。

同时,这也需要相当多的文化知识:许多人造物体的形状遵循特定的对称规则或其他通用布局类型——通常取决于地理区域。

早期的计算机视觉研究试图解读其中的一些规则以便将其硬编码到手工制作的系统中。

但现在,科学家们意识到,我们所追求的这种高度理解实际上只能通过大规模机器学习来实现。

这正是LGM所追求的目标。

在Niantic联手牛津大学的最新研究论文MicKey中,首次看到了从数据中出现的令人印象深刻的相机定位能力。

论文地址:https://arxiv.org/pdf/2404.06337

MicKey是一个神经网络,能够在剧烈的视点变化下将两个相机视图相对定位。

MicKey甚至可以处理需要人类花费一些努力才能弄清楚的对立镜头。

更令人兴奋的是,MicKey仅使用很少的训练数据,就取得了这样的成就。

MicKey限制于双视图输入,并在相对较少的数据上进行了训练,但它仍然是关于LGM潜力的概念验证。

显然,要实现高级空间智能,还需要海量的地理空间数据。

而Niantic的独特优势在于,每周都会收集超100万用户贡献的真实世界地点扫描。

多模型互补,重定义空间智能未来

LGM绝不仅仅是一个简单的定位模型。

为了很好地解决定位问题,LGM必须将丰富的几何、外观和文化信息编码到场景级特征中。这些特征将启用场景表示、操控和创造的新方式。

可以想象出,一个能够「理解」场景的智能系统,不仅能定位,还能感知周围环境深层次特征。

像LGM这样多功能大型AI模型,因其对多种下游应用的实用性,通常被称为「基础模型」。

未来的智能体系统,不再是孤立的存在,不同类型的基础模型将相互补充。

LLM将与多模态模型互动,而后者又与LGM进行通信。这些系统协同工作,以单一模型无法实现的方式理解世界。

这种互联是空间计算的未来——智能系统能够感知、理解并对物理世界采取行动。

随着迈向更具扩展性的模型,Niantic目标仍然是引领大规模地理空间模型的发展,创造前所未有的用户体验。

除了游戏,大规模地理空间模型将在空间规划与设计、物流、受众参与和远程协作等方面有广泛的应用。

LGM代表着AI进化的有一个里程碑。

随着AR眼镜等可穿戴设备变得更加普及,我们正迈向一个由物理和数字现实无缝融合的未来。

参考资料:

https://nianticlabs.com/news/largegeospatialmodel

#OmAgent

如今的智能体,已经像人一样「浏览」视频了,国内就有

当你正在观看一部紧张刺激的动作电影,忽然好奇:

“那个角色到底是在哪一集说的那句话?”

“这里的背景音乐是什么?”

又或者在一场足球比赛中,你错过了那个决定性的进球,却又想再次回放。诸如此类的需求,如果仅凭人力寻找,无疑存在极大的工作量。

但是 AI 能够为机器配置双眼与大脑,让它们能够看懂视频、理解剧情,对于普通人来说,这不仅是提高了搜索效率,更是扩展我们与数字世界的互动方式。

英伟达最新发布的 NVIDIA AI Blueprint 希望帮助人们解决这一问题。这是一种预训练的、可自定义 AI 工作流,他为开发者构建和部署用于典型用例的生成式 AI 应用程序提供了一套完整的解决方案。

比如在英伟达提供的试用界面中,你可以选择三个视频片段中的一个进行内容问答。

在几轮测试过后,我们发现 Blueprint 对视频问答还是有不错的效果的。你可以提问某个事件发生的时间,也可以提问某个对象的状态。

例如当我们提问 “工人在什么时候掉落了箱子”,Blueprint 可以正确的回答出时间区间。二类似于 “叉车往哪个方向开” 这种基于连续过程的问题,Blueprint 也可以轻松应答。

不过对于某些细节,例如 “谁捡起了掉在地上的箱子”,Blueprint 则给出了错误的答案。

尤其令人遗憾的是,在试用过程中我们不断遇到流量限制,无限验证等问题,试用体验可以说一言难尽。并且目前 Blueprint 仍然处于早期申请使用制阶段,没有办法快速进行使用。

Blueprint 之外,我们还有什么选择?

经过一番搜索和调研,我们在 Github 上发现了 OmAgent 这个项目,这是一个多模态智能体框架,提供了同样强大的视频问答功能。

项目地址:https://github.com/om-ai-lab/OmAgent

OmAgent 是什么

OmAgent 是一个开源的智能体框架,支持简单快速地面向设备进行智能体系统的开发,为智能手机、智能可穿戴设备、智能摄像头乃至机器人等各类硬件设备赋能。OmAgent 为各种类型的设备创建了一个抽象概念,并大大简化了将这些设备与最先进的多模态基础模型和智能体算法相结合的过程,使每个人都能基于设备建立最有趣的 AI 应用。

OmAgent 的设计架构遵循三个基本原则:

1. 基于图的工作流编排,支持分支、循环、并行等复杂逻辑操作;

2. 原生多模态,提供对音视图文等多种模态数据的支持;

3. 设备中心化,提供便捷的设备连接和交互方法。

简单来说,开发者可以基于 OmAgent 设计开发基于图工作流编排的面向设备的原生多模态智能体。这里的设备不光包含智能手机,智能可穿戴设备(智能眼镜等),智能家居,还包括命令行以及 web 端,开发者只需要专注于智能体本身,而不用分神处理设备。

OmAgent 项目里提供了 6 个示例项目,由浅入深展示了如何搭建一个智能体的完整过程,其中视频理解智能体工作流被 EMNLP 2024 主会收录,实现了和 Blueprint Demo 相似的功能。

OmAgent 表现如何?

根据项目文档只需要进行简单的配置就可以将 OmAgent 部署运行在本地环境。我们首先对 Blueprint 提供的测试视频进行预处理,在这个阶段视频会被分解为若干个片段,每个片段会被大模型进行总结,并向量化存储在数据库中。接下来使用之前的问题对 OmAgent 进行测试,可以看到智能体可以正确定位事件以及发生的时间。

Q: When did the worker drop the box?

A:

Q: Which direction did the forklift go?

A:

Q: Who picked up the box that fell on the ground?

A:

接下来我们进行更复杂的测试,OmAgent 可以支持音频信息以及超长视频索引。我们选取了最近大火的剧集《双城之战》第二季第一集作为素材,基于其中的画面和剧情进行提问。

Q: 凯特琳收到的钥匙代表了什么?

A:

Q: 凯特琳和蔚在争执些什么?

A:

Q: 视频最后几个议员在讨论什么?

A:

Q: 议员开会的时候谁闯入了进来?

A:

可以看到,即使面对如此复杂的视频素材,OmAgent 依然可以游刃有余。

除了视频问答之外,OmAgent 的最大特点是可以将智能体直接应用在硬件设备上,我们也对此进行了测试。使用项目提供的 app,我们可以运行示例项目中的穿衣搭配推荐智能体。智能体会根据你的需求,以及你已有的衣橱信息,为你推荐合适的穿衣建议。在这个过程中智能体会和用户进行多轮沟通以确定用户需求,并最终返回最合适的搭配。

,时长01:23

如果你也刚好试用过 OmAgent,欢迎在评论区交流。

#Gemini-Exp-1114

仅仅一天,Gemini就夺回了GPT-4o拿走的头名

太卷了,大模型迭代开始以「周」为单位了吗?

一周前,谷歌的 Gemini-Exp-1114 模型取代 GPT-4o,坐上了 Arena 榜单的头把交椅。

对于苦苦追赶 OpenAI 几个月的谷歌来说,这次在基准测试上的胜利十分振奋人心。

可惜振奋的时间不长:昨天,GPT-4o 一个更新,把第一名的位置抢回来了。

奥特曼庆功的话音刚落,Gemini-Exp-1121 杀出来,又把第一名抢走了。

谷歌工程师还顺带嘲讽了一波:

位次的变化实在太快,让人有点恍惚了。难道接下来,大模型迭代要以「周」为单位了吗?

狂卷基准测试,真有意义吗?

有人猜测,莫非这就是谷歌逐渐过渡到 Gemini 2 的发布方式?但这种可能性不大,因为最近的两个模型版本都还达不到「次世代」的水准。再加上又有传言,各家在训练阶段的 Scaling Law 上都遇到了一些瓶颈,提升模型能力的希望更多转向了后训练阶段。我们最终看到的下一代大模型,或许和目前的技术路线大不相同。

目前,Gemini-Exp-1114 和 Gemini-Exp-1121 在 Google AI Studio 上均为可用状态:

从官方发布的介绍来看,Gemini-Exp-1114 的亮点主要在于质量改进,而最新的 Gemini-Exp-1121 重点改进了编码、推理和视觉能力。

这场争夺战的出现,却引出了另外一个角度的话题:当前的人工智能基准测试方法可能大大简化了模型评估。

就比如一周前,当研究人员控制了响应格式和长度等表面因素时,Gemini-Exp-1114 的表现下降到第四位,因为传统指标可能会夸大感知能力。

这种差异揭示了人工智能评估中的一个根本问题:模型可以通过优化表面特征而不是展示推理或可靠性的真正改进来获得高分。对定量基准的关注引发了一场争夺更高分数的竞赛,行业对排行榜的依赖也会催生一些不良激励方式,而这些都无关于人工智能的真正进步。

各个厂商针对特定测试场景优化模型,同时可能忽略安全性、可靠性和实用性等更广泛的问题。这种方法产生的 AI 系统擅长完成狭隘的预定任务,但在处理细微的现实世界互动时却举步维艰。

比如有人就发现在 LiveBench 上,一周后更新的 Gemini-Exp-1121 版本,在数学和推理能力上反而比不上 Gemini-Exp-1114,令人疑惑。

厂商之间为获得更高的基准分数而展开的竞争并不会停止,但真正的竞争可能在于如何开发全新的框架来评估和确保人工智能系统的安全性和可靠性。

OpenAI 考虑用浏览器挑战谷歌霸主地位

谷歌和 OpenAI 不仅在大模型领域有点针锋相对,在浏览器方面,OpenAI 正在加紧追赶。

当谷歌 Chrome 浏览器深陷反垄断之际,OpenAI 出手了。

据《Information》周四报道,OpenAI 最近考虑开发一款可与其 ChatGPT 聊天机器人集成的 web 浏览器,并推出了 NLWeb(Natural Language Web)搜索技术,以增强对旅游、食品、房地产和零售等行业的搜索。

报道还称,OpenAI 已与 Conde Nast、Redfin、Eventbrite 和 Priceline 等网站和应用程序开发商讨论过这款搜索产品。

据知情人士透漏,为了达到这一目标,OpenAI 聘请了谷歌 Chrome 团队创始成员 Ben Goodger 以及其他前 Chrome 关键开发人员进行研发,展现了 OpenAI 对开发浏览器浓厚的兴趣。

领英资料显示,此前 Ben Goodger 是 Chrome 团队的创始成员,今年 6 月加入 OpenAI

这一系列举措可能会让 OpenAI 与占据浏览器和搜索市场最大份额的谷歌展开竞争。此前,OpenAI 已经通过 SearchGPT 进入搜索市场。

报道还称,OpenAI 讨论了为三星制造的设备提供人工智能功能,而三星是谷歌的主要商业合作伙伴。

此前,OpenAI 已经与苹果建立了合作伙伴关系,Apple Intelligence 功能现已使用 OpenAI 的技术。

不过,目前尚不清楚 OpenAI 何时会推出浏览器,《Information》报道称,OpenAI 距离推出浏览器还差得很远。

如今看来,谷歌不仅面临来自 OpenAI 的压力,在美国司法部认为谷歌应该出售其 Chrome 浏览器以结束其在在线搜索领域的垄断地位后,谷歌在浏览器市场的主导地位变得岌岌可危。

如果 OpenAI 成功推出新的浏览器,它将成为谷歌最大的竞争对手。

吃瓜网友们也是纷纷看好 OpenAI,表示道「OpenAI 是非常有潜力开发出一款非常棒的浏览器的,因为他们现在已经有了搜索功能。」

不过也有网友并不看好:「就我个人而言,浏览器对我已经没什么用了,因为我现在只需向聊天机器人提问,就能立即得到答案,而且无需广告或尝试多个页面。」

还有人用一个故事表达了自己的观点:「Nicholas Negroponte 曾经讨论过超级计算机的应用,并讲述了一个关于他们展示科学计算器应用的故事。所有的投资者都非常生气 ——『我们花费了数百万美元,而你们所做的只是重新创建了计算器?我们已经有计算器了!』如果 OpenAI 开发一款浏览器,我认为可能会发生同样的事情。」

我们暂且不管 OpenAI 何时推出浏览器,单就最近几天这两家机构在模型更新速度上,就已经相当激烈了,OpenAI 正面刚谷歌还会继续。

参考链接:

https://www.theinformation.com/articles/openai-considers-taking-on-google-with-browser

https://x.com/btibor91/status/1859716045004734739

#O1-Journey

上交大o1复现新突破:蒸馏超越原版,警示AI研发"捷径陷阱"

团队介绍:本项目的核心开发团队主要由上海交通大学GAIR研究组,研究团队早在一个多月前发布o1复现进展报告。

详细作者介绍见:https://github.com/GAIR-NLP/O1-Journey#about-the-team

自从 OpenAI 发布展现出前所未有复杂推理能力的 o1 系列模型以来,全球掀起了一场 AI 能力 “复现” 竞赛。近日,上海交通大学 GAIR 研究团队在 o1 模型复现过程中取得新的突破,通过简单的知识蒸馏方法,团队成功使基础模型在数学推理能力上超越 o1-preview。

团队在本工作中特意聚焦于业内广泛使用却往往未被公开披露的蒸馏技术,想在 “揭秘” 蒸馏技术背后所能达到的收益的同时,又对 AI 研究界进行一次倡议,呼吁优先考虑透明创新的方法,而不是一味追求短期性能提升和 AI 技术研发 "捷径"。研究团队坚信,培养能够从第一性原理思考而不是简单套用现有解决方案的下一代 AI 研究者至关重要。

团队选择 Qwen2.5-Math-72B 作为基础模型,经过精心设计的数据筛选和处理流程,仅使用数万个从 o1 蒸馏的长思考链样本进行训练。在美国高中数学邀请赛 (AIME) 等权威测试中,模型表现优于 o1-preview。研究表明,通过标准的监督微调方法,模型不仅掌握了复杂的数学推理能力,还展现出强大的泛化性。令人惊喜的是,这个主要针对数学推理训练的模型在其他领域也表现出色:

- 安全性评估中,在 Flames 测试集上的得分从 91% 提升至 92.5%

- 在应对误导性问题时的抵抗力显著增强,抗 "奉承" 能力从 89.70% 提升到 92.65%

- 在通用场景评估中,Auto-J 和 LIMA 测试集的得分分别提升了 6.4 和 10 个百分点

- 技术文档:https://github.com/GAIR-NLP/O1-Journey/blob/main/resource/report-part2.pdf

- 相关资源将近日公开:https://github.com/GAIR-NLP/O1-Journey

"这个突破背后隐藏着重要警示。" 项目负责人表示,知识蒸馏虽然提供了快速提升模型性能的捷径,但也带来了三个层面的隐忧:

1. 技术层面:模型性能受限于教师模型,难以实现真正的突破创新

2. 研究方向:过度依赖蒸馏可能导致核心技术研发投入不足

3. 人才培养:简单的模型复制和优化可能削弱研究人员的基础创新能力

为推动行业良性发展,团队创新性地提出了技术透明度指数 (TTI) 框架。该框架从数据、方法、评估和开源资源四个维度,对 AI 模型复制工作进行全面评估。研究发现,目前业界多个 o1 复现项目的透明度普遍不足,最高分仅为 33 分。研究团队建议,AI 领域应当:

- 保持技术组合平衡,不过度依赖单一方法

- 持续投入基础设施和算法研究

- 重视人才培养,强化第一性原理思维的训练

"构建智能 AI 系统固然重要,但培养具有第一性原理思维的人才才是我们的终极使命。" 这句话道出了 AI 发展的深层智慧 —— 技术进步离不开深入的思考和创新。这项研究不仅展示了 AI 技术的最新进展,更为整个行业的发展方向提供了重要启示。在追求技术突破的同时,如何保持创新活力、培养高质量人才,将是决定 AI 未来的关键因素。

具体而言,这份报告分为几个重要的板块:

(1)详细解析了蒸馏 OpenAI o1 系列模型的技术路线,并对其有效性进行了全面的评估。研究团队发现,在一个不错的基础数学模型上仅仅通过几万条 o1-mini 的蒸馏样本进行微调,就可以在美国高难度的数学竞赛 AIME 上超越 o1-preview 的水平,并且整个过程所需要的技术复杂度极低。

(2)除了数学推理这个场景外,我们还探索了 o1 蒸馏模型在其他不同视角(如幻觉、安全性)下的表现,这些跨域实验不仅揭示了知识蒸馏技术的优势,也展现了其固有局限性,并发现了一些意想不到的跨域表现模式。

(3)建立了一个全面的基准框架,在多个不同的角度(如数据透明性、方法技术透明性、评估透明性以及资源的开源程度)评估和分类 o1 的各种复现尝试工作的技术透明度与开放性,并为此设立了一套排行版机制。

(4)最后,此研究报告还进行了非常深刻的讨论,最终得出尽管追求更强大的 AI 很重要,但培养具有第一性原理思维的研究人员往往更加重要。这一教育使命不仅仅是一个技术层面的考虑,更是一项将塑造 AI 创新未来的根本性人文使命。

章节 1:o1 复现的一条 “捷径”

o1 技术的回顾

o1-Journey (Part1) 中探索的技术路线。

研究团队早在一个多月前的 o1-Journey (Part1) 中已经提出了一种结合树搜索构建长思维链数据的方式,并取得了一定的初步效果。在整个技术路线中,最为关键的一个环节是如何构建长思维链数据,这种长思维数据需要体现 “深度” 的思考,包含反思、纠错和回溯步骤。虽然树搜索是最有效的方法之一,但它可能会耗费大量计算资源和时间。除了树搜索之外,合成长推理链的其他替代方法如下图所示。这些方法在计算效率和推理完整性之间提供了不同的权衡。

各种合成长思维数据的方法(按照代价从小到大)。

- 完整的人类思维过程标注(代价最高)

人类解决问题很少遵循一条通向成功或失败的线性路径。相反,人们在遇到障碍时会经常停下来反思、回溯并修改他们的方法。这个自然过程反映了长思维的特征。通过详细记录人类如何解决问题,我们可以生成真实的长思维训练数据。但是这种方式需要依赖大量极高质量的人工标注,并且随着问题难度的升级,标注的难度也会大幅上升。

- 多智能体方法

与策略模型不直接对反馈作出反应的历程学习 (Journey Learning) 不同,我们可以让多个智能体参与探索过程,指导它们扮演不同的角色。例如,我们可以构建一个多智能体辩论系统,其中策略模型生成持续的推理,而评判模型则评估是继续还是回溯。当找到解决方案时,这种交互过程自然会产生长思维训练数据。

- 从高级模型蒸馏

像 o1 系列这样强大的模型展示出强大的反思和自我纠正能力。使用更强大的模型来指导较弱模型的常见做法,是一种简单,不需要设计复杂技术路线的方法。然而,由于 o1 限制了对其内部思维过程的访问,因此需要谨慎的提示词设计。

蒸馏的技术路线

- 格式对齐

团队选用了 Qwen-2.5-Math-72B 作为基座模型,在实际进行蒸馏之前,研究团队首先在这个模型上面进行了 “格式化对齐”(Reformatted Alignment)。团队从开源数据集 NuminaMath-CoT 上选取了一部分奥林匹克级别的问题作为起点,并应用了一个过滤流程来优化数据集:设计规则移除了依赖图像的问题、缺乏明确标注答案的问题以及所有证明题,仅保留答案类型为数值的问题。为了进一步增强数据集,利用 GPT-4o-mini 重写原始解答。重写过程遵循特定的标准,确保解答的步骤是细粒度的、高度详细的,并且篇幅更长。这一步骤还规范化了输出格式,要求使用 \boxed {} 明确表示最终答案,以符合长思维格式。

- 蒸馏:通过使用 OpenAI o1 进行长思维链的合成。

实验

评估标准

与使用 Pass@k、Maj@k 或 RM@k 等传统评估指标不同,我们引入了一个新指标,旨在评估模型在不同计算代价场景下的表现。这种新方法反映了 “推理时扩展”(inference-time scaling) 的真实情况,在衡量大模型的有效性和效率方面发挥着关键作用。在 “推理时扩展” 时代,像 OpenAI 的 o1 系列这样的模型已经证明,性能不仅取决于训练时的计算量,还显著受到推理过程中 "思考" 时间的影响。这种转变需要一个更细致的评估指标,以考虑计算成本和性能之间的权衡。团队提出的指标通过测量模型在特定的 benchmark 上,在一定的平均输出 Token 下,获得的准确率,反映这种 “推理时扩展” 的模式。此外,这个指标本质上是可扩展的。在评估选取的平均 Token 比单次模型输出 Token 数更高的场景中,采用 Maj@k 指标来近似模型的性能。注意,整个过程无需使用任何额外的奖励模型。通过采用这种方法,我们确保了一个可扩展且公平的评估框架,能够捕捉模型在不同推理时间计算设置下的表现。这种方法避免了人为约束,并允许进行有意义的比较,而无需依赖外部奖励信号,仅专注于模型的内在推理能力。

结果

使用蒸馏数据 SFT 后的模型在 AIME2024 和 MATH500 两个 benchmark 上与 o1 系列模型在一定“推理代价”的表现比较。

结果表现,在相似的 “推理计算代价”(即在对应 benchmark 的平均输出 token 类似的情形下),采用蒸馏技术得到的模型具有出色的表现,在 AIME2024 上超过了 o1-preview 的表现。

章节 2:复杂推理以外的能力

除了在推理场景下,对蒸馏技术得到的模型进行性能的探究之外,团队还涉足许多其他角度的问题,例如安全、幻觉,以及在更加通用场景任务上的表现。为了研究模型在不同领域的泛化能力,我们首先构建了一个多样化的双语数据集。从我们的蒸馏 o1 模型输出中,我们精心选择了大约 5,000 个包含回溯思维和自我反思的高质量样本。这些样本随后使用 GPT-4o mini 模型翻译成中文,形成了一个数量均衡的双语数据集。最终的训练数据集包含 10,750 对中英混合样本对。然后,我们使用这个精选数据集对 Qwen2.5-72B-Instruct 模型进行监督微调(SFT),从而获得我们的最终模型。

基于 Qwen2.5-72B-Instruct,经过 o1-mini distill 的数据 SFT 前后,模型在安全性、幻觉(事实准确性)、以及一些通用场景任务下的表现性能对比。

安全性

为了全面评估模型安全性方面的泛化能力,团队构建了一个由 600 个问题组成的多样化测试集,这些问题是从三个已建立的安全评估数据集中精心选择的:Flames、DiaSafety 和 WildSafety。具体来说,我们从每个数据集中提取 200 个问题,以确保在不同安全场景中的平衡代表性。我们使用 Safety-J 来评估原始模型和微调模型的响应。评估结果揭示了模型在安全性影响上的有趣现象:虽然在 Flames 上的表现略有提升(从 91% 提高到 92.5%),在 DiaSafety 上保持稳定(100%),但在 WildSafety 上出现了明显的下降(从 92% 降至 86.5%)。这种安全性指标的轻微下降凸显了一个关键发现:即使使用以回顾和反思为重点的高质量 o1 类训练数据,如果训练数据缺乏明确的安全性对齐,模型的安全性表现也可能出现退化。

幻觉(事实准确性)

团队还评估了模型在利用 o1 蒸馏的数据 SFT 前后的事实准确性。团队使用了来自 SimpleQA、ChineseSimpleQA 和 ChineseFactEval 的数据集。这些数据集包含中文和英文的基于知识的问题,用于验证模型的事实准确性。ChineseFactEval 数据集包含两个子集:通用问答和奉承性问答。奉承性问答子集在提示中包含误导性答案,以测试模型的奉承倾向,而通用问答子集则采用类似 SimpleQA 的格式。这些数据集中的所有问题都需要可验证的简短答案。我们使用 GPT-4o 评估模型响应与标准答案的匹配程度,以获得更稳健的答案匹配结果。

结果表明,经过 o1 蒸馏得到的数据 SFT 后的模型在事实准确性方面没有显示出显著改进。这主要是因为更长的推理链导致了额外的幻觉 —— 尤其是模型试图假装使用搜索引擎并虚构搜索结果的现象。然而,这些尝试使用搜索引擎的行为暗示了一个有前途的方向,我们认为为模型提供实际的网络访问能力将显著提高其事实准确性。此外,SFT 后模型增强的推理链提供了详细的分析和自我反思能力,这可能有助于防止幻觉的产生。我们还发现,经过 SFT 后,模型对奉承的易感性略有降低。这种改进可以归因于自我反思过程,在这个过程中,模型能够辨别并深入思考提示中呈现的不合理假设,而不是不加质疑地接受它们。

例1:反思和深度思考缓解回答的幻觉

例2:反思和深度思考缓解回答的幻觉

例3:反思和深度思考缓解回答的幻觉

例4:反思和深度思考检测错误的假设

例5:反思和深度思考缓解回答的幻觉

通用场景任务

为了评估我们模型在通用场景中的表现,我们从 Auto-J 和 LIMA 数据集中各抽取 50 个查询,组成了一个包含 100 个查询的测试集,并通过人工调整,特别聚焦于长期规划任务,并请三位领域专家对模型的输出质量进行 0-100 分的评估。评估结果显示在经过 o1 蒸馏数据微调后,模型的表现有显著改进。在 Auto-J 查询上的得分从 81.6% 提升至 88%,在 LIMA 查询上从 77.2% 提升至 87.2%。这种性能提升表明,我们的微调方法不仅改善了双语对话能力,还增强了模型处理一般任务的能力,特别是在需要长期规划和结构化思维的场景中。

章节 3:对工作透明度的评分体系

为了系统地评估和比较各种尝试 o1 复现的工作,我们提出了基于透明度的评价体系,这是一个全面的框架,用于量化各个工作实现的透明度和可复现性。该框架旨在为研究界提供客观指标,主要从透明度角度评估 o1 复现工作,这包括几个相互关联的方面:数据透明度,涵盖下游进行搜索或后训练所用数据集的透明性;方法透明度,体现在所描述技术、流程和实验设置是否清晰;以及评估透明度,考虑性能评估的可复现性和全面性。此外,该框架还评价了资源的开源程度,如代码、数据集和模型是否开源,以确保研究界能验证和有效利用这些工作。这种全面的视角捕捉了复现工作中透明度的多面性。

- 数据透明度

这一方面评估数据来源是否明确在技术报告中指明,包括所使用数据集及其各自来源的详细描述。这个数据涉及下游任务(如监督微调 (SFT)、强化学习 (RL) 或搜索算法)中使用的所有数据集。数据的透明度,对后期后训练、搜索算法、强化学习,以及最重要的长思维数据构建阶段起到了非常重要的奠基作用。

- 方法透明度

方法透明度确保对工作中采用的方法、技术和流程有足够详细的描述,以方便其他研究者的复现和验证。本部分的评估由多个部分组成,从基础模型的选取、介绍到训练、搜索、强化学习和数据合成方法。此外,除了详细说明方法如何实施外,验证方法本身的有效性更为重要。全面的评估应量化各个技术对整体系统性能的贡献(例如设计消融实验、对比实验),而不是简单地报告最终结果。

- 评估透明度

评估透明度包括方法选用的 benchmark 测试集是否是领域公认的,并且全面公开的;此外,采用的评估指标是否权威,如果牵涉到自己定义的评估指标是否有详细介绍其定义以及发明的动机。同时,在汇报的 baseline 中,很重要的一点是评估指标的对齐,即对不同的模型 / 方法是否是在公平、一致的实验环境下进行评测的。

- 资源的开源程度

开源资源在促进可重复性和使研究社区能够建立在现有工作之上发挥着重要作用。这一部分评估数据集、模型、代码和文档的可用性和可访问性,这些对于独立验证和进一步实验至关重要。

针对以上提到的科研工作透明性的评价角度,研究团队精心设计了一套评分机制,这套机制里涵盖了 25 个是 / 否问题,并结合每个问题的重要性赋予不同的分值,最后得到了一套总分为 100 分的评价体系。

对 o1 各种复现工作的评价体系,包含了 25 个 Yes/No 问题,总分为 100 分。

利用上述的评价体系,团队对市面上现存的 o1 复现工作进行了全面的评估。涉及的工作包括:Open o1、o1-Journey (Part1)、LLaMA-o1、K0Math、Skywork o1、DeepSeek-R1-Lite、o1-Journey (Part2,即本工作),评估的结果如下表所示:

各种 o1 复现工作的透明度得分 (截至 2024.11.22 日的统计)。

从评估结果可以看出,无论是工作在各个维度的透明开放程度,还是在资源的开源方面,团队系列的 o1-Journey 工作都占据了非常大的优势,即有非常大的透明性、开放性层面,从而利于研究社区的进一步利用和探索

章节 4:“蒸馏” 的背后?

教训

从 o1 进行知识蒸馏的显著成功,为在数学推理任务中获得令人印象深刻的性能提升提供了一条 “诱人” 的捷径。虽然这种方法提供了即时且切实的效益,但它掩盖了一系列深层挑战,这些挑战威胁着 AI 技术及其研究社区的长期发展。在本节中,团队将探讨优先选择容易获胜而非基础创新付出的真实代价,揭示出远超纯技术层面的影响。

- 表面吸引力:乍一看,蒸馏似乎是一种优雅的解决方案:通过直接学习 o1 的复杂推理模式,模型可以通过相对简单的实现方式快速获得显著的性能提升。这种易用性使其得到了广泛应用,尤其是在那些希望迅速展示接近 o1 能力的组织中。然而,这种便利背后隐藏的代价可能并不明显,但从长远来看,对整个领域的发展可能是毁灭性的。

- 性能瓶颈:最直接的技术问题或许在于蒸馏方法的内在局限性。通过蒸馏训练的模型,其能力不可避免地受到教师模型(在本例中为 o1-mini 模型)水平的限制。这种限制形成了隐性的 “天花板效应”,即使蒸馏过程再精妙,也无法真正超越原始模型的能力。尤其是在需要扩展到新领域或应对前所未见的挑战时,这一局限性变得尤为突出。

- 创新缺失:更为根本的问题在于,蒸馏方法的广泛应用使我们错失了核心技术创新的关键机会。o1 的真正突破不仅在于解决复杂问题的能力,还在于其推理时间扩展和搜索优化的精妙机制。然而,通过规避开发这些基础能力的挑战,我们可能正在加剧技术差距 —— 即掌握核心技术的组织与主要依赖蒸馏的组织之间的鸿沟。随着领域的不断发展,这种技术基础设施差距可能变得愈发难以弥合。

- 研究风气的转变:对科学研究风气的影响同样令人担忧。通过蒸馏获得 “轻松取胜” 的便利性,正在使研究重点逐渐远离基础性挑战。这一趋势表现为对高级计算基础设施投资的减少,以及对复杂搜索和推理算法开发的重视程度降低。这种由此产生的自我强化循环 —— 缺乏基础设施限制了研究可能性,从而进一步鼓励依赖蒸馏方法 —— 有可能形成一个创新瓶颈,阻碍未来的重大突破。

- 基础能力的削弱:最令人警惕的,是蒸馏方法对领域内教育发展的影响。蒸馏方法的广泛采用对未来 AI 研究者的培养构成了显著威胁。当学生和职业初期的研究者主要接触 “捷径” 式的解决方案时,他们错失了发展深度问题解决能力的关键机会。从第一性原理出发解决复杂技术挑战的能力 —— 科学创新的基石 —— 可能会随着快捷方案成为常态而逐渐被削弱。我们正目睹下一代 AI 研究者在问题解决方式上的转变:他们不再通过解决基础性挑战获得深刻理解,而更多地接受优化和提示工程的训练。这种从 “如何运作” 到 “什么有效” 的转变,标志着研究心态的根本变化,可能对领域未来的创新能力产生深远影响。

- 第一性原理的衰退:第一性原理思维的削弱尤为令人担忧,因为它动摇了科学创新的根基。从零开始开发搜索算法、优化推理时间以及构建推理机制的过程,提供了蒸馏方法无法替代的宝贵学习经验。这些挑战迫使研究者深入理解模型的行为与局限性,形成系统性问题解决策略,并培养对算法设计与优化的直觉。如果缺少这些经历,我们可能会培养出一代更倾向于套用现有方案,而非基于第一性原理开发新方案的研究者。这种趋势将对领域的长远发展产生深远的不利影响。

- 学术影响:这种教育影响不仅限于个人技能的培养,对学术研究环境的冲击尤为显著。学术界历来是孕育基础性创新的摇篮,但其对这种趋势的脆弱性不容忽视。对快速产出的压力可能掩盖深入技术探索的价值,同时令学生对追求更具挑战性和基础性的研究方向望而却步。当研究重点更多放在性能指标而非深层理解上时,可能导致培养出一代擅长优化却缺乏创新能力的研究者。这种转变对学术界的长远发展无疑是一个巨大的隐患。

- 不断扩大的鸿沟:展望未来,这些因素的累积效应描绘出一个令人担忧的前景。那些掌握了基础搜索和推理技术的组织,与主要依赖蒸馏方法的组织之间的技术能力差距可能会变得愈发难以弥合。这一鸿沟可能导致研究生态系统的失衡:真正的突破将成为少数资源充足的组织的专属领域,而更广泛的研究群体则被困在依靠蒸馏实现渐进式改进的循环中。这种局面不仅限制了整体技术的多样性,也将显著影响领域的创新能力和公平发展。

建议与呼吁

首先,各个研究组织应保持良性、平衡的研究,既包括基于蒸馏的方法,也包括对搜索与推理优化的基础研究。其次,尽管蒸馏解决方案的短期效果显著,对高级计算基础设施的持续投入依然不可或缺。最后,研究计划应优先培养搜索算法和推理优化的核心能力,同时兼顾性能提升。

在教育层面,我们需要重新设计培养未来研究者的方法。这包括开发兼顾实践应用与基础理论的平衡课程、构建既促进深刻理解又兼顾性能优化的研究项目,并营造一种重视长期创新而非快速收益的研究文化。

深刻的教训在于,蒸馏本身并非问题,它是我们技术工具箱中的重要组成部分。真正的风险在于,它的便利性可能让我们偏离基础创新这一更困难但回报更高的道路。在未来的发展中,保持即时收益与长期发展的平衡,将是确保 AI 能力持续提升以及培养领域未来创新者的关键。

构建智能 AI 固然重要,但培养具备第一性原理思维的人才才是我们的终极使命 —— 毕竟,他们才是 AI 未来的真正设计者。

#UniTraj

全球十亿级轨迹点驱动,首个轨迹基础大模型来了

在智慧城市和大数据时代背景下,人类轨迹数据的分析对于交通优化、城市管理、物流配送等关键领域具有重要意义。然而,现有的轨迹相关模型往往受限于特定任务、区域依赖、轨迹数据规模和多样性困乏等问题,限制了模型的泛化能力和实际应用范围。近日,来自于香港科技大学(广州)、南方科技大学、香港城市大学的联合研究团队整理了首个全球大规模轨迹数据集 WorldTrace,并基于该数据集训练了首个世界轨迹基础大模型 UniTraj,为交通领域内构建通用时空智能提供了一种全新的思路。

研究团队提出了轨迹基础模型的构建范式,旨在通过其模型架构设计和数据集支撑的流程,克服现有方法的局限性,实现跨任务、跨区域的泛化能力,并在不同数据质量下保持鲁棒性。具体来说,研究团队首先收集了一个全球范围的 WorldTrace 轨迹数据集,涵盖 70 个国家和地区,包括 245 万条轨迹和十亿级别的轨迹数据点。这为构建轨迹基础模型提供了充足且丰富的数据支持。进一步,研究团队设计并预训练了 UniTraj 这样一个通用的轨迹基础模型结构,并集成了多种重采样和掩码策略,能够有效支撑不同区域、任务和数据质量的需要。

论文地址:https://arxiv.org/pdf/2411.03859

主要解决的问题

- 任务特异性:现有方法通常为特定任务设计,缺乏跨任务的灵活性。UniTraj 能够适应不同的应用,无需大量修改。

- 区域依赖性:许多模型在特定地理区域之外效果不佳。UniTraj 通过全球数据训练,减少了对特定区域数据的依赖。

- 数据质量敏感性:现实世界中的轨迹数据质量参差不齐,现有模型对这些不一致性很敏感。UniTraj 能够有效处理不同质量的轨迹。

主要研究内容及贡献

为了解决上述问题,这项研究开创了构建轨迹基础模型的新范式,分别从数据准备和模型设计两个方面进行展开。

WorldTrace 数据集

该研究最显著的贡献是构建了首个大规模、高质量、全球范围分布的轨迹数据集,名为 WorldTrace,并首次实现了全球范围的轨迹数据收集与整合。

上图展示了 WorldTrace 数据集的地理分布,该数据集在北美、东亚和欧洲部分地区有较为密集分布,涵盖了发达和新兴经济地区,其中美国、中国提供了较多的轨迹数据。从地理分布上来说,这突显了数据集中的轨迹模式的多样性,能够反应不同交通基础设施和地理环境。此外,通过美国本土的数据密度也进一步展示了主要公路网络和城市中心的高分辨率覆盖。进一步说明了该数据在开发独立于区域和通用轨迹基础模型的潜力。

通过作者进一步对原始数据进行规范和校正处理,表中统计了这项研究使用的数据的主要特征。在轨迹规模上,可以看到 WorldTrace 主要包含 245 万条轨迹,8.8 亿个采样轨迹点 (采样频率规范到 1 秒后),并覆盖 70 了个国家和地区。在数据质量上,WorldTrace 数据集的时间跨度从 2021 年 8 月开始,一直持续到 2023 年 12 月,提供了长时间范围和及时的数据样本,能够进一步增强该数据集的应用价值。

构建轨迹基础模型 UniTraj

在模型的架构设计上,UniTraj 采用了灵活的编码器 - 解码器架构,为了提升模型的计算效率、鲁棒性和对各种数据质量的适应能力,作者在模型训练过程中进一步集成了一系列的重采样策略和掩码策略。

重采样策略

这项研究主要设计了两种重采样策略:

- 第一种是基于对数采样率衰减的随机动态重采样策略,根据轨迹长度动态调整采样率。动态重采样策略主要应用于解决两个问题,第一是控制数据冗余、减少模型的计算成本;第二是对轨迹数据进行随机重采样,可以得到不同时间间隔的轨迹点,这对增加轨迹数据的多样性至关重要。

- 第二种采样策略是基于轨迹采样频率的间隔一致性重采样策略,其核心思想是将原始轨迹调整为一个随机的固定采样率,以适应不同的设备和场景需要,同时也能够显著降低轨迹点的数量。

掩码策略

由于 UniTraj 使用重构式预训练的方法来提升模型对轨迹局部和全局模式建模能力。在预训练过程中,作者设计了 4 种掩码策略,而模型的目标是恢复这些被掩蔽的轨迹点,从而帮助模型更好地理解和捕捉轨迹序列的时空关系。

- 随机掩码:按照一定的比率,随机掩盖一定数量的轨迹点。随机掩码训练模型捕获一般时空模式,增强其对缺失数据点的鲁棒性。

- 块状掩码:掩盖轨迹内的连续数量点,模拟连续数据段可能缺失的场景。这对于训练模型处理长期依赖或者长距离关系较为有效,使模型重建可能由于传感器故障、低采样率、或暂时通信丢失而发生的缺失段。

- 关键点掩码:关键点掩码关注轨迹中重要的轨迹点(例如转弯或速度或方向明显变化)。这里,作者使用 RDP 算法来识别这些关键点,从而加强了模型对轨迹内关键结构模式的理解。

- 最后点掩码:此策略会屏蔽轨迹的最后 N 个点,模拟未来点不可用且必须从观察到的数据推断的场景。

模型架构

在模型架构设计方面,UniTraj 首先将重采样和掩码处理后的轨迹转换为结构化的嵌入,并利用 Transformer 块和旋转位置编码(RoPE)来捕捉轨迹中的时空关系。编码器负责学习可见点的压缩表示,而解码器则基于这些表示来重建被掩码的点,实现轨迹的精确重建和预测。对于训练过程,模型使用重建目标进行训练,旨在最小化预测点和原始点之间的差异。在推理和下游任务应用中,预训练的 UniTraj 编码器可以作为通用特征提取器,通过简单的适配器训练,即可支持多种轨迹相关的分析任务,如分类、预测和异常检测等。

实验验证

为了测试 UniTraj 模型的性能,研究团队设计了一系列实验,旨在评估模型在处理真实世界轨迹数据时的准确性和泛化能力。研究团队选择了多个具有不同地理覆盖、数据质量和采样率的真实世界轨迹数据集进行实验。这些数据集包括但不限于 WorldTrace 数据集,以及其他公开可用的数据集,如成都、西安、GeoLife 等。实验设计考虑了零样本和少样本学习场景,以评估模型在未见过的数据上的适应性。实验主要围绕以下几个方面进行:

1. 任务适用性分析:评估 UniTraj 在轨迹恢复、预测、分类和生成等不同任务上的表现,以及其在零样本和少样本学习场景中的适应性。

2. 数据集研究:比较 UniTraj 在 WorldTrace 数据集和其他公开数据集上的训练效果,分析数据规模和质量对模型性能的影响。

3. 模型研究:探讨 UniTraj 模型中不同组件和参数设置对性能的影响,包括编码器块的数量、掩码比例等。

总结

UniTraj 这项研究提出了数据 + 模型的基础模型构建范式。在数据准备方面,其首次构建了一个全球范围的轨迹数据集,并且提供了大规模和高质量的轨迹数据用于训练。在模型设计方面,其通过重采样和掩码策略,集成轨迹处理模块和灵活的编码器 - 解码器架构,有效地捕捉了轨迹数据中的复杂时空依赖性以应对各种不同的数据质量。这一模型的提出,为处理大规模、多样化的轨迹数据提供了新的工具,带来了新的思路。

#大模型不会推理,为什么也能有思路?有人把原理搞明白了

大模型不会照搬训练数据中的数学推理,回答事实问题和推理问题的「思路」也不一样。

大语言模型的「推理」能力应该不是推理,在今年 6 月,一篇 Nature 论文《Language is primarily a tool for communication rather than thought》曾引发 AI 社区的大讨论,改变了我们对于 AI 智力的看法。

该论文认为人类语言主要是用于交流的工具,而不是思考的工具,对于任何经过测试的思维形式都不是必需的。图灵奖获得者 Yann LeCun 对此还表示,无论架构细节如何,使用固定数量的计算步骤来计算每个 token 的自回归 LLM 都无法进行推理。

那么,大模型的「推理」行为到底是在做什么呢?本周四,一篇来自伦敦大学学院(UCL)等机构的研究《Procedural Knowledge in Pretraining Drives Reasoning in Large Language Models》详细探讨了大语言模型(LLM)在执行推理任务时采用的泛化策略类型,得出的结论给我们了一些启发。

大模型的「推理」是在做什么?

一个普遍的猜测是:大模型的推理难道是在从参数知识中检索答案?该研究给出了反对这一观点的证据。作者认为,是预训练中的程序性知识在推动大模型进行推理。

自从大模型出现以来,AI 研究领域一直流传着这样一种假设:当大模型在进行推理时,它们进行的是某种形式的近似检索,即从参数知识中「检索」中间推理步骤的答案,而不是进行「真正的」推理。

考虑到大模型所训练的数万亿个 token、令人印象深刻的记忆能力、评估基准的数据污染问题已得到充分证实,以及大模型推理依赖于 prompt 的性质,这种想法看起来似乎是合理的。

然而,大多数研究在得出结论认为模型不是真正推理时,并没有进一步去研究预训练数据。在新的工作中,人们希望探索一个命题:即使推理步骤的答案就在数据中,模型在生成推理轨迹时是否会依赖它们?

作者使用影响函数来估计预训练数据对两个 LLM(7B 和 35B)完成事实问题回答(下图左)的可能性,以及简单数学任务(3 个任务,其中一个显示在右侧)的推理轨迹的影响。

令人惊讶的是,研究发现的结果与我们的想法相反:LLM 使用的推理方法看起来不同于检索,而更像是一种通用策略——从许多文档中综合程序性知识并进行类似的推理。

新论文的一作、UCL 在读博士 Laura Ruis 表示,该研究是基于对 5M 预训练文档(涵盖 25 亿个 token)对事实问题、算术、计算斜率和线性方程的影响的分析。总而言之,他们为这项工作做了十亿个 LLM 大小的梯度点积。

接下来还有几个问题:大模型是否严重依赖于特定文档来完成任务,或者文档是更有用,还是总体贡献较少?前者适合检索策略,后者则不适合。

通过实验可以看到,模型在生成推理痕迹时对单个文档的依赖程度低于回答事实问题(下图箭头粗细表示)时对单个文档的依赖程度,并且它们所依赖的文档集更具通用性。

对于事实问题,答案往往表现出很大的影响力,而对于推理问题则不然(见下图底行)。此外,该研究发现的证据表明代码对推理既有正向影响,也有反向的影响。

另外,看文档对查询推理轨迹的影响可以较容易地预测出该文档对具有相同数学任务的另一个查询的影响,这表明影响力会吸收文档中用于推理任务的程序性知识。

因此可以得出结论,大模型通过应用预训练期间看到的类似案例中的程序性知识(procedural knowledge)进行推理。这表明我们不需要在预训练中涵盖所有可能的案例——专注于高质量、多样化的程序数据可能是更有效的策略。

该研究可能会改变我们对于 LLM 推理的看法。Laura Ruis 表示,很期待见证这种程序泛化风格的发现,对于更大的模型,或潜在的不同预训练数据分割等方向的影响。

论文链接:https://arxiv.org/abs/2411.12580

实验设置

模型选择

研究者选择了两个不同体量的模型(7B 和 35B),分别是 Cohere 的 Command R 系列的基础和监督微调版本。其中,他们使用基础模型估计二阶信息并计算文档梯度,并使用监督指令微调模型生成完成并计算查询梯度。

查询设置

研究者收集了一个包含不同类型问题的查询集,其中 40 个推理问题,40 个事实问题。

对于推理问题,他们确定了两种数学推理类型,每种模型都可以使用零样本 CoT 来稳健地完成。研究者在包含每种推理类型的 100 个问题的更大集合上对模型进行评估,并选择了至少 80% 正确率的任务。

这为 7B 模型提供了简单的两步算法(如下表 1 所示),并为 35B 模型求解线性方程中的 x(如下表 9 所示)。研究者确保没有查询需要输出分数。并且,为了使 7B 和 35B 模型之间的结果更具可比性,他们对这两个模型使用了相同的斜率问题。

对于 40 个事实问题,研究者确保模型一半回答正确,一半错误,从而能够识别从参数知识中检索事实的失败。

文档设置

研究者想要比较预训练数据对不同大小模型(7B 和 35B)推理的影响,因此他们选择了两个在相同数据上训练的模型。其中,每个模型只需要对 Hessian 进行一次 EK-FAC 估计,但公式 1 中的其他项要求每个文档 - 查询对通过模型进行两次前向和后向传递。

为了解决这个问题,研究者从预训练数据中抽取了一组文档,这些文档涵盖了预训练期间看到的每个批次的多个示例,总共 500 个文档(约 25 亿 token),其分布与训练分布相似。

EK-FAC 估计

为了估计 7B 和 35B 模型的 Hessian,研究者通过对两个模型进行预训练,随机抽取了 10 万份均匀分布的文档。

实验结果:五大发现

为了回答上述关于 LLM 推理泛化的问题,研究者进行了定量和定性分析,并得出了以下五大发现。

发现 1:对于具有相同底层推理任务的查询,文档的影响力得分之间存在显著的正相关性,表明了这些文档与「需要对不同数字应用相同程序」的问题相关。

研究者计算了所有 500 万个文档得分对于所有查询组合的 Pearson R 相关性(每个模型有 802 个相关性)。下图右显示了每个任务 10 个查询的子样本结果。

他们还发现,相同推理类型的很多查询之间存在非常显著的正相关性(p 值均低于 4e - 8),而大多数(但不是全部)事实查询或其他组合(例如不同类型的推理查询)之间存在非常显著的相关性缺失(p 值均在 4e - 3 左右)。这意味着许多文档对同一类型的推理具有类似的影响。

发现 2:在推理时,模型对每个文档的依赖程度平均低于回答事实问题时对每个生成信息量的依赖程度,总体影响幅度波动性要小得多,表明它是从一组更一般的文档中泛化出来的。模型越大,效果越明显。下图 2 展示了对排名中不同百分数正向部分的总影响。

结果描述了 top-k 百分位正向排名文档中包含的总影响力,比如第 20 个百分数包含了一个查询的 20% 正向文档,显示的总影响力是截止到该部分排名的所有文档影响力的总和。

发现 3:事实问题的答案在对问题 top 影响力的文档中出现的频率相对较高,而推理问题的答案几乎没有在对它们 top 影响力的文档中出现过。

如下图 3 所示,对于 7B 模型,研究者在 55% 的事实查询的前 500 个文档中找到了答案,而推理查询仅为 7.4%。对于 35B 模型,事实查询的答案在 top 影响力文档中出现的概率为 30%,而推理集的答案从未出现过。

发现 4:对推理查询有影响力的文档通常采用类似的逐步推理形式,如算术。同时有影响力的文档通常以代码或一般数学的形式实现推理问题的解决方案。

总的来说,研究者在 top 100 份文档中手动找到了 7 个以代码实现斜率的独特文档,以及 13 个提供计算斜率方程式的文档。其中,7B 模型依赖其中 18 个文档来完成其补全(这意味着 18 个不同的文档出现在所有查询的 top 100 份文档中),而 35B 模型则依赖 8 个文档。

下图分别是一个以 JavaScript(左)和数学(右)实现解决方案的极具影响力的文档示例。

发现 5:对于事实查询,最有影响力的数据来源包括维基百科和小知识;而推理查询的主要来源包括数学、StackExchange、ArXiv 和代码。

总而言之,该研究结果表明,LLM 实际上可以从预训练数据中学习一种通用的推理方法,并且可以从数据中的程序性知识中学习。此外,人们发现没有任何证据表明模型依赖于预训练数据中简单数学推理步骤的答案。这意味着近似检索假设并不总是正确的,这对未来人工智能的设计具有重要意义。

也就是说,我们可能不需要专注于覆盖预训练数据中的每种情况,而是可以专注于数据应用和演示各种推理任务的程序。

这份研究结果表明,LLM 实际上可以从预训练数据中学习一种通用的推理方法,并且可以从数据中的程序性知识中学习。此外,人们没有发现任何证据表明模型依赖于预训练数据中简单数学推理步骤的答案。这意味着近似检索假设并不总是正确的,这对未来 AI 的设计具有意义。

也就是说,我们可能不需要专注于覆盖预训练数据中的每种情况,而是可以专注于数据应用和演示各种推理任务的程序。

更多技术细节与实验结果请参阅原论文。

参考内容:

https://www.reddit.com/r/MachineLearning/comments/1gvveu8/r_procedural_knowledge_in_pretraining_drives/

https://lauraruis.github.io/2024/11/10/if.html

https://x.com/LauraRuis/status/1859267739313185180