Question Difficulty Prediction for READING Problems in Standard Tests

一、基本信息

时间:2017年

会议:AAAI(CCF推荐的A类会议 人工智能与模式识别)

作者:黄振亚等(陈恩红团队)

机构:中国科学技术大学

二、论文五要素

1、论文动机

1.1 背景:

在标准测试(如TOFEL、SAT)中,需要不同难度的试题保证考试的公平。而传统的试题难度评估方法是人工标注和考前组织测试,存在各自的缺点。此外,大量的辅助信息(如学生答题记录、习题文本信息)可用于习题难度预测。

(即作者认为习题的难度和习题的文本信息有关系,因此使用习题的文本对习题难度进行预测。大致的逻辑:测试中需要不同的习题难度——>传统的习题难度评估方法存在缺点——>利用现有的答题记录和习题文本可以实现习题难度自动预测)

1.2 目的:

在组织考试前就需要知道试卷中试题的难度,因此需要预测标准测试中英语阅读题的难度(即习题难度预测)

1.3 挑战:

如何建立一个统一的方式来理解和表达文本材料的多个部分(可理解为:为什么用word2vec,为什么使用CNN)

如何区分文本材料对具体问题的重要性(可理解为:为什么选用attention)

如何消除不同测试中的难度偏差(可理解为:为什么要使用test-dependent损失函数)

英语阅读题:包括TD、TQ和TO。TD为阅读文本(document),TQ为题干(question),TO为选项(option)(如下图)

2、传统方法

2.1 评估习题难度的传统方法:

(1)专家对习题难度进行标注

缺点:工作量大、主观性强

(2)组织人员对试题样本进行试测,然后对试题样本进行稍加修改投入使用

缺点:耗时且耗费大量人力物力

共同点:二者皆存在试题泄露风险

2.2 前人研究-习题难度:

(1)影响习题难度可能因素:

①question attributes and examinees' abilities (Beck et al.1997)

②question attributes(如question types习题类型,question structures习题结构,knoledge depth深度)

(2)试图利用考生从测试中得到的反馈(即成绩)来进行习题难度的评估,并形成了一些心理学理论(如经典测试理论CTT,认知诊断CDA)

2.3 前人研究-NLP领域的文本理解:

注意:作者提出的模型中的最关键的步骤就是对习题文本的理解和表征

(1)language modeling(Smith et al.2015)(即更注重从习题的语法和语义方面出发进行建模,如句子的结构,词汇语法)

(2)neural network(Hermann et al.2015) (即使用神经网络将习题转化为语义表征)

3、主要方法

针对英语阅读理解题的难度预测提出了一个新的模型TACNN(Test-aware Attention-based Convolutional Neural Network framework )

训练阶段:

是一种有监督的方法,ground truth是学生答题的通过率,损失函数用在训练阶段用来调整模型的参数,该文提出了一个test-dependent pairwise loss function损失函数

TACNN的输入:习题的文本信息、习题的难度、测试编号、习题编号(如下图)

测试阶段:

TACNN的输入:习题的文本信息

TACNN的输出:预测得到的习题难度值

模型框架图:(分为四个部分,如下图所示)

①Input Layer:输入层

②Sentence CNN Layer:句子CNN层(模型重点)

作用:从句子语义角度去学习每个习题的所有文本信息。(即将习题中的句子进行表征)

③Attention Layer:注意力层(模型重点)

作用:通过attention机制衡量每个习题中不同文本信息对习题难度的影响

④Prediction Layer:预测层/输出层

4、实验

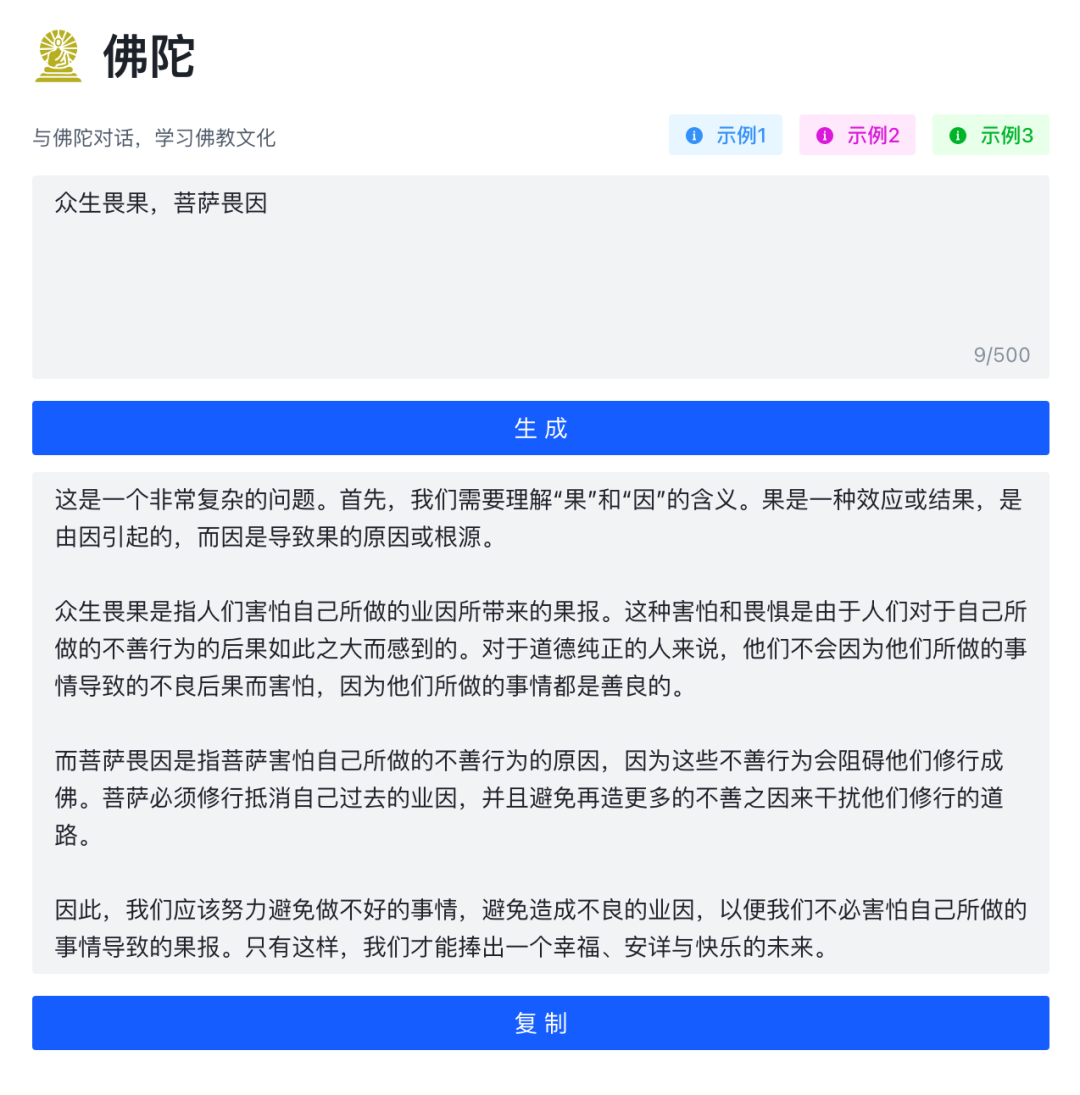

数据集:

来自科大讯飞收集的数据,具体如下图所示,可以看到数据量很大

对比方法:

CNN:使用attention-ignored机制,损失函数用的test-independent损失函数

ACNN:具有TACNN中的attention机制,损失函数用的test-independent损失函数(用于对比TACNN模型中的tetst-dependent损失函数)

TCNN:使用attention-ignored机制,损失函数用的是test-dependent损失函数(用于对比TACNN模型中的attention机制)

HABCNN:以上三种都是与自己提出的进行对比,这个则是和他人的模型比较(他人的模型作者进行了稍加修改为了适用于习题难度预测问题上)。

实验评价指标:

RMSE(Salakhutdinov and Mnih 2011):均方根误差,越小越好,评价习题难度预测值和真实值的准确度对比(注意:预测值是模型在训练阶段训练好后,将测试集的习题放入训练好的模型后得到的习题难度值;这里的真实值是指测试集中的习题难度值)

DOA(Liu et al.2012):一致性(啥玩意?没懂是干嘛的,需要追溯该论文引用的那篇论文),越大越好,从ranking的角度评价?

PCC(Benesty et al.2009):皮尔逊相关系数 ,越大越好,评价习题难度真实值和预测值的相关性

PR:t-test通过率(啥玩意?不懂是啥,需要追溯该论文引用的那篇论文),越大越好,评价confidence performance

实验结果:

5、创新点

三、论文总结

这篇文章提出的模型的前提:习题文本信息丰富、大量的数据(包括习题和学生的答题记录)

此外,这篇文章中得到的习题难度是absolute difficulty values,即绝对难度(区别于相对难度,即某个学生对于某道题的难度)

挑战:

如何建立一个统一的方式来理解和表达文本材料的多个部分——>使用word2vec对习题文本信息的单词进行表征,使用sentence CNN表达习题文本信息中的句子(包括阅读的文章、题干、选项)

如何区分文本材料信息中哪部分对具体习题难度的重要性——>使用attention机制对习题文本信息的重要部分进行关注

如何消除不同测试中的难度偏差——>提出了test-independent的损失函数

(后面继续补充)

最后,发现某个网站上的关于这篇论文的PPT写得挺好的,需要的也可以看看,链接https://myslide.cn/slides/17905