当你和他人谈论人工智能的潜力时,很多人都表露出同样的担心:

害怕被取代

特别在最近几个月,随着生成式人工智能的投资和创新的爆炸性增长,这些不安的感觉更加强烈。

机器学习中相对较新的创新,即扩散模型(diffusion models),使文本到图像的生成变得成熟,也正在人工智能学术界和工业界获取越来越多的关注。续 GAN 之后,大放异彩的扩散模型除了生成图像,还可以生成动作。

比如以色列 Tel Aviv University 在今年 10 月开源的 Human Motion Diffusion Model 项目,人体运动扩散模型,简称 MDM ,就是通过 AI 识别人的骨骼行为模型。

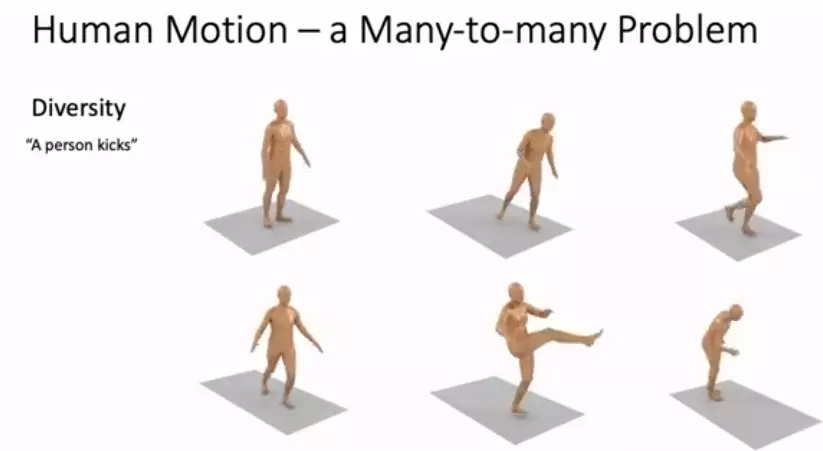

直接上效果~

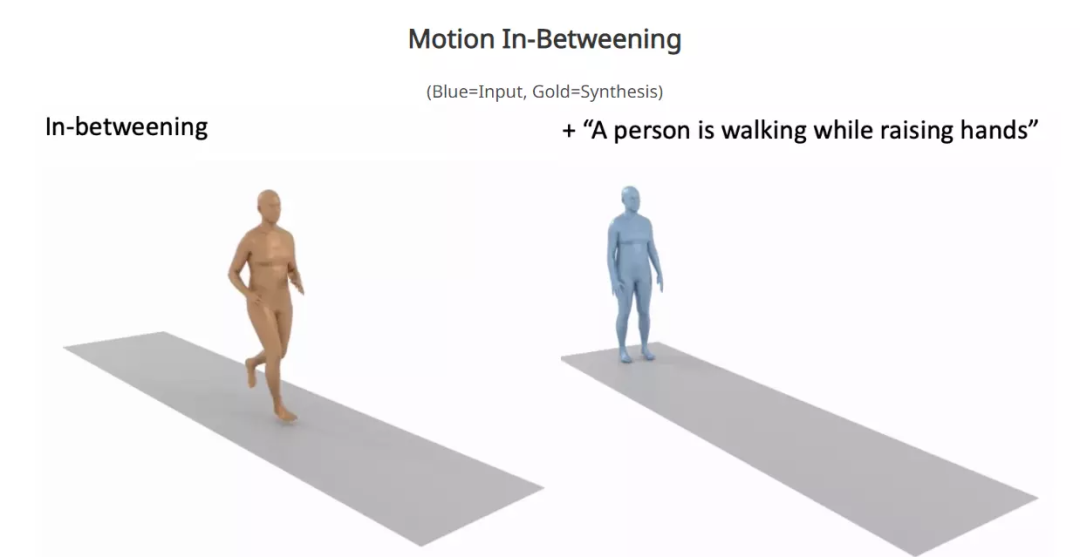

MDM 的功能就是:利用扩散模型

根据文字直接驱动人体三维模型

做出相应的动作

图片来源:MDM

若能被AI扩充那样骨骼识别-肌肉移动-动画视频的创作方式若能实现, MDM 将会极大辅助影视和游戏等行业的工作流。

MDM 有一个通用设计框架,来支持不同形式的条件反射,目前可以实现从文本到运动、从行动到运动和无条件生成的任务。

在文本到运动的任务中,MDM 的模型生成连贯的动作,在人类 ML3D 和 KIT 基准上实现了最先进的结果。

同时也有用户研究表明,人类评估人员在 42% 的时间里更喜欢我们生成的动作而不是真实的动作。

从文本到运动

文本到运动是在给定输入文本提示的情况下生成运动的任务。输出运动预计既要实现文本描述,也要从数据分布中获得有效样本(即遵守一般人类能力和物理规则)。此外,对于每个文本提示,MDM 还期望匹配它的运动分布,而不仅仅是一个结果。

从行动到运动

行动到运动是在给定输入动作类的情况下生成运动的任务,由标量表示。同时,输出的运动也是基于数据集分布反映的自然模型训练。

在此前,无论是游戏还是电影要做特效时,演员需要穿上特制的服装,贴上 marker,在动捕系统的覆盖下完成表演。后期制作时,特效师将采集到的肢体动作和面部表情重定向到虚拟角色中,然后经过不断的后处理让虚拟人的动作尽可能真实。

因此,动作捕捉 + 重定向 + 后处理涉及大量的人工操作,过程十分烧钱。但有了 MDM 这类动作生成模型,就能够快速又真实的生成特定的动作,最关键的是节省不少成本。