AI 编程工具—Cursor进阶使用 Rules for AI

这里配置是给所有的会话和内嵌模式的,你可以理解为是一个全局的配置

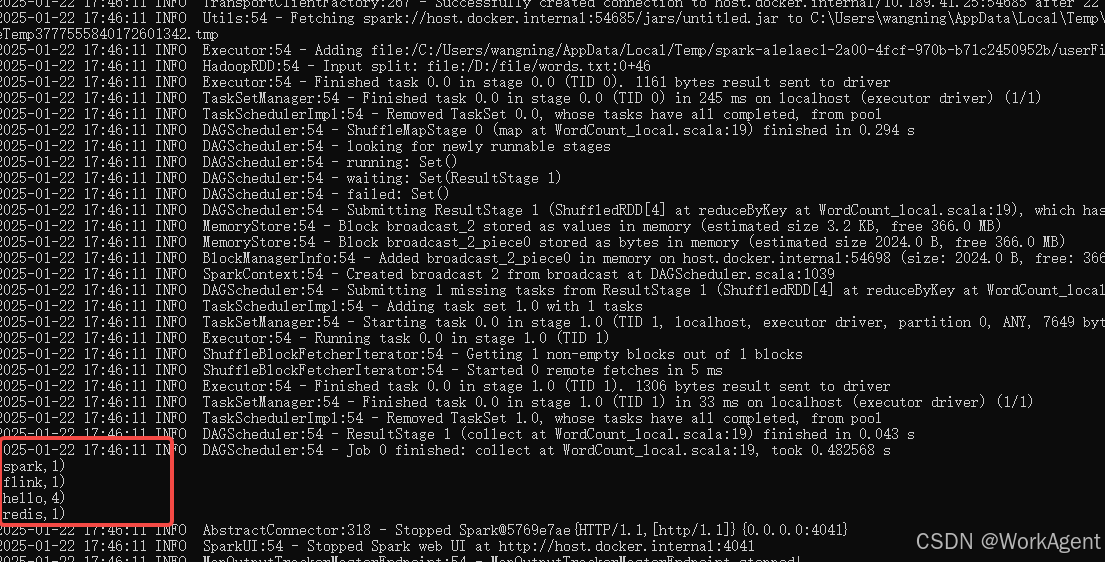

下面的代码是之前Cursor 给我们生成的,下面我们开始配置Rules ,来让Cursor生成的代码更加符合我们的编程习惯

def quick_sort(arr):"""使用快速排序算法对数组进行排序。该函数接受一个数组作为输入,并返回一个新的已排序数组。它使用快速排序算法,这是一种分治算法。它通过从数组中选择一个"pivot"元素并将其他元素分成两个子数组来工作,具体取决于它们是否小于或大于pivot。然后递归地对子数组进行排序。:param arr: 要排序的数组。:return: 一个新的已排序数组。"""if len(arr) <= 1:return arrpivot = arr[len(arr) // 2]left = [x for x in arr if x < pivot]middle = [x fo