NLP_wuenda

1.简介

吴恩达老师在2020年6月份推出了NLP课程,Natural Language Processing Specialization

本人忙里偷闲将老师的视频和作业都完成了,后续会持续更新课程的资料和作业。目前NLP课程一共分为四门,每门课程会分为三(四)周,每周都会有代码测验题目。

- homework_test–是原封不动的将课程资料打包下载,供读者自行完成;

- homework_accomplished–是本人完成的代码测验,基本都是100%通过(但这并不意味着0差错)。

- 由于前两门课程做完测验题目之后才进行的总结,所以没有homework_test,你可以将其当做答案阅览。

2.课程目录

- Course 1: Classification and Vector Spaces in NLP

- Course 2: Probabilistic Models in NLP

- Course 3: Sequence Models in NLP

- Course 4: Attention Models in NLP

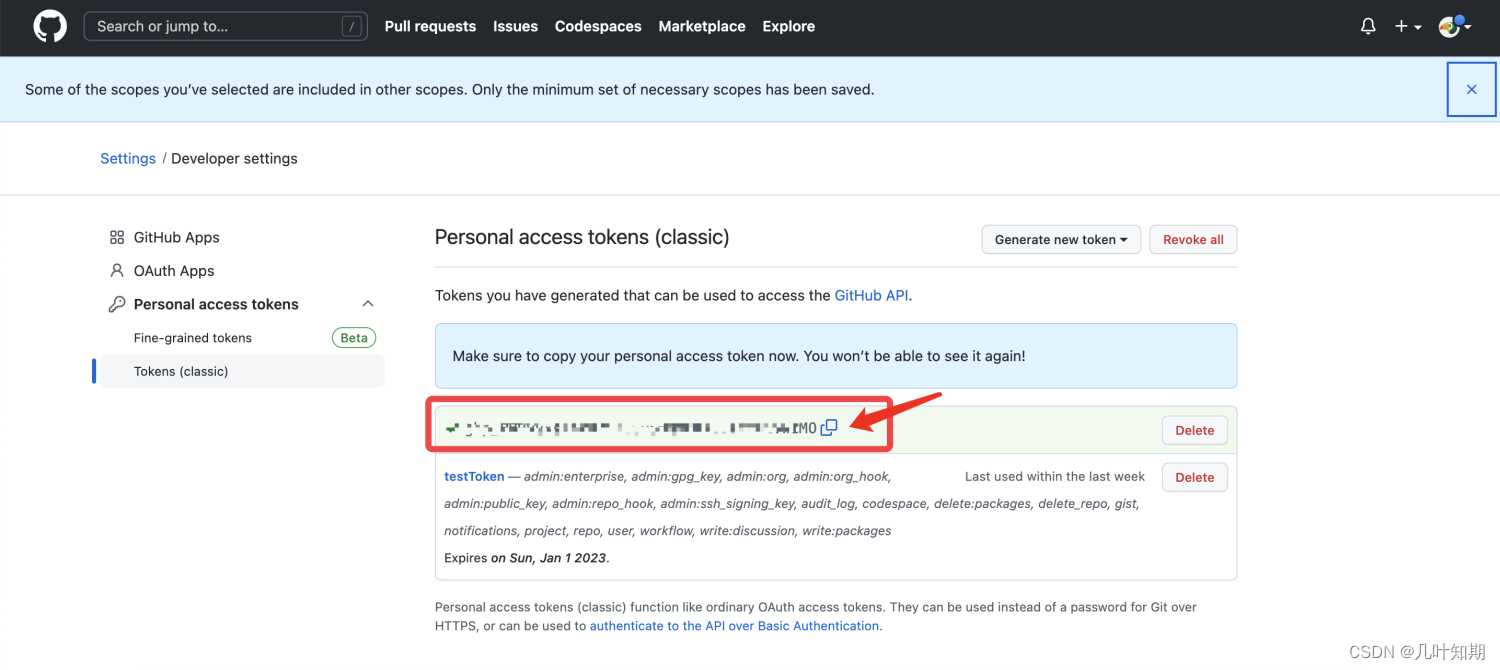

3. Github地址

本人还是初入职场的小白,仓库的知识才刚刚起步,吴恩达老师NLP课程资料的 github 地址如下:

https://github.com/baisechundu/NLP_wuenda

目前课程仅留下第四门课程的最后一周,月底之前将会补齐!如果对吴恩达老师的深度学习课程资料有兴趣的,参见 deeplearning.ai,可以留言,如果确定有人需要深度学习课程的资料,我就贴出自己的深度学习仓库地址哈!

4. Jupyter目录文件打包下载(文件结构一致)

资料中 jupyter 格式的文件较多,都是原汤原味的照搬课程资料的。由于本门课程较多的使用了 Trax 模型,一款基于tensorflow 框架的深度学习库。所以自己在本地运行时可能需要提前配置好环境,目前环境的配置仍在摸索中,后期成熟后会总结。

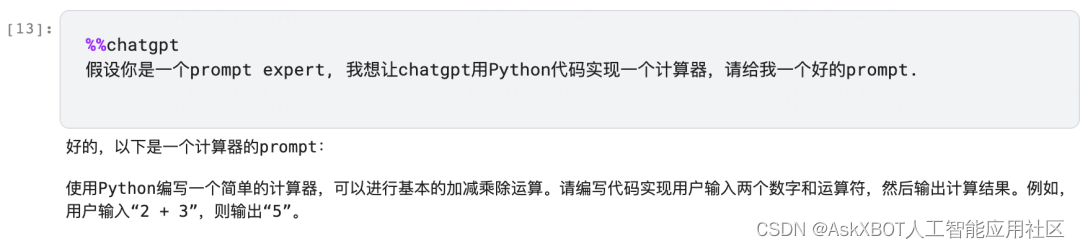

众所周知,吴恩达老师的课堂资料是存放在jupyter notebook 的目录下的,部分目录有很多的子目录,手动下载只能一个个点击。这里提供一个脚本,方便大家批量下载 jupyter notebook 的资料文件,使用方法在代码后面。

import os

import tarfiledef recursive_files(dir_name='.', ignore=None):for dir_name,subdirs,files in os.walk(dir_name):if ignore and os.path.basename(dir_name) in ignore: continuefor file_name in files:if ignore and file_name in ignore:continueyield os.path.join(dir_name, file_name)def make_tar_file(dir_name='.', tar_file_name='tarfile.tar', ignore=None):tar = tarfile.open(tar_file_name, 'w')for file_name in recursive_files(dir_name, ignore):tar.add(file_name)tar.close()if __name__ == '__main__':dir_name = '.'tar_file_name = 'archive.tar'ignore = {'.ipynb_checkpoints', '__pycache__', tar_file_name}make_tar_file(dir_name, tar_file_name, ignore)

- 背景:在学习吴恩达老师的 deeplearning.ai 课程时,课堂代码测验其实是用 jupyter 完成的,所以为了方便自己的调试和教学使用,希望能将课程中提供的代码文件下载下来,但是jupyter 只能选中一条逐个 download ,这样的话费时费力。

- 方法:利用python的 os 库函数,读取文件的目录结构,然后利用 tarfile 读取文件压缩即可。

- 使用:在课程的 jupyter 中,进入文件的根目录 / ,然后创建一个 ipynb 的块,将下面的代码粘贴运行,会发现根目录下面会多出一个 archive.tar 的压缩包。将这个压缩包下载下来,在自己的电脑上解压即可。

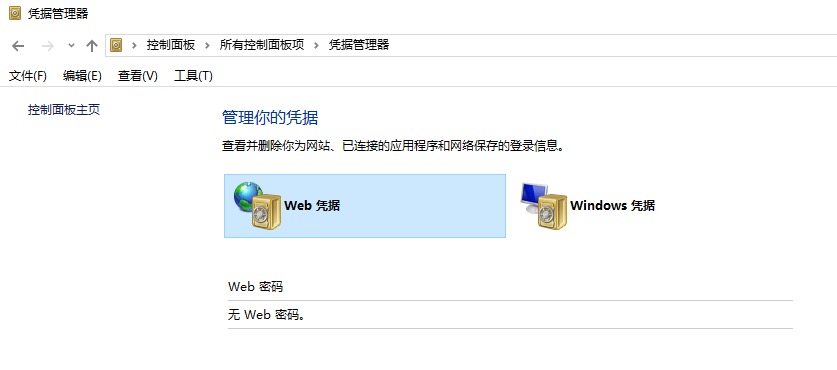

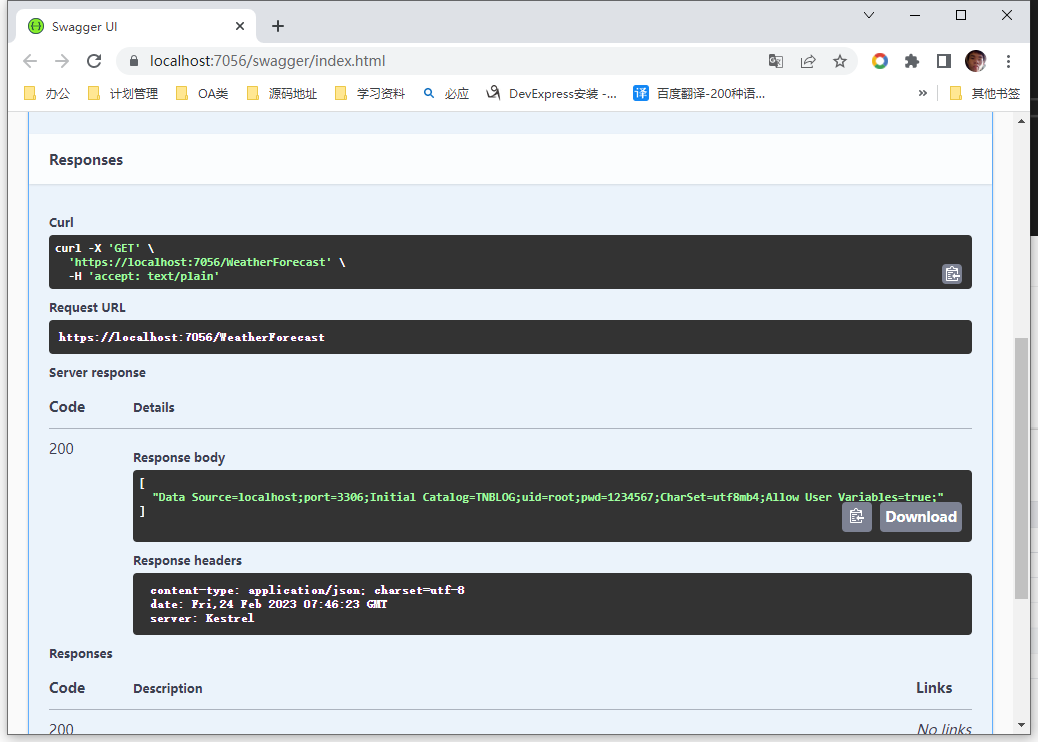

下图就是下载的效果展示