来源:机器之心

人工智能存在「灭绝」级别的风险,未来的系统可能像核武器一样致命。本周二,著名的人工智能学者、科技公司创始人团结了起来,发出呼吁。

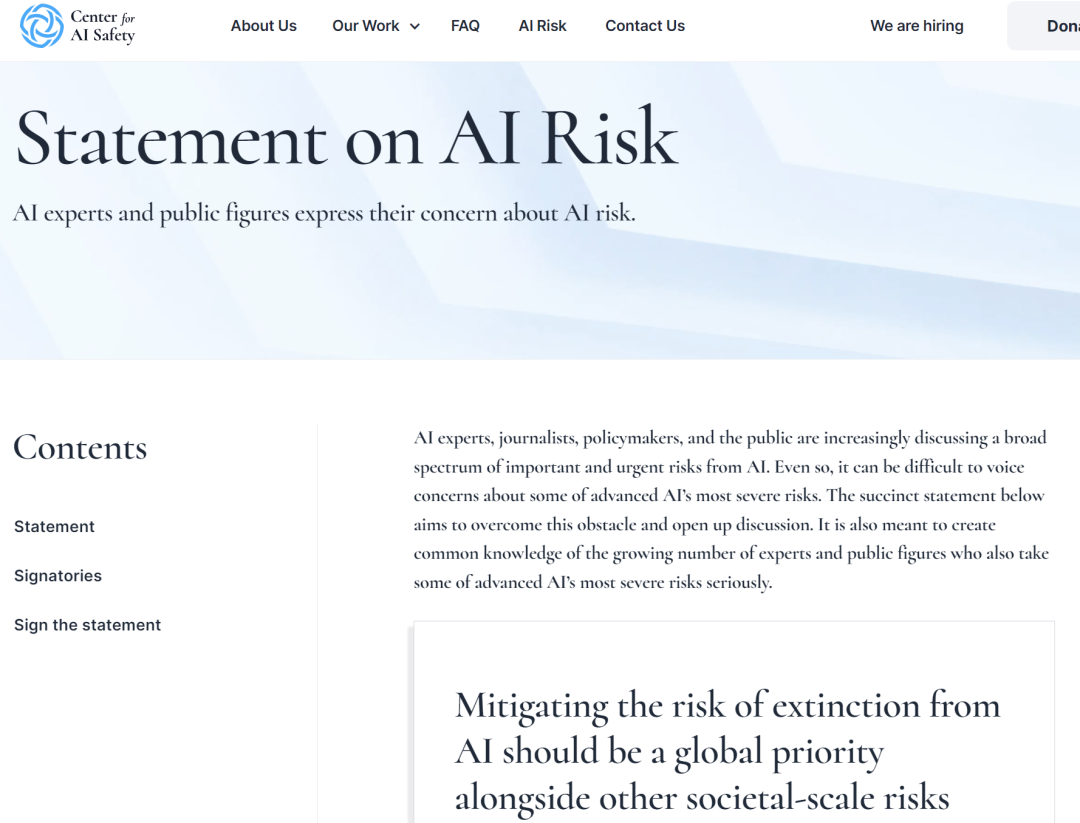

公开信地址:https://www.safe.ai/statement-on-ai-risk

前有马斯克、Bengio 等人发出公开信,叫停 GPT-4 后续 AI 大模型的研发,近期又有 OpenAI 高层发文探讨「超级智能」监管问题,并表示像监管核武器一样监管 AI。AI 可能引发的一系列风险问题正在得到大家越来越多的关注。

一封重要公开信《AI 风险声明》引发了大量的议论。

这封信由非营利组织人工智能安全中心(CAIS)发布,370 多名 AI 专家在信上签名,信中警告称如果对先进人工智能的发展监管不当,可能会对人类构成生存威胁。

本公开信与以往不同,因为其中许多重要签署者在 AI 实验室、大型科技公司担任要职。其中包括图灵奖得主 Geoffrey Hinton、Yoshua Bengio,OpenAI 首席执行官 Sam Altman,Google DeepMind 联合创始人兼 CEO Demis Hassabis,微软首席技术官 Kevin Scott,谷歌副总裁 James Manyika,OpenAI 首席科学家 Ilya Sutskever,GAN 之父 Ian Goodfellow 等都已签名。

部分公开信签署人。

公开信只有一句声明:「减轻人工智能引发的灭绝风险应当与其他社会规模的风险(如大流行病和核战争)一样成为全球的优先事项。」

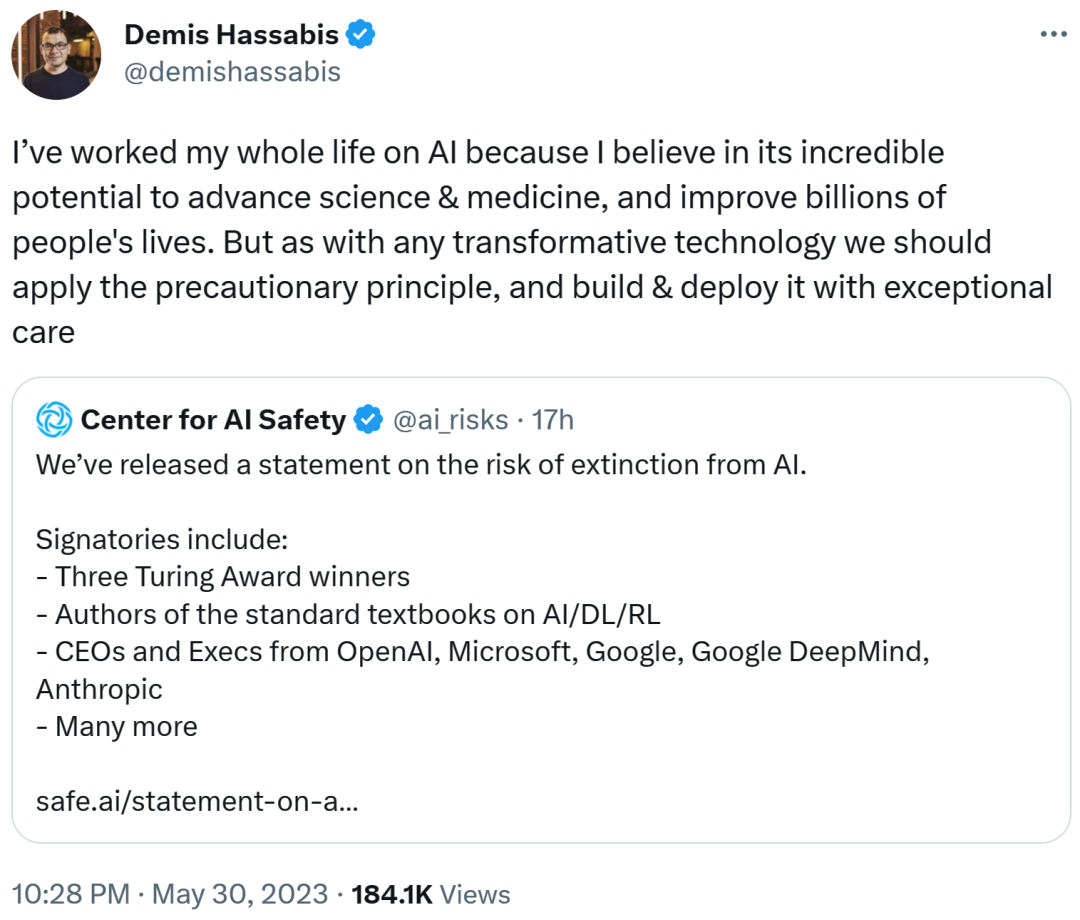

Demis Hassabis 还发表了自己的看法,「我一生都在研究人工智能,相信它在推动科学和医学发展以及改善数十亿人的生活方面具有不可思议的潜力。但与任何变革技术一样,我们应该采取预防原则,并格外小心地构建和部署 AI。」

如今人们越来越担心 ChatGPT 等 AI 模型的发展可能给人类带来的潜在威胁。AI 在不断发展的同时,但相应的监管却迟迟没有跟上。

不过一些 AI 研究者们已经意识到这一点,就在上个月,Hinton 离开谷歌,并表示希望不受公司隶属关系的限制,就人工智能的潜在风险进行坦诚的讨论。

针对 AI 风险的呼吁行动一直进行中

这份联合声明之前也有类似的倡议,3 月底上千名行业领袖和专家签署公开信呼吁至少 6 个月内暂停开发比 GPT-4 更强大的 AI 系统,并警告 AI 的发展对社会和人类构成的潜在风险。当时,马斯克、史蒂芬・沃茲尼克、Bengio 和 Gary Marcus 都在公开信中签名。目前,这份公开信的署名人数已经超过了 31000 人。

公开信地址:https://futureoflife.org/open-letter/pause-giant-ai-experiments/

尽管已经有很多人呼吁对 AI 采取谨慎态度,但行业领导者和政策制定者对负责任地监管和开发人工智能的最佳方法几乎没有达成共识。

本月早些时候,包括 OpenAI CEO Sam Altman、Google DeepMind 联合创始人兼 CEO Demis Hassabis 在内的科技领袖会见了美国总统拜登,讨论了潜在的监管问题。在之后的参议院听证上,Sam Altman 主张政府干预,并强调了先进 AI 系统带来的严重风险以及对解决潜在危害进行监管的必要性。

Sam Altman

在前几天的一篇 OpenAI 博客中,该公司高管概述了负责任地管理 AI 系统的几项建议,包括加强顶级 AI 研究者之间的合作、对大语言模型进行更加深入的技术研究以及建立国际 AI 安全组织等。该声明进一步呼吁采取行动,敦促更广泛的社区就 AI 未来及其对社会的潜在影响展开有意义的对话。

原文地址:https://openai.com/blog/democratic-inputs-to-ai

AI 伦理专家不以为然,不必过分关注假想中的风险

关于对假想中导致世界末日的 AI 风险采取行动,并不是所有人都对这些行业领袖和专家的观点表示赞同,来自机器学习社区的质疑声也是有的。其中,经常关注 AI 伦理的专家对这些不断出现的公开信并不「感冒」。

Hugging Face 的机器学习研究科学家 Sasha Luccioni 将 CAIS 的新公开信看作是耍弄花招。首先将 AI 假设存在风险与流行病和气候变化等非常切实的风险相提并论,这对公众来说非常新鲜且能直达内心。但这也是一种误导,将公众的注意力吸引到未来风险上,这样他们就不会过多地思考偏见、法律问题和许可等当前的有形风险。

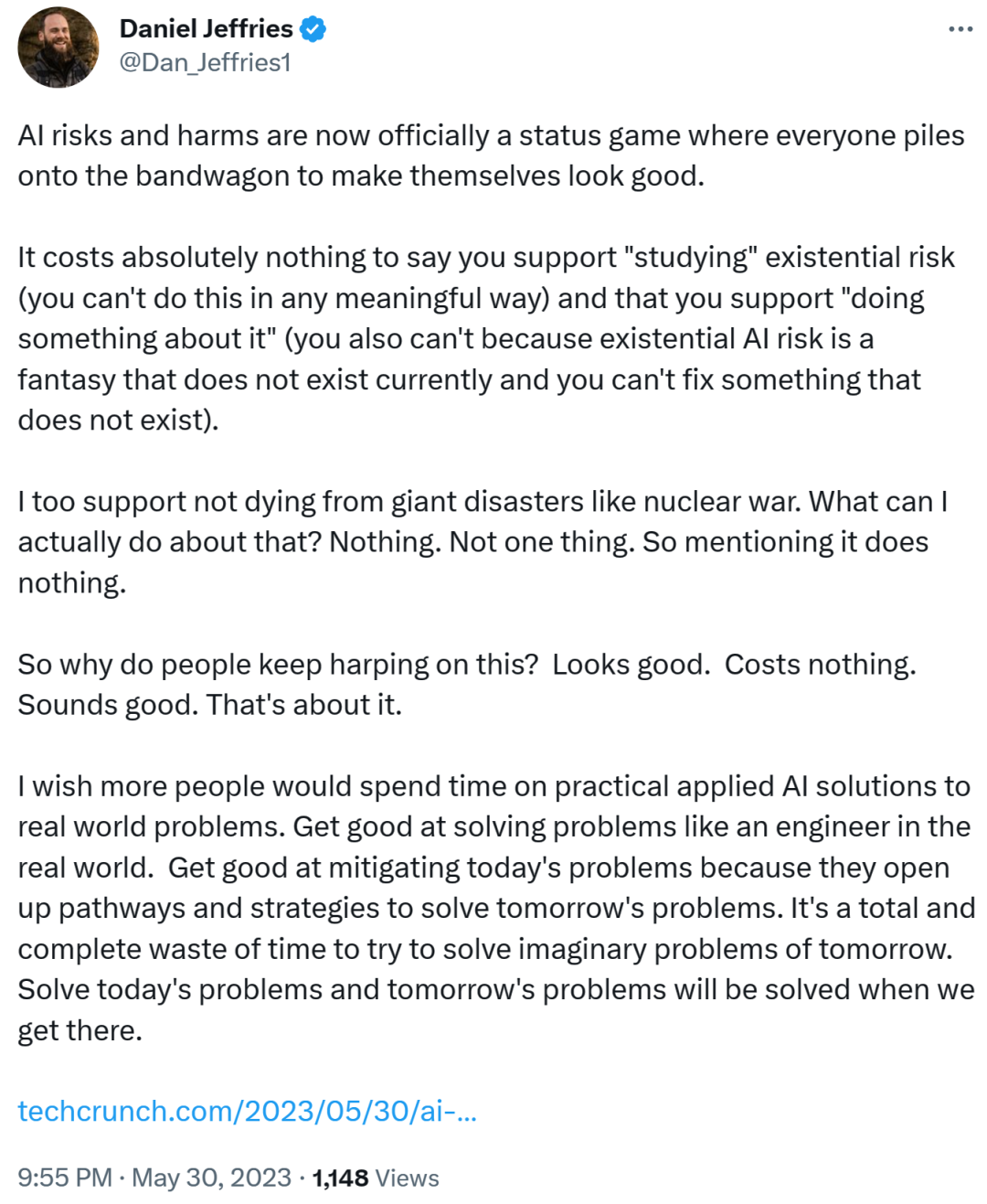

作家、未来学家 Daniel Jeffries 发推表示,「AI 的风险和危害现在正成为一种地位游戏,每个人都挤在这波潮流中让自己看起来不错…… 人们为什么一直在喋喋不休呢?或许是这些呼吁看起来不错、也不花钱。就是这样。」

因此,尽管有朝一日或许有一种先进的人工智能威胁到了人类,但将注意力集中在假想中的不清不楚的世界末日场景上并不富有建设性,也不会产生助益。人们不能老是将精力放在不存在的事情上。

正如 Daniel Jeffries 所言,「试图解决明天想象中的问题完全是浪费时间。解决好今天的问题,明天的问题到时自然而然地就会解决。」

参考链接:

https://venturebeat.com/ai/top-ai-researchers-and-ceos-warn-against-risk-of-extinction-in-joint-statement/

https://arstechnica.com/information-technology/2023/05/openai-execs-warn-of-risk-of-extinction-from-artificial-intelligence-in-new-open-letter/

https://www.nytimes.com/2023/05/30/technology/ai-threat-warning.html

推荐阅读

西电IEEE Fellow团队出品!最新《Transformer视觉表征学习全面综述》

润了!大龄码农从北京到荷兰的躺平生活(文末有福利哟!)

如何做好科研?这份《科研阅读、写作与报告》PPT,手把手教你做科研

奖金675万!3位科学家,斩获“中国诺贝尔奖”!

又一名视觉大牛从大厂离开!阿里达摩院 XR 实验室负责人谭平离职

最新 2022「深度学习视觉注意力 」研究概述,包括50种注意力机制和方法!

【重磅】斯坦福李飞飞《注意力与Transformer》总结,84页ppt开放下载!

2021李宏毅老师最新40节机器学习课程!附课件+视频资料

欢迎大家加入DLer-计算机视觉技术交流群!

大家好,群里会第一时间发布计算机视觉方向的前沿论文解读和交流分享,主要方向有:图像分类、Transformer、目标检测、目标跟踪、点云与语义分割、GAN、超分辨率、人脸检测与识别、动作行为与时空运动、模型压缩和量化剪枝、迁移学习、人体姿态估计等内容。

进群请备注:研究方向+学校/公司+昵称(如图像分类+上交+小明)

👆 长按识别,邀请您进群!