文|卖萌酱

当前人工智能产业迅猛发展,各种场景对AI算力和硬件适配的需求与日俱增。要充分发挥硬件算力的潜能,硬件厂商必须与成熟的AI框架深度适配和优化,从而形成一个软硬一体的AI开发工具栈。

笔者注意到,作为国内市场综合份额第一的深度学习平台,百度飞桨成为了这场合作盛宴的核心。

受深度学习浪潮的带动,人工智能芯片赛道可谓持续爆火。如果说,2020年以前,人工智能概念更多偏重于研究,那么2022年以后,人工智能的概念可谓是应用生态的全面爆发,无论是传统互联网,还是金融、能源、制造、交通等其他行业,都被带入了新一代人工智能技术升级的红利期。

尤其近期在ChatGPT应用破圈的影响下,AI算力的需求被推到了史无前例的高度。甚至有人喊出“得算力者得ChatGPT”的夸张口号。

但是,“囤卡”真的能解决全部问题吗?

相信任何一个AI从业者心里都有个清晰的答案: 不是。

同样是100张A100卡,如果没有强大的中间件——深度学习框架支持,那这100张A100的实际运行算力可能仅能做到理论值的20%甚至更低。底层算子优化、框架计算效率、跨卡通信优化、网络优化、IO优化等,都会极大的影响算力的释放。换句话说,硬件+框架的联合建设才能做到全局最优解。

在刚刚结束的NVIDIA GTC2023大会上,笔者留意了一下,发现大量的议题是跟算力工具和硬件设施优化相关的。其中,百度在GTC2023的主题演讲特别精彩,在此推荐一波:

为什么要这么强调框架+硬件共建呢?

我们知道,在各行各业AI产品大爆发的背后,是百花齐放的AI硬件/芯片底座。可以确定的是,底层硬件设计、框架中间件架构、上层软件系统都在不断的升级变化,因此,各行各业都会面临新硬件新框架适配困难、部署复杂、应用开发困难、算力无法得到充分释放等问题。

而这个问题,对硬件厂商来说也很头疼。

比如,国内某硬件厂商曾经在2019年围绕着Tensorflow 1.x版本展开了大量的研发适配,但到了2020年,新发布的Tensorflow 2.x版本在接口、架构体系上相比1.x版本做了大幅改动,导致该厂此前对1.x投入的成本远未获得相匹配的回报。

因此,可以说,如果实现不了开源深度学习框架与AI芯片、计算系统的联合优化,那么硬件厂商将不得不增加额外的研发成本和资源消耗,整个上层的AI应用生态的爆发速度和进化效率都会受到严重掣肘。反之,则是一个多赢局面。

解决问题的关键

在上面的问题中,开源深度学习框架则是实现硬件跨平台统一、高效发挥硬件性能并支撑上层各类AI应用开发的关键软件平台。因此,要解决上述问题,释放AI生态的潜力和行业赋能效率,那么就需要一个强有力的深度学习框架来作为纽带,带动上下游联动优化,实现AI算力和工具链效率的极致优化。笔者注意到,作为国产深度学习框架担当的百度飞桨,在去年5月份,其携手NVIDIA、Intel、瑞芯微、Arm、Imagination等国内外硬件厂商联合发布 了 “硬件生态共创计划” ,笔者认为,这正是问题破局的关键点。

飞桨硬件生态共创计划

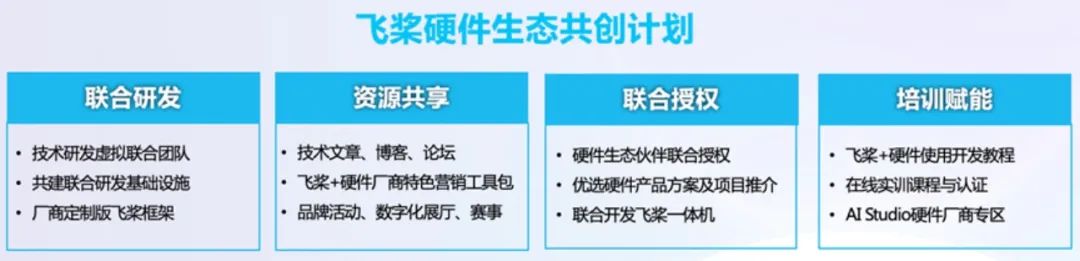

一句话来解释这个计划—— 飞桨“硬件生态共创计划”是面向飞桨硬件生态伙伴的合作计划,主要包含联合研发、资源共享、联合授权、培训赋能四项重点工作,旨在协同战略合作伙伴软硬一体全面共创,聚生态之力,促进人工智能产业繁荣发展。

飞桨硬件生态共创计划,犹如一场AI产业界的盛大狂欢,让国内外的硬件厂商们齐心协力,共同打造一个软硬协同的全栈式人工智能平台。这个生态计划不仅有利于解决硬件厂商在AI框架适配上的实际需求和硬件市场份额提升,还可以为企业和开发者提供更高效、稳定、可靠的一站式AI服务,进而为下游的AI应用生态的爆发提供坚实、稳定、高效的生产力后盾。

这项计划不仅有助于解决各大硬件厂商在适配AI框架时可能面临的技术和投资失误问题,而且将大大提升人工智能产业链的协同效率,最终这份效率提升会传导至消费端,进而创造巨大的社会和经济价值。

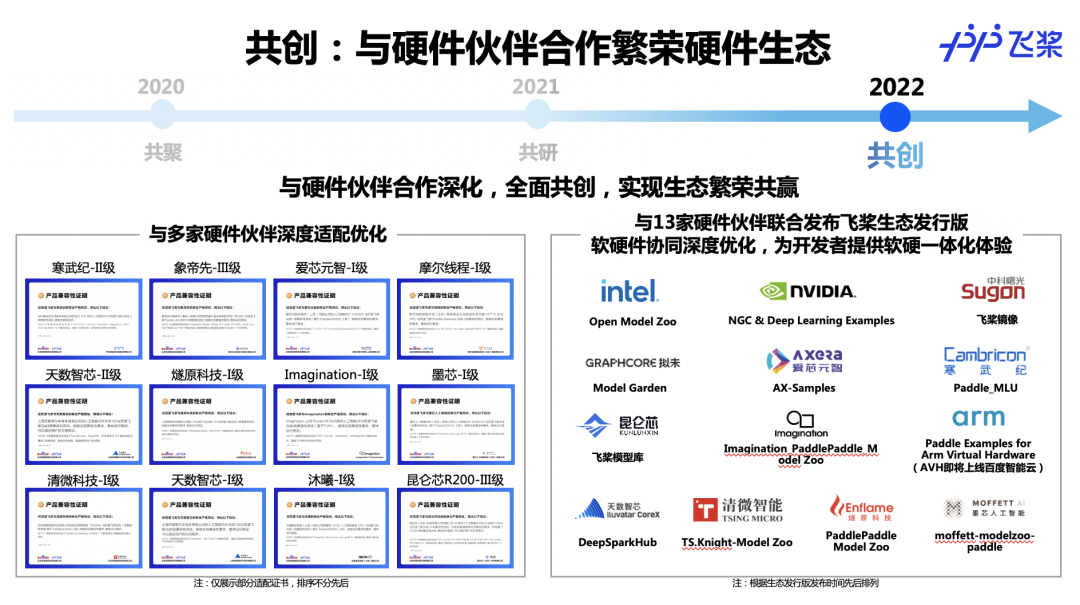

据笔者了解,这个计划已经产生了许多突破性的成就:已经有超过40家硬件厂商与飞桨深度融合优化,29家企业成为了这项计划的核心成员,其中有13家已经推出飞桨生态发行版。

从2020年到现在,飞桨与硬件伙伴合作已经经历了“共聚”、“共研”、“共创”三个阶段。从开始的解决成本收益权衡和如何共建生态的问题,到后续解决厂商软件栈不统一引发的适配难度和接入成本问题,再到去年与硬件伙伴联合推出飞桨生态发行版,共建模型库,实现生态繁荣共赢,可以说每一步都挑战重重,但最终的结果都是硕果累累。

在这个发展过程中,飞桨与众多硬件厂商如NVIDIA、Intel、瑞芯微、Arm、Imagination、昆仑芯等紧密合作,通过技术的联合研发和生态共建,不断取得突破,共同推动了人工智能产业链的高质量发展。

以百度飞桨与NVIDIA围绕硬件生态展开的合作举例

一方面,作为全球领先的GPU硬件厂商,NVIDIA持续为飞桨的开发者做训练推理优化——比如在数据处理方面,NVIDIA帮助飞桨集成 DALI;在大规模训练方面,支持各类数据和ASP、CUDA等算子函数API;在优化推理方面,开发了Paddle-TRT,Deep Learning Examples;在规模部署方面,集成了NCCL,开发了Triton PaddlePaddle Backend等。

另一方面,其与飞桨经常与开发者交流,进而发现生态共建过程中暴露的问题。

比如在一次交流中,就发现了飞桨用户遭遇的一个痛点——如果用户希望使用 NVIDIA 最新软件栈进行开发、训练、部署,那就需要做大量的手动配置工作,这对不少用户而言是一个巨大的工程挑战。

受本次交流的启发,NVIDIA便与飞桨联合开发了 NGC飞桨容器(NGC PaddlePaddle Container),其将最新版的飞桨框架与最新的 NVIDIA 的软件栈进行了无缝的集成与性能优化,最大程度地释放飞桨框架在 NVIDIA 最新硬件上的计算能力。

具体来说,这个容器,不仅能够适应各种硬件环境,从裸机到虚拟机、K8S、X86、ARM、Power、云等等,其广泛的适应性让开发者无惧环境变化。而且,NGC飞桨容器还经过了众多专业团队的优化与调试,进而具备了强大的计算性能,让飞桨平台在NVIDIA最新硬件上能发挥出越来越强大的计算性能。

可以说,NGC飞桨容器充分挖掘了NVIDIA GPU的潜力,为飞桨用户提供了一个“一站式”的AI开发环境,让开发者无需担心硬件兼容性与性能问题。这样,开发者便能更加专注于自己的创意和应用本身,实现性能极致又高效便捷的AI训练推理体验。

目前,NGC飞桨容器已上线到百度飞桨官网和英伟达官网:

https://www.paddlepaddle.org.cn/documentation/docs/en/install/install_NGC_PaddlePaddle_ch.html

https://catalog.ngc.nvidia.com/orgs/nvidia/containers/paddlepaddle

除此之外,还不得不提一个工业级的模型库——NVIDIA Deep Learning Examples。

NVIDIA GPU 的开发者能通过这个模型库,快速复现极致精度和高性能的模型。既包括了机器人、数字孪生、金融等行业模型,又包含了ResNet50等学术研究模型。感兴趣的小伙伴可以在如下页面查看

详情:https://developer.nvidia.com/deep-learning-examples

一些畅想

对于不同的硬件厂商和开发者而言,有了飞桨这个强大后盾,他们可以更好地应对市场需求和技术挑战,共创一个应用广泛、性能优越的人工智能平台。飞桨硬件生态共创计划不仅为行业提供了一个全新的发展蓝图,更为整个人工智能产业打开了诸多无限可能。

对于整个人工智能产业链而言,行业效率的提升将大大促进下游应用的爆发,这份价值最终将反馈给全社会。

百度飞桨的硬件生态,或许将成为中国AI行业腾飞的有力基础。

后台回复关键词【入群】

加入卖萌屋NLP、CV、搜推广与求职讨论群