ChatGPT,这款被许多人誉为语言处理领域的“黑马”,究竟能否应用于撰写科研论文?近期,以色列理工学院生物学家兼数据科学家Roy Kishony带领的团队,针对这一问题进行了系列研究,其结果已在《Nature》杂志上发表。让我们一起来看看这项发人深思的研究。

实验历程

在实验的初步阶段,Kishony教授和研究生Tal Ifargan开发了一种自动化系统,这个系统就像一个专门的导师,逐步引导ChatGPT完成一篇科研论文的撰写。他们使用的数据来自美国疾病预防控制中心的一个公开数据集,这个数据集包含了25万人关于运动习惯、饮食情况以及糖尿病状态的健康数据。

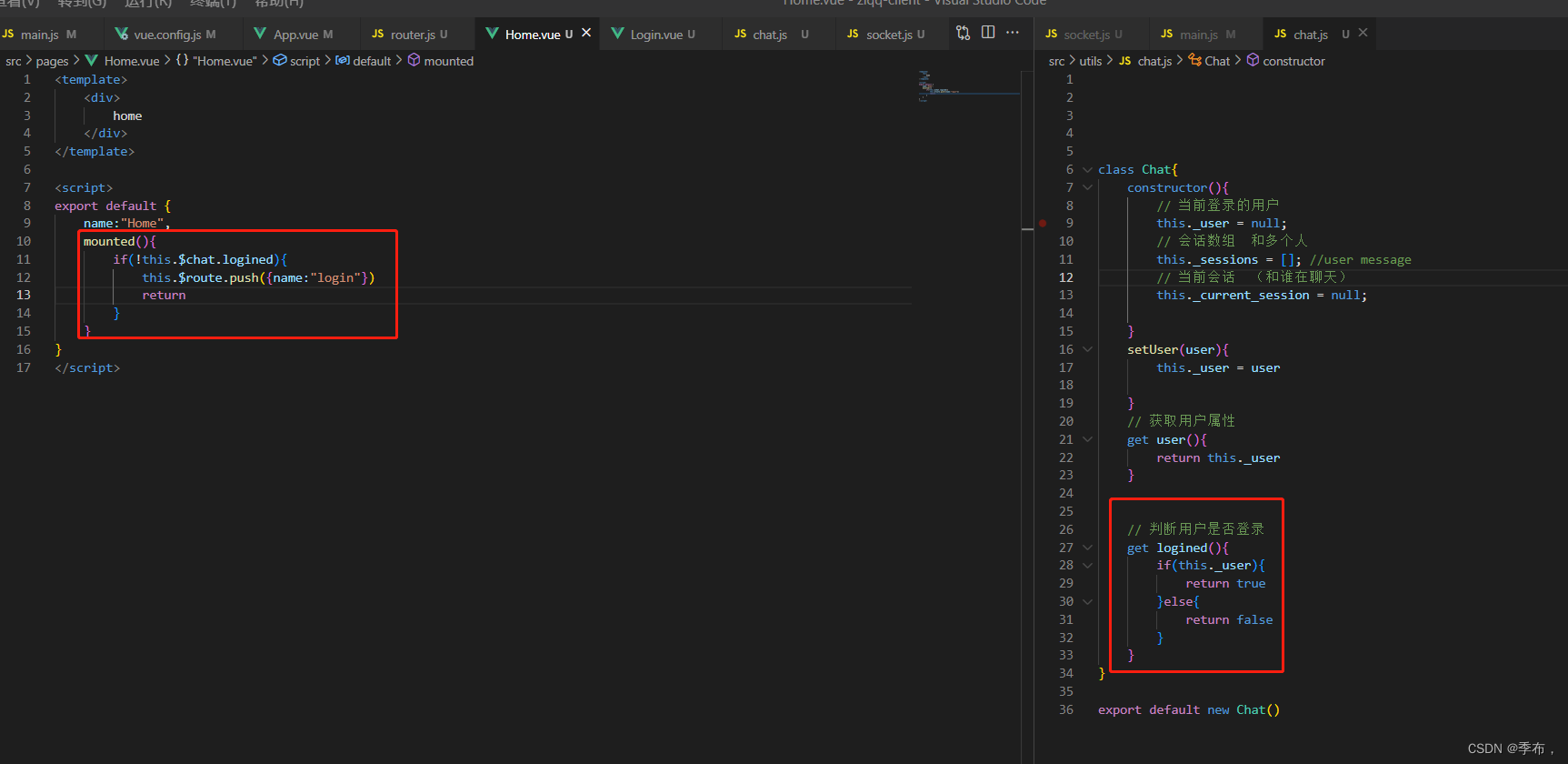

然后,系统开始运行,让ChatGPT开始编写数据探索的代码。ChatGPT第一次尝试时出现了错误,但当系统反馈了这些错误之后,ChatGPT成功地修复了代码。之后,ChatGPT在系统的引导下,确定了研究目标:探索运动和饮食如何影响糖尿病的风险。接着,它根据自己提出的数据分析计划,编写了分析代码,并生成了结果。

有了这些结果后,系统进一步引导ChatGPT代写论文。为了保证文献的准确引用,他们还特意为ChatGPT开通可以访问文献搜索引擎的权限。最终,ChatGPT完成了一篇研究论文。

实验结果

然而,尽管ChatGPT完成的这篇论文在表面上看起来十分完美,但在更深入的审查后,研究团队发现了一些值得关注的问题。

例如,ChatGPT在论文中声称该研究“填补了文献中的空白”——这是科研论文中常见的说法,但在这个具体的案例中,这个表述并不准确。实际上,它所探讨的关于饮食、运动与糖尿病风险之间的关系并没有为现有的医学研究带来新的启示。

Kishony教授还指出,ChatGPT的这种应用还可能会干扰科研团队的实验结果。比如,科学家们在进行科学实验时,常常会针对一个数据集做出多个假设,但ChatGPT的数据分析可能会只报告那些产生显著结果的假设。这种行为可能会诱导科学家们在研究中忽视重要信息,从而影响最终的实验结果。

另外,值得注意的是,ChatGPT这种可以自动生成论文的AI工具的应用可能会导致学术期刊充斥着大量质量低下的论文。

因此,尽管ChatGPT展示出了撰写科研论文的能力,但AI工具还尚不能取代科研人员的研究分析,甚至不合理的利用还可能会干扰研究结果。AI工具在科研领域的应用和实践问题还有待研究和优化。尤其是,如何防止AI“捏造”数据或引用,以及如何保证其产出的论文质量,都是亟待解决的问题。

![[NLP]LLM高效微调(PEFT)--LoRA](https://img-blog.csdnimg.cn/ca73a8eb85aa43b782100ca6210f34e9.png)