在 Taichi 中模拟一维波场,通常是利用 Taichi 编程语言的特性来对一维空间中的波动现象进行数值模拟,以下是相关介绍:

原理基础

- 波动方程:一维波动方程的一般形式为

,其中 u(x,t) 表示在位置x 和时间t 处的波的状态(比如位移、压力等),c 是波的传播速度。

- 数值求解方法:常用的方法有有限差分法等。将空间和时间进行离散化,把连续的波动方程转化为离散的方程组来求解。例如,在空间上把一维区域划分为许多等间距的网格点,在时间上也进行等间隔的采样。通过离散化后的方程,利用已知的初始条件和边界条件,逐步计算出每个网格点在不同时刻的波的状态。

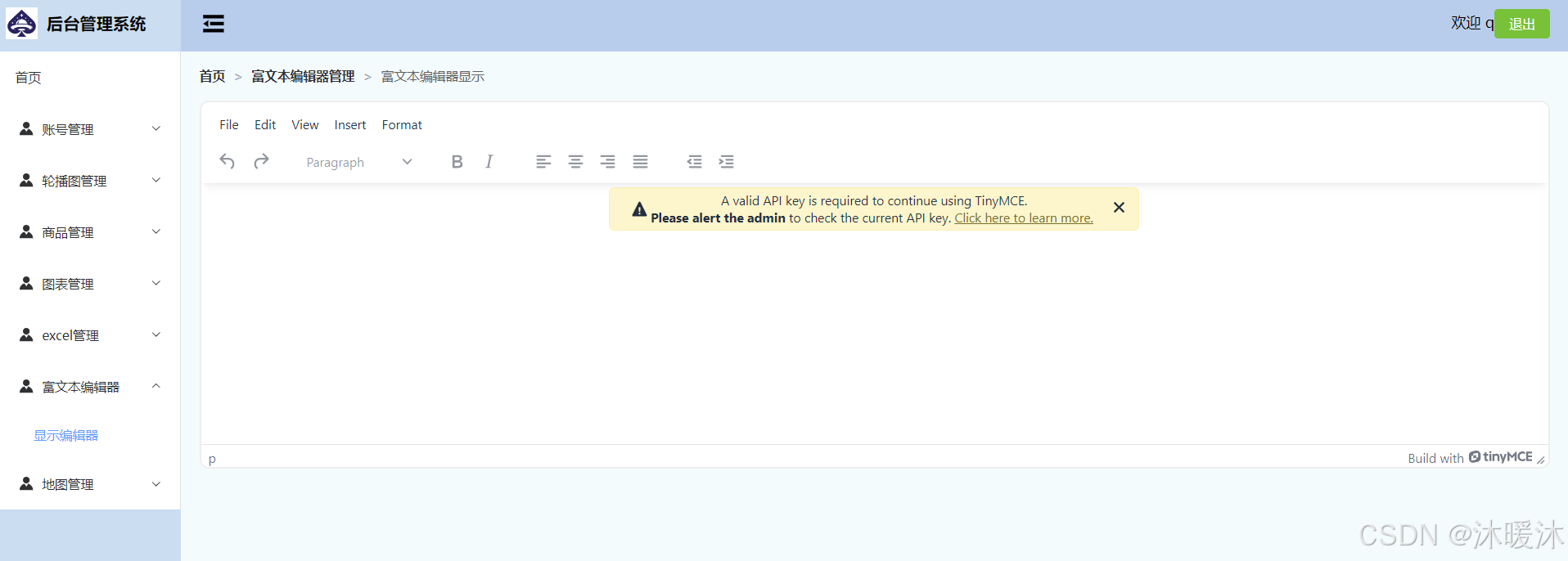

代码实现示例

以下是一个简单的用 Taichi 实现的一维波动方程的模拟代码:test_taichi_1d.py

# -*- coding: utf-8 -*-

""" taichi 模拟一维空间中的波动现象 """

import taichi as ti# 初始化 taichi

ti.init(arch=ti.cpu) # 使用 CUDA 后端,用 ti.cuda# 定义模拟参数

n = 512 # 空间网格点数

dt = 1e-4 # 时间步长

dx = 1.0 / (n - 1) # 空间步长

c = 0.1 # 波速

steps = 2000 # 模拟步数# 定义 taichi 场

u = ti.field(dtype=ti.f32, shape=n) # 当前时刻的波场

u_prev = ti.field(dtype=ti.f32, shape=n) # 上一时刻的波场

u_next = ti.field(dtype=ti.f32, shape=n) # 下一时刻的波场# 初始化边界条件和初始条件

@ti.kernel

def initialize():for i in range(n):u_prev[i] = 0.0u[i] = 0.0if 0.25 < i * dx < 0.35:u[i] = ti.exp(-((i * dx - 0.3) ** 2) / 0.01)# 执行一步时间迭代

@ti.kernel

def update():for i in range(1, n - 1):u_next[i] = 2 * u[i] - u_prev[i] + (c * dt / dx) ** 2 * (u[i + 1] - 2 * u[i] + u[i - 1])# 更新边界条件u_next[0] = 0.0u_next[n - 1] = 0.0# 进行模拟

initialize()

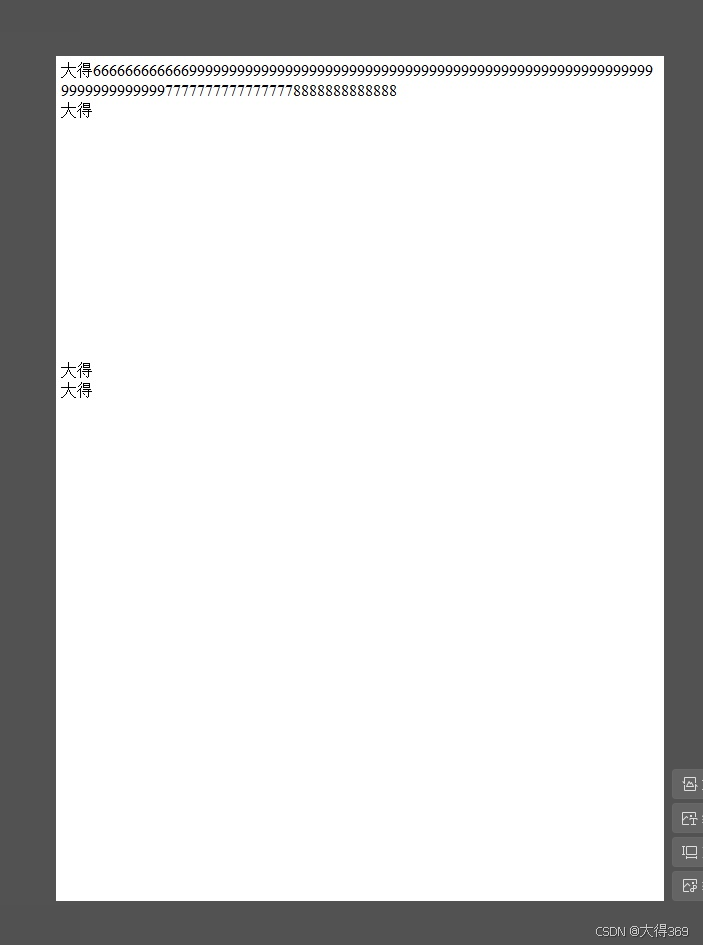

for step in range(steps):update()# 更新波场u_prev, u = u, u_next# 打印结果

for j in range(n):if u[j] != 0.0:print(j,u[j])

运行 python test_taichi_1d.py

在上述代码中,首先初始化了 Taichi 环境和一些模拟参数,包括空间网格点数、时间步长、空间步长、波速和模拟步数等。然后定义了三个 Taichi 场 u、u_prev和u_next,分别表示当前时刻、上一时刻和下一时刻的波场。通过initialize函数初始化了波场的边界条件和初始条件,在这个例子中,初始条件是在空间的一个小区域内设置了一个高斯分布的波峰。update函数实现了根据波动方程进行一步时间迭代的计算,最后通过循环进行模拟,不断更新波场。