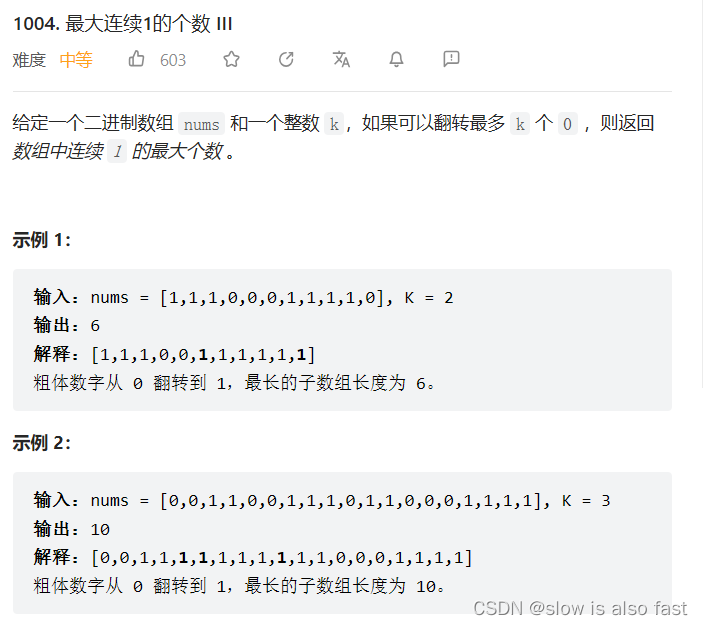

一、说明

在上一篇博客中,我们讨论了原版RNN架构,也讨论了它的局限性。梯度消失是一个非常重要的缺点,它限制了RNN对较短序列的建模。香草 RNN 在相关输入事件和目标信号之间存在超过 5-10 个离散时间步长的时间滞时无法学习。这基本上限制了香草RNN在许多实际问题上的应用,特别是NLP,因为句子中的单词数量通常远远超过10个。

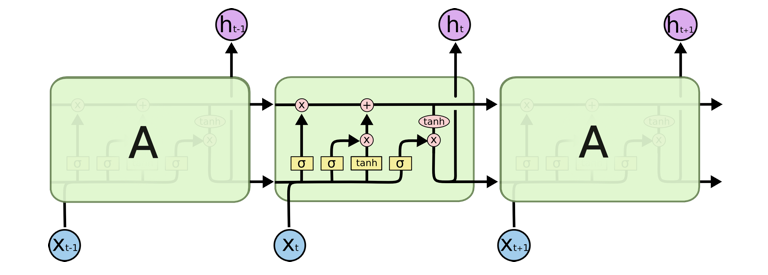

长短期记忆(LSTM)是一种流行的循环神经网络架构的更好变体,专门设计用于解决梯度消失问题。LSTM调整了RNN循环单元的内部结构,为消失梯度带来了解决方案。 LSTM 在翻译和序列生成方面的应用取得了巨大成功。在这篇博客中,我们将讨论 LSTM 的神经架构。如果您不熟悉RNN,请参考我之前的博客。

二、神经架构

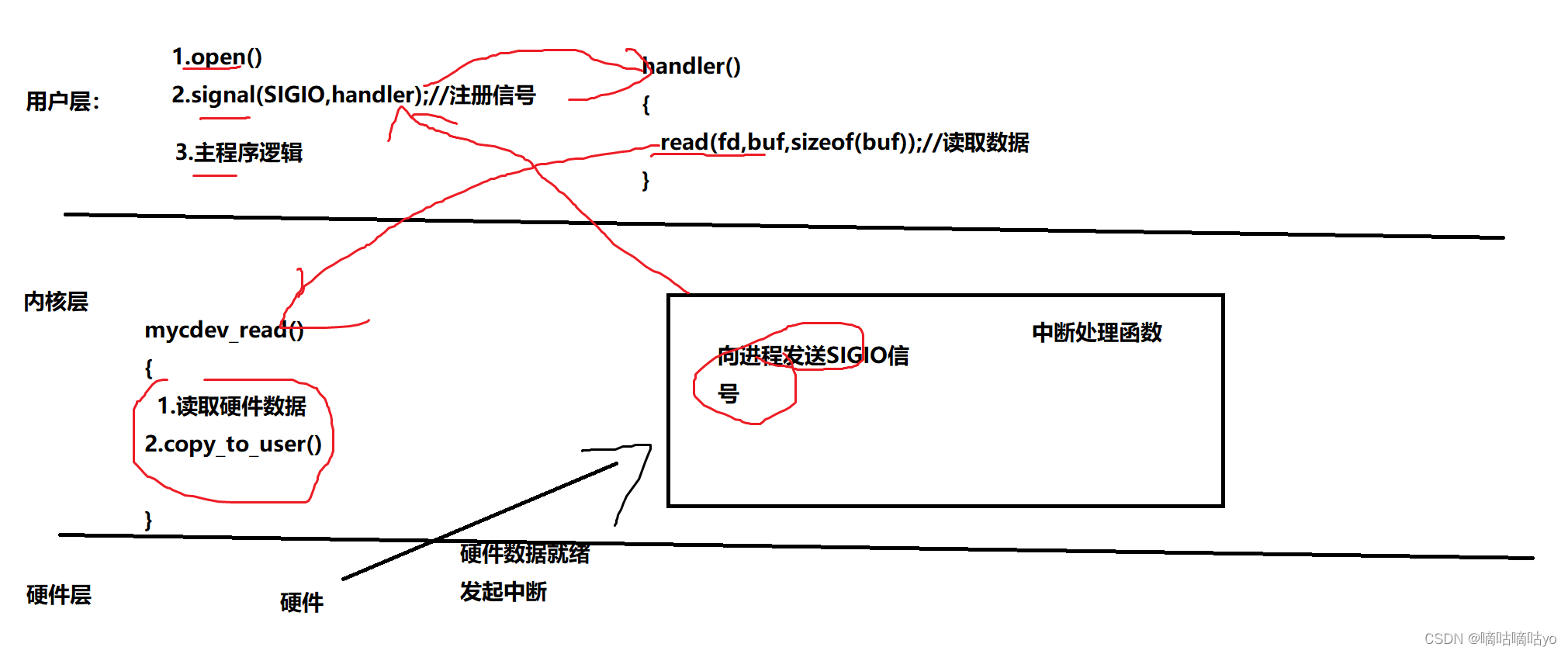

LSTM与我们学到的RNN非常相似,它具有与递归神经网络类似的控制流。在RNN中,信息(隐藏状态/梯度)在进行反向传播时跨时间步不间断地传递。LSTM所做的只是利用简单的门来控制循环网络单元中的梯度传播。LSTM 存储单元使用不同的门处理向前传播时传递信息的数据。让我们看看这些信息是如何在 LSTM 存储单元中处理的,首先让我们定义单元状态,