目录

1.算法运行效果图预览

2.算法运行软件版本

3.部分核心程序

4.算法理论概述

4.1 Q值更新规则

4.2 基于Q-learning的路径规划算法设计

4.3 Q-learning路径规划流程

5.算法完整程序工程

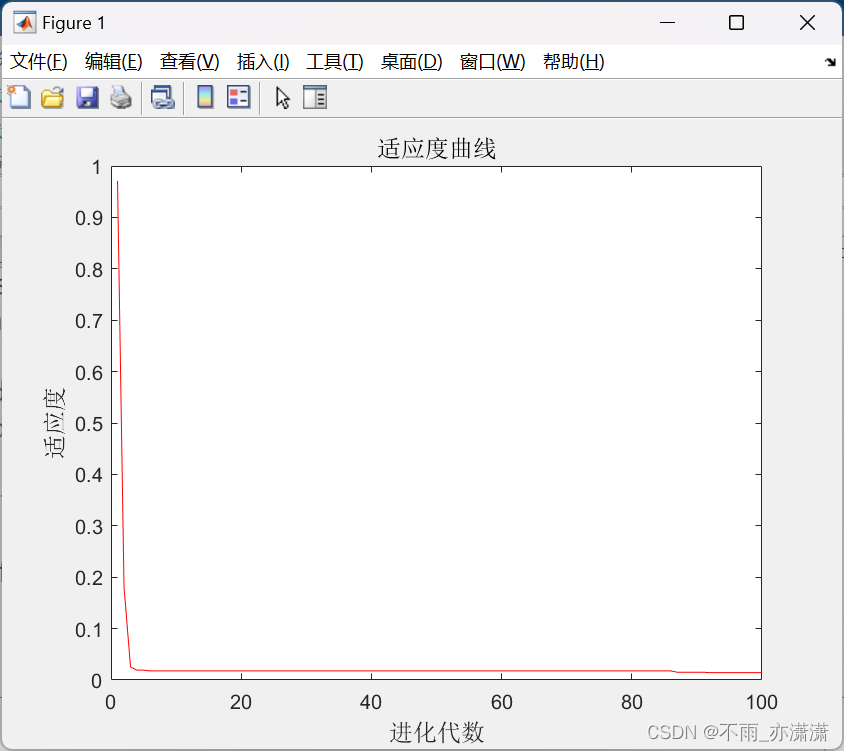

1.算法运行效果图预览

2.算法运行软件版本

MATLAB2022A

3.部分核心程序

...................................................[T,crowd,flow,R] = Update_M(T,crowd,flow,width,dis,cor,XY1);

last_s = XYs;

[Q,XYs] = qlearning(Q,R,XYs,XY1);

Reward0 = Reward0 + R(last_s,XYs);

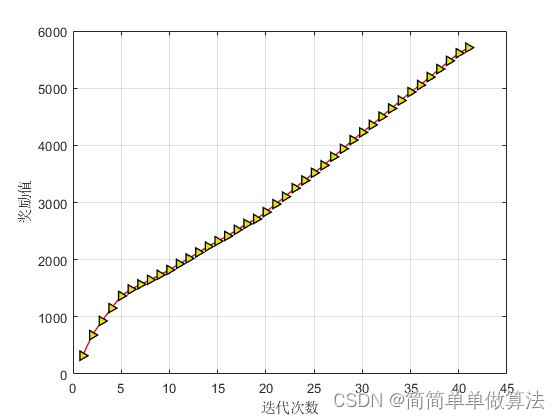

figure;

plot(Rewards,'-r>',...'LineWidth',1,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.9,0.0]);grid on

xlabel('迭代次数');

ylabel('奖励值');figure;

plot(path,'-r>',...'LineWidth',1,...'MarkerSize',6,...'MarkerEdgeColor','k',...'MarkerFaceColor',[0.9,0.9,0.0]);

hold on

grid on

xlabel('迭代次数');

ylabel('路线变化');

00394.算法理论概述

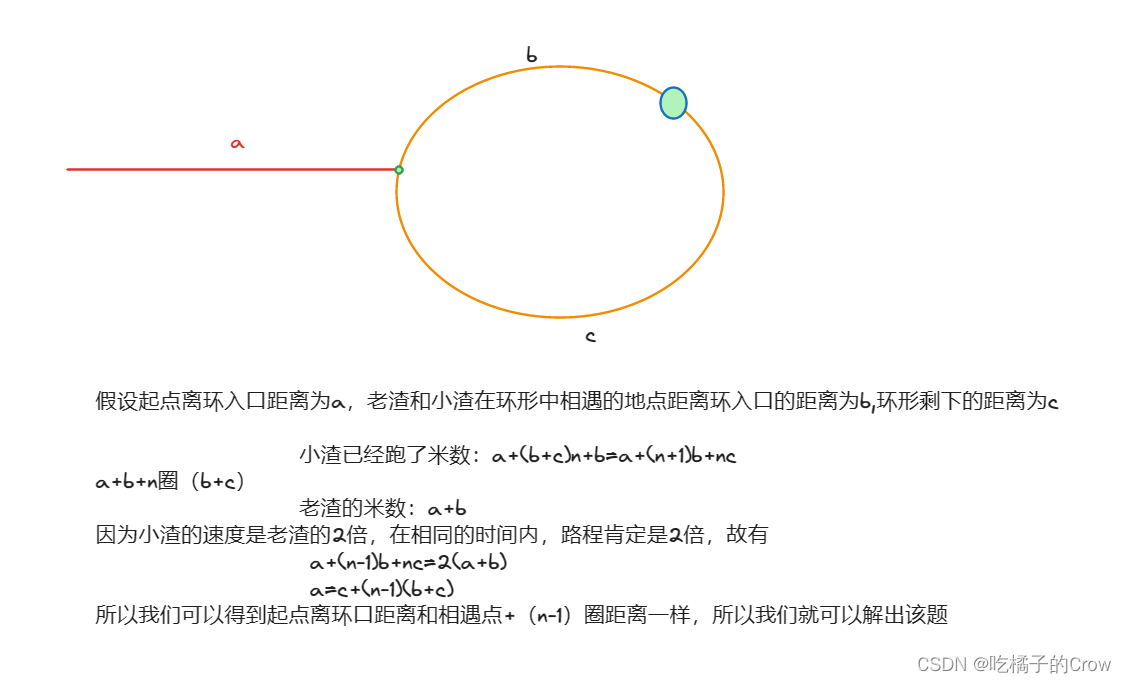

路径规划在机器人、自动驾驶等领域中具有重要应用。Q-learning是一种经典的强化学习算法,可以用于解决路径规划问题。本文介绍了基于Q-learning的路径规划算法,该算法可以在未知环境中学习最优路径,具有广泛的应用前景。Q-learning是一种基于值函数的强化学习算法,用于学习最优策略。在路径规划问题中,状态(State)表示机器人所处的位置,动作(Action)表示机器人可以采取的移动方向,奖励(Reward)表示机器人根据采取的动作获得的反馈。Q-learning的目标是学习一个Q值函数,用于评估在给定状态下采取某个动作的预期回报。

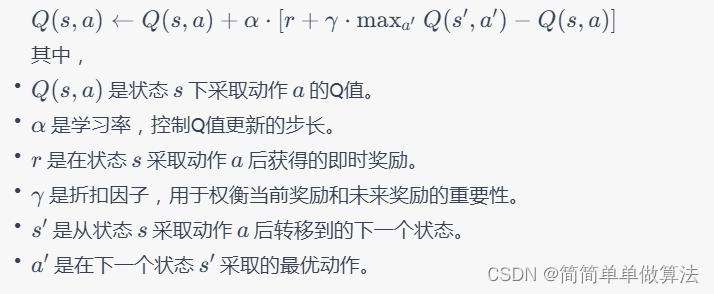

4.1 Q值更新规则

在每个时间步,Q-learning根据以下更新规则更新Q值:

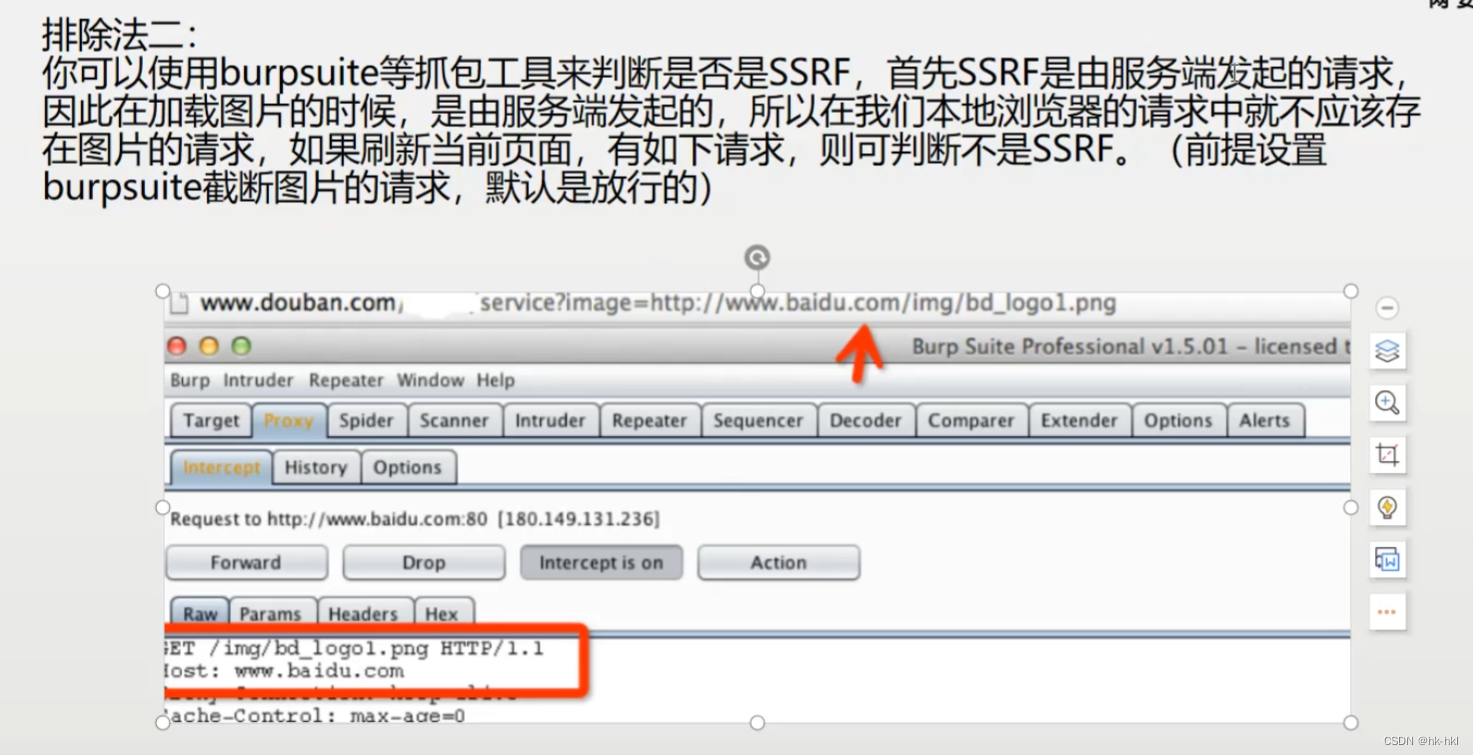

4.2 基于Q-learning的路径规划算法设计

在路径规划中,状态可以表示机器人所处的位置坐标,动作可以表示机器人可以向上、下、左、右等方向移动。将Q值初始化为一个小的随机值或零。

可以通过逐渐减小学习率和折扣因子,或者使用不同的策略来调优算法,以实现更好的性能和收敛性。

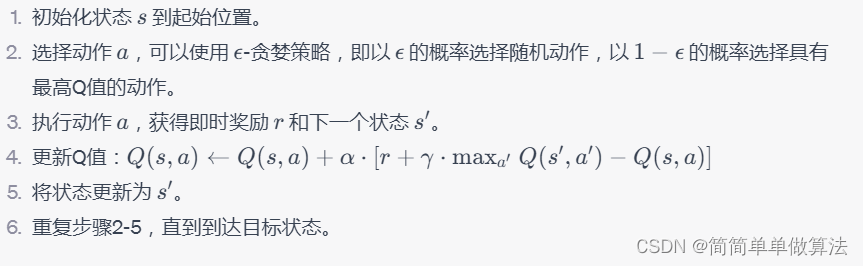

4.3 Q-learning路径规划流程

基于Q-learning的路径规划算法可以在未知环境中学习最优路径,具有广泛的应用前景。通过合理的参数设置和调优,可以实现高效的路径规划。

5.算法完整程序工程

OOOOO

OOO

O