测试时自适应对于领域转移下真实机器感知应用的成功至关重要,近年来,研究者们仍然在不断优化现有的方法。在今年的ICML中,TTA相关的研究也有了最新进展。

1.Uncovering Adversarial Risks of Test-Time Adaptation

标题:揭示测试时适应的对抗风险

内容:最近,测试时适应(TTA)被提出作为解决分布漂移的有望解决方案。它允许基模型在推理期间利用测试批次中的信息适应未知分布。但是,作者揭示了TTA基于这样的洞见存在新的安全漏洞:良性样本的预测会受到同一批次中恶意样本的影响。为了利用这个漏洞,作者提出了分布入侵攻击(DIA),它向测试批次注入少量恶意数据。DIA导致使用TTA的模型将良性和未经扰动的测试数据错误分类,为对手提供了一种在规范机器学习流水线中不可行的完全新能力。通过全面评估,作者证明了攻击对六种TTA方法在多个基准上的高效性。为应对这一漏洞,作者研究了两个对策来增强现有不安全的TTA实现,遵循“安全设计”的原则。

2.On Pitfalls of Test-Time Adaptation

标题:测试时间自适应的陷阱

内容:测试时间自适应(TTA)最近出现作为一种解决分布转移鲁棒性挑战的有希望的方法。但是,先前文献中缺乏一致的设置和系统的研究,阻碍了对现有方法的彻底评估。为解决这个问题,作者提出了TTAB,一个测试时间自适应基准,它包含十种最先进的算法,各种分布转移和两种评估协议。通过大量的实验,该基准揭示了先前工作中的三个常见陷阱。第一,由于在线批处理依赖性,选择适当的超参数,特别是用于模型选择,非常困难。第二,TTA的有效性在很大程度上取决于所调整的模型的质量和属性。第三,即使在最佳的算法条件下,现有的方法也无法解决所有常见类型的分布转移。

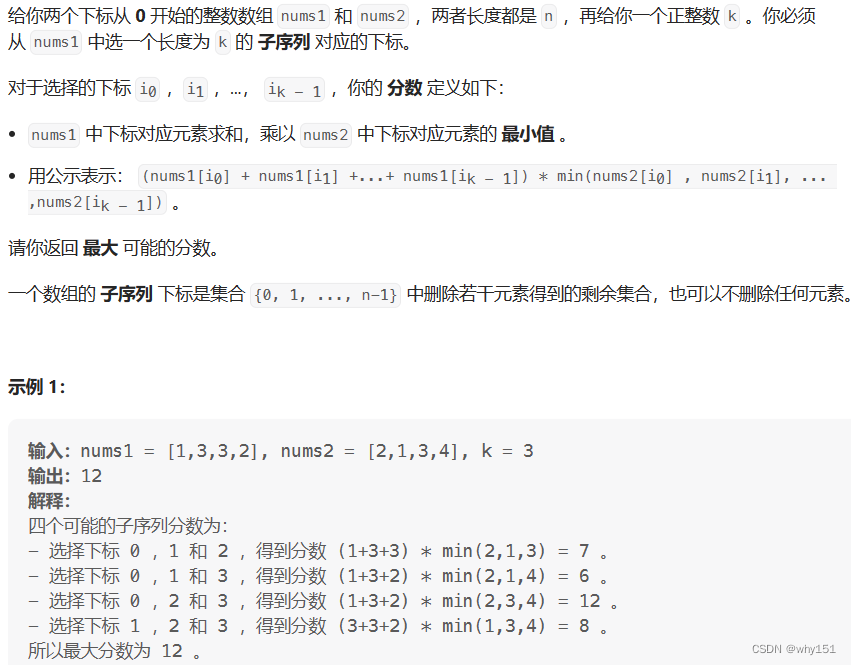

3.Leveraging Proxy of Training Data for Test-Time Adaptation

标题:利用训练数据代理进行测试时适应

内容:TTA的常见做法是忽略训练数据,以减少内存需求和隐私泄露。但是,训练数据是唯一的监督来源。这促使作者研究恰当地使用它们的方法,同时最小化副作用。为此,作者提出了训练数据的两个轻量级且信息丰富的代理,以及一个充分利用它们的TTA方法。代理之一由少量通过数据浓缩合成的图像组成,它们最小化了域特定性以捕获广泛域的一般潜在结构。然后,在TTA中,通过调整它们的样式以匹配无标签测试样本的样式,将它们转换为标记的测试数据,这实现了虚拟的测试时训练。另一个代理是训练数据的类间关系,在TTA期间转移到目标模型。在四个公共基准测试上,我们的方法以显著更少的计算和内存优于最先进的方法。

4.Learnability and Algorithm for Continual Learning

标题:持续学习的可学习性与算法

内容:本文研究了类增量学习(CIL)这一具有挑战性的持续学习设置。CIL学习一系列由不相交的概念或类构成的任务的序列。在任何时间点,都会构建一个单一模型,该模型可以对至今学习过的任何类的测试实例进行预测/分类,而无需为每个测试实例提供任何任务相关信息。尽管已为CIL提出许多技术,但它们大多是经验性的。最近证明,一个强大的CIL系统需要对每个任务具有强大的任务内预测(WP)和出分布(OOD)检测。然而,CIL是否可学习性仍未可知。本文证明CIL是可学习的。基于该理论,还提出了一种新的CIL算法。实验结果证明了其有效性。

5.Test-time Adaptation with Slot-Centric Models

标题:基于槽位的模型的测试时适应

内容:当前的视觉检测器在训练分布内的表现虽然令人印象深刻,但在分布外的场景中解析实体时往往会失败。最近的测试时间自适应方法使用辅助自监督损失来独立地对每个测试示例的参数进行自适应,在图像分类任务中对训练分布之外的泛化显示了有希望的结果。作者发现这些损失本身对于场景分解任务是不够的,如果不考虑建模的归纳偏差。最近的以slot为中心的生成模型试图通过重建像素以自监督的方式分解场景成实体。汲取这两条研究路线的精华,作者提出了Slot-TTA,这是一个半监督的以slot为中心的场景分解模型,在测试时通过对重建或跨视觉合成目标进行梯度下降对每个场景进行自适应。作者评估了Slot-TTA跨多个输入模式(图像或3D点云),并展示了相对于最先进的监督前馈检测器和其他测试时间自适应方法的重大分布外性能改进。

6.Theory on Forgetting and Generalization of Continual Learning

标题:持续学习遗忘和泛化理论

内容:持续学习(CL)旨在学习一系列任务,最近受到广泛关注。但是,大多数工作集中在CL的实验表现,理论研究还比较有限。特别是对影响“灾难性遗忘”和泛化性能的关键因素还缺乏理解。为弥补这一空白,作者在过参数化线性模型下的理论分析首次给出了预期遗忘和泛化误差的显式形式。进一步分析这个关键结果产生了许多理论解释,阐明了过参数化、任务相似性和任务顺序如何影响CL的遗忘和泛化误差。更有趣的是,通过在真实数据集上使用深度神经网络(DNN)进行实验,作者发现一些见解甚至超越了线性模型,可以延伸到实际设置。

7.Test-Time Style Shifting: Handling Arbitrary Styles in Domain Generalization

标题:测试时风格转换:处理域泛化中的任意风格

内容:作者提出了测试时风格迁移,在进行预测之前,它会将测试样本(与源域有较大风格差异的样本)的风格转换为模型已经熟悉的最相近的源域的风格。这种策略使得模型可以处理任意风格统计的目标域,而无需在测试时进行额外的模型更新。另外,作者提出了风格平衡,它为最大限度地发挥测试时风格迁移的优势提供了一个很好的平台,通过处理DG特有的不平衡问题。作者提出的思想很容易实现,并且可以与各种其他DG方案成功配合使用。不同数据集上的实验结果证明了该方法的有效性。

8.Learning Rate Schedules in the Presence of Distribution Shift

标题:分布变化下的学习率调度

内容:作者设计了学习率调度方案,以最小化SGD在线学习在数据分布变化的情况下的遗憾。通过创新的随机微分方程分析完全表征了线性回归的最佳学习率调度。对于一般的凸损失函数,作者提出了鲁棒的学习率调度,给出了遗憾的上下界,仅差一个常数。对于非凸损失函数,作者定义了基于估计模型的梯度范数的遗憾概念,并提出了最小化总预期遗憾上界的学习率调度。直觉上,变化的损失景观需要更多的探索,作者确认最佳学习率调度通常在分布变化时增加。

9.Nonparametric Density Estimation under Distribution Drift

标题:分布漂移下的非参数密度估计

内容:作者研究了非平稳漂移设置下的非参数密度估计。给定从随时间逐渐变化的分布中采样的独立样本序列,目标是计算当前分布的最佳估计。作者证明了离散和连续光滑密度的紧致最小最大风险界,其中最小值是所有可能的估计量,最大值是满足漂移约束的所有可能分布。作者的技术处理广泛的漂移模型,并推广了之前关于漂移下无知学习的结果。

关注下方《学姐带你玩AI》🚀🚀🚀

回复“TTA”获取全部论文PDF+代码合集

码字不易,欢迎大家点赞评论收藏!