全球各行业对 3D 世界和虚拟环境的需求呈指数级增长。3D 工作流程是工业数字化的核心,开发实时模拟来测试和验证自动驾驶车辆和机器人,操作数字孪生来优化工业制造,并为科学发现铺平新的道路。

如今,3D 设计和世界构建仍然是高度手动的。虽然 2D 艺术家和设计师已经拥有了辅助工具,但 3D 工作流程仍然充满了重复、乏味的任务。

为场景创建或查找对象是一个耗时的过程,需要长期磨练的专业 3D 技能,例如建模和纹理化。正确放置对象以及将 3D 环境艺术引导至完美需要数小时的微调。

为了减少手动、重复性任务并帮助创作者和设计师专注于工作中富有创意和乐趣的方面,NVIDIA 推出了众多 AI 项目,例如用于生成式AI/

人工智能的 变革

借助 ChatGPT,我们现在正在体验变革,各种技术水平的个人都可以使用日常语言与高级计算平台进行交互。大模型(LLM) 变得越来越复杂,当像 ChatGPT 这样的用户友好界面让每个人都可以使用它们时,它成为历史上增长最快的应用,推出后仅两个月就超过了 1 亿用户。现在,每个行业都计划利用人工智能的力量进行广泛的应用,例如药物发现、自主机器和虚拟助手。

最近,我们尝试了 OpenAI 的病毒式 ChatGPT 和新的 GPT-4 大型多模态模型,以展示开发可为NVIDIA Omniverse中的虚拟世界快速生成 3D 对象的自定义工具是多么容易。OpenAI 联合创始人 Ilya Sutskever 在GTC 2023上与 NVIDIA 创始人兼首席执行官黄仁勋的炉边聊天中表示,与 ChatGPT 相比,GPT-4 标志着“在许多方面都有相当大的改进” 。

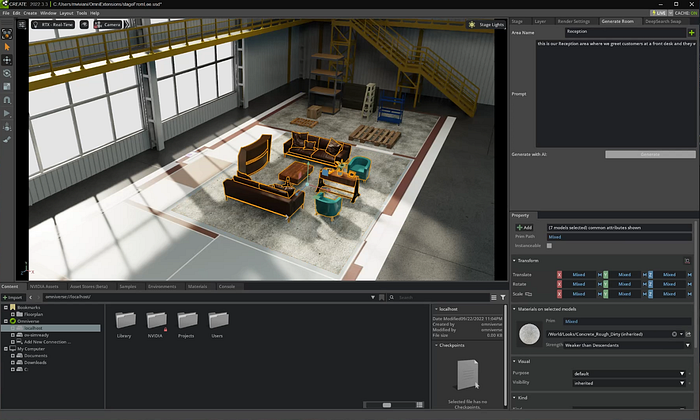

通过将 GPT-4 与Omniverse DeepSearch(一种智能 AI应用,能够搜索未标记 3D 资产的海量数据库)相结合,我们能够快速开发一个自定义扩展,通过简单的基于文本的提示检索 3D 对象,并将它们自动添加到3D 场景。

AI生成3D内容

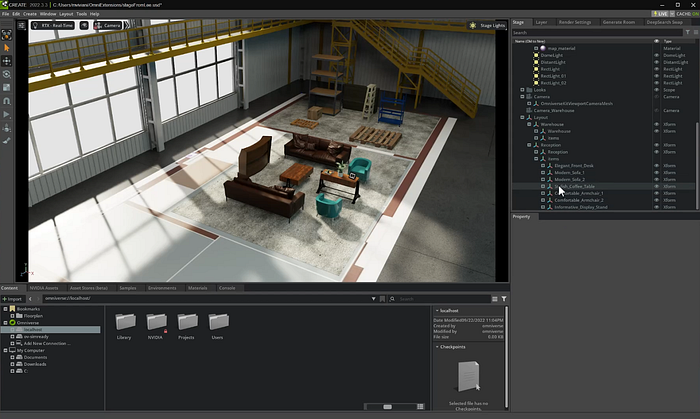

NVIDIA Omniverse(3D 应用程序开发平台)中的这一有趣实验向开发人员和技术美术人员展示了快速开发利用生成式 AI 来填充现实环境的自定义工具是多么容易。最终用户只需输入基于文本的提示即可自动生成和放置高保真对象,从而节省创建复杂场景通常所需的数小时时间。

从扩展生成的对象基于通用场景描述(USD) SimReady 资产。SimReady 资产是物理上精确的 3D 对象,可以在任何模拟中使用,并且其行为就像在现实世界中一样。

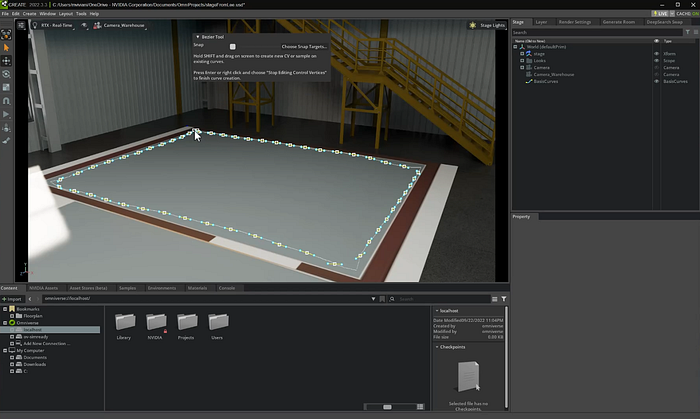

获取有关 3D 场景的信息

一切都从 Omniverse 中的场景开始。用户可以使用 Omniverse 中的铅笔工具轻松圈出一个区域,输入他们想要生成的房间/环境类型(例如仓库或接待室),然后单击一下即可创建该区域

创建 ChatGPT 提示

ChatGPT提示由四部分组成:系统输入、用户输入示例、助手输出示例和用户提示。

让我们从适合用户场景的提示的各个方面开始。这包括用户输入的文本以及场景中的数据。

例如,如果用户想要创建一个接待室,他们会指定类似“这是我们会见客户的房间。确保有一套舒适的扶手椅、沙发和咖啡桌。” 或者,如果他们想要添加一定数量的项目,他们可以添加“确保至少包含 10 个项目”。

该文本与场景信息相结合,例如我们将在其中放置项目作为用户提示的区域的大小和名称。

“接待室,7 x10 米,原点为( 0.0 , 0.0 , 0.0 )。这是我们会见客户

的房间。确保有一套舒适的扶手椅、沙发和咖啡桌”将用户的文本与场景细节相结合的想法非常强大。在场景中选择一个对象并以编程方式访问其详细信息比要求用户编写提示来描述所有这些详细信息要简单得多。我怀疑我们会看到很多利用这种文本+场景到场景模式的 Omniverse 扩展。

除了用户提示之外,我们还需要使用系统提示和一两次训练来启动 ChatGPT。

为了创建可预测的、确定性的结果,人工智能根据系统提示和示例专门返回一个 JSON,其中所有信息都以明确定义的方式格式化,以便可以在 Omniverse 中使用。

以下是我们将发送的四部分提示。

系统提示

这为人工智能设置了约束和指令

您是一个区域生成专家。在给定一定大小的区域后,您可以生成适合该区域的物品列表,并将它们放置在正确的位置。

您在一个三维空间中操作,使用 X、Y、Z 坐标系。其中,X 代表宽度,Y 代表高度,Z 代表深度。坐标 (0.0, 0.0, 0.0) 表示默认的空间原点。

您从用户那里接收到区域的名称、X 和 Z 轴上的尺寸(以厘米为单位)、区域的原点(即区域中心点)。

您的回答只需生成包含以下信息的 JSON 文件:

- area_name:区域名称

- X:区域在 X 轴上的坐标

- Y:区域在 Y 轴上的坐标

- Z:区域在 Z 轴上的坐标

- area_size_X:区域在 X 轴上的尺寸(厘米)

- area_size_Z:区域在 Z 轴上的尺寸(厘米)

- area_objects_list:区域中所有物品的列表

对于每个物品,您需要存储以下信息:

- object_name:物品名称

- X:物品在 X 轴上的坐标

- Y:物品在 Y 轴上的坐标

- Z:物品在 Z 轴上的坐标

每个物品的名称应包含适当的形容词。

请记住,物品应该放置在区域内,以创建最有意义的布局,并且它们不应重叠。所有物品必须位于区域尺寸的边界内;永远不要将物品放置在距离原点超过区域长度或深度的一半的位置。还要注意,物品应根据区域的原点分布在整个区域内,您也可以使用负值来正确显示物品,因为区域的原点始终位于区域的中心。

请记住,您只需生成 JSON 代码,不需要其他内容。这非常重要。

用户输入示例

这是用户可能提交的内容的示例。请注意,它是场景数据和文本提示的组合。

“接待室,7 x10m,原点为 ( 0.0 , 0.0 , 0.0 )。这是我们会见客户的房间

。确保有一套舒适的扶手椅、沙发和咖啡 桌”

辅助输出示例

这提供了人工智能必须使用的模板。请注意我们如何描述我们期望的JSON。

{"area_name": "Reception","X": 0.0,"Y": 0.0,"Z": 0.0,"area_size_X": 700,"area_size_Z": 1000,"area_objects_list": [{"object_name": "White_Round_Coffee_Table","X": -120,"Y": 0.0,"Z": 130},{"object_name": "Leather_Sofa","X": 250,"Y": 0.0,"Z": -90},{"object_name": "Comfortable_Armchair_1","X": -150,"Y": 0.0,"Z": 50},{"object_name": "Comfortable_Armchair_2","X": -150,"Y": 0.0,"Z": -50} ]

}连接到 OpenAI

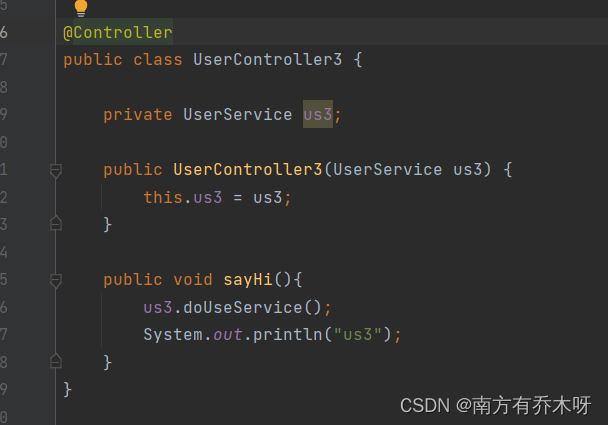

该提示通过 Python 代码从扩展发送到 AI。这在 Omniverse Kit 中非常简单,只需使用最新的O penAI Python 库的几个命令即可完成。请注意,我们正在将系统输入、示例用户输入和我们刚刚概述的示例预期助理输出传递给 OpenAI API。变量“response”将包含来自 ChatGPT 的预期响应。

# Create a completion using the chatGPT model response = openai.ChatCompletion.create(model="gpt-3.5-turbo",# if you have access, you can swap to model="gpt-4",messages=[{"role": "system", "content": system_input},{"role": "user", "content": user_input},{"role": "assistant", "content": assistant_input},{"role": "user", "content": my_prompt},])# parse response and extract texttext = response["choices"][0]["message"]['content']将 ChatGPT 的结果传递到 Omniverse DeepSearch API 并生成场景

然后,扩展程序会解析 ChatGPT JSON 响应中的项目,并将其传递到 Omnivere DeepSearch API。DeepSearch 允许用户使用自然语言查询搜索存储在 Omniverse Nucleus 服务器中的 3D 模型。

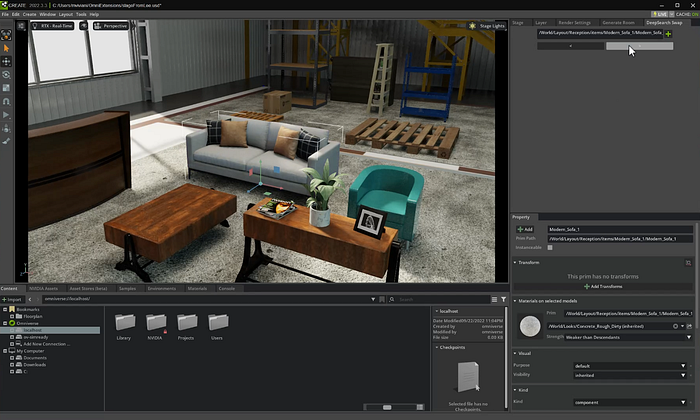

这意味着,例如,即使我们不知道沙发模型的确切文件名,我们也可以通过搜索“Comfortable Sofa”来检索它,这正是我们从 ChatGPT 中获得的。

DeepSearch 能够理解自然语言,通过向其询问“舒适的沙发”,我们会得到一份项目列表,我们乐于助人的人工智能图书馆员从我们当前资产库中选择的资产中确定了最适合的项目。它在这方面出奇地好,所以我们经常可以使用它返回的第一个项目,但当然,我们建立了选择,以防用户想要从列表中选择某些内容。

从那里,我们只需将对象添加到舞台即可。

将 DeepSearch 中的项目添加到 Omniverse 阶段

现在 DeepSearch 已返回结果,我们只需要将对象放入 Omniverse 中即可。在我们的扩展中,我们创建了一个名为 place_deepsearch_results() 的函数,它处理所有项目并将它们放置在场景中。

def place_deepsearch_results(gpt_results, query_result, root_prim_path):index = 0for item in query_result:# Define Prim stage = omni.usd.get_context().get_stage()prim_parent_path = root_prim_path + item[‘object_name’].replace(" ", "_")parent_xForm = UsdGeom.Xform.Define(stage, prim_parent_path)prim_path = prim_parent_path + "/" + item[‘object_name’].replace(" ", "_")next_prim = stage.DefinePrim(prim_path, 'Xform')# Add reference to USD Assetreferences: Usd.references = next_prim.GetReferences()references.AddReference(assetPath="your_server://your_asset_folder" + item[‘asset_path’])# Add reference for future search refinement config = next_prim.CreateAttribute("DeepSearch:Query", Sdf.ValueTypeNames.String)config.Set(item[‘object_name’])# translate primnext_object = gpt_results[index]index = index + 1x = next_object['X']y = next_object['Y']z = next_object['Z']此方法用于放置项目,迭代我们从 GPT 获得的 query_result 项目,使用 USD API 创建和定义新原语,根据 gpt_results 中的数据设置其转换和属性。我们还将 DeepSearch 查询保存在美元的属性中,以便以后我们想再次运行 DeepSearch 时可以使用它。请注意,assetPath“your_server//your_asset_folder”是一个占位符,应替换为执行 DeepSearch 的文件夹的真实路径。

使用 DeepSearch 交换项目

然而,我们可能不喜欢第一次检索到的所有项目。因此,我们构建了一个小型配套扩展程序,允许用户浏览类似的对象并只需单击即可交换它们。借助 Omniverse,可以非常轻松地以模块化方式构建,因此您可以通过其他扩展轻松扩展您的工作流程。

这个配套扩展非常简单。它采用通过 DeepSearch 生成的对象作为参数,并提供两个按钮来从相关 DeepSearch 查询中获取下一个或上一个对象。例如,如果 USD 文件包含属性“DeepSearch:Query = Modern Sofa”,它将通过 DeepSearch 再次运行此搜索并获得下一个最佳结果。当然,您可以将其扩展为包含所有搜索结果图片的可视化 UI,类似于我们用于一般 DeepSearch 查询的窗口。为了使这个示例简单,我们只选择了两个简单的按钮。

请参阅下面的代码,其中显示了增加索引的函数,以及实际根据索引操作对象交换的函数replace_reference(self) 。

def increment_prim_index():if self._query_results is None:return self._index = self._index + 1if self._index >= len(self._query_results.paths):self._index = 0self.replace_reference()def replace_reference(self):references: Usd.references = self._selected_prim.GetReferences()references.ClearReferences()references.AddReference(assetPath="your_server://your_asset_folder" + self._query_results.paths[self._index].uri)请注意,如上所述,路径“your_server://your_asset_folder”只是一个占位符,您应该将其替换为执行 DeepSearch 查询的 Nucleus 文件夹。

使用 DeepSearch 将灰色沙发替换为棕色沙发

这展示了如何通过结合 LLM 和 Omniverse API 的力量,可以创建增强创造力和加快流程的工具。

从 ChatGPT 到 GPT-4

OpenAI 的新 GPT-4 的主要进步之一是其在大型语言模型中增强的空间意识。

我们最初使用ChatGPT API,它基于GPT-3.5-turbo。虽然 GPT-4 提供了良好的空间感知,但它提供了更好的结果。您在上面视频中看到的版本使用的是 GPT-4。

GPT-4 相对于 GPT-3.5 在解决复杂任务和理解复杂指令方面有了很大的改进。因此,在设计文本提示“指导人工智能”时,我们可以更具描述性并使用自然语言

我们可以给人工智能非常明确的指令,例如:

- “每个对象名称都应该包含一个适当的形容词。”

- “请记住,对象应该放置在该区域中以创建尽可能最有意义的布局,并且它们不应该重叠。”

- “所有物体都必须在区域大小的范围内;切勿将物体放置在距原点超过该区域长度 1/2 或深度 1/2 的位置。”

- “还要记住,对象应该放置在相对于区域原点的整个区域上,并且您也可以使用负值来正确显示项目,因为区域的原点始终位于区域的中心。该地区。”

人工智能在生成响应时正确遵循这些系统提示的事实尤其令人印象深刻,因为人工智能表明对空间意识以及如何正确放置物品有很好的理解。使用 GPT-3.5 执行此任务的挑战之一是有时对象会在房间外或奇怪的位置生成。

GPT-4 不仅将物体放置在房间的正确边界内,而且还逻辑地放置物体:床头柜实际上会出现在床的一侧,咖啡桌将放置在两个沙发之间,等等。

构建您自己的 ChatGPT 支持的扩展

虽然这只是人工智能连接到 3D 空间后可以做什么的一个小演示,但我们相信它将为场景构建之外的各种工具打开大门。开发人员可以在 Omniverse 中构建人工智能驱动的扩展,用于照明、相机、动画、角色对话和其他优化创作者工作流程的元素。他们甚至可以开发工具将物理附加到场景并运行整个模拟。