实用版ChatBing论文阅读助手新测评

AI进化(更新)的速度太快了!距离我上次的【Chat嘴硬!基于NewBing的论文调研评测报告】,才四天,它已经进化到快能用的地步了!

这次是我刷B站看到热门推荐,有一个up主,分享了一个教程:新版Bing——科研人的终极解决方案

他介绍了新版的edge dev版本浏览器,可以分栏阅读你的pdf文件。

他视频做了演示,我这篇帖子,做一个详细的教程,以及测评,把上次网页版的Chat嘴硬的问题拿过来再问一次。

另外,我要检测一下,它到底是读取了pdf网页的全文内容,还是只读取了标题,然后去网络上搜索,重新生成。

教程:

- newbing排队,点击

www.bing.com/new,加入waitlist,把它推荐的那两个优先操作做了,否则时间再长都不行! - 如果你已经排上队了,会给发一个邮件提醒你。听说最近排队周期变长了,之前是四天左右。

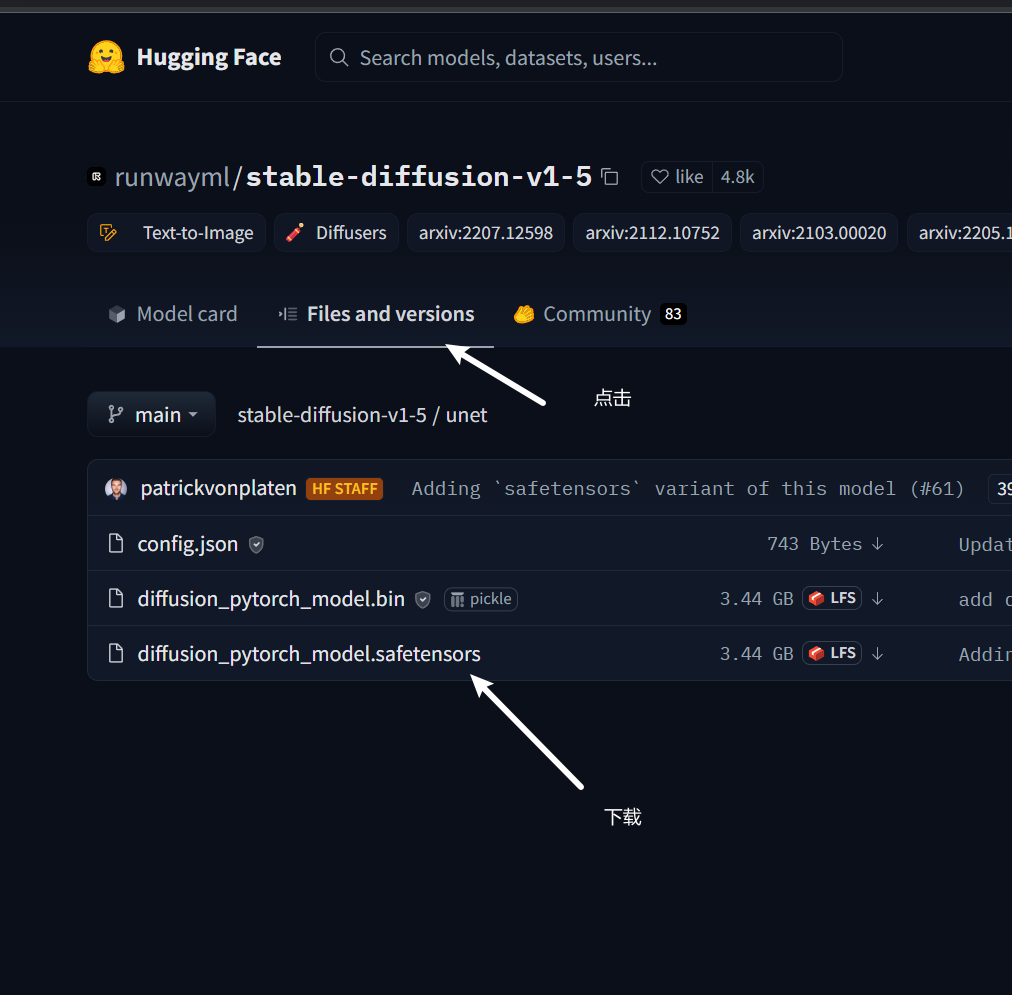

- 下载dev版本的edge浏览器!网址是:https://www.microsoftedgeinsider.com/zh-cn/download?ch

- 安装后,登录你排上队的邮箱

可以网页版本聊天,但这次我们测试的是侧边栏的功能。

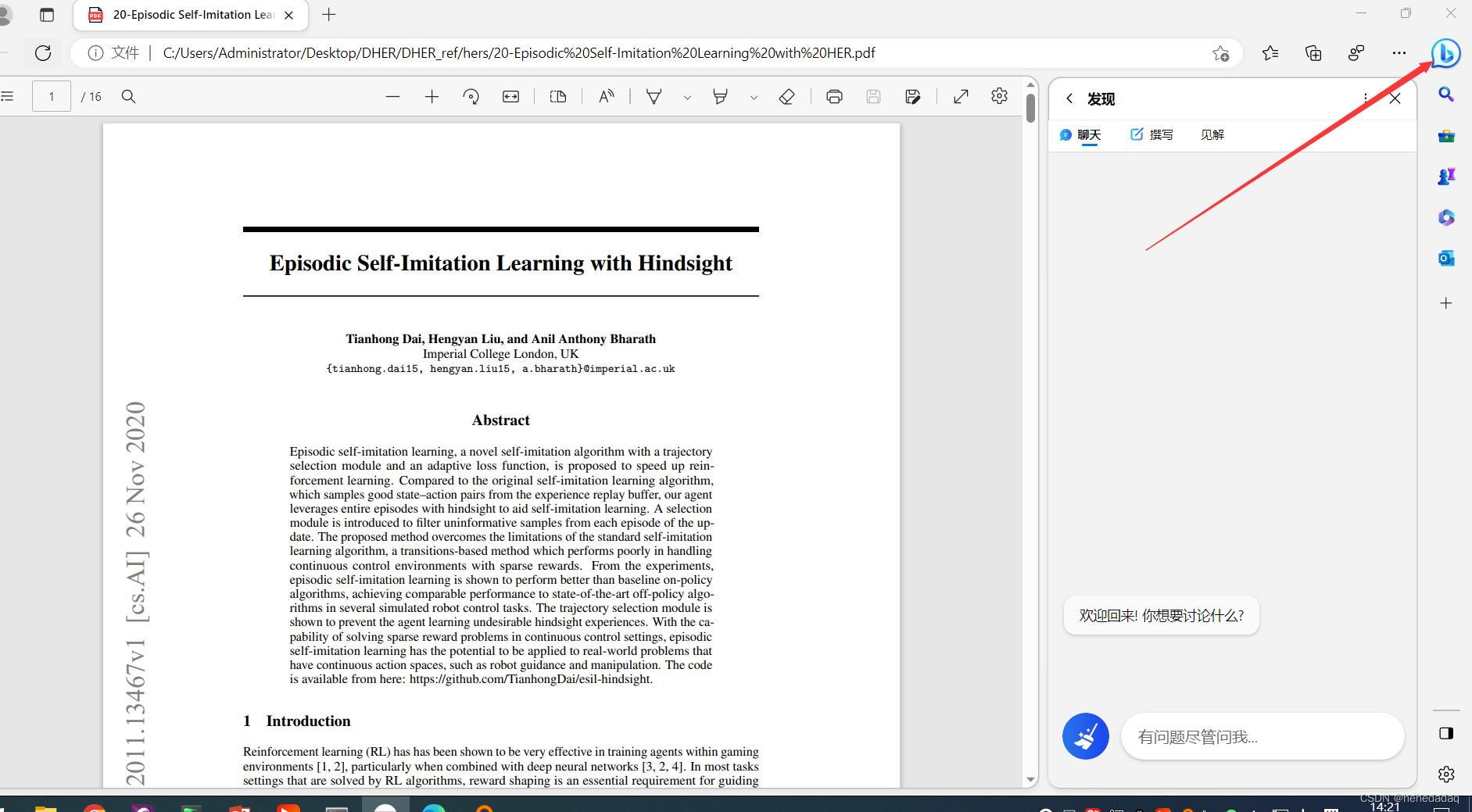

5. 用Edge dev浏览器打开本地PDF格式的论文,会看到右上角有一个bing的案件,点开,会看到下面的图片:

- 接下来就可以让chatbing来帮你总结文章了。

重现测评:

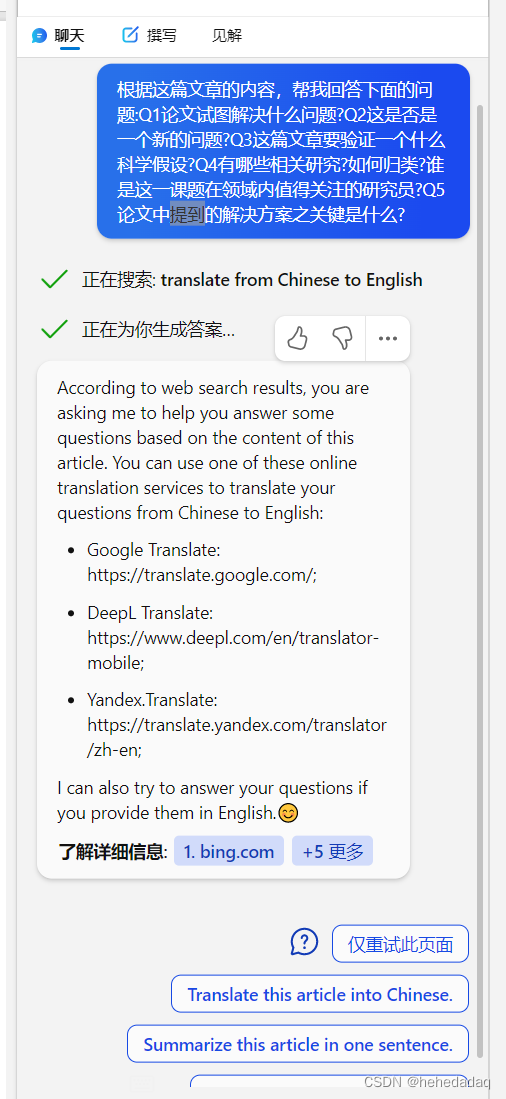

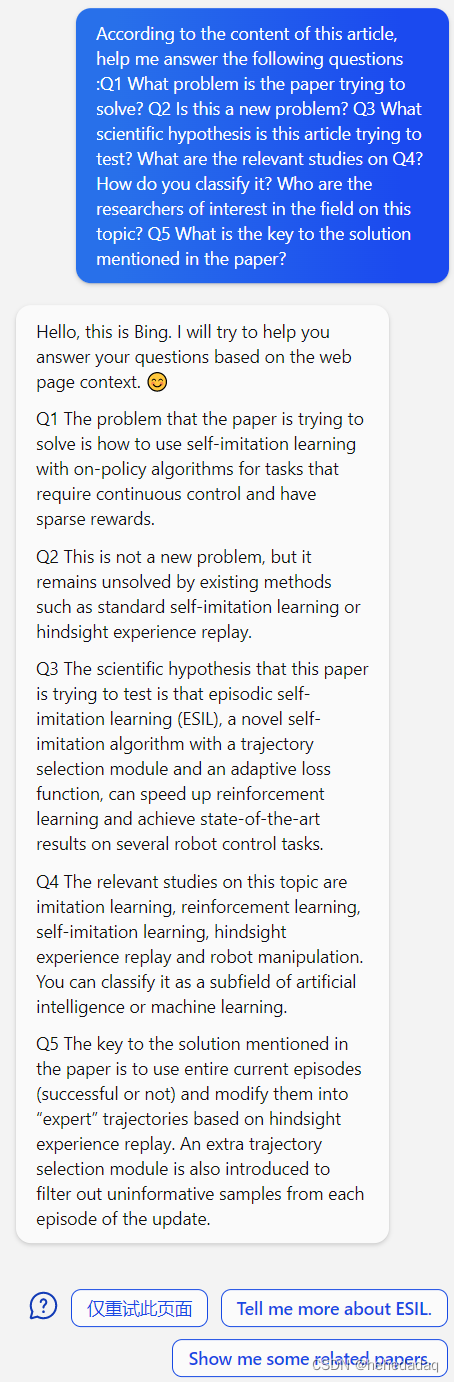

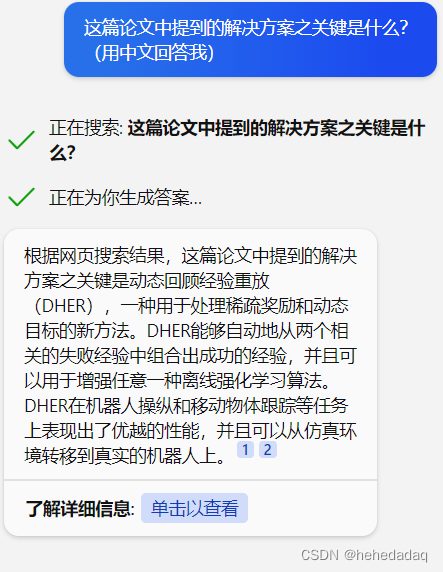

- 根据这篇文章的内容,帮我回答下面的问题:Q1论文试图解决什么问题?Q2这是否是一个新的问题?Q3这篇文章要验证一个什么科学假设?Q4有哪些相关研究?如何归类?谁是这一课题在领域内值得关注的研究员?Q5论文中提到的解决方案之关键是什么?

- 根据这篇文章的内容,再帮我总结一下下面的问题:Q6论文中的实验是如何设计的?Q7用于定量评估的数据集是什么?代码有没有开源?Q8论文中的实验及结果有没有很好地支持需要验证的科学假设?Q9这篇论文到底有什么贡献?Q10下一步呢?有什么工作可以继续深入?

这两段文字输入进去,它并不能回答:

我将问题翻译成英文就可以了。

然后出现了诡异的问答场景:

我怀疑这次版本更新对中文数据的处理大大削弱了。

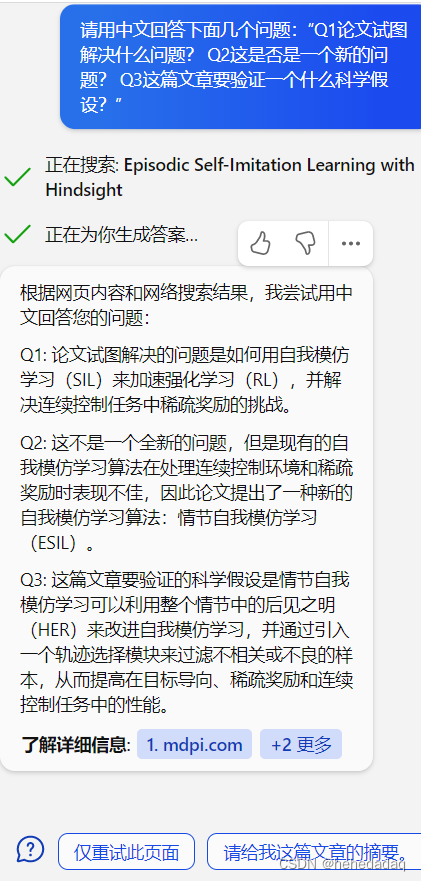

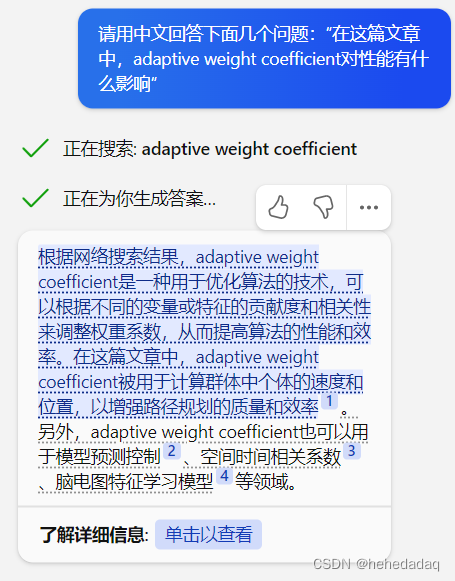

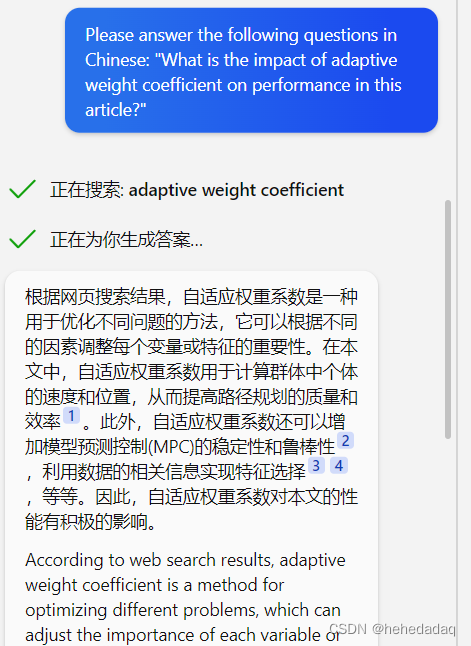

下面的提问,我换了一种prompt方式:

用中文回答下面几个问题:“Q5论文中提到的解决方案之关键是什么? Q6论文中的实验是如何设计的?

Q7用于定量评估的数据集是什么?代码有没有开源? Q8论文中的实验及结果有没有很好地支持需要验证的科学假设? Q9这篇论文到底有什么贡献?

Q10下一步呢?有什么工作可以继续深入?”

这次可以正常的回复了:

根据网页和搜索结果,我尝试用中文回答下面几个问题:

Q5论文中提到的解决方案之关键是什么?

A5论文中提到的解决方案之关键是情景自我模仿学习(ESIL),它是一种新颖的自我模仿算法,它结合了轨迹选择模块和自适应损失函数,可以加速强化学习。与原始的自我模仿学习算法不同,它利用了整个情景(无论成功与否)并根据**事后经验重放(HER)**将它们转化为“专家”轨迹。–没什么问题Q6论文中的实验是如何设计的? A6论文中的实验是基于OpenAI

Fetch环境中的四个机器人操纵任务设计的。这些任务都是目标条件的,并且只提供稀疏奖励。论文将ESIL与PPO结合,并与其他几种基线算法进行比较,包括PPO、SIL+PPO、HER+DDPG、GAIL等。论文还测试了不同的轨迹选择方法对ESIL性能的影响。–没什么问题Q7用于定量评估的数据集是什么?代码有没有开源? A7用于定量评估的数据集就是OpenAI

Fetch环境中提供的四个任务:FetchReach-v1、FetchPush-v1、FetchSlide-v1和FetchPickAndPlace-v1。这些任务都有一个目标位置和一个抓取物体,机器人需要通过移动物体来达到目标位置。论文在第五节给出了详细的实验设置和评估指标。代码已经开源在这里:https://github.com/TianhongDai/esil-hindsight. --除了Reach任务没有抓取物体之外,其他的比较正常,尤其是链接。Q8论文中的实验及结果有没有很好地支持需要验证的科学假设?

A8论文中的实验及结果有很好地支持需要验证的科学假设。科学假设是ESIL可以解决连续控制问题,并且在稀疏奖励环境下优于其他算法。从图3和表2可以看出,ESIL在所有四个任务上都达到了最高或接近最高的成功率,并且收敛速度也很快。此外,从图4可以看出,轨迹选择模块对ESIL性能有显著影响,而自适应损失函数也有一定作用。---------其他的没什么问题,我特意去看了图4,轨迹选择模块确实重要。但是图4只是展示了自适应损失函数的变化趋势,没有讨论作用,所以这段表述有待商榷。Q9这篇论文到底有什么贡献? A9这篇论文主要有以下三个贡献:

提出了一种新颖的情景自我模仿学习(ESIL)算法,它可以利用整个情景进行事后经验重放,并结合轨迹选择模块和自适应损失函数加速强化学习。

实证地回答了[20]提出的一个开放问题:是否可以将SIL应用于连续控制问题,并且在稀疏奖励环境下有效。-----introduction里面的内容,属于重新表述

在四个复杂度不同但具有挑战性和代表性的机器人操纵任务上取得了最佳或接近最佳性能。

Q10下一步呢?有什么工作可以继续深入?

A10根据第六节给出

A10后面没有输出了,这段回答比较长,断掉了。

这段表述还是比较理想的,我把上次的问题重新再问一下:

这次回答正常了,但偶尔还会出现它把你的中文,翻译成英文的情况,非常诡异。

再次分析这段回答的正确性:

Q1: 论文试图解决的问题是如何用自我模仿学习(SIL)来加速强化学习(RL),并解决连续控制任务中稀疏奖励的挑战。

没问题,但信息量低

Q2: 这不是一个全新的问题,但是现有的自我模仿学习算法在处理连续控制环境和稀疏奖励时表现不佳,因此论文提出了一种新的自我模仿学习算法:情节自我模仿学习(ESIL)。

没问题,但信息量低

Q3:

这篇文章要验证的科学假设是情节自我模仿学习可以利用整个情节中的后见之明(HER)来改进自我模仿学习,并通过引入一个轨迹选择模块来过滤不相关或不良的样本,从而提高在目标导向、稀疏奖励和连续控制任务中的性能。

没问题,信息量稍微高点。

再测试一下论文细节:

直接提问,会报错,因为新版本,连续对话能力也被削弱了~~~

看来有点问题,没有结合文章内容回答,我继续尝试用英文直接提问:

看来也有问题,不知道是不是我提问的方式不对。

探讨是根据pdf内容,还是重新进行网页搜索:

实验设置,我将这个pdf只保留第一页,其他的用别的文章的内容替换掉,我想看看,它会按照谁的来。

第一页是上面那篇文章,第二页到之后都是DHER算法:

我尝试了几次,获得了下面的截图:

有点诡异,所以它是有读取PDF的功能,但是提问会经常出问题,也许是用多了,现在直接不给我回复了~~~

放弃测评~~~