文章目录

- 1. 扩张卷积的提出

- 2. 理解的难点

本片博客的主题思路来自于这篇文章——如何理解Dilated Convolutions(空洞卷积),但是作者似乎是很久之前写的,文字的排版很混乱,自己来写一个新的。

1. 扩张卷积的提出

- Multi-Scale Context Aggregation by Dilated Convolutions

- Dilated Residual Networks

这里有原作者推荐的一篇论文笔记,大家有兴趣可以看一看,论文笔记——CVPR 2017 Dilated Residual Networks。

2. 理解的难点

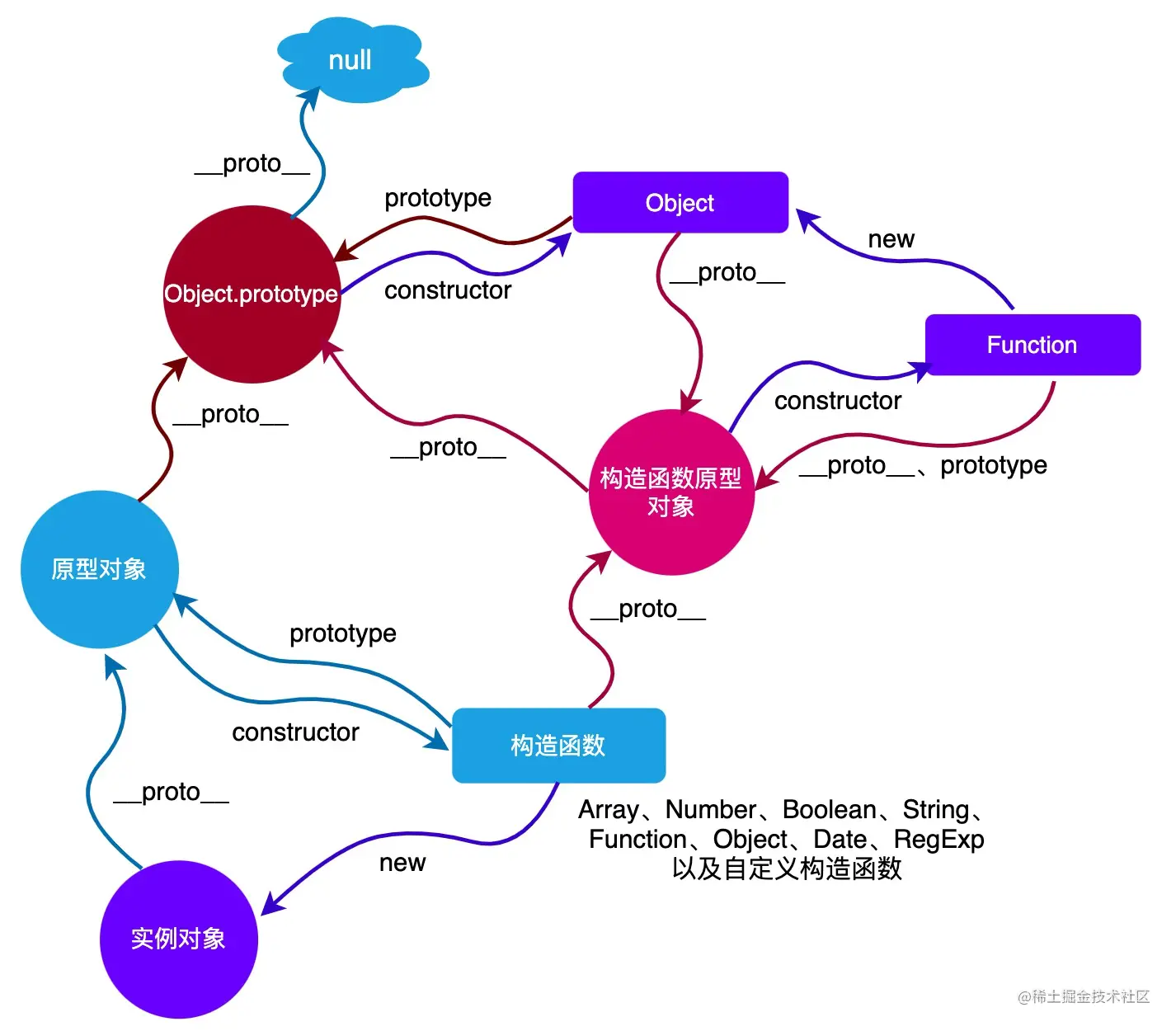

上图是论文 Multi-Scale Context Aggregation by Dilated Convolutions 的原图,我们可以问几个小问题

- 红点代表什么含义

- 为什么扩张卷积,图像尺寸是不改变的

- 图中最外层图像代表什么

上面这张图可以帮助你从直观上更好的理解感受野,这个图来自一篇博客,A guide to receptive field arithmetic for Convolutional Neural Networks,看不懂的话可以看中文翻译版,都很有参考价值。

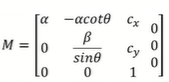

我们根据感受野的计算公式

l k = l k − 1 + ( ( f k − 1 ) ∗ ∐ i = 1 k − 1 s i ) l_{k}=l_{k-1}+\left(\left(f_{k}-1\right) * \coprod_{i=1}^{k-1} s_{i}\right) lk=lk−1+((fk−1)∗i=1∐k−1si)

其中, l k l_{k} lk 为第 k − 1 k-1 k−1 层的感受野大小, f k f_k fk 是当前层的卷积核大小, s i s_i si 是第 i i i 层的步长。可以推导出空洞卷积的计算公式,本质上就是在卷积和中间添0,扩大了卷积和的大小。

设普通卷积和的大小为 f k f_k fk,则等效的空洞卷积核的大小为 d k d_k dk,有公式

d k = ( f k − 1 ) × ( r a t e − 1 ) + f k d_k=(f_k-1)\times (\mathrm{rate}-1)+f_k dk=(fk−1)×(rate−1)+fk

回到最初的问题

- 红点代表什么意思?代表的是感受野的中心

- 空洞卷积得到的特征图大小是不变的

关于特征图大小的计算,我们有如下的公式

n out = ⌊ n in + 2 p − k s ⌋ + 1 n_{\text {out }}=\left\lfloor\frac{n_{\text {in }}+2 p-k}{s}\right\rfloor+1 nout =⌊snin +2p−k⌋+1

其中, n out n_{\text {out }} nout 和 n in n_{\text {in }} nin 分表代表输出和输入的特征图尺度, k k k 代表卷积核大小, p p p 代表填充的尺寸, s s s 代表卷积的步长。