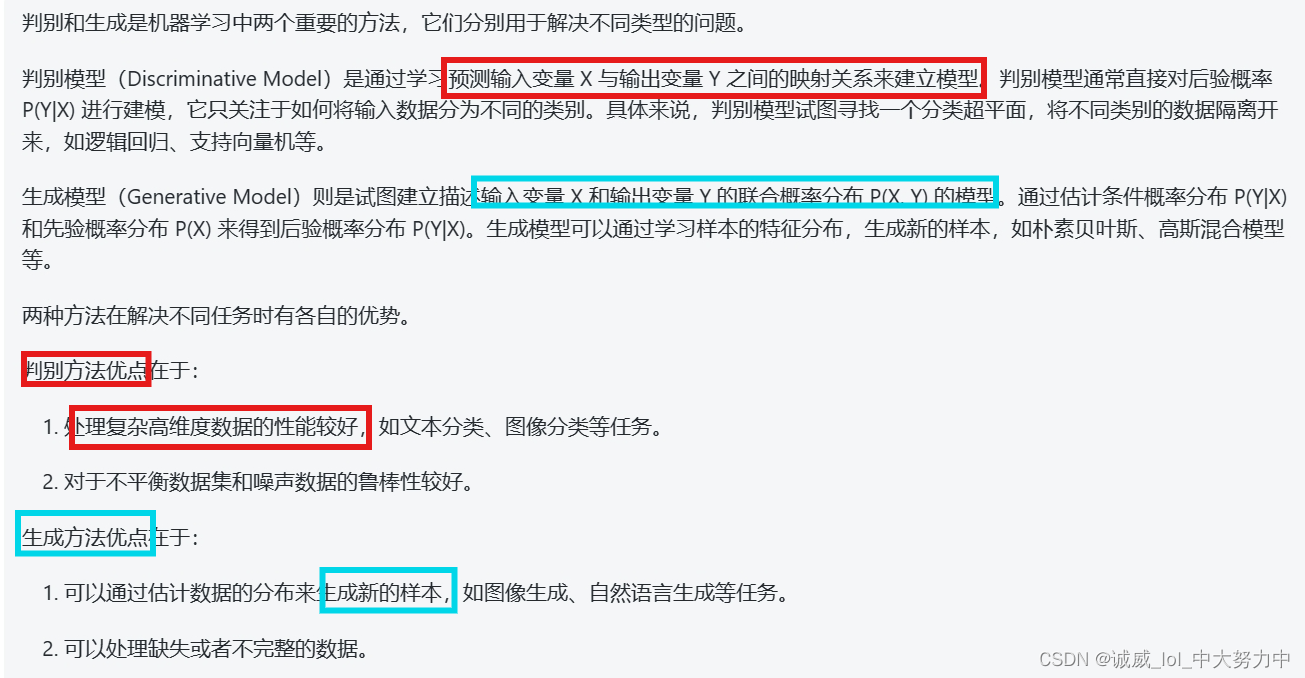

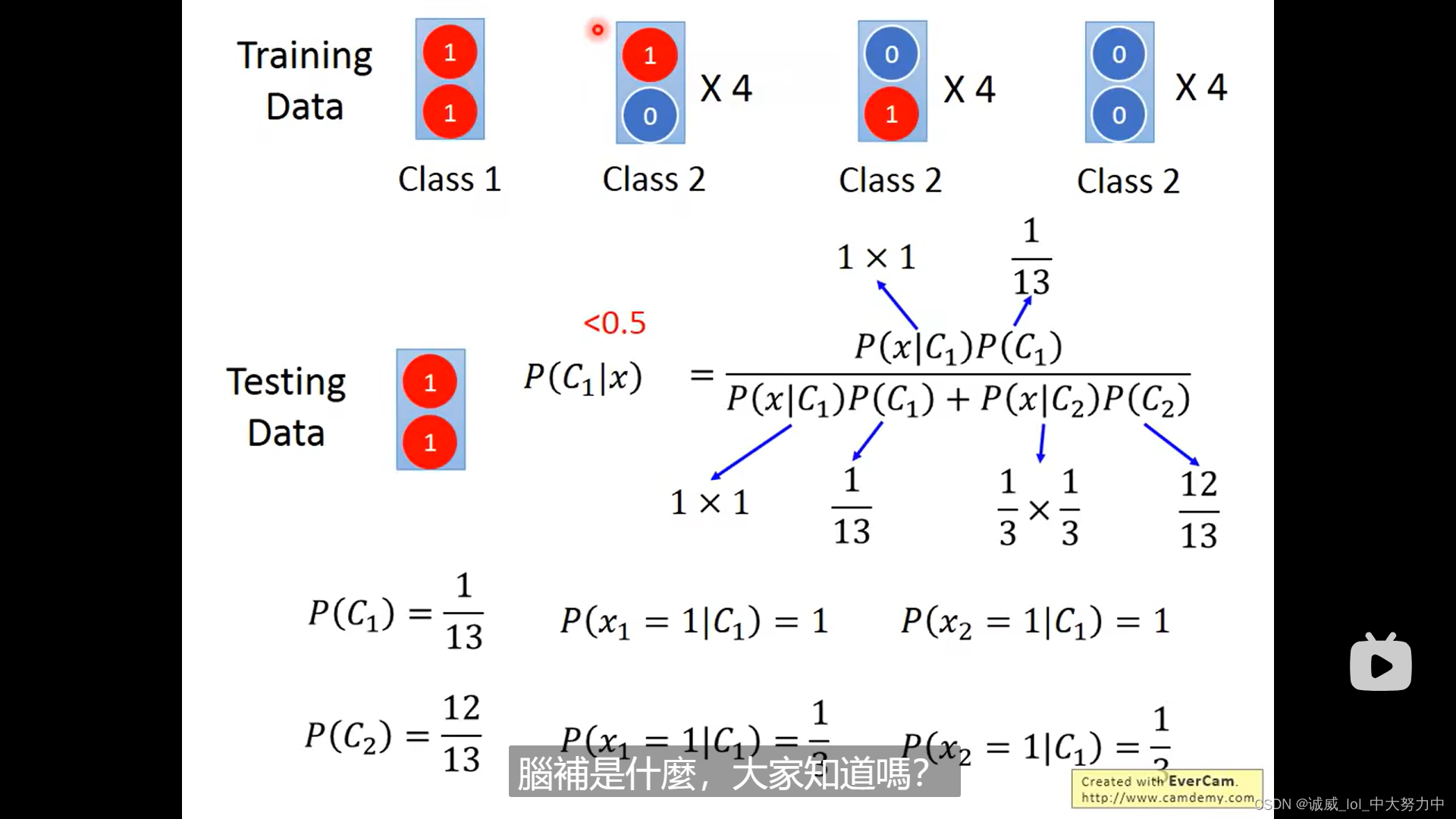

但是,其实,根据李宏毅老师讲到的,generative model是做了一些假设的,比如,如果使用Naive Bayes的话,不同特征x1,x2...之间相互独立的话,其实是很容易出现较大的偏差的,因为不同特征变量xi之间实际是存在联系的,并不是独立的

当然,generative model在训练集很少,或者label存在问题等时候,是优于 discriminative model的,但是,通常情况下,discrimitive model 都是更优的

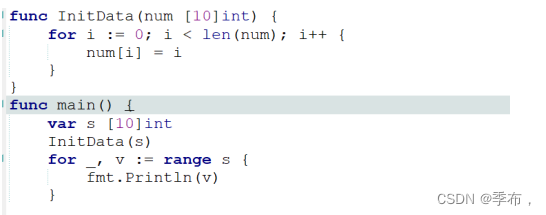

Naive Bayes的分类方法

原来softmax这个过程,主要就是进行 《拉大》“大的值”和“小的值”之间的差距,这也就是为什么叫做soft_max的原因,《拉大》的实现,就是下面取指数exponential

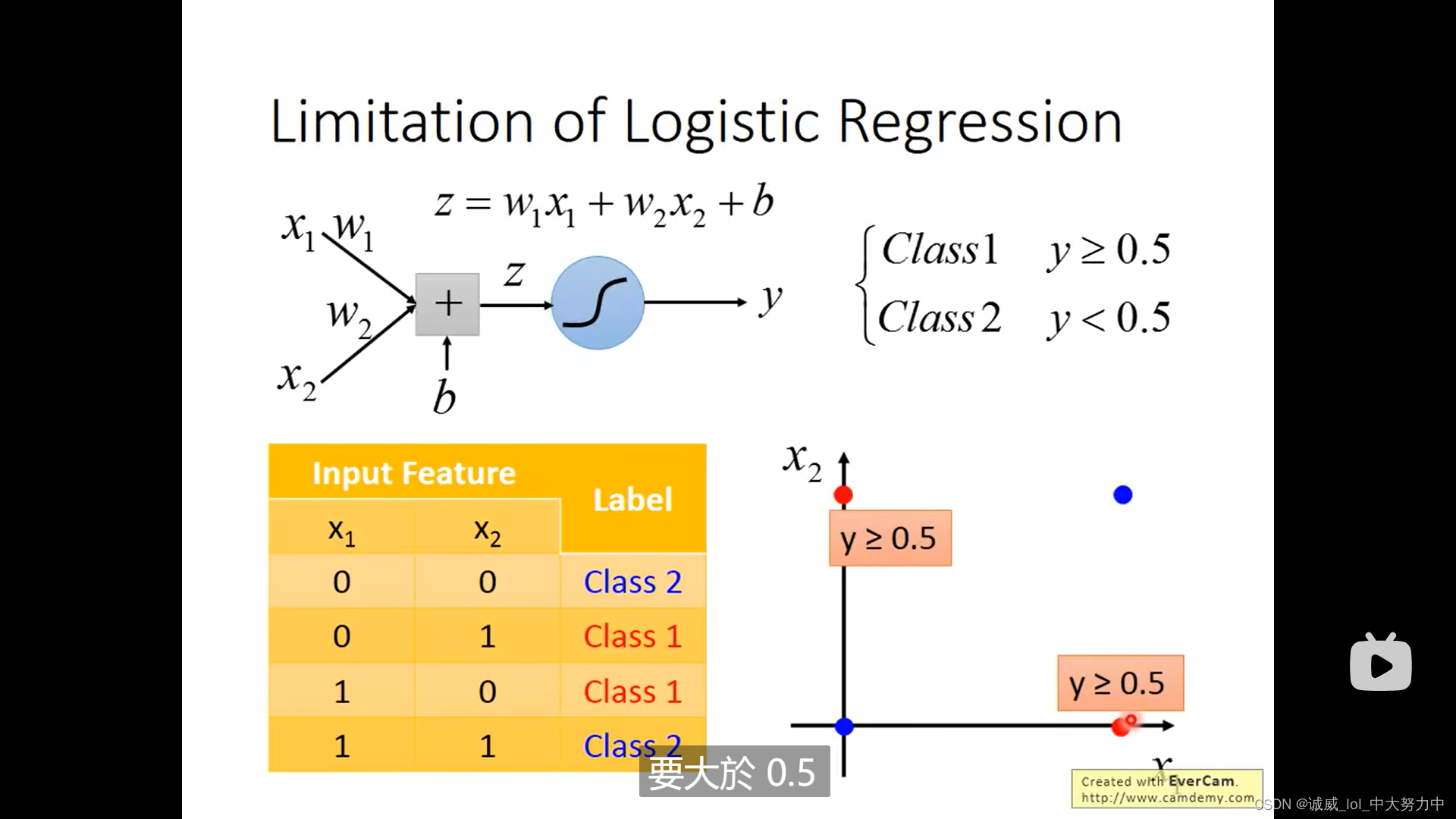

总的来说,Logistic regression这个逻辑回归,主要是用在 “classify分类的问题上”

(1)它是具备一定的局限性的:

如果只用1个logistic regreesion的话,下面就没办法进行二分类

(2)由于上述出现的问题是由于[x1,x2]这个feature本身的问题,所以考虑讲[x1,x2]统统进行一次transform得到[x1',x2'],然后,这个二分类又可以实现了

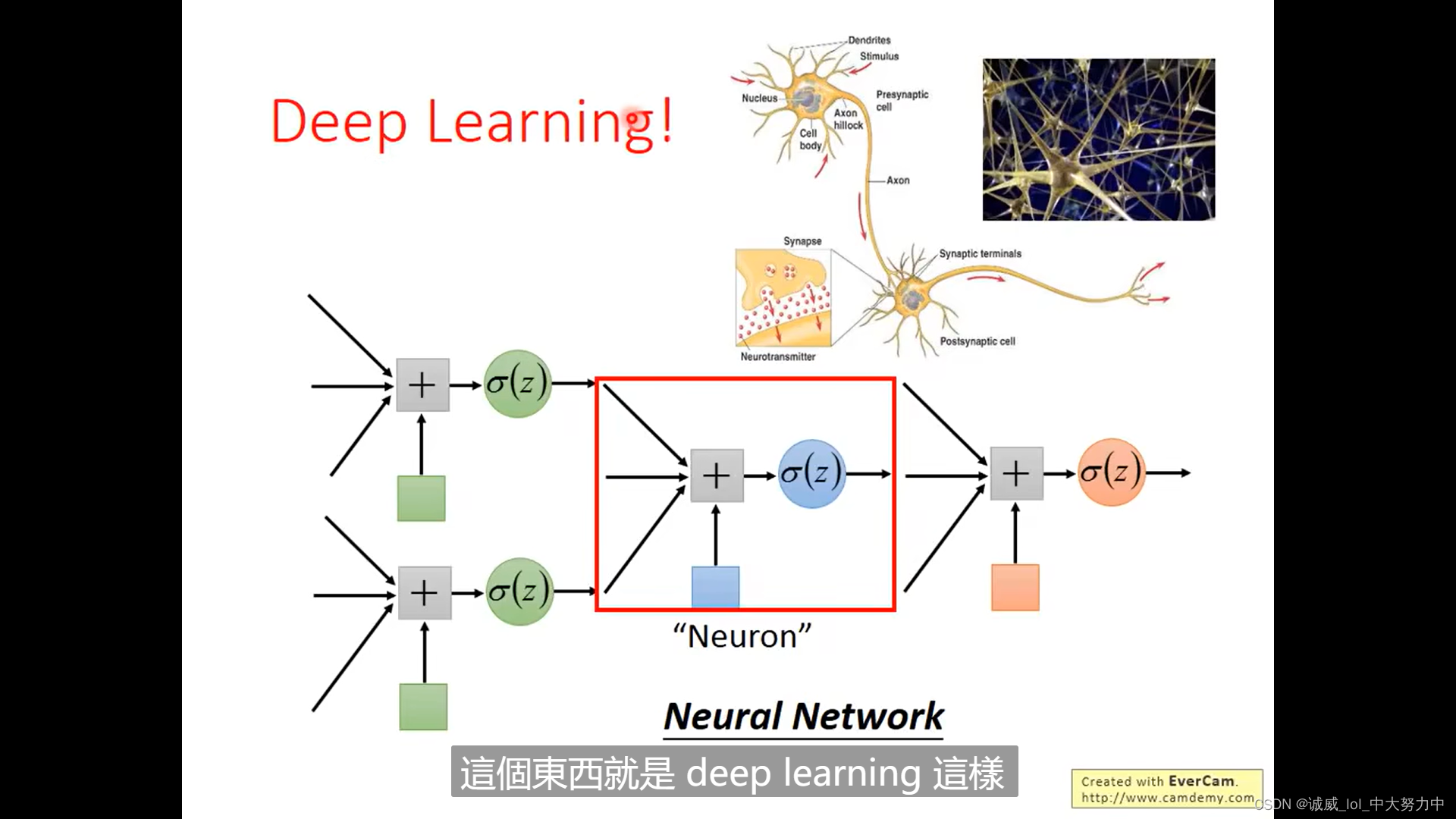

(3)不过呢,这个transform本身也可以不要“人为”的去想,而是利用 《多个logistic regreesion》进行实现,所以,每个logistic regression都作为一个neuron的话,那么就可以搭建起来一个 neuron network,也就是deep learning