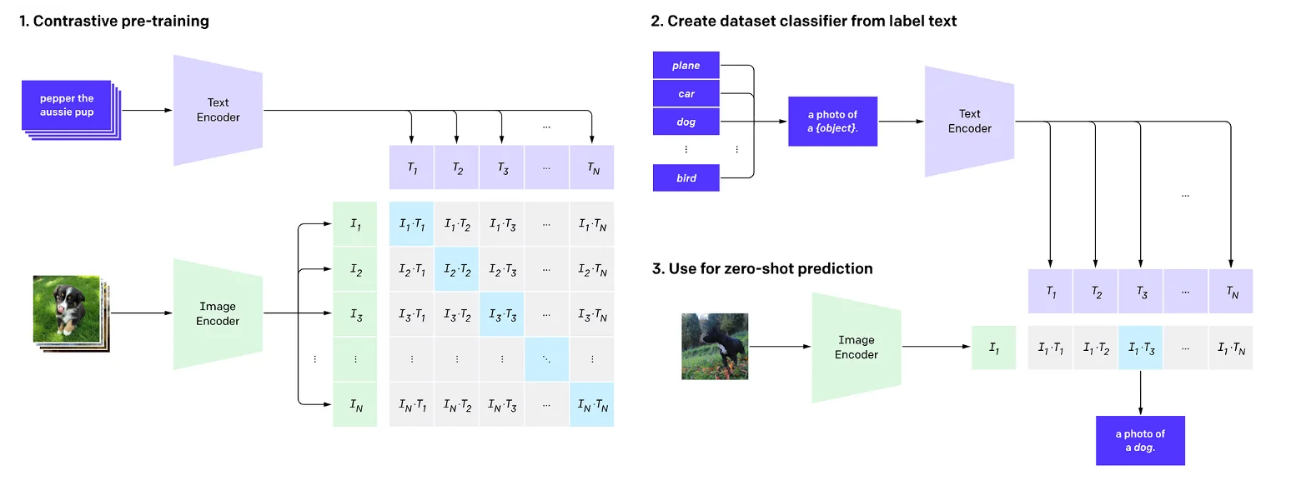

Contrastive Language-Image Pre-Training

- CLIP的主要目标是通过对比学习,学习匹配图像和文本。

- CLIP最主要的作用:可以将文本和图像表征映射到同一个表示空间

这是通过训练模型来预测哪个图像属于给定的文本,反之亦然。在训练过程中,模型学会了将图像和文本编码成统一的向量空间,这使得它能够在语言和视觉上理解它们之间的关系。

通过训练模型来预测哪个图像属于给定的文本,反之亦然。在训练过程中,模型学会了将图像和文本编码成统一的向量空间,这使得它能够在语言和视觉上理解它们之间的关系。

CLIP可以识别图像中的物体、场景、动作等元素,同时也能够理解与图像相关的文本,例如标签、描述、标题等。CLIP已被证明在视觉和语言任务上具有出色的表现。

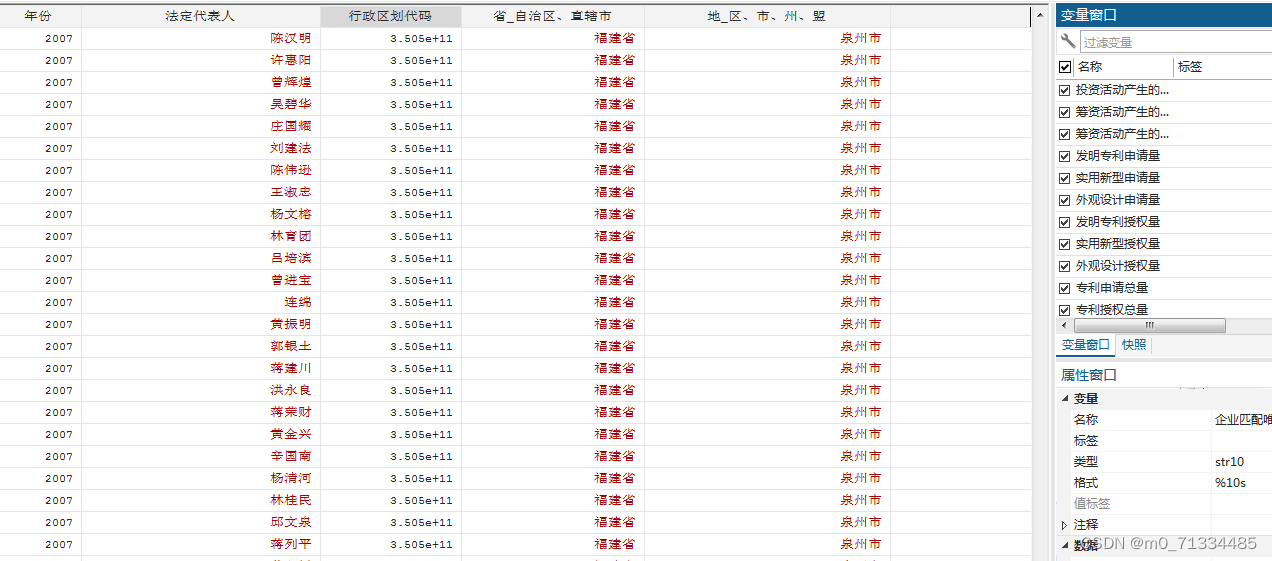

数据输入:text-image pairs

定义

论文中采用的两种文本编码器:CBOW或者Text Transformer(BERT family model)

论文中采用的两种图像编码器:ResNet和Vision Transformer (ViT)

定义了两个投影矩阵W_i和W_t,用于将文本及图像特征映射到相同维度大小。

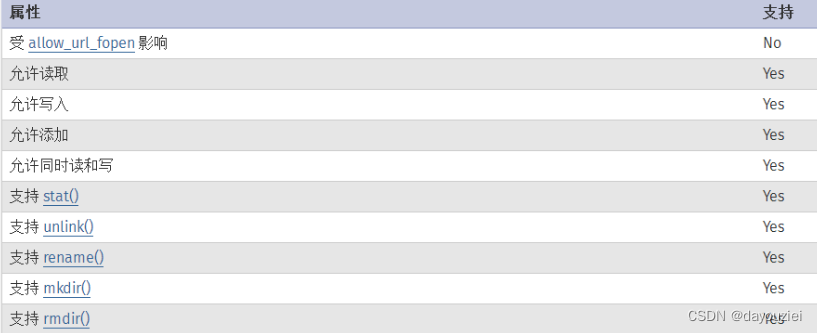

temperature参数用于控制softmax后的结果,temperature < 1 时模型倾向于给出更加极端的预测值(more confidence),temperture > 1 的时候模型预测值在更接近0.5 (less confidence)

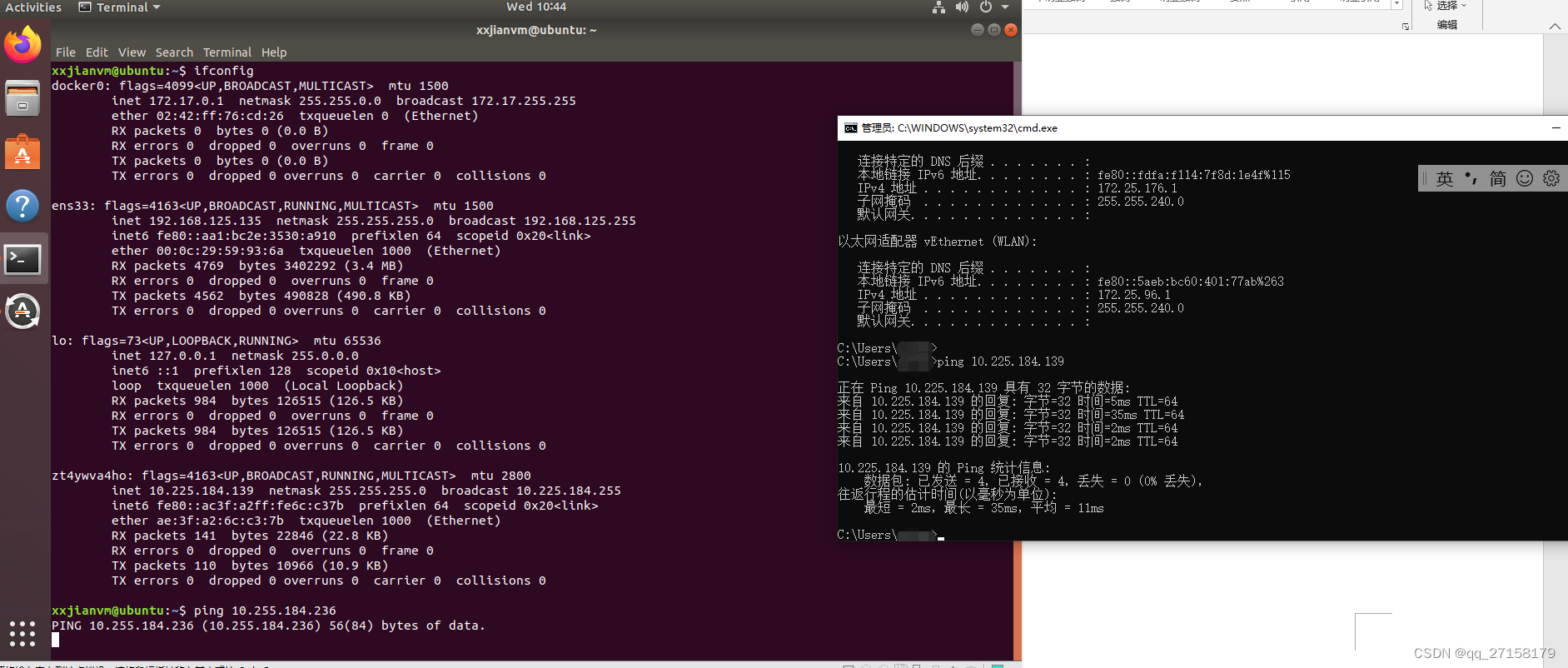

step 1 : 编码

通过图像&文本编码器,得分图像和文本特征。

step2 : 投影

首先通过投影矩阵将图像及文本特征映射到相同的维度大小,在进行L2 normalization (使得之后的点积操作直接等效于cosine similarity)

step3: 相似度计算

点积运算计算文本-图像的cosine similarity,得到 n x n 矩阵的logits(模型预测),越接近1则说明模型预测该文本-图像对是配对的,否则不配对。

step4: 计算loss

已知 logits 矩阵对角线的文本和图像是配对的,非对角线元素不配对,因此构造训练标签 np.arange(n),然后分别在图像维度(axis=0) 和文本维度(axis=1)计算loss。

以图像维度为例简单说明一下这里的逻辑,因为在计算相似度的时候,图像特征矩阵@文本特征矩阵得到的 n x n 矩阵,第一个n 代表的图像,因此我们在axis=0 计算图像维度的loss。