目录

数据清洗和处理

1.处理缺失值

1.1 删除缺失值:

1.2 填充缺失值:

1.3 插值:

2 数据类型转换

2.1 数据类型转换

2.2 日期和时间的转换:

2.3 分类数据的转换:

2.4 自定义数据类型的转换:

3 数据去重

4 数据合并和连接

数据清洗和处理

在数据清洗和处理方面,Pandas 提供了多种功能,包括处理缺失值、数据类型转换、数据去重以及数据合并和连接。以下是这些功能的详细描述和示例:

1.处理缺失值

在 Pandas 中处理缺失值有多种方法,包括删除缺失值、填充缺失值和插值。

1.1 删除缺失值:

删除缺失值是最简单的方法,但有时会导致数据损失。您可以使用 dropna() 方法来删除包含缺失值的行或列。

(1)删除包含缺失值的行:

import pandas as pddata = {'A': [1, 2, None, 4],'B': [5, None, 7, 8]}

df = pd.DataFrame(data)# 删除包含缺失值的行

df_cleaned = df.dropna()

print("删除包含缺失值的行的结果:\n", df_cleaned)

(2)删除包含缺失值的列:

# 删除包含缺失值的列

df_cleaned_columns = df.dropna(axis=1)

print("删除包含缺失值的列的结果:\n", df_cleaned_columns)

1.2 填充缺失值:

填充缺失值是用特定值替代缺失值的方法。您可以使用 fillna() 方法来填充缺失值。

使用特定值填充缺失值:

# 使用特定值填充缺失值

df_filled = df.fillna(0) # 用 0 填充缺失值

print("使用特定值填充缺失值的结果:\n", df_filled)

1.3 插值:

插值是一种基于数据的方法,根据已知数据点的值来估计缺失值。Pandas 提供了多种插值方法,如线性插值、多项式插值等。

(1) 线性插值:

线性插值使用已知数据点之间的线性关系来估计缺失值。这是一种简单而常见的插值方法。

import pandas as pddata = {'A': [1, 2, None, 4],'B': [5, None, 7, 8]}

df = pd.DataFrame(data)# 使用线性插值填充缺失值

df_interpolated = df.interpolate()

print("使用线性插值填充缺失值的结果:\n", df_interpolated)

(2) 多项式插值:

多项式插值使用多项式函数来逼近已知数据点,以估计缺失值。您可以指定多项式的阶数。

# 使用多项式插值填充缺失值(阶数为2)

df_poly_interpolated = df.interpolate(method='polynomial', order=2)

print("使用多项式插值填充缺失值的结果:\n", df_poly_interpolated)

(3) 时间序列插值:

对于时间序列数据,可以使用时间相关的插值方法,例如时间线性插值。

# 创建一个带有时间索引的示例 DataFrame

data = {'A': [1, 2, None, 4],'B': [5, None, 7, 8]}

dates = pd.date_range(start='2021-01-01', periods=len(data))

df_time_series = pd.DataFrame(data, index=dates)# 使用时间线性插值填充缺失值

df_time_series_interpolated = df_time_series.interpolate(method='time')

print("使用时间线性插值填充缺失值的结果:\n", df_time_series_interpolated)

2 数据类型转换

在 Pandas 中,数据类型转换是将一列或多列的数据类型更改为其他数据类型的过程。数据类型的转换可以帮助您适应特定的分析需求或确保数据的一致性。以下是一些常见的数据类型转换操作以及示例:

2.1 数据类型转换

- 使用

astype()方法将一列的数据类型转换为其他数据类型,如将整数列转换为浮点数列。 - 使用

pd.to_numeric()将列转换为数值类型,例如整数或浮点数。

import pandas as pd# 创建示例 DataFrame

data = {'A': [1, 2, 3],'B': ['4', '5', '6']}

df = pd.DataFrame(data)# 将列 'A' 从整数转换为浮点数

df['A'] = df['A'].astype(float)# 将列 'B' 从字符串转换为整数

df['B'] = pd.to_numeric(df['B'])print(df)

DataFrame 中的数据类型转换:

df.astype(dtype, copy=True, errors='raise')

dtype: 要将数据类型转换为的目标数据类型。可以是 NumPy 的数据类型(如np.float32)或 Python 数据类型(如float或int)。copy(可选,默认为 True):指定是否返回副本(True)或修改原始 DataFrame(False)。errors(可选,默认为 'raise'):指定如何处理转换错误。如果为 'raise',则会引发异常;如果为 'coerce',则将无法转换的值设置为 NaN。

Series 中的数据类型转换:

s.astype(dtype, copy=True, errors='raise')

import pandas as pd# 创建一个示例 DataFrame

data = {'A': [1, 2, 3],'B': [4, 5, 6]}

df = pd.DataFrame(data)# 将列 'A' 从整数转换为浮点数

df['A'] = df['A'].astype(float)# 将列 'B' 从整数转换为字符串

df['B'] = df['B'].astype(str)# 将列 'C' 从字符串转换为整数并处理转换错误(设置无法转换的值为 NaN)

df['C'] = pd.to_numeric(df['C'], errors='coerce').astype(int)print(df.dtypes)

上述示例中,我们演示了如何使用

astype()和pd.to_numeric()进行数据类型的转换,包括整数转浮点数、整数转字符串以及字符串转整数并处理转换错误的情况。

2.2 日期和时间的转换:

- 使用

pd.to_datetime()将列转换为日期时间类型,以便进行日期时间操作。

import pandas as pd# 创建示例 DataFrame

data = {'Date': ['2021-01-01', '2021-01-02', '2021-01-03'],'Value': [10, 15, 20]}

df = pd.DataFrame(data)# 将 'Date' 列从字符串转换为日期时间类型

df['Date'] = pd.to_datetime(df['Date'])print(df.dtypes)

2.3 分类数据的转换:

- 使用

astype('category')将列转换为分类数据类型,适用于有限的离散值。

import pandas as pd# 创建示例 DataFrame

data = {'Category': ['A', 'B', 'A', 'C']}

df = pd.DataFrame(data)# 将 'Category' 列转换为分类数据类型

df['Category'] = df['Category'].astype('category')print(df.dtypes)

2.4 自定义数据类型的转换:

- 您可以使用自定义函数来将数据转换为所需的数据类型,例如使用

apply()方法。

import pandas as pd# 创建示例 DataFrame

data = {'Numbers': ['1', '2', '3', '4']}

df = pd.DataFrame(data)# 自定义函数将字符串转换为整数并应用到 'Numbers' 列

df['Numbers'] = df['Numbers'].apply(lambda x: int(x))print(df.dtypes)

3 数据去重

在 Pandas 中,您可以使用 drop_duplicates() 方法来删除重复的行。这个方法会返回一个新的 DataFrame,其中不包含重复的行。以下是如何在 Pandas 中执行数据去重操作的示例:

import pandas as pd# 创建示例 DataFrame

data = {'Name': ['Alice', 'Bob', 'Alice', 'David', 'Bob'],'Age': [25, 30, 25, 40, 30]}

df = pd.DataFrame(data)# 执行去重操作,基于所有列

df_no_duplicates = df.drop_duplicates()print("原始 DataFrame:")

print(df)print("\n去重后的 DataFrame:")

print(df_no_duplicates)

上述示例中,drop_duplicates() 方法将基于所有列的内容来去重。如果要基于特定列进行去重,您可以通过传递 subset 参数来指定:

# 基于 'Name' 列进行去重

df_no_duplicates_name = df.drop_duplicates(subset=['Name'])print("基于 'Name' 列去重后的 DataFrame:")

print(df_no_duplicates_name)

您还可以使用 keep 参数来控制保留哪一个重复值。例如,keep='first'(默认值)将保留第一个出现的值,而 keep='last' 将保留最后一个出现的值:

# 基于 'Name' 列进行去重,保留最后一个出现的值

df_keep_last = df.drop_duplicates(subset=['Name'], keep='last')print("基于 'Name' 列去重,保留最后一个出现的值的 DataFrame:")

print(df_keep_last)

这些示例演示了如何使用 Pandas 进行数据去重。根据您的需求,您可以选择不同的去重方式。

4 数据合并和连接

在 Pandas 中,您可以使用不同的方法进行数据合并和连接,这通常用于将多个数据集组合在一起以进行分析。以下是一些常见的数据合并和连接操作以及示例:

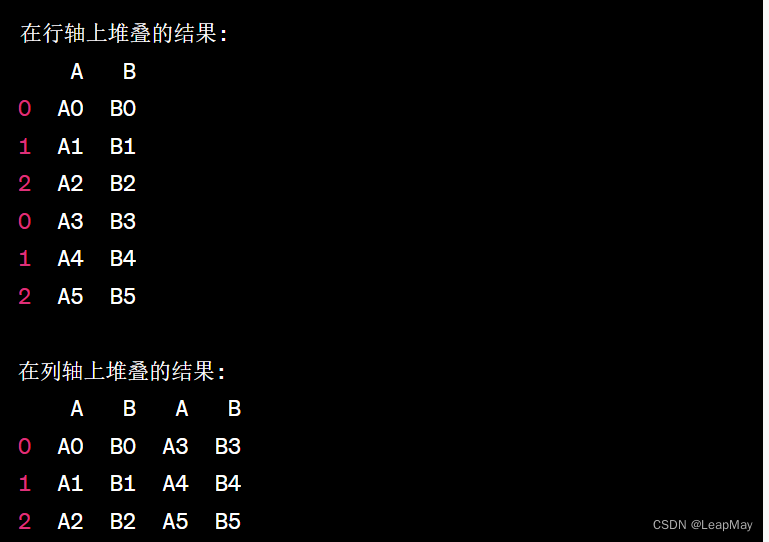

4.1 pd.concat():

用于将多个 DataFrame 沿指定轴(通常是行轴或列轴)堆叠在一起。pd.concat() 默认在行轴(axis=0)上堆叠多个 DataFrame,也就是沿着行方向将它们连接在一起。如果您想在列轴(axis=1)上堆叠多个 DataFrame,可以通过指定 axis 参数为1 来实现。

import pandas as pd# 创建两个示例 DataFrame

df1 = pd.DataFrame({'A': ['A0', 'A1', 'A2'],'B': ['B0', 'B1', 'B2']})df2 = pd.DataFrame({'A': ['A3', 'A4', 'A5'],'B': ['B3', 'B4', 'B5']})# 在行轴上堆叠两个 DataFrame

result1 = pd.concat([df1, df2])# 在列轴上堆叠两个 DataFrame

result2 = pd.concat([df1, df2], axis=1)print(result1,result2)

输出:

4.2 pd.merge():

用于基于一个或多个键(列)将两个 DataFrame 合并在一起,类似于 SQL 的 JOIN 操作。

import pandas as pd# 创建两个示例 DataFrame

left = pd.DataFrame({'key': ['K0', 'K1', 'K2'],'value_left': ['V0', 'V1', 'V2']})right = pd.DataFrame({'key': ['K1', 'K2', 'K3'],'value_right': ['V3', 'V4', 'V5']})# 基于 'key' 列进行合并

result = pd.merge(left, right, on='key')print(result)

输出

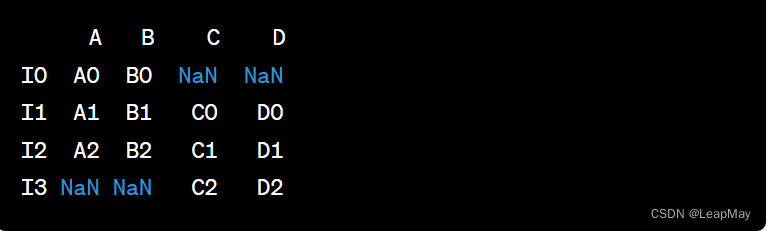

4.3 df.join():

用于将两个 DataFrame 沿索引合并。

import pandas as pd# 创建两个示例 DataFrame

df1 = pd.DataFrame({'A': ['A0', 'A1', 'A2'],'B': ['B0', 'B1', 'B2']}, index=['I0', 'I1', 'I2'])df2 = pd.DataFrame({'C': ['C0', 'C1', 'C2'],'D': ['D0', 'D1', 'D2']}, index=['I1', 'I2', 'I3'])# 沿索引合并两个 DataFrame

result = df1.join(df2)print(result)

输出:

这些是一些常见的数据合并和连接操作示例。根据您的需求,您可以选择适当的方法来合并和连接数据集。 Pandas 提供了丰富的选项和参数,以满足不同的合并和连接需求。