介绍

网络爬虫是从网站收集数据的强大技术,而Python是这项任务中最流行的语言之一。然而,构建一个强大的网络爬虫不仅仅涉及到获取网页并解析其HTML。在本文中,我们将为您介绍创建一个网络爬虫的过程,这个爬虫不仅可以获取和保存网页内容,还可以遵循最佳实践。无论您是初学者还是经验丰富的开发人员,本指南都将为您提供构建既有效又尊重被抓取网站的网络爬虫所需的工具。

设置您的环境

在深入代码之前,请确保您的计算机上已安装Python。您还需要安装requests和BeautifulSoup库。您可以使用pip来安装它们:

pip install requests beautifulsoup4基本网络爬虫

让我们首先查看一个简单的网络爬虫脚本。此脚本获取一个网页,提取其标题和文本内容,并将它们保存到文本文件中。

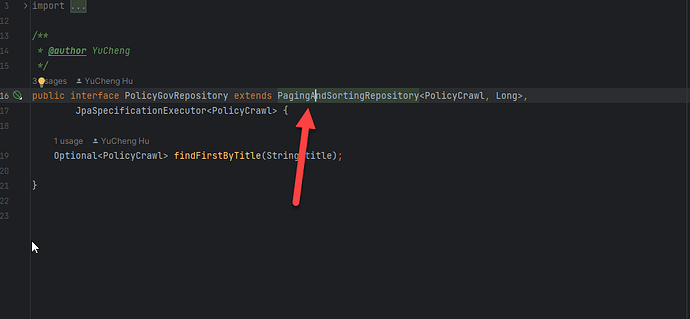

import os

import requests

from bs4 import BeautifulSoup

from urllib.parse import urljoin

# ...(其余代码)为什么使用requests和BeautifulSoup?

Requests:此库允许您发送HTTP请求并处理响应,因此在获取网页时至关重要。

BeautifulSoup:此库用于解析HTML并提取所需的数据。

创建输出目录

在进行抓取之前,有一个目录可以保存抓取到的数据非常关键。

if not os.path.exists(output_folder):os.makedirs(output_folder)为什么这很重要?

创建专用的输出目录有助于组织抓取到的数据,使以后的分析更加容易。

网页遍历

该脚本使用广度优先搜索方法来遍历网页。它维护一个 visited 集合和一个 to_visit 的URL列表。

visited = set()

to_visit = [base_url]网页遍历的必要性

网页遍历对于从一个网站抓取多个页面非常重要。visited 的集合确保您不会重新访问相同的页面,而 to_visit 的列表则用作您打算抓取的页面的队列。

获取和解析网页

获取网页涉及发送HTTP GET请求,而解析涉及将HTML内容转换为BeautifulSoup对象。

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')为什么获取和解析?

获取可获取原始HTML内容,但解析允许您浏览此内容并提取所需的数据。

数据提取和存储

该脚本从各种HTML标签中提取标题和文本内容,并将它们保存到文本文件中。

title = soup.title.string if soup.title else "未找到标题"

# ...(其余代码)数据提取和存储的重要性

数据提取是网络爬虫的核心。有效存储这些数据有助于更容易地进行分析和共享。

错误处理和速率限制

该脚本检查HTTP状态码,但缺乏全面的错误处理和速率限制。

if response.status_code != 200:print(f"无法检索{url}。状态码:{response.status_code}")为什么需要错误处理和速率限制?

错误处理确保您的爬虫可以从意外问题中恢复,而速率限制可以防止您的爬虫过于频繁地访问服务器并被封锁IP地址。

网络爬虫的效用

网络爬虫不仅仅是一个技术练习;它具有现实世界的应用,可以推动业务决策、学术研究等各种领域。

为什么网络爬虫很重要?

数据汇总:网络爬虫允许您将来自各种来源的数据收集到一个地方。这对于市场研究、情感分析或竞争分析特别有用。

自动化:手动收集数据可能会耗费时间并且容易出错。网络爬虫自动化了这个过程,节省了时间并减少了错误。

内容监控:您可以使用网络爬虫来监控竞争对手网站、股价或新闻更新等内容的变化。

机器学习和数据分析:通过网络爬虫收集的数据可以用于训练机器学习模型或进行高级数据分析。

SEO监控:网络爬虫可以帮助跟踪您的网站的SEO表现,为您提供如何提高搜索引擎排名的见解。

强大网络爬虫的高级功能

虽然基本爬虫是功能性的,但缺少一些功能,这些功能可以使它更强大和多功能。让我们讨论一些您可能考虑添加的高级功能。

用户代理和头文件

一些网站可能会阻止不包含用户代理字符串的请求,该字符串用于识别发出请求的客户端。

headers = {'User-Agent': 'your-user-agent-string'}

response = requests.get(url, headers=headers)代理轮换

为了避免IP地址被封锁,您可以使用多个IP地址发出请求。

proxies = {'http': 'http://10.10.1.10:3128'}

response = requests.get(url, proxies=proxies)CAPTCHA处理

一些网站使用CAPTCHA来防止自动抓取。虽然可以使用selenium等库来处理这些挑战,但这可能会使您的爬虫变得更加复杂。

from selenium import webdriverdriver = webdriver.Firefox()

driver.get(url)

# ...(CAPTCHA处理代码)数据存储

您可以考虑使用MongoDB或SQL数据库来存储抓取的数据,而不是将其存储在文本文件中,以实现更结构化和可扩展的存储。

import pymongoclient = pymongo.MongoClient("mongodb://localhost:27017/")

db = client["抓取的数据"]

collection = db["网页"]

collection.insert_one({"url": url, "title": title, "content": full_text})将它们组合起来

import os

import time

import requests

from bs4 import BeautifulSoup

from urllib.parse import urljoindef fetch_content(base_url, output_folder):if not os.path.exists(output_folder):os.makedirs(output_folder)visited = set()to_visit = [base_url]headers = {'User-Agent': 'your-user-agent-string'}while to_visit:url = to_visit.pop(0)if url in visited: continuetry:response = requests.get(url, headers=headers, timeout=10)response.raise_for_status()except requests.RequestException as e: print(f"无法检索{url}。错误:{e}") continuevisited.add(url)soup = BeautifulSoup(response.text, 'html.parser')title = soup.title.string if soup.title else "未找到标题"text_content = [] for paragraph in soup.find_all(['p', 'div', 'h1', 'h2', 'h3', 'h4', 'h5', 'h6']):text_content.append(paragraph.text)full_text = "\n".join(text_content)output_file_path = os.path.join(output_folder, f"{len(visited)}.txt") with open(output_file_path, 'w', encoding='utf-8') as f:f.write(f"URL: {url}\n")f.write(f"Title: {title}\n")f.write("=====================================\n")f.write(f"Text Content:\n{full_text}\n\n") print(f"已保存从{url}抓取的数据到{output_file_path}") for a_tag in soup.find_all('a', href=True):next_url = urljoin(base_url, a_tag['href']) if base_url in next_url:to_visit.append(next_url)time.sleep(1) # 速率限制以避免过于频繁地访问服务器if __name__ == "__main__":base_url = "https://www.example.com/"output_folder = "抓取的页面"fetch_content(base_url, output_folder)关键添加

用户代理字符串:headers字典包含一个用户代理字符串,以帮助绕过网站上的基本安全检查。

headers = {'User-Agent': 'your-user-agent-string'}错误处理:在requests.get()方法周围的try-except块可以优雅地处理与网络相关的错误。

try:response = requests.get(url, headers=headers, timeout=10)response.raise_for_status()

except requests.RequestException as e: print(f"无法检索{url}。错误:{e}") continue速率限制:添加了time.sleep(1)以在请求之间暂停一秒钟,减少IP地址被封锁的风险。

time.sleep(1)通过添加这些功能,我们使网络爬虫更加强大,并确保其尊重与之交互的网站。这是一个很好的起点,随着您继续完善网络爬虫,您可以添加更多高级功能,如代理轮换、CAPTCHA处理和数据库存储。

结论和未来方向

网络爬虫是一个功能强大的工具,具有广泛的应用,从业务到学术都有。然而,构建一个强大的网络爬虫不仅仅涉及到获取网页并解析其HTML。本文为您提供了每个步骤的综合指南,不仅解释了如何实现每个功能,还解释了每个功能为什么必要。

在继续完善您的网络爬虫时,考虑添加高级功能,如用户代理字符串、代理轮换、CAPTCHA处理和数据库存储。这些功能将使您的爬虫更加强大、多功能,并确保尊重您正在抓取的网站。有了这些工具,您将成功迈向成为一个网络爬虫专家。祝愉快抓取!

· END ·

HAPPY LIFE

本文仅供学习交流使用,如有侵权请联系作者删除

![MongoDB【部署 02】mongodb使用配置文件启动、添加为系统服务及自启动(一个报错:[13436][NotMasterOrSecondary])](https://img-blog.csdnimg.cn/d9f243d80b764bb6b382c6393a64d803.jpeg#pic_center)