AI视野·今日CS.NLP 自然语言处理论文速览

Thu, 21 Sep 2023

Totally 57 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| Chain-of-Verification Reduces Hallucination in Large Language Models Authors Shehzaad Dhuliawala, Mojtaba Komeili, Jing Xu, Roberta Raileanu, Xian Li, Asli Celikyilmaz, Jason Weston 生成看似合理但不正确的事实信息(称为幻觉)是大型语言模型中尚未解决的问题。我们研究语言模型仔细考虑其给出的响应以纠正错误的能力。我们开发了验证链 CoVe 方法,模型首先 i 起草初始响应,然后 ii 计划验证问题以对其草案进行事实核查 iii 独立回答这些问题,这样答案就不会受到其他响应的影响,iv 生成最终经过验证的响应。 |

| Controlled Generation with Prompt Insertion for Natural Language Explanations in Grammatical Error Correction Authors Masahiro Kaneko, Naoaki Okazaki 在语法错误纠正GEC中,确保用户理解纠正原因至关重要。现有的研究提出了关于纠正基础的标记、例子和提示,但没有直接解释纠正的原因。尽管已经针对各种任务提出了使用大型语言模型 LLM 提供自然语言直接解释的方法,但 GEC 不存在这样的方法。生成 GEC 校正的解释涉及对齐输入和输出标记、识别校正点并一致地呈现相应的解释。然而,指定复杂的格式来生成解释并不简单,因为通过提示很难显式控制生成。本研究引入了一种称为“Prompt Insertion PI 控制生成”的方法,以便法学硕士可以用自然语言解释更正的原因。在PI中,LLM首先纠正输入文本,然后我们根据规则自动提取纠正点。提取的校正点作为提示依次插入LLM的解释输出中,指导LLM生成校正点的解释。我们还通过注释 NUCLE、CoNLL2013 和 CoNLL2014 创建了可解释的修正原因 GEC XGEC 数据集。 |

| You Only Look at Screens: Multimodal Chain-of-Action Agents Authors Zhuosheng Zhan, Aston Zhang 自主用户界面 UI 代理旨在通过与用户界面交互而无需手动干预来促进任务自动化。最近的研究调查了大型语言模型法学硕士在不同环境中有效参与的能力。为了满足法学硕士的输入输出要求,现有的方法是在沙箱设置下开发的,它们依赖外部工具和特定于应用程序的 API 将环境解析为文本元素并解释预测的操作。因此,这些方法经常面临推理效率低下和错误传播风险的问题。为了缓解这些挑战,我们引入了 Auto UI,这是一种直接与界面交互的多模式解决方案,绕过了环境解析的需要或对应用程序相关 API 的依赖。此外,我们提出了一种行动链技术,利用一系列中间的先前行动历史和未来行动计划来帮助代理决定执行什么行动。我们在新的设备控制基准 AITW 上评估我们的方法,该基准具有 30K 独特指令,涵盖应用程序操作、网络搜索和网络购物等多步骤任务。实验结果表明,Auto UI 实现了最先进的性能,动作类型预测准确度为 90 ,总体动作成功率为 74 。 |

| Kosmos-2.5: A Multimodal Literate Model Authors Tengchao Lv, Yupan Huang, Jingye Chen, Lei Cui, Shuming Ma, Yaoyao Chang, Shaohan Huang, Wenhui Wang, Li Dong, Weiyao Luo, Shaoxiang Wu, Guoxin Wang, Cha Zhang, Furu Wei 我们推出了 Kosmos 2.5,这是一种用于机器阅读文本密集型图像的多模式读写模型。 Kosmos 2.5 在大规模文本密集型图像上进行了预训练,在两个不同但协作的转录任务中表现出色:1 生成空间感知文本块,其中每个文本块在图像中分配其空间坐标;2 生成捕获样式和内容的结构化文本输出。结构转换为 Markdown 格式。这种统一的多模式读写能力是通过共享 Transformer 架构、特定于任务的提示和灵活的文本表示来实现的。我们在端到端文档级文本识别和图像到 Markdown 文本生成方面评估 Kosmos 2.5。此外,该模型可以通过监督微调轻松适应任何具有不同提示的文本密集型图像理解任务,使其成为涉及文本丰富图像的现实世界应用的通用工具。 |

| Safurai 001: New Qualitative Approach for Code LLM Evaluation Authors Davide Cifarelli, Leonardo Boiardi, Alessandro Puppo 本文介绍了 Safurai 001,一种新的大型语言模型法学硕士,在编码辅助领域具有巨大潜力。在编码 LLM 最新进展的推动下,Safurai 001 在性能方面可与 WizardCoder Xu et al., 2023 、PanguCoder Shen et al., 2023 和 Phi 1 Gunasekar et al., 2023 等最新模型竞争,但旨在提供更具对话性的交互。通过利用数据工程的进步,包括最新的数据转换技术以及即时工程和指令调整,这种新模型有望与最近的封闭和开源开发并驾齐驱。认识到编码 LLM 需要有效的评估指标,本文还介绍了基于 GPT4 的 MultiParameters,这是一种评估基准,利用各种参数来全面了解模型的功能和性能。 |

| Long-Form End-to-End Speech Translation via Latent Alignment Segmentation Authors Peter Pol k, Ond ej Bojar 当前的同步语音翻译模型只能处理长达几秒钟的音频。当代数据集根据人类注释的转录本和翻译提供了对句子的预言分割。然而,在现实世界中无法实现句子的分割。当前的语音分割方法要么提供较差的分割质量,要么必须以延迟换取质量。在本文中,我们提出了一种用于低延迟端到端语音翻译的新颖分割方法。我们利用现有的语音翻译编码器解码器架构和 ST CTC,并表明它可以在没有监督或附加参数的情况下执行分割任务。据我们所知,我们的方法是第一个允许实际端到端同步语音翻译的方法,因为同一模型同时用于翻译和分割。 |

| Studying Lobby Influence in the European Parliament Authors Aswin Suresh, Lazar Radojevic, Francesco Salvi, Antoine Magron, Victor Kristof, Matthias Grossglauser 我们提出了一种基于自然语言处理 NLP 的方法,用于研究利益集团游说团体在欧洲议会 EP 立法过程中的影响。我们收集并分析游说立场文件和欧洲议会议员的演讲的新颖数据集。通过根据语义相似性和蕴涵比较这些文本,我们能够发现欧洲议会议员和游说团体之间可解释的联系。在缺乏此类链接的真实数据集的情况下,我们通过将发现的链接与我们策划的欧洲议会议员和游说者之间的转发链接数据集以及公开披露的欧洲议会议员会议进行比较来进行间接验证。我们最好的方法达到了 0.77 的 AUC 分数,并且表现明显优于几个基线。此外,对相关游说团体和欧洲议会议员政治团体之间发现的联系进行汇总分析,符合这些团体意识形态的期望,例如,中左翼团体与社会事业相关。 |

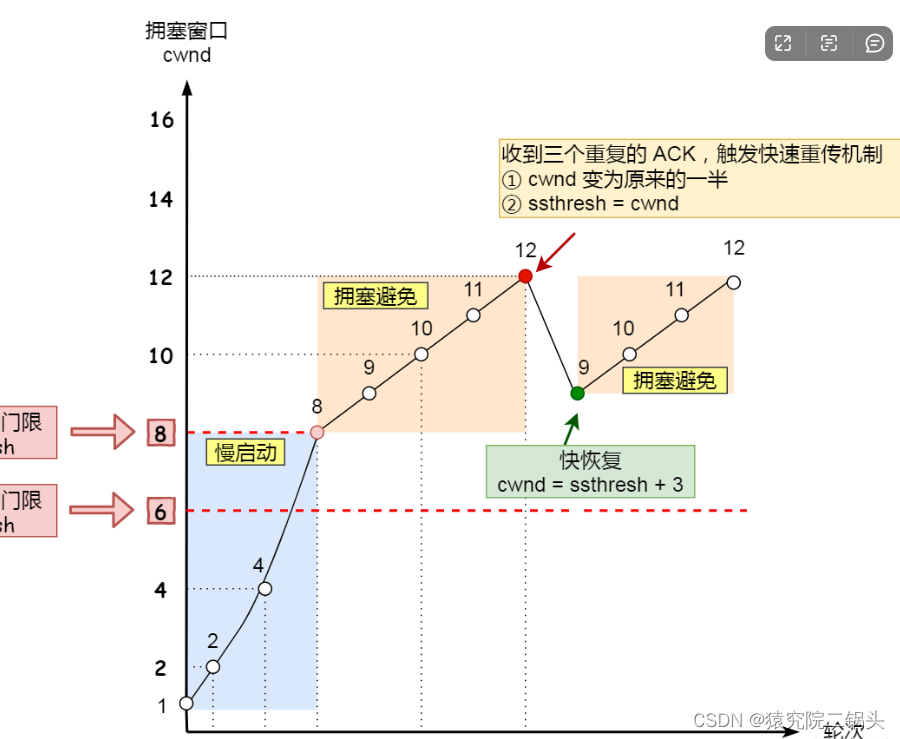

| Incremental Blockwise Beam Search for Simultaneous Speech Translation with Controllable Quality-Latency Tradeoff Authors Peter Pol k, Brian Yan, Shinji Watanabe, Alex Waibel, Ond ej Bojar 块式自注意力编码器模型最近已成为一种有前途的同步语音翻译端到端方法。这些模型采用带有假设可靠性评分的分块波束搜索来确定何时在进一步翻译之前等待更多输入语音。然而,该方法维持多个假设,直到整个语音输入被消耗为止,该方案不能直接向用户显示单个文本增量翻译。此外,该方法缺乏控制质量与延迟权衡的机制。我们提出了一种改进的增量分块波束搜索,结合了本地协议或保持 n 策略以进行质量延迟控制。 |

| GECTurk: Grammatical Error Correction and Detection Dataset for Turkish Authors Atakan Kara, Farrin Marouf Sofian, Andrew Bond, G zde G l ahin 事实证明,语法错误检测和纠正 GEC 工具对于母语人士和第二语言学习者非常有用。开发此类工具需要大量并行的带注释的数据,而这对于大多数语言来说是不可用的。合成数据生成是克服此类数据稀缺性的常见做法。然而,对于像土耳其语这样形态丰富的语言来说,这并不简单,因为复杂的书写规则需要语音、形态和句法信息。在这项工作中,我们为土耳其语提供了一个灵活且可扩展的合成数据生成管道,涵盖 20 多个专家策划的语法和拼写规则(又称,通过复杂的转换函数实现的编写规则)。使用此管道,我们从专业编辑的文章中得出 130,000 个高质量的平行句子。此外,我们通过手动注释一组电影评论来创建更真实的测试集。我们实现了三个基线,将任务制定为 i 神经机器翻译、ii 序列标记和 iii 使用预训练解码器模型进行前缀调整,取得了很好的结果。此外,我们对域外数据集进行了详尽的实验,以深入了解所提出方法的可转移性和鲁棒性。我们的结果表明,我们的语料库 GECTurk 质量很高,并且允许在域外环境中进行知识转移。 |

| TRAVID: An End-to-End Video Translation Framework Authors Prottay Kumar Adhikary, Bandaru Sugandhi, Subhojit Ghimire, Santanu Pal, Partha Pakray 在当今全球化的世界中,与来自不同语言背景的人们进行有效的沟通变得越来越重要。虽然传统的语言翻译方法(例如书面文本或纯语音翻译)可以完成任务,但它们往往无法捕捉通过面部表情和嘴唇动作等非语言线索传达的完整上下文和微妙信息。在本文中,我们提出了一种端到端视频翻译系统,该系统不仅可以翻译口语,还可以将翻译后的语音与说话者的嘴唇运动同步。我们的系统专注于将教育讲座翻译成各种印度语言,其设计目的是即使在资源匮乏的系统环境中也能发挥作用。通过结合与目标语言一致的嘴唇动作,并使用语音克隆技术将其与说话者的声音进行匹配,我们的应用程序为学生和用户提供了增强的体验。 |

| DISC-LawLLM: Fine-tuning Large Language Models for Intelligent Legal Services Authors Shengbin Yue, Wei Chen, Siyuan Wang, Bingxuan Li, Chenchen Shen, Shujun Liu, Yuxuan Zhou, Yao Xiao, Song Yun, Wei Lin, Xuanjing Huang, Zhongyu Wei 我们提出DISC LawLLM,这是一个利用大语言模型LLM提供广泛法律服务的智能法律系统。我们采用法律三段论提示策略构建中国司法领域的有监督微调数据集,并微调具有法律推理能力的法学硕士。我们通过检索模块增强法学硕士,以增强模型访问和利用外部法律知识的能力。提出了综合法律基准DISC Law Eval,从客观和主观维度评估智能法律系统。 DISC 法律评估的定量和定性结果证明了我们的系统在为不同法律场景中的不同用户提供服务方面的有效性。 |

| Rating Prediction in Conversational Task Assistants with Behavioral and Conversational-Flow Features Authors Rafael Ferreira, David Semedo, Jo o Magalh es 预测会话任务助手 CTA 的成功对于了解用户行为并采取相应行动至关重要。在本文中,我们提出了 TB Rater,一种 Transformer 模型,它将会话流特征与用户行为特征相结合,用于预测 CTA 场景中的用户评分。特别是,我们使用在 Alexa TaskBot 挑战赛中收集的真实人类代理对话和评级,这是一种新颖的多模式和多回合对话环境。我们的结果显示了在单个模型中对对话流程和对话行为方面进行建模以进行离线评分预测的优势。 |

| CPLLM: Clinical Prediction with Large Language Models Authors Ofir Ben Shoham, Nadav Rappoport 我们提出了使用大语言模型 CPLLM 进行临床预测,该方法涉及对预先训练的大语言模型 LLM 进行微调以进行临床疾病预测。我们利用量化并使用提示对 LLM 进行微调,其任务是利用患者的历史诊断记录来预测患者在下次就诊或随后的诊断中是否会被诊断出目标疾病。我们将我们的结果与各种基线进行了比较,包括 Logistic 回归、RETAIN 和 Med BERT,这是使用结构化 EHR 数据进行疾病预测的当前最先进的模型。 |

| Overview of AuTexTification at IberLEF 2023: Detection and Attribution of Machine-Generated Text in Multiple Domains Authors Areg Mikael Sarvazyan, Jos ngel Gonz lez, Marc Franco Salvador, Francisco Rangel, Berta Chulvi, Paolo Rosso 本文概述了 AuTexTification 共享任务,作为 SEPLN 2023 会议框架内伊比利亚语言评估论坛 IberLEF 2023 研讨会的一部分。 AuTexTification 由子任务 1 的两个子任务组成,参与者必须确定文本是人类创作的还是由大型语言模型生成的。对于子任务 2,参与者必须将机器生成的文本归因于六种不同的文本生成模型之一。我们的 AuTexTification 2023 数据集包含超过 160,000 条文本,涵盖英语和西班牙语两种语言以及五个领域的推文、评论、新闻、法律和如何文章。共有114个团队报名参加,其中36个团队发送了175个跑分,其中20个团队发送了工作笔记。 |

| The Wizard of Curiosities: Enriching Dialogues with Fun Facts Authors Frederico Vicente, Rafael Ferreira, David Semedo, Jo o Magalh es 在谈话中引入好奇心是一种以愉快和愉快的方式向人们传授新知识的方法。通过情境化的好奇心丰富对话可以改善用户对对话系统的感知及其整体用户体验。在本文中,我们介绍了一系列精心策划的好奇心,针对烹饪和 DIY 领域的对话。特别是,我们使用在 Amazon Alexa TaskBot 挑战(一种多模式和多轮对话设置)背景下收集的真实人类代理对话。 |

| Grounded Complex Task Segmentation for Conversational Assistants Authors Rafael Ferreira, David Semedo, Jo o Magalh es 与阅读相同的指令相比,由于注意力和记忆跨度较短,因此遵循会话助理中的复杂指令可能会非常令人畏惧。因此,当会话助理引导用户完成复杂任务的步骤时,需要将任务构建为具有适当长度和复杂性的可管理信息片段。在本文中,我们解决食谱领域并将阅读结构化指令转换为会话结构化指令。我们根据对话场景注释了指令的结构,这提供了对该设置中预期内容的见解。为了对对话步骤的特征进行计算建模,我们测试了各种基于 Transformer 的架构,结果表明基于令牌的方法可提供最佳结果。进一步的用户研究表明,用户倾向于支持可管理的复杂性和长度的步骤,并且所提出的方法可以改进基于网络的原始教学文本。 |

| The Scenario Refiner: Grounding subjects in images at the morphological level Authors Claudia Tagliaferri, Sofia Axioti, Albert Gatt, Denis Paperno 派生相关的单词,例如 runner 和 running ,表现出语义差异,也会引发不同的视觉场景。在本文中,我们询问 Vision 和 Language V L 模型是否使用新的方法和数据集在形态层面捕获了这种区别。我们将 VL 模型的结果与人类的判断进行比较,发现模型的预测与人类参与者的预测不同,特别是显示出语法偏差。我们进一步研究人体模型错位是否与模型架构有关。 |

| OpenChat: Advancing Open-source Language Models with Mixed-Quality Data Authors Guan Wang, Sijie Cheng, Xianyuan Zhan, Xiangang Li, Sen Song, Yang Liu 如今,像LLaMA这样的开源大型语言模型已经出现。最近的发展结合了监督微调 SFT 和强化学习微调 RLFT,使这些模型与人类目标保持一致。然而,SFT 方法平等地对待所有具有混合质量的训练数据,而 RLFT 方法需要高质量的成对或基于排序的偏好数据。在这项研究中,我们提出了一个名为 OpenChat 的新颖框架,以利用混合质量数据推进开源语言模型。具体来说,我们考虑一般的 SFT 训练数据,由少量专家数据与大量次优数据混合组成,没有任何偏好标签。我们提出了条件 RLFT,它将不同的数据源视为粗粒度奖励标签,并学习类条件策略来利用互补的数据质量信息。有趣的是,C RLFT 中的最优策略可以通过单阶段、RL 免费监督学习轻松解决,这种学习是轻量级的,并且避免了昂贵的人类偏好标记。通过对三个标准基准的大量实验,我们使用 C RLFT 进行微调的 openchat 13b 在所有 13b 开源语言模型中实现了最高的平均性能。此外,我们使用 AGIEval 来验证模型泛化性能,其中只有 openchat 13b 超越了基础模型。最后,我们进行了一系列分析,以阐明 OpenChat 的有效性和稳健性。 |

| Retrieve-Rewrite-Answer: A KG-to-Text Enhanced LLMs Framework for Knowledge Graph Question Answering Authors Yike Wu, Nan Hu, Guilin Qi, Sheng Bi, Jie Ren, Anhuan Xie, Wei Song 尽管大型语言模型法学硕士在知识密集型任务上表现出色,但在记忆所有世界知识尤其是长尾知识方面仍然存在局限性。在本文中,我们研究了 KG 增强语言模型方法,用于解决需要丰富世界知识的知识图问答 KGQA 任务。现有的工作表明,检索 KG 知识来增强 LLM 的提示可以显着提高 LLM 在 KGQA 中的表现。然而,他们的方法缺乏对 KG 知识的良好的语言表达,即他们忽略了 KG 表示和文本表示之间的差距。为此,我们提出了一种对答案敏感的 KG 到文本方法,该方法可以将 KG 知识转化为对 KGQA 最具信息性的文本化语句。基于这种方法,我们提出了一个 KG to Text 增强的 LLM 框架来解决 KGQA 任务。 |

| Are Large Language Models Really Robust to Word-Level Perturbations? Authors Haoyu Wang, Guozheng Ma, Cong Yu, Ning Gui, Linrui Zhang, Zhiqi Huang, Suwei Ma, Yongzhe Chang, Sen Zhang, Li Shen, Xueqian Wang, Peilin Zhao, Dacheng Tao 大型语言模型法学硕士的规模和能力的迅速进步使它们成为各种下游任务的有前途的工具。除了追求更好的表现、避免某个提示上的暴力反馈之外,为了保证LLM的责任,更注重LLM的稳健性。然而,现有的评估方法大多依赖于带有预定义监督标签的传统问答数据集,这与当代法学硕士的卓越生成能力不符。为了解决这个问题,我们提出了一种新颖的理性评估方法,利用预先训练的奖励模型作为诊断工具来评估法学硕士的稳健性,我们将其称为合理稳健性评估奖励模型 TREvaL 。我们广泛的实证实验表明,TREval 提供了一种评估 LLM 稳健性的准确方法,尤其是在面临更具挑战性的开放性问题时。此外,我们的结果表明,法学硕士经常表现出容易受到单词级扰动的影响,这在日常语言使用中很常见。值得注意的是,我们惊讶地发现,随着 SFT 和 RLHF 的微调,鲁棒性往往会降低。 |

| Assessment of Pre-Trained Models Across Languages and Grammars Authors Alberto Mu oz Ortiz, David Vilares, Carlos G mez Rodr guez 我们提出了一种评估多语言大语言模型法学硕士如何根据多种形式句法结构学习语法的方法。我们的目标是通过将解析转换为序列标签来恢复成分和依赖结构。为此,我们选择了一些法学硕士,并在 13 个不同的 UD 树库(用于依存解析)和 10 个树库(用于成分解析)上对他们进行研究。我们的结果表明,i 框架在编码之间是一致的,ii 预训练的词向量不支持语法的选区表示而不是依赖关系,iii 与基于字符的模型相比,需要子词标记化来表示语法,iv 语言的出现 |

| CoT-BERT: Enhancing Unsupervised Sentence Representation through Chain-of-Thought Authors Bowen Zhang, Kehua Chang, Chunping Li 无监督句子表示学习旨在将输入句子转换为富含复杂语义信息的固定长度向量,同时避免对标记数据的依赖。在对比学习和即时工程的推动下,该领域的最新进展显着缩小了无监督策略和监督策略之间的差距。尽管如此,在这一轨迹中,思想链的潜在利用在很大程度上仍未得到开发。为了释放预训练模型(例如 BERT)中的潜在功能,我们提出了一种用于句子表示理解和总结的两阶段方法。随后,后一阶段的输出被用作输入句子的向量化表示。为了进一步提高性能,我们精心改进了对比学习损失函数和模板去噪技术以进行即时工程。 |

| Prototype of a robotic system to assist the learning process of English language with text-generation through DNN Authors Carlos Morales Torres, Mario Campos Soberanis, Diego Campos Sobrino 在过去的几年里,自然语言处理 NLP 领域在执行包括英语语言教学 ELT 在内的多项任务方面取得了显着的进步。有利于学习过程的有效策略是使用交互式设备来吸引学习者参与自学过程。在这项工作中,我们提出了一个人形机器人系统的工作原型,通过使用长短期记忆 LSTM 神经网络生成文本来帮助英语自学者。学习者使用图形用户界面与系统进行交互,该界面根据用户的英语水平生成文本。该实验是由英语学习者进行的,结果根据国际英语语言测试系统雅思评分标准进行测量。 |

| AttentionMix: Data augmentation method that relies on BERT attention mechanism Authors Dominik Lewy, Jacek Ma dziuk 混合方法已被证明是计算机视觉中强大的数据增强技术,有许多后继者以引导方式执行图像混合。有趣的研究方向之一是将底层的 Mixup 思想转移到其他领域,例如自然语言处理NLP。尽管已经存在多种将 Mixup 应用于文本数据的方法,但仍然有新的改进方法的空间。在这项工作中,我们介绍了 AttentionMix,一种依赖于基于注意力的信息的新颖混合方法。虽然本文重点关注 BERT 注意力机制,但所提出的方法通常可以应用于任何基于注意力的模型。 AttentionMix 在 3 个标准情感分类数据集上进行评估,在所有三种情况下都优于利用 Mixup 机制的两种基准方法以及普通 BERT 方法。 |

| K-pop Lyric Translation: Dataset, Analysis, and Neural-Modelling Authors Haven Kim, Jongmin Jung, Dasaem Jeong, Juhan Nam 歌词翻译是一个研究了一个多世纪的领域,现在吸引了计算语言学研究人员。我们在之前的研究中发现了两个局限性。首先,歌词翻译研究主要集中在西方流派和语言上,尽管韩国流行音乐很受欢迎,但之前没有针对它的研究。其次,据我们所知,歌词翻译领域缺乏公开可用的数据集,不存在这样的数据集。为了扩大歌词翻译研究的流派和语言范围,我们引入了一个新颖的可唱歌词翻译数据集,其中大约 89 个由韩国流行歌曲歌词组成。该数据集逐行、逐节对齐韩语和英语歌词。 |

| UniPCM: Universal Pre-trained Conversation Model with Task-aware Automatic Prompt Authors Yucheng Cai, Wentao Ma, Yuchuan Wu, Shuzheng Si, Yuan Shao, Zhijian Ou, Yongbin Li 最近的研究表明,多任务预训练极大地提高了模型的鲁棒性和迁移能力,这对于构建高质量的对话系统至关重要。然而,之前大多数多任务预训练的工作严重依赖于人类定义的输入格式或提示,这在质量和数量上都不是最优的。在这项工作中,我们建议使用基于任务的自动提示生成 TAP 来自动生成高质量的提示。使用生成的高质量提示,我们将预训练对话模型的语料库扩展到来自 15 个对话相关任务的 122 个数据集,从而产生了通用预训练对话模型 UniPCM,这是适用于各种对话任务和不同对话系统的强大基础模型。大量实验表明,UniPCM 对于输入提示具有鲁棒性,并且能够执行各种与对话相关的任务。此外,UniPCM 具有强大的传输能力,并且在低资源场景下表现出色,在从面向任务的对话到开放域对话的 9 个不同数据集上取得了 SOTA 结果。此外,我们惊讶地发现 TAP 可以生成与众包收集的提示相同的提示。 |

| XATU: A Fine-grained Instruction-based Benchmark for Explainable Text Updates Authors Haopeng Zhang, Hayate Iso, Sairam Gurajada, Nikita Bhutani 文本编辑是一项至关重要的任务,涉及修改文本以更好地符合用户意图。然而,现有的文本编辑基准数据集在仅提供粗粒度指令方面存在局限性。因此,尽管编辑后的输出可能看起来合理,但它常常偏离黄金参考中概述的预期更改,导致评估分数较低。为了全面研究大型语言模型的文本编辑能力,本文引入了 XATU,这是第一个专门为基于细粒度指令的可解释文本编辑而设计的基准测试。 XATU 涵盖广泛的主题和文本类型,包含词汇、句法、语义和知识密集型编辑。为了增强可解释性,我们利用高质量的数据源和人工注释,形成了包括细粒度指令和黄金标准编辑解释的基准。通过根据我们的基准评估现有的开放式和封闭式大型语言模型,我们展示了指令调整的有效性以及底层架构对各种编辑任务的影响。此外,广泛的实验揭示了解释在微调文本编辑任务的语言模型中的重要作用。 |

| Design of Chain-of-Thought in Math Problem Solving Authors Zhanming Jie, Trung Quoc Luong, Xinbo Zhang, Xiaoran Jin, Hang Li 思想链 CoT 在数学问题解决的推理中起着至关重要的作用。我们对 CoT 的设计方法进行了全面的检查,将传统自然语言 CoT 与各种程序 CoT 进行比较,包括自描述程序、注释描述程序和非描述程序。此外,我们还比较了 Python 和 Wolfram 语言,研究了编程语言对程序 CoT 的影响。通过对 GSM8K、MATHQA 和 SVAMP 的大量实验,我们发现程序 CoT 在解决数学问题方面通常具有卓越的有效性。值得注意的是,30B 参数的最佳性能组合明显优于 GPT 3.5 Turbo。结果表明,自描述程序提供了更大的多样性,因此通常可以获得更高的性能。我们还发现,对于程序 CoT,Python 是比 Wolfram 更好的语言选择。实验结果为未来的 CoT 设计提供了宝贵的指导,该设计考虑了编程语言和编码风格,以实现进一步的进步。 |

| Fake News BR: A Fake News Detection Platform for Brazilian Portuguese Authors Luiz Giordani, Gilsiley Dar , Rhenan Queiroz, Vitor Buzinaro, Davi Keglevich Neiva, Daniel Camilo Fuentes Guzm n, Marcos Jardel Henriques, Oilson Alberto Gonzatto Junior, Francisco Louzada 假新闻的扩散近年来已成为一个重大问题,因为它有可能传播错误信息和操纵公众舆论。在本文中,我们对巴西葡萄牙语中的假新闻检测进行了全面的研究,重点关注新闻类新闻。我们提出了一种基于机器学习的方法,利用自然语言处理技术(包括 TF IDF 和 Word2Vec)从文本数据中提取特征。我们在包含真假新闻文章的数据集上评估各种分类算法(例如逻辑回归、支持向量机、随机森林、AdaBoost 和 LightGBM)的性能。所提出的方法实现了高水平的准确性和 F1 分数,证明了其在识别假新闻方面的有效性。 |

| Localize, Retrieve and Fuse: A Generalized Framework for Free-Form Question Answering over Tables Authors Wenting Zhao, Ye Liu, Yao Wan, Yibo Wang, Zhongfen Deng, Philip S. Yu 表格数据问答 TableQA 旨在生成基于给定表格的问题的答案,近年来引起了越来越多的关注。现有的工作倾向于通过从一个或几个表格单元格中提取信息来生成事实的简短答案,而不对选定的表格单元格进行推理。然而,自由形式的 TableQA 需要更复杂的相关表格单元选择策略以及单独信息的复杂集成和推理,目前仍在探索中。为此,本文提出了一种通用的三阶段方法,即表到图转换和单元格定位、外部知识检索和表文本融合(称为 TAG QA),解决了为生成式 TableQA 推断长自由形式答案的挑战。特别是,TAG QA 1 使用图神经网络来收集相关行和列之间的相交单元来定位相关表格单元,2 利用维基百科的外部知识,3 通过集成表格数据和自然语言信息来生成答案。人类评估实验表明,与几种最先进的基线相比,TAG QA 能够生成更忠实、更连贯的句子。特别是,在 BLEU 4 和 PARENT F 分数方面,TAG QA 的性能分别比基于强大管道的基线 TAPAS 好 17 和 14。 |

| Heterogeneous Entity Matching with Complex Attribute Associations using BERT and Neural Networks Authors Shitao Wang, Jiamin Lu 在各个领域,来自百度百科和维基百科等不同来源的数据通常以不同的形式表现出来。当前的实体匹配方法主要关注同质数据,其特征是共享相同结构的属性和简洁的属性值。然而,这种方向对处理不同格式的数据提出了挑战。此外,流行的方法聚合相应属性之间的属性值的相似性来确定实体相似性。然而,他们常常忽视属性之间错综复杂的相互关系,其中一个属性可能有多个关联。 |

| Making Small Language Models Better Multi-task Learners with Mixture-of-Task-Adapters Authors Yukang Xie, Chengyu Wang, Junbing Yan, Jiyong Zhou, Feiqi Deng, Jun Huang 最近,大型语言模型法学硕士在各种自然语言处理 NLP 任务中取得了惊人的零样本学习性能,尤其是文本生成任务。然而,法学硕士规模庞大,往往导致模型训练和在线部署的计算成本较高。在我们的工作中,我们提出了 ALTER,这是一个系统,可以在具有 1B 参数的小型语言模型上有效地构建具有混合任务适配器的多任务学习器,以同时处理多个 NLP 任务,捕获任务之间的共性和差异,以支持特定领域应用程序。具体来说,在 ALTER 中,我们提出混合任务适配器 MTA 模块作为底层模型的转换器架构的扩展,以捕获任务内和任务间知识。进一步提出了两阶段训练方法,以较小的计算成本优化适配器之间的协作。混合 NLP 任务的实验结果表明,我们提出的 MTA 架构和两阶段训练方法取得了良好的性能。 |

| Named Entity Recognition via Machine Reading Comprehension: A Multi-Task Learning Approach Authors Yibo Wang, Wenting Zhao, Yao Wan, Zhongfen Deng, Philip S. Yu 命名实体识别 NER 旨在提取文本中提及的实体并将其分类为预定义的类型,例如组织或人名。最近,已经提出了许多工作来将 NER 塑造为机器阅读理解问题,也称为基于 MRC 的 NER,其中实体识别是通过基于上下文通过 MRC 回答与预定义实体类型相关的公式化问题来实现的。然而,这些工作忽略了实体类型之间的标签依赖性,这对于精确识别命名实体至关重要。在本文中,我们建议将实体类型之间的标签依赖性合并到多任务学习框架中,以实现更好的基于 MRC 的 NER。我们将基于 MRC 的 NER 分解为多个任务,并使用自注意力模块来捕获标签依赖性。对嵌套 NER 和平面 NER 数据集进行了综合实验,以验证所提出的 Multi NER 的有效性。 |

| Towards Joint Modeling of Dialogue Response and Speech Synthesis based on Large Language Model Authors Xinyu Zhou, Delong Chen, Yudong Chen 本文探讨了构建一个同时思考如何响应和如何说话的人工智能语音对话系统的潜力,与当前独立聊天机器人和文本转语音 TTS 模块的级联管道相比,该系统更符合人类语音生成过程。我们假设具有数十亿参数的大型语言模型法学硕士拥有显着的语音理解能力,并且可以联合建模对话响应和语言特征。我们进行了两组实验:1 韵律结构预测,TTS 中的典型前端任务,展示了法学硕士的语音理解能力;2 使用统一的编码格式进一步集成对话响应和广泛的语言特征。 |

| MBR and QE Finetuning: Training-time Distillation of the Best and Most Expensive Decoding Methods Authors Mara Finkelstein, Markus Freitag 最近对自然语言生成 NLG 任务的解码方法的研究表明,传统的波束搜索和贪婪解码算法并不是最优的,因为模型概率并不总是符合人类的偏好。此后,人们提出了更强大的解码方法,包括质量估计 QE 重排序和最小贝叶斯风险 MBR 解码,以减轻模型困惑与质量不匹配的情况。虽然这些解码方法实现了最先进的性能,但它们的计算成本却非常昂贵。在这项工作中,我们提出了 MBR 微调和 QE 微调,它们在训练时从这些解码方法中提取质量增益,同时在推理时使用高效的解码算法。使用神经机器翻译 NMT 的规范 NLG 任务,我们表明即使进行自我训练,这些微调方法也显着优于基本模型。此外,当使用外部法学硕士作为教师模型时,这些微调方法优于对人类生成的参考的微调。 |

| In-Context Learning for Text Classification with Many Labels Authors Aristides Milios, Siva Reddy, Dzmitry Bahdanau 在上下文学习中,由于上下文窗口有限,ICL 使用大型语言模型来处理具有许多标签的任务具有挑战性,这使得很难在提示中容纳足够数量的示例。在本文中,我们使用预先训练的密集检索模型来绕过此限制,为模型提供每个推理调用的完整标签空间的部分视图。使用最近的开源 LLM OPT、LLaMA 进行测试,我们在三个常见意图分类数据集的几个镜头设置中设置了新的最先进性能,无需进行微调。在某些情况下,我们还超越了细粒度情感分类的微调性能。我们分析了上下文示例数量和不同模型规模的性能,表明需要更大的模型才能有效且一致地利用更大的上下文长度进行 ICL。通过运行几次消融,我们分析了模型对 a 上下文中示例与当前输入的相似性、b 类名称的语义内容以及 c 示例和标签之间的正确对应关系的使用。 |

| LMDX: Language Model-based Document Information Extraction and Localization Authors Vincent Perot, Kai Kang, Florian Luisier, Guolong Su, Xiaoyu Sun, Ramya Sree Boppana, Zilong Wang, Jiaqi Mu, Hao Zhang, Nan Hua 大型语言模型法学硕士彻底改变了自然语言处理 NLP,提高了许多现有任务的最先进水平并展示了新兴功能。然而,法学硕士尚未成功应用于半结构化文档信息提取,半结构化文档信息提取是许多文档处理工作流程的核心,包括从给定预定义目标模式的视觉丰富的文档 VRD 中提取关键实体。在该任务中采用法学硕士的主要障碍是法学硕士内缺乏布局编码,这对于高质量提取至关重要,并且缺乏确保答案不被幻觉的基础机制。在本文中,我们介绍了基于语言模型的文档信息提取和本地化 LMDX,这是一种适应任意 LLM 进行文档信息提取的方法。 LMDX 可以提取单个、重复和分层实体(无论有没有训练数据),同时提供基础保证并本地化文档中的实体。 |

| Benchmarks for Pirá 2.0, a Reading Comprehension Dataset about the Ocean, the Brazilian Coast, and Climate Change Authors Paulo Pirozelli, Marcos M. Jos , Igor Silveira, Fl vio Nakasato, Sarajane M. Peres, Anarosa A. F. Brand o, Anna H. R. Costa, Fabio G. Cozman Pir 是一个专注于海洋、巴西海岸和气候变化的阅读理解数据集,由有关这些主题的科学摘要和报告集合构建而成。该数据集代表了一种多功能语言资源,对于测试当前机器学习模型获取专业科学知识的能力特别有用。尽管具有潜力,但尚未为 Pir 开发一套详细的基线。通过创建这些基线,研究人员可以更轻松地利用 Pir 作为在各种问答任务中测试机器学习模型的资源。在本文中,我们在 Pir 数据集上定义了六个基准,涵盖封闭式生成问答、机器阅读理解、信息检索、开放式问答、答案触发和多项选择问答。作为这项工作的一部分,我们还制作了原始数据集的精选版本,其中修复了许多语法问题、重复和其他缺点。此外,该数据集还向几个新方向进行了扩展,以应对上述支持文本从英语到葡萄牙语的基准翻译、可回答性的分类标签、问题和答案的自动释义以及多项选择候选。 |

| A Family of Pretrained Transformer Language Models for Russian Authors Dmitry Zmitrovich, Alexander Abramov, Andrey Kalmykov, Maria Tikhonova, Ekaterina Taktasheva, Danil Astafurov, Mark Baushenko, Artem Snegirev, Tatiana Shavrina, Sergey Markov, Vladislav Mikhailov, Alena Fenogenova 如今,Transformer 语言模型 LM 代表了 NLP 研究方法和应用的基本组成部分。然而,专门针对俄语的此类模型的开发却很少受到关注。本文提出了基于编码器 ruBERT、ruRoBERTa、ruELECTRA 、解码器 ruGPT 3 和多种尺寸的编码器解码器 ruT5、FRED T5 模型的 13 个 Russian Transformer LM 的集合。通过 HuggingFace 平台可以轻松访问这些模型。我们提供了模型架构设计和预训练的报告,以及评估其在俄语自然语言理解和生成数据集和基准上的泛化能力的结果。 |

| Specializing Small Language Models towards Complex Style Transfer via Latent Attribute Pre-Training Authors Ruiqi Xu, Yongfeng Huang, Xin Chen, Lin Zhang 在这项工作中,我们引入了复杂文本样式迁移任务的概念,并基于两个广泛适用的场景构建了复杂文本数据集。我们的数据集是同类中第一个大规模数据集,包含 700 个改写的句子和来自游戏 Genshin Impact 的 1,000 个句子。虽然大型语言模型 LLM 在复杂文本样式传输方面显示出前景,但它们也存在数据隐私问题、网络不稳定和部署成本高等缺点。为了解决这些问题,我们通过对比学习探索小于 T5 3B 的隐式预训练小模型的有效性。我们还提出了一种基于使用 ChatGPT 与人类评估一致的文本生成质量自动评估方法。 |

| Semi-Autoregressive Streaming ASR With Label Context Authors Siddhant Arora, George Saon, Shinji Watanabe, Brian Kingsbury 非自回归 NAR 模型在语音处理领域引起了极大的兴趣,因为这些模型比自回归 AR 模型的推理时间显着缩短,同时还实现了良好的转录准确性。由于 NAR 自动语音识别 ASR 模型必须等待整个话语完成才能处理,因此一些工作探索基于块式注意力的流式 NAR 模型,以实现低延迟应用。然而,与流式 AR 和非流式 NAR 模型相比,流式 NAR 模型的准确性明显滞后。为了解决这个问题,我们提出了一种流式半自回归 ASR 模型,该模型使用语言模型 LM 子网络将先前块中发出的标签合并为附加上下文。我们还引入了一种新颖的贪婪解码算法,该算法可以解决块边界附近的插入和删除错误,同时不会显着增加推理时间。实验表明,我们的方法在 Tedlium2 上比现有的流式 NAR 模型好 19 个,在 Librispeech 100 clean 其他测试集上比现有流 NAR 模型好 16 个 8,在 Switchboard SWB Callhome CH 测试集上比现有流 NAR 模型好 19 个 8。它还缩小了流式 AR 和非流式 NAR 模型的准确度差距,同时实现了 2.5 倍的延迟降低。 |

| Semi-automatic staging area for high-quality structured data extraction from scientific literature Authors Luca Foppiano, Tomoya Mato, Kensei Terashima, Pedro Ortiz Suarez, Taku Tou, Chikako Sakai, Wei Sheng Wang, Toshiyuki Amagasa, Yoshihiko Takano, Masashi Ishii 在这项研究中,我们提出了一个暂存区,用于在 SuperCon 中摄取新的超导体实验数据,这些数据是机器从科学文章中收集的。我们的目标是提高 SuperCon 的更新效率,同时保持或提高数据质量。我们提出了一个半自动暂存区域,该区域由在提取的数据库上结合自动和手动流程的工作流程驱动。异常检测自动过程旨在预先筛选收集的数据。然后,用户可以通过专门定制的用户界面手动更正任何错误,以简化原始 PDF 文档的数据验证。此外,当记录被更正时,其原始数据将被收集并用作训练数据来改进机器学习模型。评估实验表明,我们的暂存区显着提高了策展质量。我们将该界面与读取 PDF 文档并在 Excel 文档中记录信息的传统手动方法进行了比较。 |

| RedPenNet for Grammatical Error Correction: Outputs to Tokens, Attentions to Spans Authors Bohdan Didenko 1 , Andrii Sameliuk 1 1 WebSpellChecker LLC Ukraine 文本编辑任务,包括句子融合、句子分割和改写、文本简化和语法错误纠正 GEC,都有一个共同的特点,即处理高度相似的输入和输出序列。该研究领域位于两个成熟领域的交叉点:i 完全自回归序列到序列方法,通常用于神经机器翻译 NMT 等任务;ii 序列标记技术,通常用于解决词性标记、命名实体识别 NER 等任务,和类似的。为了追求平衡的架构,研究人员提出了许多富有想象力和非常规的解决方案,我们将在相关作品部分中讨论这些解决方案。我们解决文本编辑任务的方法称为 RedPenNet,旨在减少特定序列编辑模型中出现的架构和参数冗余,保留其半自回归优势。 |

| Self-Augmentation Improves Zero-Shot Cross-Lingual Transfer Authors Fei Wang, Kuan Hao Huang, Kai Wei Chang, Muhao Chen 零样本跨语言迁移是多语言 NLP 的核心任务,允许使用训练资源更充足的语言训练的模型泛化到其他低资源语言。此任务的早期工作使用并行语料库、双语词典或其他带注释的对齐数据来提高跨语言可迁移性,而获得这些数据通常成本高昂。在本文中,我们提出了一种简单而有效的方法 SALT,来改进多语言预训练语言模型的零样本跨语言迁移,而无需此类外部数据的帮助。通过将代码切换和嵌入混合与自我增强相结合,SALT 有效地从多语言 PLM 中提取跨语言知识,并增强其在下游任务中的可迁移性。 XNLI 和 PAWS X 上的实验结果表明,我们的方法能够在没有外部数据的情况下提高零样本跨语言可迁移性。 |

| Classifying Organizations for Food System Ontologies using Natural Language Processing Authors Tianyu Jiang, Sonia Vinogradova, Nathan Stringham, E. Louise Earl, Allan D. Hollander, Patrick R. Huber, Ellen Riloff, R. Sandra Schillo, Giorgio A. Ubbiali, Matthew Lange 我们的研究探索使用自然语言处理 NLP 方法对实体进行自动分类,以实现知识图谱填充并与食品系统本体集成。我们创建了 NLP 模型,可以根据与环境问题相关的类别以及标准行业分类 SIC 代码自动对组织进行分类,美国政府使用这些代码来描述商业活动。作为输入,NLP 模型提供了由 Google 搜索引擎检索到的每个组织的文本片段,这些文本片段用作用于学习的组织的文本描述。我们的实验结果表明,NLP 模型可以在这两个分类任务上取得相当好的性能,并且它们依赖于一个也可以应用于许多其他分类问题的通用框架。 |

| DreamLLM: Synergistic Multimodal Comprehension and Creation Authors Runpei Dong, Chunrui Han, Yuang Peng, Zekun Qi, Zheng Ge, Jinrong Yang, Liang Zhao, Jianjian Sun, Hongyu Zhou, Haoran Wei, Xiangwen Kong, Xiangyu Zhang, Kaisheng Ma, Li Yi 本文介绍了 DreamLLM,这是一个学习框架,它首先实现了多功能多模态大语言模型 MLLM,该模型具有多模态理解和创建之间经常被忽视的协同作用。 DreamLLM 的运作遵循两个基本原则。第一个重点是通过在原始多模态空间中直接采样来对语言和图像后验进行生成建模。这种方法规避了 CLIP 等外部特征提取器固有的限制和信息丢失,并且获得了更彻底的多模态理解。其次,DreamLLM 促进原始交错文档的生成,对文本和图像内容以及非结构化布局进行建模。这使得 DreamLLM 能够有效地学习所有条件、边际和联合多模态分布。因此,DreamLLM 是第一个能够生成自由格式交错内容的 MLLM。 |

| Text2Reward: Automated Dense Reward Function Generation for Reinforcement Learning Authors Tianbao Xie, Siheng Zhao, Chen Henry Wu, Yitao Liu, Qian Luo, Victor Zhong, Yanchao Yang, Tao Yu 设计奖励函数是强化学习 RL 中长期存在的挑战,它需要专业知识或领域数据,导致开发成本高昂。为了解决这个问题,我们引入了 Text2Reward,这是一个无数据框架,可以根据大型语言模型 LLM 自动生成密集奖励函数。给定一个用自然语言描述的目标,Text2Reward 会生成密集的奖励函数,作为基于环境的紧凑表示的可执行程序。与逆向 RL 和最近使用 LLM 编写稀疏奖励代码的工作不同,Text2Reward 生成可解释的、自由形式的密集奖励代码,涵盖广泛的任务,利用现有的包,并允许根据人类反馈进行迭代细化。我们在两个机器人操作基准 ManiSkill2、MetaWorld 和 MuJoCo 的两个运动环境上评估 Text2Reward。在 17 个操作任务中的 13 个中,使用生成的奖励代码训练的策略与专家编写的奖励代码相比,实现了相似或更好的任务成功率和收敛速度。对于运动任务,我们的方法学习了六种新颖的运动行为,成功率超过 94 。此外,我们还表明,用我们的方法在模拟器中训练的策略可以部署在现实世界中。最后,Text2Reward 通过人类反馈完善奖励函数,进一步改进了策略。 |

| Discuss Before Moving: Visual Language Navigation via Multi-expert Discussions Authors Yuxing Long, Xiaoqi Li, Wenzhe Cai, Hao Dong 视觉语言导航 VLN 是一项具体任务,需要广泛的技能,包括理解、感知和规划。对于这样一个多方面的挑战,以前的VLN方法完全依靠一个模型自己的思维在一轮内做出预测。然而,现有的模型,即使是最先进的大语言模型 GPT4,仍然难以通过单轮自我思考来处理多个任务。在这项工作中,我们从专家咨询会议中汲取灵感,引入了一种新颖的零样本VLN框架。在这个框架内,具有独特能力的大型模型被充当领域专家。我们提出的导航代理,即 DiscussNav,可以在每一步行动之前与这些专家积极讨论以收集必要的信息。这些讨论涵盖了关键的导航子任务,例如指令理解、环境感知和完成度估计。通过全面的实验,我们证明与领域专家的讨论可以通过感知指令相关信息、纠正无意的错误以及筛选一致的运动决策来有效地促进导航。代表性 VLN 任务 R2R 的性能表明,我们的方法在所有指标上都大大超过了领先的零样本 VLN 模型。 |

| Improving Article Classification with Edge-Heterogeneous Graph Neural Networks Authors Khang Ly, Yury Kashnitsky, Savvas Chamezopoulos, Valeria Krzhizhanovskaya 考虑到现有和新发表的文章数量,将研究成果分类为上下文特定的标签分类法是一项具有挑战性且相关的下游任务。我们提出了一种通过边缘异构图表示丰富简单图神经网络 GNN 管道来增强文章分类性能的方法。 SciBERT 用于节点特征生成,以捕获文章文本元数据中的高阶语义。在 Open Graph Benchmark OGB ogbn arxiv 数据集和 PubMed 糖尿病数据集上进行了完全监督的转导节点分类实验,并分别使用来自 Microsoft Academy Graph MAG 和 PubMed Central 的附加元数据进行了增强。结果表明,与边缘同质图相比,边缘异构图持续提高了所有 GNN 模型的性能。转换后的数据使简单且浅层的 GNN 管道能够实现与更复杂的架构相当的结果。在 ogbn arxiv 上,我们在 OGB 竞赛中取得了前 15 名的成绩,2 层 GCN 精度为 74.61,是参数低于 100 万的得分最高的解决方案。在 PubMed 上,我们通过在图准确度 89.88 中包含额外的共同作者边,使用 2 层 GraphSAGE 密切跟踪 SOTA GNN 架构。 |

| Leveraging Data Collection and Unsupervised Learning for Code-switched Tunisian Arabic Automatic Speech Recognition Authors Ahmed Amine Ben Abdallah, Ata Kabboudi, Amir Kanoun, Salah Zaiem 为方言制定有效的自动语音识别 ASR 解决方案需要创新的方法,不仅要解决数据稀缺问题,还要解决语言多样性的复杂性。在本文中,我们解决了上述 ASR 挑战,重点关注突尼斯方言。首先,收集文本和音频数据,并在某些情况下进行注释。其次,我们探索自我监督、半监督和少量镜头代码切换方法,以推动覆盖不同声学、语言和韵律条件的不同突尼斯测试集的最新技术。最后,考虑到传统拼写的缺失,我们对成绩单进行了人工评估,以避免测试参考文献中拼写缺陷带来的噪音。 |

| Speak While You Think: Streaming Speech Synthesis During Text Generation Authors Avihu Dekel, Slava Shechtman, Raul Fernandez, David Haws, Zvi Kons, Ron Hoory 大型语言模型法学硕士展示了令人印象深刻的能力,但与这些模型的交互主要是通过文本来促进的。使用文本到语音合成 LLM 输出通常会导致显着的延迟,这对于流畅的语音对话来说是不切实际的。我们提出了 LLM2Speech,这是一种在 LLM 生成文本的同时合成语音的架构,可显着减少延迟。 LLM2Speech 模仿非流式教师模型的预测,同时限制对未来上下文的暴露以启用流式传输。它利用了法学硕士的隐藏嵌入,这是包含信息语义上下文的文本生成的副产品。 |

| The Languini Kitchen: Enabling Language Modelling Research at Different Scales of Compute Authors Aleksandar Stani , Dylan Ashley, Oleg Serikov, Louis Kirsch, Francesco Faccio, J rgen Schmidhuber, Thomas Hofmann, Imanol Schlag Languini Kitchen 既是一个研究团体,也是一个代码库,旨在使计算资源有限的研究人员能够为语言建模领域做出有意义的贡献。我们引入了一种实验协议,该协议能够基于等效计算(以加速器时间为单位进行测量)进行模型比较。训练模型的令牌数量由模型的吞吐量和所选的计算类定义。值得注意的是,这种方法避免了对影响总参数或浮点运算的关键超参数的约束。为了进行评估,我们预处理了现有的大型、多样化和高质量的书籍数据集,这些数据集在质量、多样性和文档长度方面超越了现有的学术基准。在此基础上,我们根据经验缩放趋势来比较方法,这些趋势是通过不同计算级别的实验估计的。这项工作还提供了两个基线模型,一个是源自 GPT 2 架构的前馈模型,另一个是具有十倍吞吐量的新型 LSTM 形式的循环模型。虽然 GPT 基线在我们所有的计算级别上都实现了更好的困惑度,但我们的 LSTM 基线表现出了可预测且更有利的缩放定律。这是由于吞吐量的提高以及需要更少的训练令牌来实现测试困惑度的相同降低。推断两个模型的比例定律领先结果在大约 50,000 个加速器小时处产生交集。 |

| Language-Oriented Communication with Semantic Coding and Knowledge Distillation for Text-to-Image Generation Authors Hyelin Nam, Jihong Park, Jinho Choi, Mehdi Bennis, Seong Lyun Kim 通过将大型语言模型 LLM 和生成模型的最新进展集成到新兴的语义通信 SC 范式中,在本文中,我们提出了一种面向语言的语义通信 LSC 的新颖框架。在 LSC 中,机器使用人类语言消息进行通信,这些消息可以通过自然语言处理 NLP 技术进行解释和操作,以提高 SC 效率。为了展示 LSC 的潜力,我们引入了三种创新算法 1 语义源编码 SSC,将文本提示压缩为其关键词核心词,捕获提示的句法本质,同时保持其外观顺序以保持提示的上下文 2 语义通道编码 SCC,改进通过用较长的同义词替换中心词来增强抗错误能力,并且 3 语义知识蒸馏 SKD 通过在上下文中学习听众的语言风格来生成听众定制的提示。 |

| Dual-Modal Attention-Enhanced Text-Video Retrieval with Triplet Partial Margin Contrastive Learning Authors Chen Jiang, Hong Liu, Xuzheng Yu, Qing Wang, Yuan Cheng, Jia Xu, Zhongyi Liu, Qingpei Guo, Wei Chu, Ming Yang, Yuan Qi 近年来,网络视频的爆炸式增长使得文本视频检索对于视频过滤、推荐和搜索变得越来越重要和流行。文本视频检索的目的是使相关文本视频的排名高于不相关文本视频的排名。该任务的核心是精确测量文本和视频之间的跨模态相似度。最近,对比学习方法在文本视频检索方面显示出了可喜的结果,其中大多数侧重于构建正负对来学习文本和视频表示。然而,他们对硬否定对没有给予足够的重视,并且缺乏对不同级别的语义相似性进行建模的能力。为了解决这两个问题,本文使用两种新颖的技术改进了对比学习。首先,为了利用硬样本获得强大的判别力,我们提出了一种新颖的双模态注意力增强模块 DMAE,从文本和视觉线索中挖掘硬负对。通过进一步引入负感知 InfoNCE NegNCE 损失,我们能够自适应地识别所有这些硬负数,并明确强调它们对训练损失的影响。其次,我们的工作认为,与成对样本相比,三元组样本可以更好地模拟细粒度的语义相似性。因此,我们提出了一种新的三重态部分边缘对比学习 TPM CL 模块,通过自动为匹配的文本视频对生成细粒度的硬底片来构造偏序三重态样本。所提出的 TPM CL 设计了一种具有跨模式交互的自适应令牌屏蔽策略,以对细微的语义差异进行建模。 |

| End-to-End Speech Recognition Contextualization with Large Language Models Authors Egor Lakomkin, Chunyang Wu, Yassir Fathullah, Ozlem Kalinli, Michael L. Seltzer, Christian Fuegen 近年来,大型语言模型法学硕士因其卓越的性能和泛化能力而引起了研究界的极大关注。在本文中,我们介绍了一种结合法学硕士的语音识别模型的语境化新方法。我们的方法将语音识别视为基于预训练的 LLM 的混合模态语言建模任务。我们提供音频功能以及上下文的可选文本标记,以训练系统以仅解码器的方式完成转录。因此,系统会隐含地学习如何在训练期间利用非结构化上下文信息。我们的实证结果表明,当提供额外的文本上下文时,性能显着提高,WER 减少 6。此外,我们发现我们的方法具有竞争力,相对于已在超过 25 倍大的语音数据集上进行训练的基线上下文化 RNN T 系统,我们的方法总体上提高了 7.5 个 WER,在稀有词上提高了 17 个 WER。 |

| What Learned Representations and Influence Functions Can Tell Us About Adversarial Examples Authors Shakila Mahjabin Tonni, Mark Dras 对抗性例子是故意使用小扰动来愚弄深度神经网络的,最初是在图像处理中研究的,最近在 NLP 中进行了研究。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com

![计算机视觉与深度学习-全连接神经网络-训练过程-批归一化- [北邮鲁鹏]](https://img-blog.csdnimg.cn/c44607224f1f442b9ad8fe62e13f468b.png)

![[NLP] LLM---<训练中文LLama2(四)方式一>对LLama2进行SFT微调](https://img-blog.csdnimg.cn/bec50e7544ad455fba2cd4cfac385af9.png)

![计算机视觉与深度学习-卷积神经网络-卷积图像去噪边缘提取-图像去噪 [北邮鲁鹏]](https://img-blog.csdnimg.cn/364f66a79e0546ddafbdcdc104d4fea0.png)