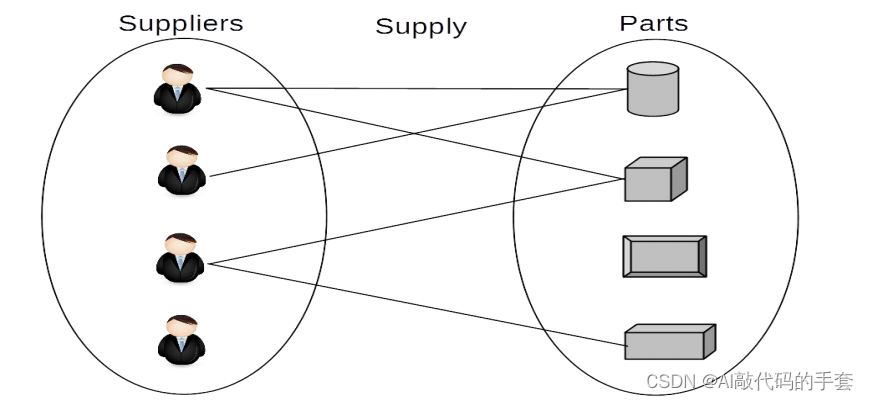

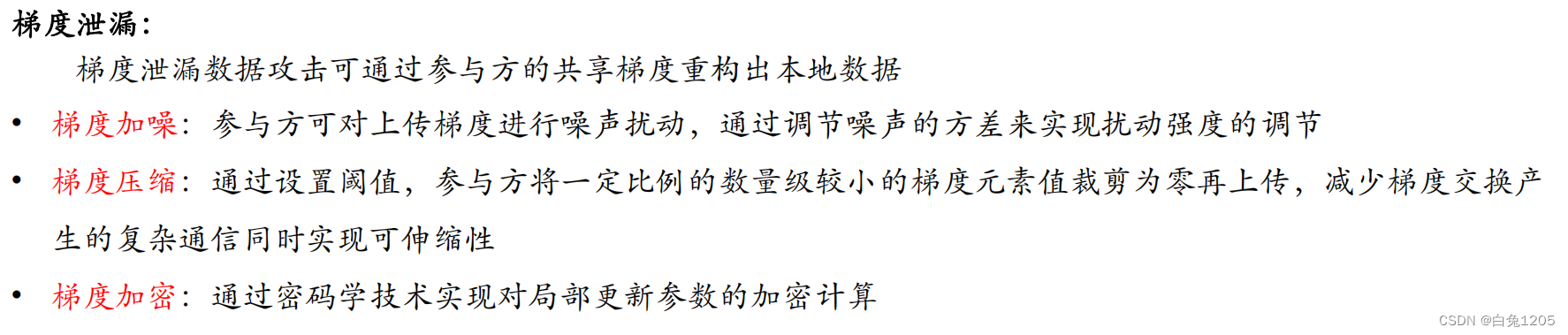

联邦学习中的梯度出现挑战:

-

暴露原始训练数据的某些属性

-

利用生成对抗网络生成与私有训练图像类似的图片

尽管许多研究已经证实从梯度中重构原始数据的可能性,这些研究通常基于一个前提假设,即用户上传的梯度是全梯度。

联邦学习系统更倾向于使用梯度压缩方法,以降低通信带宽,即上传高度压缩的梯度。这将使得基于全梯度的数据重构攻击算法可能失效。

生成对抗网络(模型反演攻击,MIA):没有利用共享的梯度信息,而是只用了最后训练好的全局模型参数信息,因此这种类型的攻击只有当每个类下的所有数据分布基本一致时才有效,每一类下的图像分布差异很大的时候则会导致重构的图像缺乏细节或与原始数据的感知相似性极低。

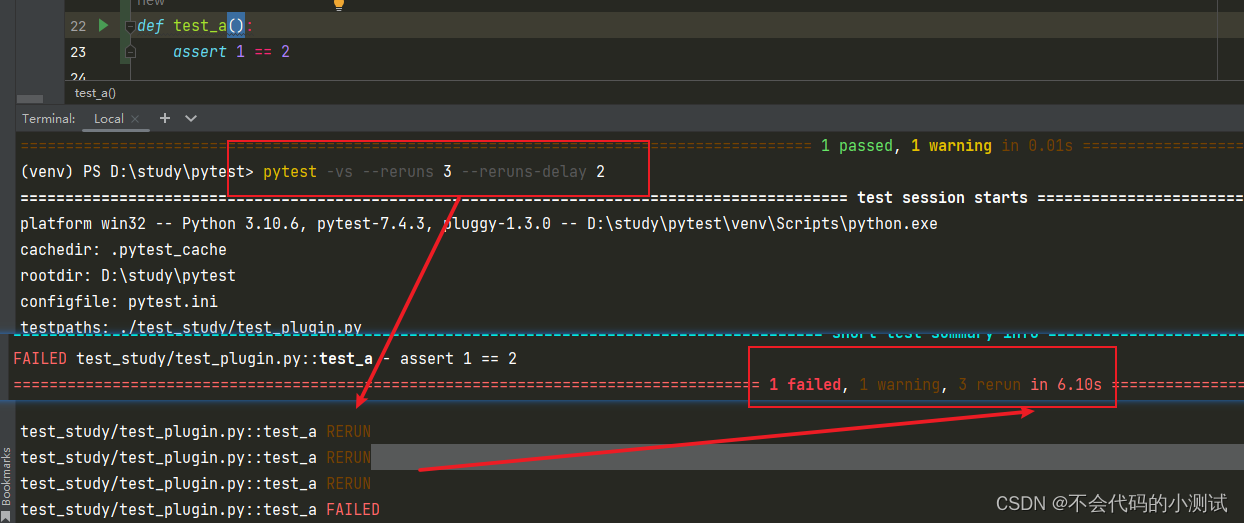

iDLG:共享梯度中会泄露原始数据的标签;标签被提取出后,攻击的过程就不需要再更新标签了,只需要不断优化初始的虚假图像,从而减小了搜索空间,加速了收敛过程。但他们的做法缺陷在于只能推断当批大小 (Batch Size) 为 1 时的真实标签,而当批大小大于 1 时则无法推断了。

梯度的批量标签泄漏 (LLG) 方法:从共享梯度中获得用户批量训练数据标签的攻击。LLG利用梯度的方向和大小来确定一个标签的存在或不存在,并且可以很好地扩展到任意批大小和多个类的主任务中,LLG 可以在当批大小为 128 时,标签推断的准确率达到 90% 以上。

IG : 将 DLG 中优化目标中的距离表示从欧式距离变成了余弦相似性,并且对虚假数据进行了正则惩罚。此外,IG 的目标函数中对不同层的梯度设置了不同的权重,优化器也从 DLG 中的 LBFGS 改为了 Adam 优化器。他们通过实验证实了这样的设置可以产生比 DLG 更好的重构结果并且支持批量数据重构。

STG:进一步对损失函数(优化目标)进行了改进在目标函数中加入了更多的正则项(包括了对网络批归一化层的规范化),同时并行开启多个独立的优化过程,最终把不同优化过程得到的结果进行配准得到最终的重构图像。实验结果表明他们的方法可以在更大批大小下恢复出高分辨率的图像,但大部分恢复的图像与原始图像依然存在细节上的差异,甚至出现位置错位的问题,其真实的恢复率只有 28%

在辅助数据集中预先训练一个生成器作为先验,然后不断优化生成器的输入,使得其产生的图像所对应的梯度与真实的梯度不断接近,该方法不但引入了先验,且大大降低了搜索空间,从而提高了优化效率和重构质量

- 参数服务器由于仅有模型聚合和分发的功能,它无法知道模型每个神经元所对应的真实标签是什么。

- 敌手不可能事先拥有与私有训练数据分布一致的辅助数据。

设计了一种从压缩的梯度中推断原始数据属性的方法。在该方法中,敌手需要准备大量包含原始数据本身及其属性值的辅助数据集,并在该数据集上训练多个属性推断模型,其中每个推断模型均为二分类模型(这样的假设也是不合理的呀)

属性相似性度量指标,该指标结合了属性推断模型的输出分类置信值与模型本身的曲线下面积 (Area Under The Curve, AUC),从而给两个属性向量进行打分。分数越高表示两个属性向量越

接近。在攻击阶段,敌手先通过梯度推断出原始数据的 N 个属性得分,然后再利用属性相似性度量指标对推断的属性向量与辅助数据集中的人为标注的属性向量进行两两比较,并选取出得分最高的标注属性向量所对应的图像作为虚假初始化图像