个人名片:

🐅作者简介:一名大三在校生,热爱生活,爱好敲码!

\ 💅个人主页 🥇:holy-wangle

➡系列内容: 🖼️ tkinter前端窗口界面创建与优化

🖼️ Java实现ATP小系统

✨个性签名: 🍭不积跬步,无以至千里;不积小流,无以成江海

今天我们聊聊如何使用maxwell监控mysql的数据改变,然后将数据传输到kafka的过程。

首先我们是不是要有mysql,maxwell,kafka的环境吧!环境我就默认各位都部署好了。

第一步:配置maxwell的bin目录下的config.properties(刚安装的时候这个文件叫config.properties.example,我这里把这个文件改名了)

添加一下内容:

log_level=infoproducer=kafka

kafka.bootstrap.servers=hadoop102:9092,hadoop103:9092#kafka topic配置

kafka_topic=topic_db# mysql login info

host=hadoop102

user=maxwell

password=maxwell

jdbc_options=useSSL=false&serverTimezone=Asia/Shanghai保存退出!

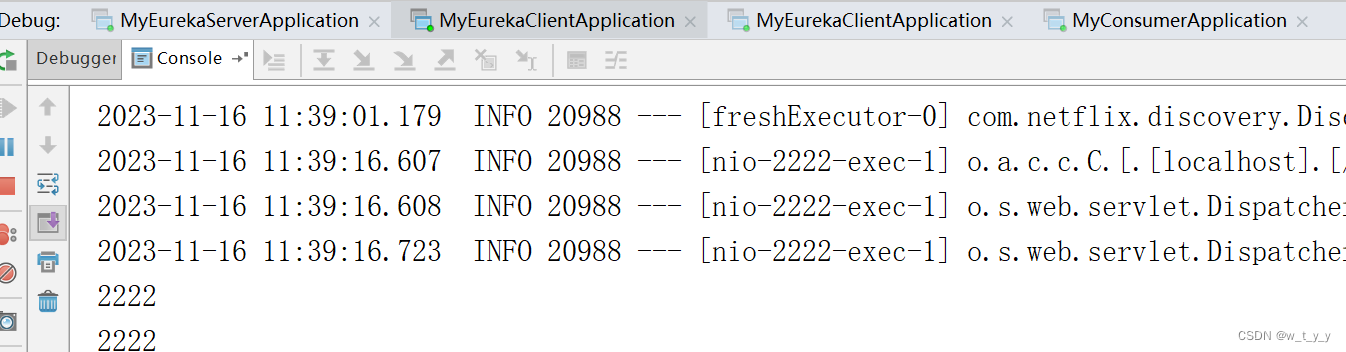

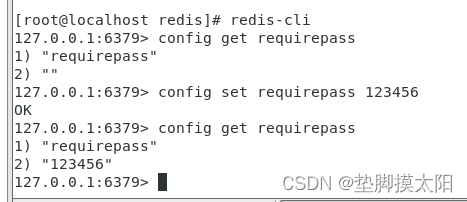

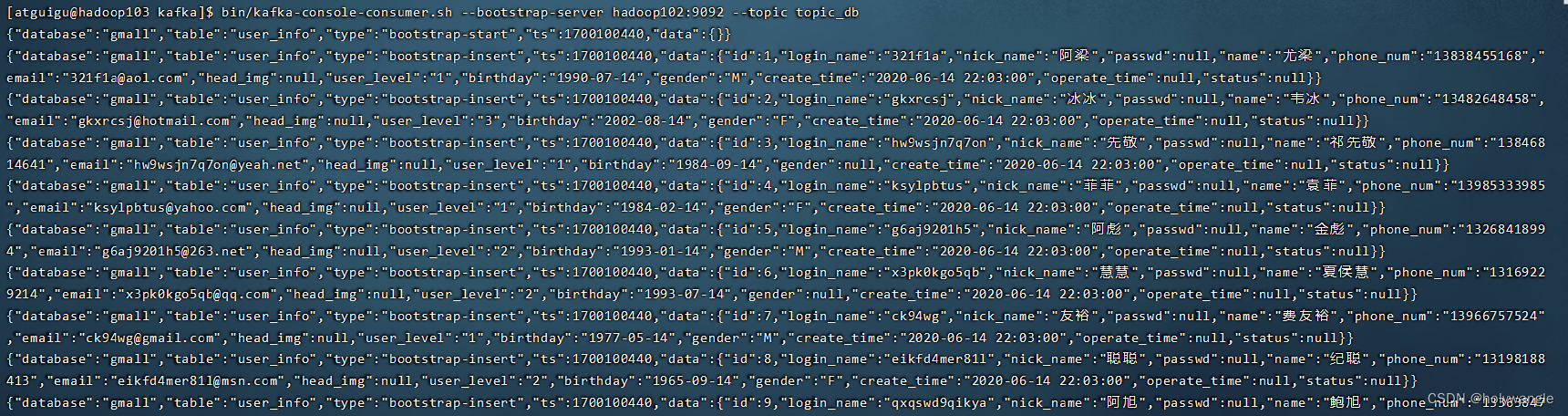

然后在hadoop103的节点启动消费者模式,命令是:

bin/kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic topic_db跟着我们在hadoop102节点上面启动maxwell,要有maxwell进程才行哦!然后输入命令:

/opt/software/maxwell/bin/maxwell-bootstrap --database gmall --table user_info --config /opt/software/maxwell/config.properties 我这里是获取mysql中gmall.user_info表中的数据进来消费。

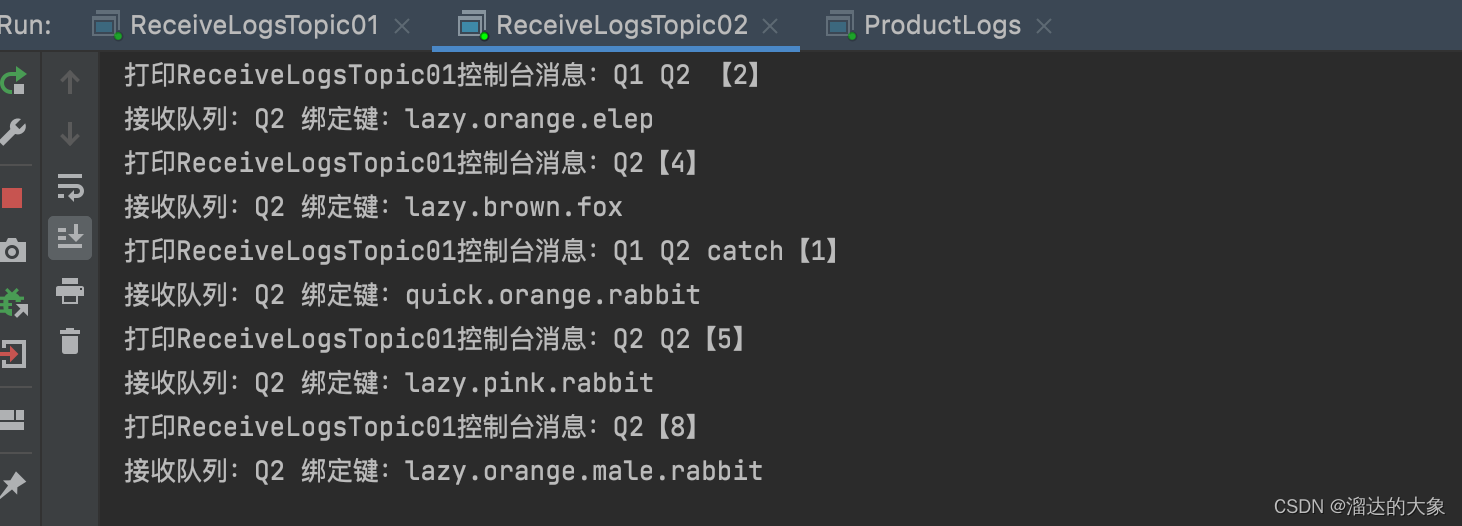

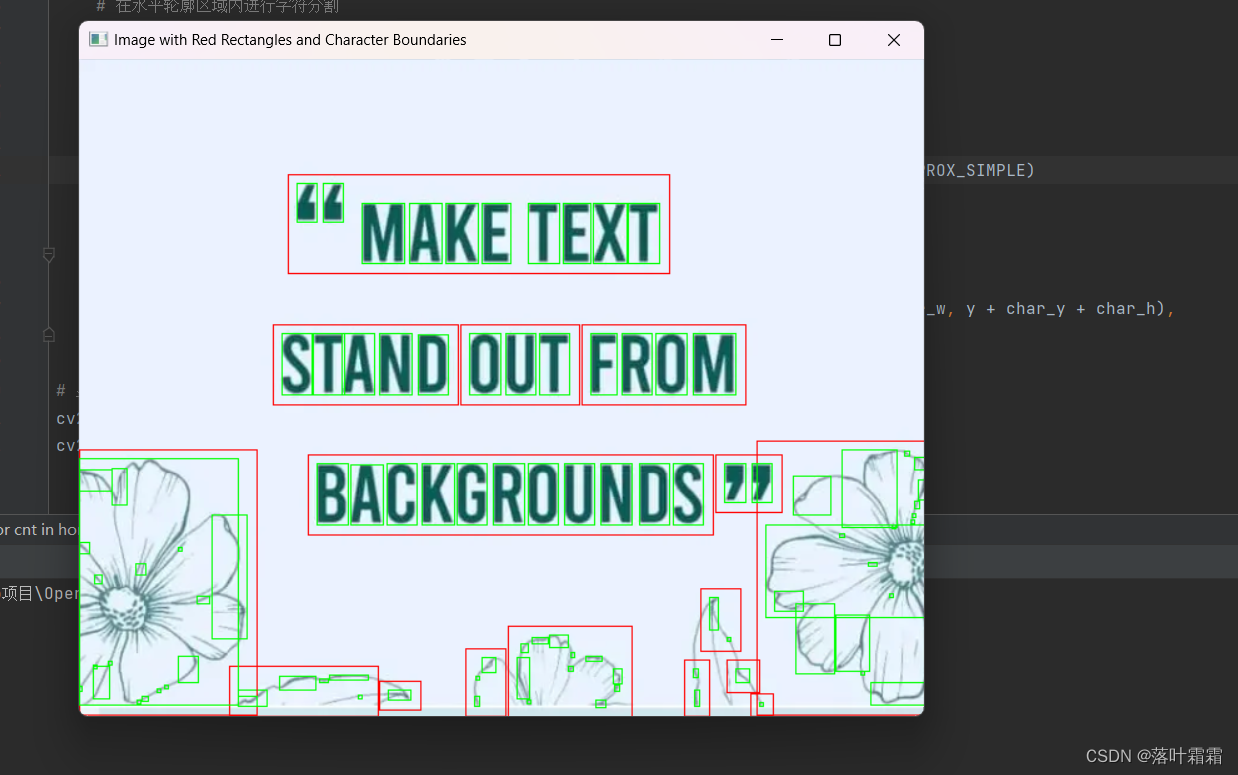

下面是图示:

感谢各位的观看,创作不易,能不能给哥们来一个点赞呢!!!

好了,今天的分享就这么多了,有什么不清楚或者我写错的地方,请多多指教!

私信,评论我呗!!!!!!

关注我下一篇不迷路哦!