技能展示:

- 会构建双机热备系统

- 会构建 LVS+HA 高可用群集

在这个高度信息化的 IT 时代,企业的生产系统、业务运营、销售和支持,以及日常管理等环节越来越依赖于计算机信息和服务,对高可用(HA)技术的应用需求不断提高,以便提供持续的、不间断的计算机系统或网络服务。

本章将学习如何使用 Keepalived 实现双机热备,包括针对 IP 地址的故障切换,以及在LVS 高可用群集中的热备应用。

3.1 Keepalived双机热备基础知识

Keepalived 起初是专门针对 LVS 设计的一款强大的辅助工具,主要用来提供故障切换(Failover)和健康检查(Health Checking)功能——判断 LVS 负载调度器、节点服务器的可用性,当 master 主机出现故障及时切换到 backup 节点保证业务正常,当 master 故障主机恢复后将其重新加入群集并且业务重新切换回 master 节点。

3.1.1 Keepalived概述及安装

Keepalived 的官方网站位于 http://www.keepalived.org/,本章将以 YUM 方式讲解Keepalived 的安装、配置和使用过程。在非 LVS 群集环境中使用时,Keepalived 也可以作为热备软件使用。

3.1.1 Keepalived概述及安装

1. Keepalived的热备方式

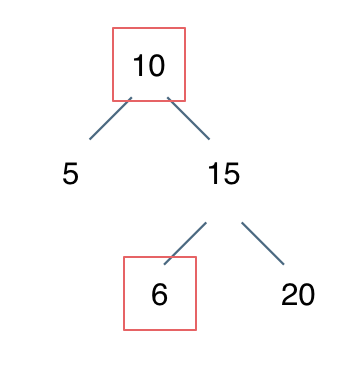

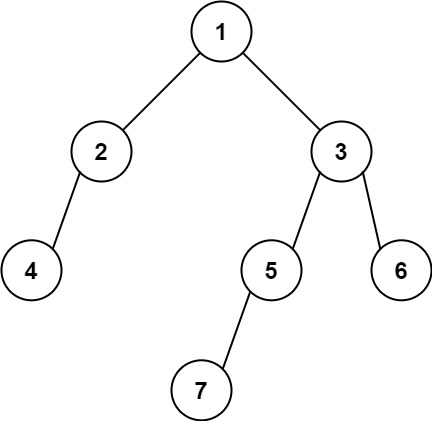

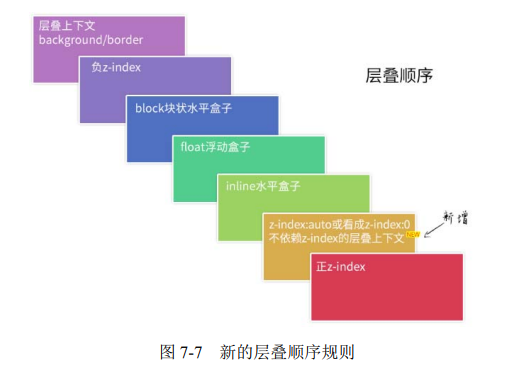

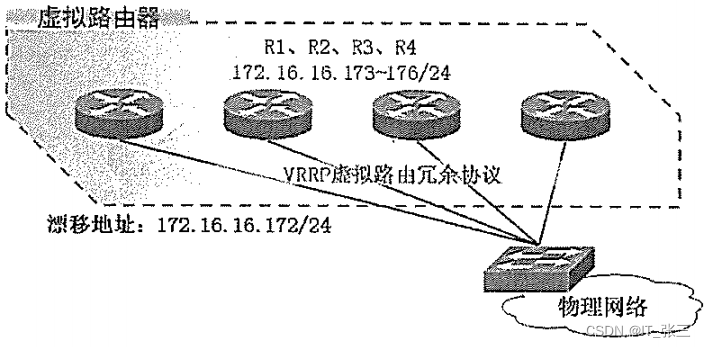

Keepalived 采用 VRRP(Virtual Router Redundancy Protocol,虚拟路由冗余协议)热备份协议,以软件的方式实现 Linux 服务器的多机热备功能。VRRP 是针对路由器的一种备份解决方案——由多台路由器组成一个热备组,通过共用的虚拟 IP 地址对外提供服务;每个热备组内同一时刻只有一台主路由器提供服务,其他路由器处于冗余状态。若当前在线的路由器失效,则其他路由器会自动接替(优先级决定接替顺序)虚拟 IP 地址,以继续提供服务,如图 3.1 所示。

热备组内的每台路由器都可能成为主路由器,虚拟路由器的 IP 地址(VIP)可以在热备组内的路由器之间进行转移,所以也称为漂移 IP 地址。使用 Keepalived 时,漂移地址的实现不需要手动建立虚接口配置文件(如 ens33∶0),而是由 Keepalived 根据配置文件自动管理。

图 3.1 Keepalived 的 VRRP 热备机制

2. Keepalived的安装与服务控制

(1)安装 Keepalived

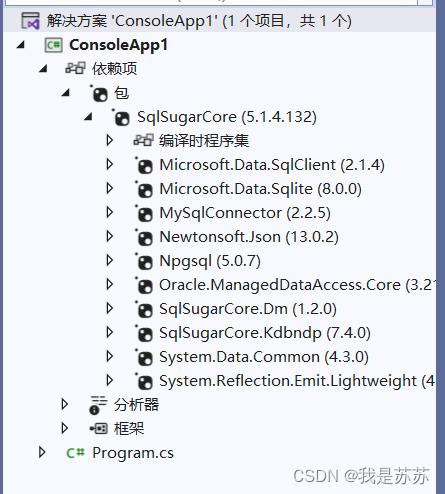

在 CentOS 7 系统中,使用 YUM 方式安装 keepalived.x86_64 0:1.2.13-8.el7,会自动 安装 Keepalived 所需的软件包。除此之外,在 LVS 群集环境中应用时,也需要用到 ipvsadm 管理工具。

[root@node1 ~]# yum -y install keepalived ipvsadm ##两台机器均需要安装(2)控制 Keepalived 服务

YUM 安装 keepalived 后,执行以下命令将 keepalived 服务设置为开机启动。

[root@node1 ~]# systemctl enable keepalived.service ##两台机器均需要安装3.1.2 使用Keepalived实现双机热备

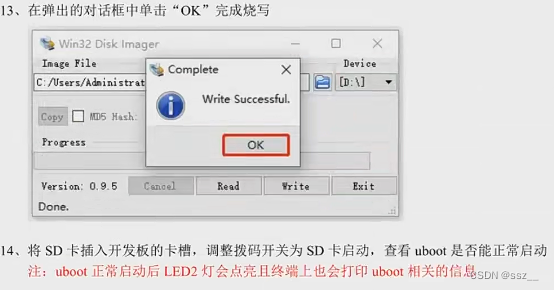

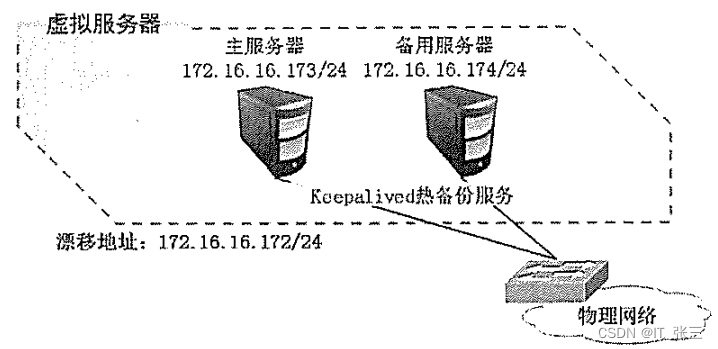

基于 VRRP 的热备方式,Keepalived 可以用作服务器的故障切换,每个热备组可以有多台服务器——当然,最常用的就是双机热备了。在这种双机热备方案中,故障切换主要针对虚拟 IP 地址的漂移来实现,因此能够适用于各种应用服务器(不管是 Web、FTP、Mail,还是 SSH、DNS……)。

本小节将通过一个简单的案例来说明 Keepalived 双机热备的配置方法。其中,主、备服务器的 IP 地址分别为 172.16.16.173 和 172.16.16.174,基于漂移地址 172.16.16.172提供 Web 服务,如图 3.2 所示

图 3.2 Keepalived 双机热备示意图

主、备服务器中都需要安装 Keepalived,使用 YUM 方式安装 httpd 提供 Web 服务。下面仅讲解与 Keepalived 相关的配置及测试过程。

1. 主服务器的配置

Keepalived 服务的配置目录位于/etc/keepalived/。其中,keepalived.conf 是主配置文件。另外包括一个子目录 samples/,提供了许多配置样例作为参考

在 Keepalived 的配置文件中,使用“global_defs {…}”区段指定全局参数,使用“vrrp_instance 实例名称 {…}”区段指定 VRRP 热备参数,注释文字以“!”符号开头。

[root@node1 ~]# systemctl stop firewalld

[root@node1 ~]# cd /etc/keepalived/

[root@node1 keepalived]# cp keepalived.conf keepalived.conf.bak

[root@node1 keepalived]# vim keepalived.conf

global_defs {router_id HA_TEST_R1

}vrrp_instance VI_1 {state MASTERinterface ens33virtual_router_id 1priority 100advert_int 1authentication {auth_type PASSauth_pass 123456}virtual_ipaddress {192.168.8.10}

} 确认上述配置无误,然后启动 Keepalived 服务。实际状态为 MASTER 的主服务器将为 ens33 接口自动添加 VIP 地址,通过 ip 命令可以查看。注意:ifconfig 命令看不到。

[root@node1 keepalived]# systemctl start keepalived.service

[root@node1 keepalived]# ip addr show dev ens33

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000link/ether 00:0c:29:6c:32:f2 brd ff:ff:ff:ff:ff:ffinet 192.168.8.11/24 brd 192.168.8.255 scope global noprefixroute ens33valid_lft forever preferred_lft foreverinet 192.168.8.10/32 scope global ens33valid_lft forever preferred_lft foreverinet6 fe80::7457:78b3:7f51:9a01/64 scope link noprefixroute valid_lft forever preferred_lft forever

[root@node1 keepalived]#

2. 备用服务器的配置

在同一个 Keepalived 热备组内,所有服务器的 Keepalived 配置文件基本相同,包括虚拟路由器的 ID 号、认证信息、漂移地址、心跳频率等。不同之处主要在于路由器名称、热备状态、优先级。

- 路由器名称(router_id):建议为每个参与热备的服务器指定不同的名称。

- 热备状态(state):至少应有一台主服务器,将状态设为 MASTER;可以有多台备用的服务器,将状态设为 BACKUP。

- 优先级(priority):数值越大则取得 VIP 控制权的优先级越高,因此主服务器的优先级应设为最高;其他备用服务器的优先级可依次递减,但不要相同,以免在争夺 VIP 控制权时发生冲突。

配置备用服务器(可以有多台)时,可以参考主服务器的 keepalived.conf 配置文件内容,只需修改路由器名称、热备状态、优先级。

global_defs {router_id HA_TEST_R2

}vrrp_instance VI_1 {state BACKUPinterface ens33virtual_router_id 1priority 99advert_int 1authentication {auth_type PASSauth_pass 123456}virtual_ipaddress {192.168.8.10}

}

[root@node2 keepalived]# systemctl start keepalived.service

确认配置无误,一样需要启动 Keepalived 服务。此时主服务器仍然在线,VIP 地址实际上仍然由主服务器控制,其他服务器处于备用状态。因此,在备用服务器中将不会为 ens33接口添加 VIP 地址。

3. 测试双机热备功能

Keepalived 的日志消息保存在/var/log/messages 文件中,在测试主、备故障自动切换功能时,可以跟踪此日志文件来观察热备状态的变化。以针对连通性和 Web 服务的测试为例,主要操作如下。

(1)连通性测试

在客户机中执行“ping -t 172.16.16.172”命令,能够正常、持续 ping 通,根据以下 操作继续观察测试结果。

① 停止启用主服务器的 Keepalived 服务,发现 ping 测试只中断了 1 或 2 个包即恢复正常,说明已有其他服务器接替 VIP 地址,并及时响应客户机请求。

② 重新启用主服务器的 Keepalived 服务,发现 ping 测试再次中断 1 或 2 个包即恢复正常,说明主服务器已恢复正常,并夺回 VIP 地址的控制权。

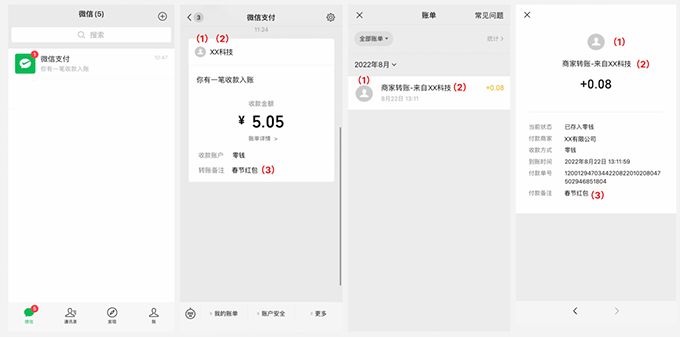

(2)Web 访问测试

在客户机中访问 http://172.16.16.172/,将看到由主服务器 172.16.16.173 提供的网页文档。

① 停止启用主服务器的 Keepalived 服务,再次访问上述 Web 服务,将看到由备用服务器 172.16.16.174 提供的网页文档,说明 VIP 地址已切换至备用服务器。

② 重新启用主服务器的 Keepalived 服务,再次访问上述 Web 服务,将看到重新由主服务器 172.16.16.173 提供的网页文档,说明主服务器已重新夺取 VIP 地址。

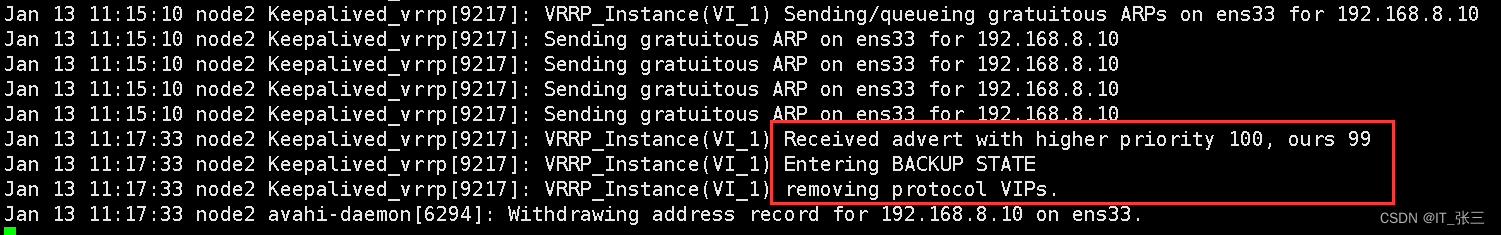

(3)查看日志记录

在执行主、备服务器故障切换的过程中,分别观察各自的/var/log/messages 日志文件,可以看到 MASTER、SLAVE 状态的迁移记录。

① 主服务器中,Keepalived 服务状态先变为“stop”,移除 VIP 地址,恢复后重新变为 MASTER。

② 备用服务器中,状态先切换为 MASTER,待主服务器恢复后再交回控制权。

通过上述测试过程,可以发现双机热备已经正常。客户机只要通过 VIP 地址就可以访问服务器所提供的 Web 等应用。其中,任何一台服务器失效,另一台服务器将会立即接替服务,从而实现高可用性。实际应用时,注意主、备服务器所提供的 Web 服务内容要保持一致。

3.2 LVS+Keepalived高可用群集

Keepalived 的设计目标是构建高可用的 LVS 负载均衡群集,可以调用 ipvsadm 工具来创建虚拟服务器、管理服务器池,而不仅仅用作双机热备。使用 Keepalived 构建 LVS 群集更加简便易用,主要优势体现在:对 LVS 负载调度器实现热备切换,提高可用性;对服务器池中的节点进行健康检查,自动移除失效节点,恢复后再重新加入。

在基于 LVS+Keepalived 实现的 LVS 群集结构中,至少包括两台热备的负载调度器,三台以上的节点服务器。本节将以 DR 模式的 LVS 群集为基础,增加一台从负载调度器,使用Keepalived 来实现主、从调度器的热备,从而构建兼有负载均衡、高可用两种能力的 LVS网站群集平台,如图 3.3 所示。

图 3.3 LVS+Keepalived 高可用群集示意

使用 Keepalived 构建 LVS 群集时,也需要用到 ipvsadm 管理工具。但大部分工作会由Keepalived 自动完成,不需要手动执行 ipvsadm(除了查看和监控群集以外)。下面主要讲解 Keepalived 的服务器池设置,关于 NFS 共享服务的配置、Keepalived 的热备配置等在此不再详细阐述。

1. 配置主调度器

配置主调度器步骤如下:

(1)全局配置、热备配置

首先为主、从调度器实现热备功能,漂移地址使用 LVS 群集的 VIP 地址。

[root@node1 ~]# cd /etc/keepalived/

[root@node1 keepalived]# vim keepalived.conf

global_defs {router_id HA_TEST_R1

}vrrp_instance VI_1 {state MASTERinterface ens33virtual_router_id 1priority 100advert_int 1authentication {auth_type PASSauth_pass 123456}virtual_ipaddress {192.168.8.10}

}vrrp_instance VI_2 {state MASTERinterface ens36virtual_router_id 2priority 100advert_int 1authentication {auth_type PASSauth_pass 123456}virtual_ipaddress {192.168.10.10}

}[root@node1 keepalived]# systemctl restart keepalived.service

[root@node1 keepalived]# ip addr show dev ens36

3: ens36: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000link/ether 00:0c:29:6c:32:fc brd ff:ff:ff:ff:ff:ffinet 192.168.10.11/24 brd 192.168.10.255 scope global noprefixroute ens36valid_lft forever preferred_lft foreverinet 192.168.10.10/32 scope global ens36valid_lft forever preferred_lft foreverinet6 fe80::f237:a7e7:aa9:c19f/64 scope link noprefixroute valid_lft forever preferred_lft forever

[root@node1 keepalived]# [root@node2 keepalived]# vim keepalived.conf

global_defs {router_id HA_TEST_R2

}vrrp_instance VI_1 {state BACKUPinterface ens33virtual_router_id 1priority 99advert_int 1authentication {auth_type PASSauth_pass 123456}virtual_ipaddress {192.168.8.10}

}vrrp_instance VI_2 {state BACKUPinterface ens36virtual_router_id 2priority 99advert_int 1authentication {auth_type PASSauth_pass 123456}virtual_ipaddress {192.168.10.10}

}[root@node2 keepalived]# systemctl restart keepalived.service

[root@node2 keepalived]# ip add show dev ens36

3: ens36: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000link/ether 00:0c:29:59:ba:e7 brd ff:ff:ff:ff:ff:ffinet 192.168.10.12/24 brd 192.168.10.255 scope global noprefixroute ens36valid_lft forever preferred_lft foreverinet6 fe80::78de:7a13:fd75:e51a/64 scope link noprefixroute valid_lft forever preferred_lft forever

[root@node2 keepalived]# (2)Web 服务器池配置

在 Keepalieved 的热备配置基础上添加“virtual_server VIP 端口 { ... }”区段来配置虚拟服务器,主要包括对负载调度算法、群集工作模式、健康检查间隔、真实服务器地址等参数的设置。

virtual_server 192.168.8.10 80 {delay_loop 15lb_algo rr lb_kind DR

! persistence_timeout 50protocol TCPreal_server 192.168.8.11 80 {weight 1TCP_CHECK {connect_port 80connect_timeout 3nb_get_retry 3delay_before_retry 4} } real_server 192.168.8.12 80 {weight 1TCP_CHECK {connect_port 80connect_timeout 3nb_get_retry 3delay_before_retry 4} }

}(3)主/从机器的参数配置

[root@node1 ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0[root@node1 ~]# sysctl -p

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0[root@node1 ~]# systemctl restart keepalived.service(4)Web服务站参数配置

[root@node4 network-scripts]# vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2[root@node4 network-scripts]# sysctl -p

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2[root@node4 ~]# cd /etc/sysconfig/network-scripts/

[root@node4 network-scripts]# cp ifcfg-lo ifcfg-lo:0

[root@node4 network-scripts]# vim ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.8.10

NETMASK=255.255.255.255

ONBOOT=yes[root@node4 network-scripts]# ifup ifcfg-lo:0

[root@node4 network-scripts]# ifconfig