欢迎来到文思源想的ai空间,这是技术老兵重学ai以及成长思考的第12篇分享!

这周时间看了两本书,一本是大神斯蒂芬·沃尔弗拉姆学的《这就是ChatGPT》,另外一本则是腾讯云生态解决方案高级架构师宋立恒所写的《AI制胜机器学习极简入门》,收获还是很大的。

《这就是chatGPT》反复看了三次,才算是理解到了大神的一些想法,但是感觉很值得,它从第一性原理的角度,解释了如今chatGPT本质的一些工作原理,个人感觉对于ai的概念,没有那么陌生了,或者说因为了解到一些本质更有自信。其实看完书,有点懊恼,感觉好歹大学习和研究生期间,机器视觉、人工网络这些都是我的专业必修课,如今随着工作性质,都还回去,有点遗憾。

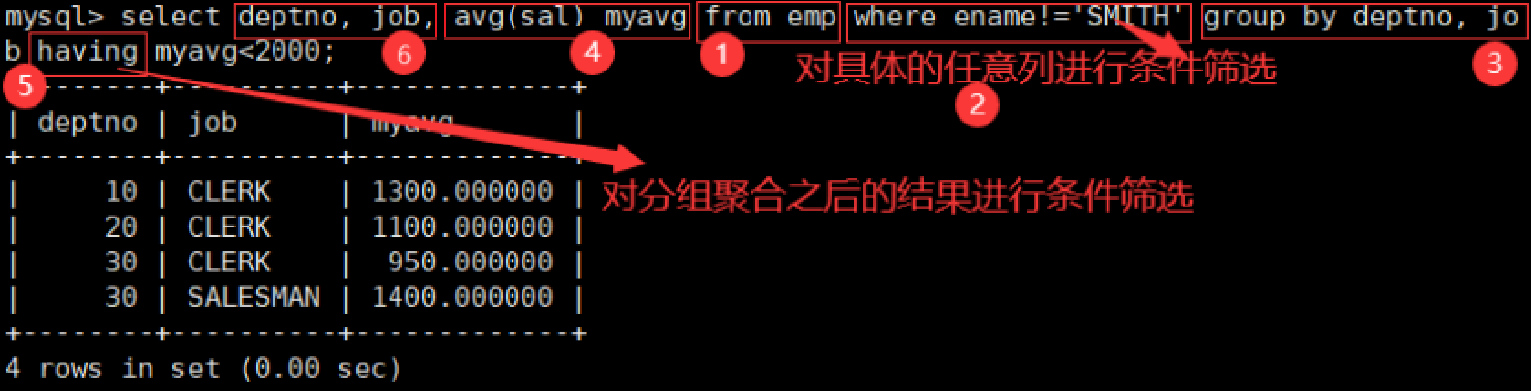

《AI制胜机器学习极简入门》则是为了弄懂《这就是chatGPT》的一些概念,我自己额外看的一本书,书中前面两张的概览还是作用挺大的,它清晰的对于机器学习的结构、总体思路做了一些梳理,也从作者工作实践的角度提出了对待这些算法、工具的实践技巧。后面的算法许多是读书时候接触过的,我并没有深入查看,先记录着,没准以后会用上。

1 人工智能、机器学习、深度学习、chatgpt、sora关系梳理

- 人工智能(Artificial Intelligence, AI):人工智能是一个广泛的领域,旨在使计算机能够模拟人类智能,包括学习、推理、感知、自然语言处理等方面。

- 机器学习(Machine Learning):机器学习是人工智能的一个分支,它关注的是让计算机通过数据自动学习和改进的方法。机器学习算法可以从大量的数据中发现模式和规律,并用于预测、分类、聚类等任务。

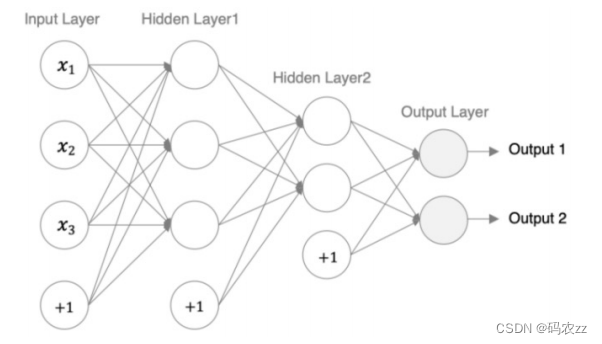

- 深度学习(Deep Learning):深度学习是机器学习的一种特殊形式,它基于神经网络模型,通过大量的数据进行训练,以实现更复杂的任务,如图像识别、语音识别等。

- ChatGPT:ChatGPT 是 OpenAI 开发的一种大型语言模型,它使用了深度学习技术,特别是 Transformer 架构,来处理自然语言处理任务,如对话生成、问答等。

- Sora:Sora是OpenAI开发的一种视频生成模型,可以拿视频中的一帧出来,效果都不亚于Dalle-3精心生成一张图片,而且这些图片放在一起可以构成基本符合真实世界物理逻辑的视频。Sora采用深度学习的方法,特别是扩散型变换器模型,通过构建深度神经网络模型来模拟人脑神经元的连接方式,从而实现对复杂数据的处理和学习。

2 chatgpt本质是什么?

摘抄了斯蒂芬的两句话:

ChatGPT从根本上始终要做的是,针对它得到的任何文本产生“合理的延续”。这里所说的“合理”是指,“人们在看到诸如数十亿个网页上的内容后,可能期待别人会这样写”。

ChatGPT的基本结构—“仅仅”用这么少的参数—足以生成一个能“足够好”地计算下一个词的概率的模型,从而生成合理的文章。

ChatGPT的基本概念在某种程度上相当简单:首先从互联网、书籍等获取人类创造的海量文本样本,然后训练一个神经网络来生成“与之类似”的文本。特别是,它能够从“提示”开始,继续生成“与其训练数据相似的文本”。

ChatGPT的具体工程非常引人注目。但是,(至少在它能够使用外部工具之前)ChatGPT“仅仅”是从其积累的“传统智慧的统计数据”中提取了一些“连贯的文本线索”。但是,结果的类人程度已经足够令人惊讶了。正如我所讨论的那样,这表明了一些至少在科学上非常重要的东西:人类语言及其背后的思维模式在结构上比我们想象的更简单、更“符合规律”。ChatGPT已经隐含地发现了这一点。但是我们可以用语义语法、计算语言等来明确地揭开它的面纱。

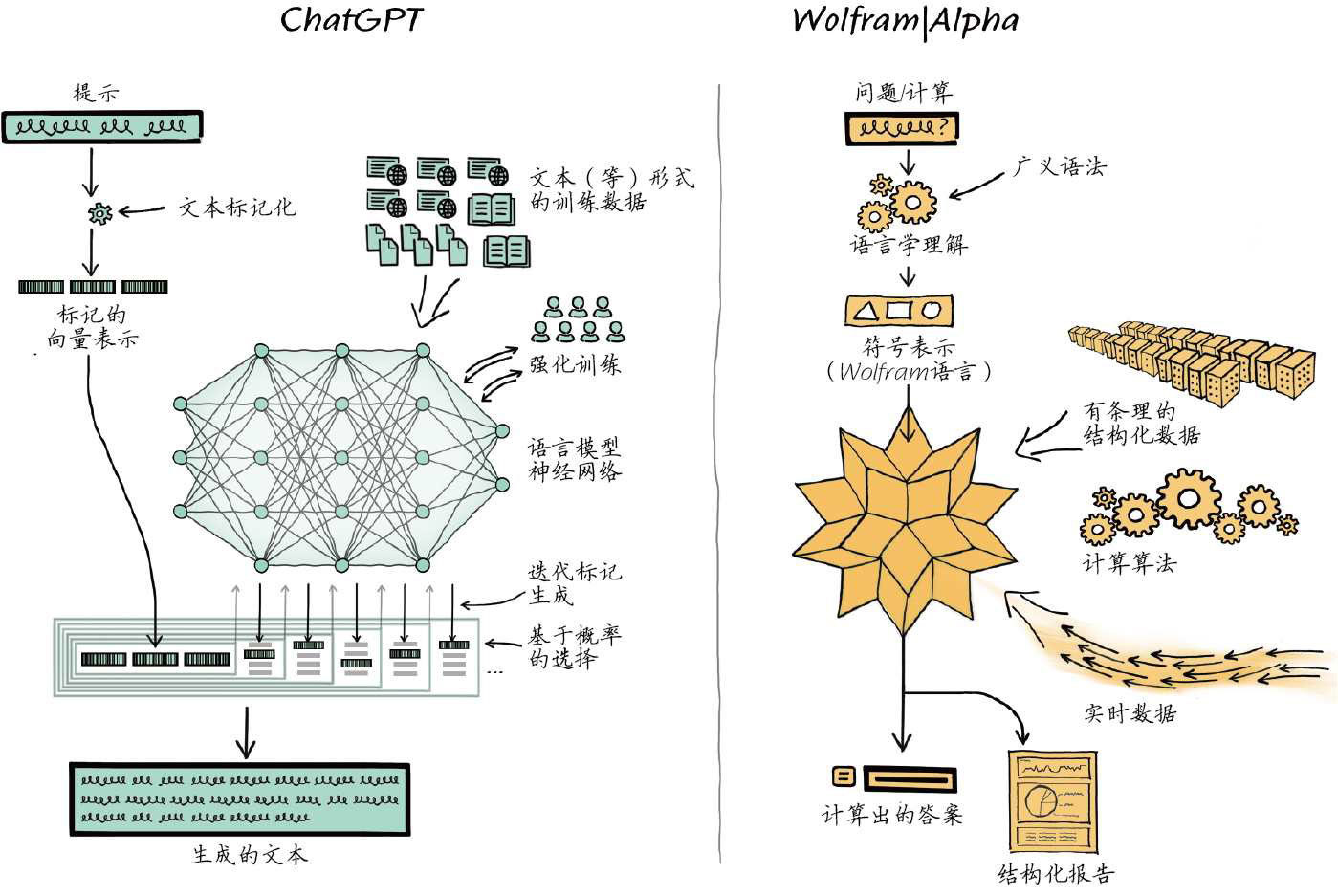

3 ChatGPT与Wolfram的关系

ChatGPT 和 Wolfram 并没有直接的关系,ChatGPT 是一个大型语言模型,而 Wolfram 插件是一个可以与 ChatGPT 结合使用的工具。Wolfram 插件提供了对 Wolfram 知识引擎的访问,使得 ChatGPT 能够获取更广泛的知识和计算能力。

ChatGPT 是由 OpenAI 开发的一种大型语言模型,它通过对大量文本数据的学习,能够生成自然语言文本、回答问题、进行对话等。而 Wolfram 则是由 Wolfram Research 开发的一系列技术和工具,包括数学计算软件 Wolfram Mathematica、知识引擎 Wolfram Alpha 等。

虽然两者都涉及到自然语言处理和知识的应用,但它们的设计目的、应用场景和技术实现方式等方面可能存在差异。具体来说,ChatGPT 主要用于对话和文本生成等任务,而 Wolfram 的产品则更侧重于数学计算、知识查询和可视化等方面。

当然,在某些情况下,ChatGPT 或其他自然语言处理模型的输出可以与 Wolfram 的技术或工具结合使用,以提供更全面和准确的信息或解决更复杂的问题。例如,可以将 ChatGPT 的回答与 Wolfram Alpha 的知识引擎相结合,以获取更准确的数学或科学知识。

4 可学习性和计算不可约性

可学习性通常指的是一个模型或算法能够从给定的数据中学习到有用的信息或模式的能力。在机器学习中,可学习性是评估一个学习算法是否能够在给定的训练数据上有效地学习到目标函数或模式的重要指标。如果一个模型具有可学习性,那么它可以通过对训练数据的学习来改进其性能,并在新的数据上做出准确的预测或分类。

计算不可约性则是理论计算机科学中的一个概念,它与问题的计算复杂度和可解性有关。计算不可约性指的是某些问题在计算上是不可约的,意味着无法通过已知的算法或方法在多项式时间内解决。这些问题可能需要指数级或更高的计算资源来解决,因此被认为是难以处理的。

可学习性与计算复杂性的关系可以从以下几个方面来理解:

- 学习能力的限制:计算复杂性的理论限制了某些问题的可学习性。如果一个问题的计算复杂性很高,可能需要大量的数据和计算资源来学习,或者可能根本无法通过现有方法进行有效学习。

- 模型的复杂度:模型的复杂度也与可学习性和计算复杂性有关。更复杂的模型可能具有更高的表达能力,但也可能导致更高的计算复杂性和过拟合的风险。

- 数据需求:计算复杂性较高的问题可能需要更多的数据来进行有效的学习。充足的数据可以帮助模型更好地学习和泛化,从而在一定程度上缓解计算复杂性的影响。

- 算法效率:用于学习的算法本身的效率也会影响可学习性和计算复杂性。更高效的算法可以在相同的计算资源下实现更好的学习效果。

然而,需要注意的是,可学习性和计算复杂性并不是简单的直接对应关系。即使一个问题具有较高的计算复杂性,仍然可以通过合适的学习算法、数据增强、模型简化等方法来提高可学习性。同时,一些问题可能在计算上是可解的,但在实际学习中可能由于数据噪声、模型偏差等因素而变得具有挑战性。

总之,可学习性和计算复杂性是相互关联的概念,但它们的关系并不是一一对应的。在实际应用中,需要根据具体问题和场景来综合考虑可学习性、计算复杂性以及其他相关因素,选择合适的方法和算法来解决问题。

这里也再次引用下下斯蒂芬的理解:“可学习性和计算不可约性之间存在根本的矛盾。学习实际上涉及通过利用规律来压缩数据,但计算不可约性意味着最终对可能存在的规律有一个限制。能力和可训练性之间存在着一个终极权衡:你越想让一个系统“真正利用”其计算能力,它就越会表现出计算不可约性,从而越不容易被训练;而它在本质上越易于训练,就越不能进行复杂的计算。”

5 关于ai工具与理论学习

AI 工具是实现 AI 应用的实际工具和框架,例如深度学习框架(如 TensorFlow、PyTorch)、自然语言处理工具(如 NLTK、SpaCy)等。学习这些工具可以帮助你实际应用和实现各种 AI 算法,进行数据处理、模型训练和部署等操作。

AI 算法理论则关注于算法的原理、设计和分析。它包括各种机器学习算法、深度学习模型、强化学习策略等的理解和研究。学习算法理论可以帮助你深入理解 AI 系统的工作原理,掌握不同算法的优缺点和适用场景。

工具就像是武器,学会使用某种工具,只是学会了这种武器最基本的招式和套路。而理论学习即策略学习,决定了在未来真实对战中,遇到对手攻击时,你选取哪些招式套路,如何组合起来去迎敌。

6 chatgpt发展历史

2014年,富兰克林·欧林工程学院本科毕业两年的亚历克·拉德福德(Alec Radford)加入OpenAI,开始发力。作为主要作者,他在苏茨克维等的指导下,连续完成了PPO(2017)、GPT-1(2018)、GPT-2(2019)、Jukebox(2020)、ImageGPT(2020)、CLIP(2021)和Whisper(2022)等多项开创性工作。尤其是2017年关于情感神经元的工作,开创了“预测下一个字符”的极简架构结合大模型、大算力、大数据的技术路线,对后续的GPT产生了关键影响。

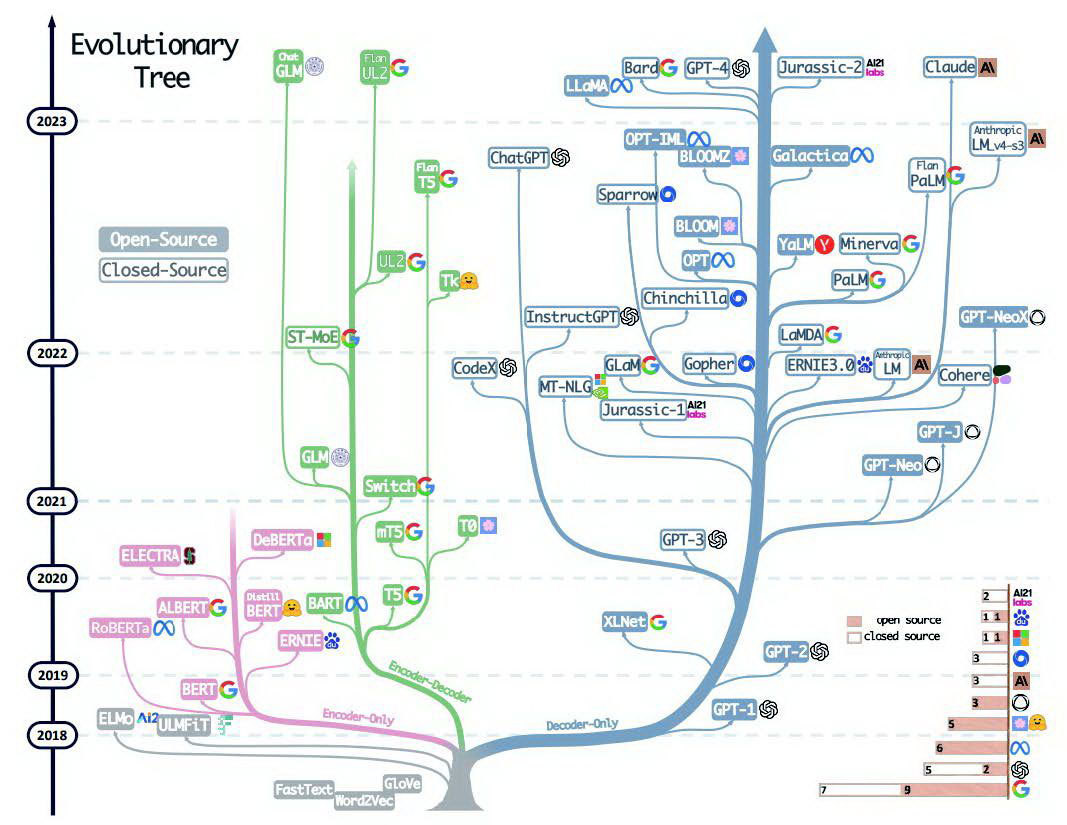

从下页图中可以清晰地看到,GPT-1的论文发表之后,OpenAI这种有意为之的更加简单的Eecoder-Only架构(准确地讲是带自回归的Encoder-Decoder架构)并没有得到太多关注,风头都被谷歌几个月之后发布的BERT(Encoder-Only架构,准确地讲是Encoder-非自回归的Decoder架构)抢去了。随后,出现了一系列xxBERT类的很有影响的工作。

2020年,GPT-3横空出世,NLP(natural language processing,自然语言处理)小圈子里的一些有识之士开始意识到OpenAI技术路线的巨大潜力。在中国,北京智源人工智能研究院联合清华大学等高校推出了GLM、CPM等模型,并积极在国内学术界推广大模型理念。从上页关于大模型进化树的图中可以看到,2021年之后,GPT路线已经完全占据上风,而BERT这一“物种”的进化树几乎停止了。

2020年底,OpenAI的两位副总达里奥·阿莫迪(Dario Amodei)和丹妮拉·阿莫迪(Daniela Amodei)(同时也是兄妹)带领GPT-3和安全团队的多位同事离开,创办了Anthropic。达里奥·阿莫迪在OpenAI的地位非同一般:他是伊尔亚·苏茨克维之外,技术路线图的另一个制定者,也是GPT-2和GPT-3项目以及安全方向的总负责人。而随他离开的,有GPT-3和规模法则论文的多位核心人员

1年后,Anthropic发表论文“A General Language Assistant as a Laboratory for Alignment”,开始用聊天助手研究对齐问题,此后逐渐演变为Claude这个智能聊天产品。

2022年6月,论文“Emergent Abilities of Large Language Models”发布,第一作者是仅从达特茅斯学院本科毕业两年的谷歌研究员JasonWei(今年2月,他在谷歌的“精英跳槽潮”中去了OpenAI)。他在论文中研究了大模型的涌现能力,这类能力在小模型中不存在,只有模型规模扩大到一定量级才会出现——也就是我们熟悉的“量变会导致质变”。

当年11月中旬,本来一直在研发GPT-4的OpenAI员工收到管理层的指令:所有工作暂停,全力推出一款聊天工具,原因是有竞争。两周后,ChatGPT诞生。这之后的事情已经载入史册。

2023年3月,在长达半年的“评估、对抗性测试和对模型及系统级缓解措施的迭代改进”之后,GPT-4发布。微软研究院对其内部版本(能力超出公开发布的线上版本)研究的结论是:“在所有这些任务中,GPT-4的表现与人类水平接近得惊人……鉴于GPT-4的广度和深度,我们认为它可以合理地被视为AGI系统早期(但仍然不完整)的版本。”

7 后续扩展

- 《GPT图解》- 黄佳老师

- 文章《ChatGPT在做什么?它为何能做到这些?》(“What Is ChatGPT Doing... and Why Does It Work?”):本书在线版本,包含可运行的代码

- 文章《初中生能看懂的机器学习》(“Machine Learning for Middle Schoolers”,作者:Stephen Wolfram):介绍机器学习的基本概念

- 图书《机器学习入门》(Introduction to Machine Learning,Etienne Bernard著):一本关于现代机器学习的指南,包含可运行的代码

- 网站“Wolfram机器学习”(Wolfram Machine Learning):阐释Wolfram语言中的机器学习能力

- Wolfram U上的机器学习课程:交互式的机器学习课程,适合不同层次的学生学习

- 文章《如何与AI交流?》(“How Should We Talk to AIs?”,作者:Stephen Wolfram):2015年的一篇短文,探讨了如何使用自然语言和计算语言与AI交流