-

ELFK的组成:

-

- Elasticsearch: 它是一个分布式的搜索和分析引擎,它可以用来存储和索引大量的日志数据,并提供强大的搜索和分析功能。 (java语言开发,)

- logstash: 是一个用于日志收集,处理和传输的工具,它可以从各种数据源收集日志数据,对数据进行处理和过滤,将数据发送到Elasticsearch。 java

- kibana: 是一个用于数据可视化和分析的工具,它可以与Elasticsearch集成,帮助用户通过图表、仪表盘等方式直观地展示和分析日志数据。 java

- filebeat: 轻量级日志收集工具,一般安装在客户端服务器上负责收集日志,传输到ES或logstash go

-

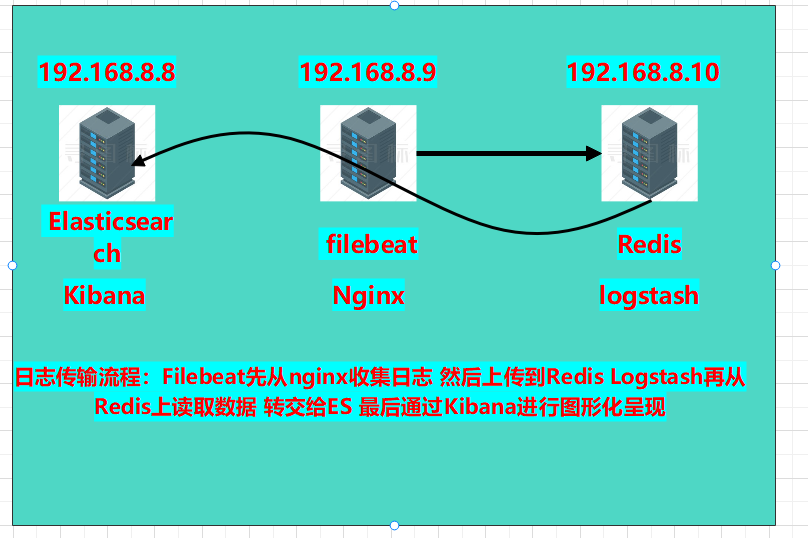

本章实验环境拓扑图:

-

- 版本介绍:

- Elasticsearch:6.6.0

- kibana:6.6.0

- filebeat:6.6.0

- nginx:1.18.0

- Redis:5.0.7

- logstash:6.6.0

- 开始部署:

- 部署8.8服务器的es和Kibna:a

- 复制软件包至服务器下安装:

- rpm -ivh elasticsearch-6.6.0.rpm

- 修改配置文件:

- vim /etc/elasticsearch/elasticsearch.yml

-

node.name: es1 path.data: /data/elasticsearch path.logs: /var/log/elasticsearch bootstrap.memory_lock: true network.host: 192.168.8.8,127.0.0.1 http.port: 9200

-

- vim /etc/elasticsearch/elasticsearch.yml

- 创建数据目录,并修改权限

-

mkdir -p /data/elasticsearch chown -R elasticsearch.elasticsearch /data/elasticsearch/

-

- 启动es:systemctl start elasticsearch

- 部署安装kibana:

- 安装kibana:rpm -ivh kibana-6.6.0-x86_64.rpm

- 修改配置文件:

- 修改项:

-

server.port: 5601 server.host: "192.168.8.8" server.name: "db01" #自己所在主机的主机名 elasticsearch.hosts: ["http://192.168.8.8:9200"] #es服务器的ip,便于接收日志数据 保存退出

-

- 修改项:

- 启动kibana:systemctl start kibana

- 查看两个服务的端口是否存在:

- netstat -anpt | grep 5601

- netstat -anpt | grep 9200

- 复制软件包至服务器下安装:

- 部署8.9服务器山的nginx和filebeat:

- 安装filebeat:

- rpm -ivh filebeat-6.6.0-x86_64.rpm

- 修改配置文件:

- vim /etc/filebeat/filebeat.yml (清空源内容,直接覆盖)

-

filebeat.inputs: (日志来源) - type: log (日志格式)enabled: true (开机自启)paths: (日志路径)- /var/log/nginx/access.logoutput.elasticsearch: (日志传送到那)hosts: ["192.168.8.8:9200"]

-

-

启动filebeat服务:

-

systemctl start filebeat

-

- vim /etc/filebeat/filebeat.yml (清空源内容,直接覆盖)

-

安装nginx:

-

yum -y install nginx

-

启动nginx:nginx

-

- 安装filebeat:

-

在8.8服务器上安装网站压力测试工具:

-

yum -y install httpd-tools

-

-

2.使用ab压力测试工具测试访问

-

ab -c 1000 -n 20000 http://192.168.8.9/

-c(并发数) -n(请求数)

-

- 部署8.8服务器的es和Kibna:a

-

使用浏览器扩展程序登录es查看索引是否有访问数:

-

-

修改nginx的日志个数为json:

-

vim /etc/nginx/nginx.conf

-

添加在http{}内:

-

log_format log_json '{ "@timestamp": "$time_local", ' '"remote_addr": "$remote_addr", ' '"referer": "$http_referer", ' '"request": "$request", ' '"status": $status, ' '"bytes": $body_bytes_sent, ' '"agent": "$http_user_agent", ' '"x_forwarded": "$http_x_forwarded_for", ' '"up_addr": "$upstream_addr",' '"up_host": "$upstream_http_host",' '"up_resp_time": "$upstream_response_time",' '"request_time": "$request_time"' ' }';access_log /var/log/nginx/access.log log_json;

-

-

重启服务:systemctl restart nginx

-

-

修改filebeat.yml文件,区分nginx的访问日志和错误日志

-

vim /etc/filebeat/filebeat.yml

-

修改为: filebeat.inputs: - type: logenabled: truepaths:- /var/log/nginx/access.logjson.keys_under_root: truejson.overwrite_keys: truetags: ["access"]- type: logenabled: truepaths:- /var/log/nginx/error.logtags: ["error"]output.elasticsearch:hosts: ["192.168.8.8:9200"]indices:- index: "nginx-access-%{+yyyy.MM.dd}"when.contains:tags: "access"- index: "nginx-error-%{+yyyy.MM.dd}"when.contains:tags: "error"setup.template.name: "nginx" setup.template.patten: "nginx-*" setup.template.enabled: false setup.template.overwrite: true

-

-

重启服务:systemctl restart filebeat

-

-

使用ab工具压力测试一下网站:

-

测试访问数据:ab -c 1000 -n 20000 http://192.168.8.9/

-

测试错误数据:ab -c 1000 -n 20000 http://192.168.8.9/444.html

-

可以看到es收集到了两个索引:

-

-

-

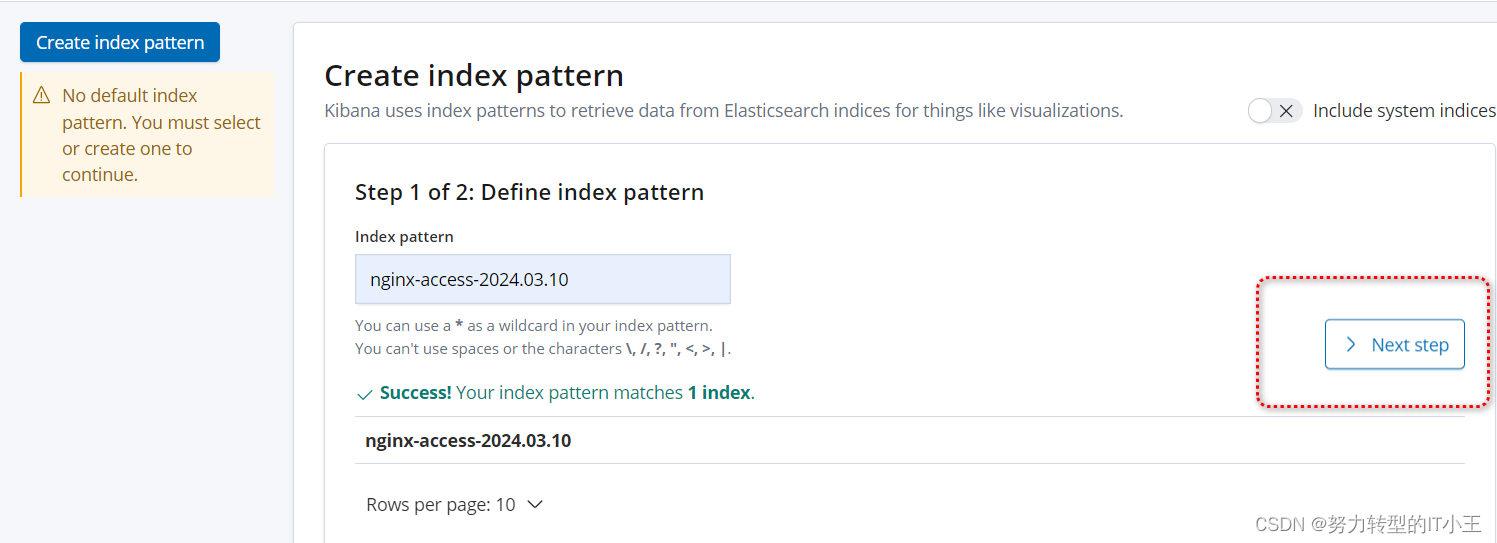

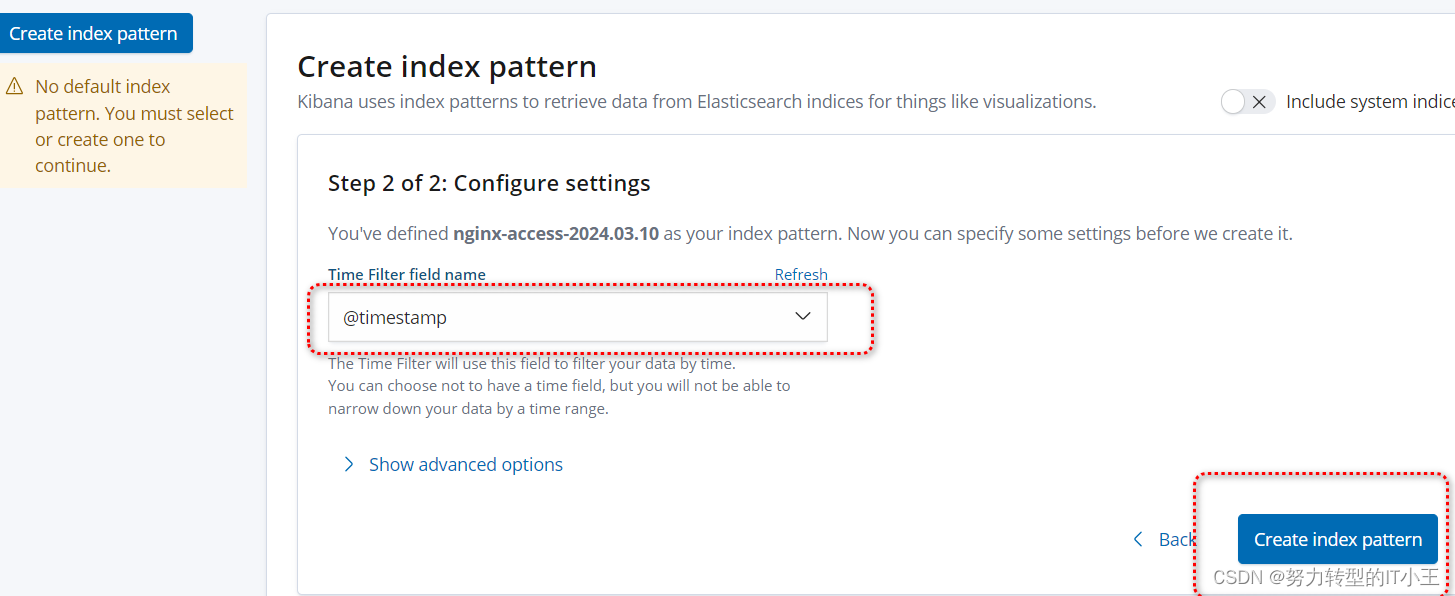

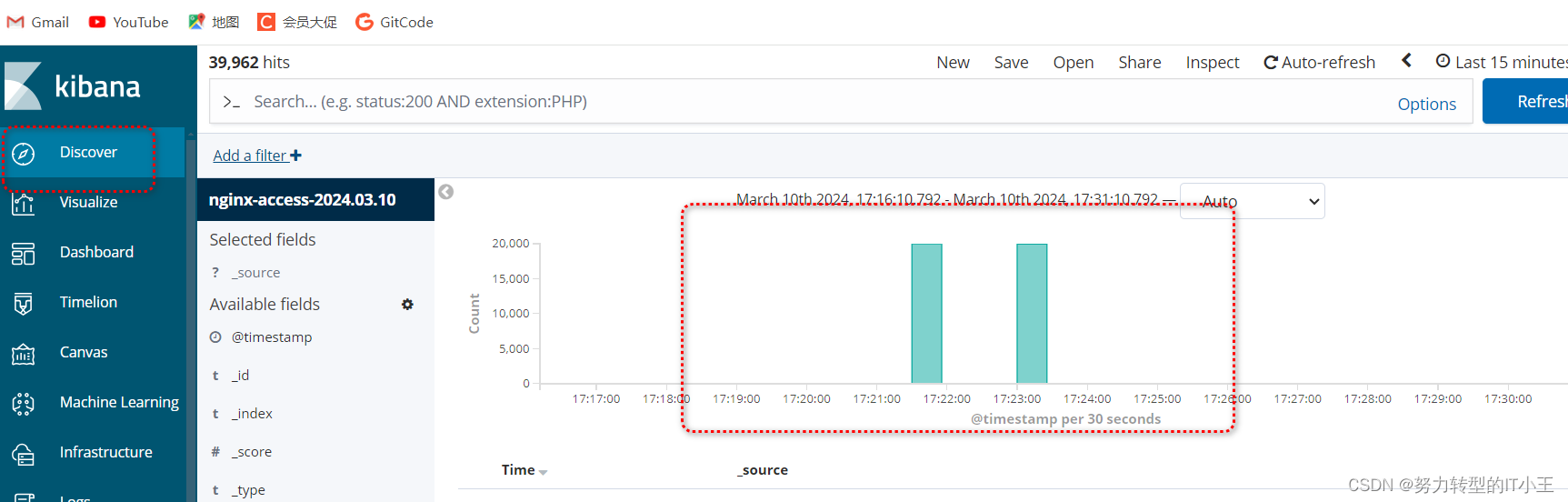

使用kibana图形化展示日志访问数据:

-

http://192.168.8.8:5601/

-

创建索引,图形化展示:

-

-

按照此步骤 将error错误索引页创建一下即可

-

-

虽然以上环境也可以进行日志收集,但只适用于中小型公司,以下再多增加一台服务器,安装redis实现消息队列,和logstash日志采集,增加吞吐量。

-

在8.10服务器上部署redis和logstash:

-

准备安装目录和数据目录:

-

mkdir -p /data/soft mkdir -p /opt/redis_cluster/redis_6379/{conf,logs,pid}

-

-

下载redis安装包:

-

cd /data/soft wget http://download.redis.io/releases/redis-5.0.7.tar.gz

-

-

将软件包解压到/opt/redis_cluster文件夹中:

-

tar xf redis-5.0.7.tar.gz -C /opt/redis_cluster/ ln -s /opt/redis_cluster/redis-5.0.7 /opt/redis_cluster/redis

-

-

切换目录编译安装redis:

-

cd /opt/redis_cluster/redis make && make install

-

-

编写redis配置文件:

-

vim /opt/redis_cluster/redis_6379/conf/6379.conf

-

bind 127.0.0.1 192.168.8.10 port 6379 daemonize yes pidfile /opt/redis_cluster/redis_6379/pid/redis_6379.pid logfile /opt/redis_cluster/redis_6379/logs/redis_6379.log databases 16 dbfilename redis.rdb dir /opt/redis_cluster/redis_6379

-

-

启动redis服务:redis-server /opt/redis_cluster/redis_6379/conf/6379.conf

-

-

修改8.9的filebeat文件(将filebeat收集的日志转发给redis):

-

vim /etc/filebeat/filebeat.yml

-

filebeat.inputs: - type: logenabled: truepaths:- /var/log/nginx/access.logjson.keys_under_root: truejson.overwrite_keys: truetags: ["access"]- type: logenabled: truepaths:- /var/log/nginx/error.logtags: ["error"]setup.template.settings:index.number_of_shards: 3setup.kibana:output.redis:hosts: ["192.168.8.10"]key: "filebeat"db: 0timeout: 5

-

- 重启服务:systemctl restart filebeat

- 再次在8.8上使用压力测试工具访问网站:ab -c 1000 -n 20000 http://192.168.8.9/

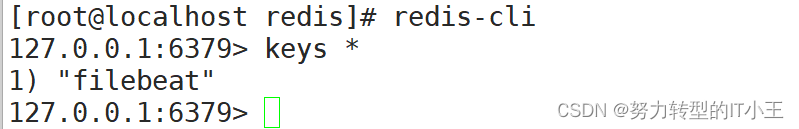

- 登录redis数据库:redis-cli

- 查看是否有以filebeat命名的键:

- filebeat与redis关联成功!

- 查看是否有以filebeat命名的键:

-

-

- 继续在8.10服务器上部署logstash:

- rpm -ivh logstash-6.6.0.rpm

- 修改logstash配置文件,实现access和error日志分离

- vim /etc/logstash/conf.d/redis.conf

-

input {redis {host => "192.168.8.10"port => "6379"db => "0"key => "filebeat"data_type => "list"} }filter {mutate {convert => ["upstream_time","float"]convert => ["request_time","float"]} }output {stdout {}if "access" in [tags] {elasticsearch {hosts => ["http://192.168.8.8:9200"]index => "nginx_access-%{+YYYY.MM.dd}"manage_template => false}}if "error" in [tags] {elasticsearch {hosts => ["http://192.168.8.8:9200"]index => "nginx_error-%{+YYYY.MM.dd}"manage_template => false}} }

-

- 最后重启logstash:

-

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/redis.conf

-

-

过程需等待,启动较慢(大约2-3分钟)

- vim /etc/logstash/conf.d/redis.conf

-

最后通过kibana图形化界面,可以看到nginx的access日志和error错误日志即可,最终效果和仅部署elk效果一致,只不过添加了redis数据库和filebeat日志收集工具,有了redis可以实现了消息队列为es服务器减轻了压力。

-

ELFK 分布式日志收集系统

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.rhkb.cn/news/272972.html

如若内容造成侵权/违法违规/事实不符,请联系长河编程网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

Linux系统下使用C++推流多路视频流

先看拉取的视频流效果: 代码如下: 一开始打算使用python写多路视频推流,但在ubuntu系统上搞了好久就是搞不定openh264导致的错误,然后改用c了,代码如下,我这里推了两路视频流,一路是网络摄像头&…

2024护网面试题精选(二)完

0x02. 内网渗透篇

00- 内网渗透的流程

拿到跳板后,先探测一波内网存活主机,用net user /domian命令查看跳板机是否在域 内,探测存活主机、提权、提取hash、进行横向移动,定位dc位置,查看是否有能直接提权域 管的漏洞…

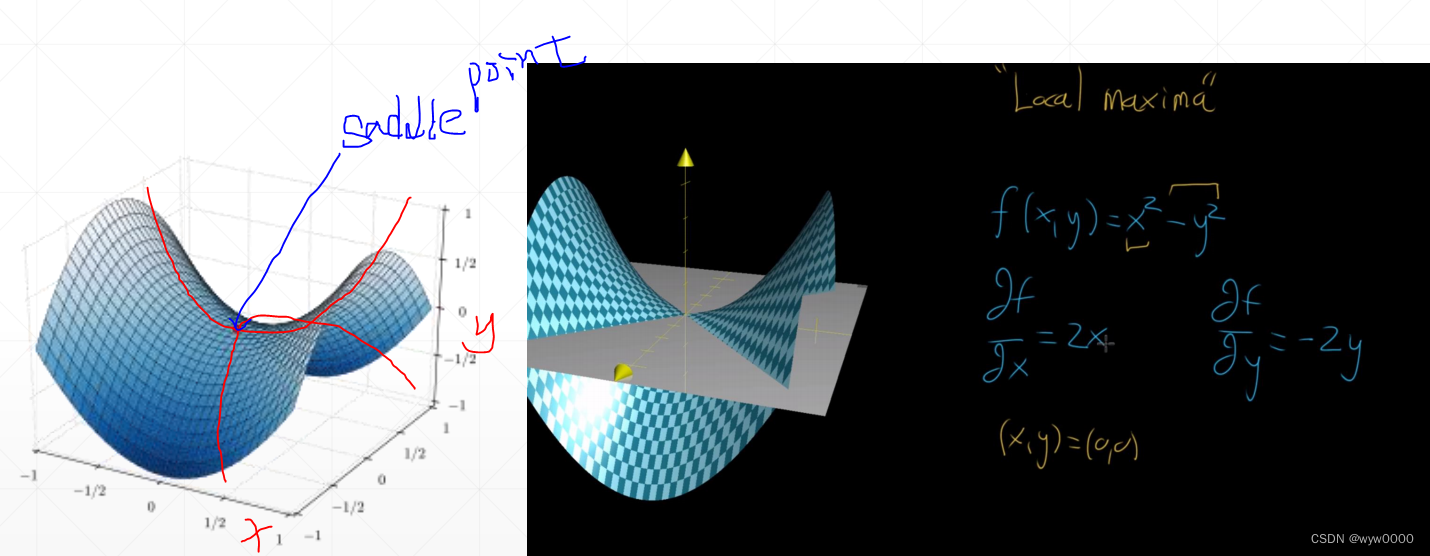

pytorch什么是梯度

目录 1.导数、偏微分、梯度1.1 导数1.2 偏微分1.3 梯度 2. 通过梯度求极小值3. learning rate3. 局部最小值4. Saddle point鞍点 1.导数、偏微分、梯度

1.1 导数

对于yx 2 2 2 的导数,描述了y随x值变化的一个变化趋势,导数是个标量反应的是变化的程度&…

【HTML】HTML基础7.1(无序列表)

目录 标签

属性

效果

注意 标签

<ul>

<li>列表里要装的东西</li>

<li>列表里要装的东西</li>

<li>列表里要装的东西</li>

</ul>

属性

type:

circle空心圆disc实心圆square方框

效果

circle空心圆效果…

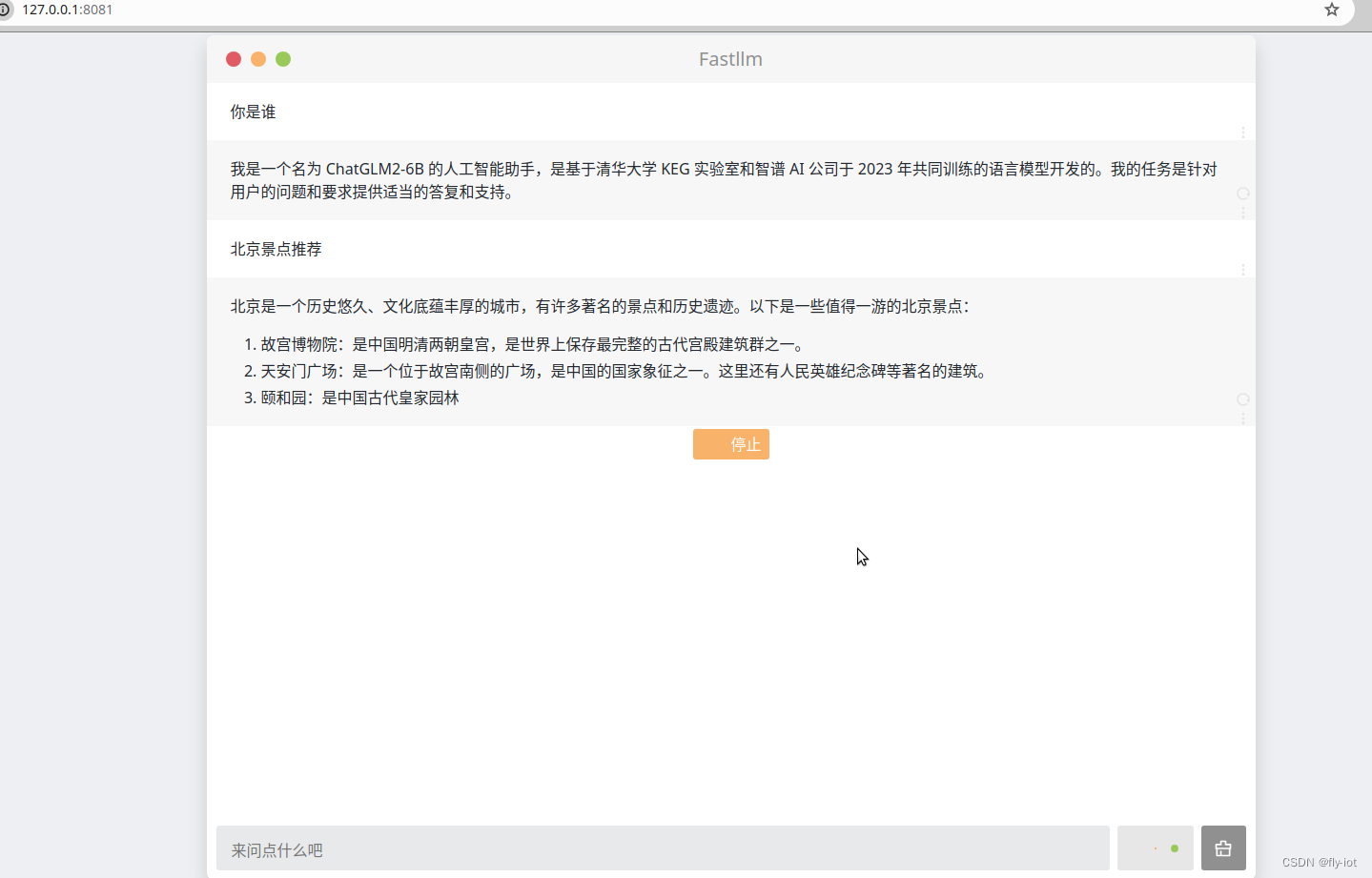

【fastllm】学习框架,本地运行,速度还可以,可以成功运行chatglm2模型

1,关于 fastllm 项目

https://www.bilibili.com/video/BV1fx421k7Mz/?vd_source4b290247452adda4e56d84b659b0c8a2 【fastllm】学习框架,本地运行,速度还可以,可以成功运行chatglm2模型 https://github.com/ztxz16/fastllm

&am…

ai学习前瞻-python环境搭建

python环境搭建 Python环境搭建1. python的安装环境2. MiniConda安装3. pycharm安装4. Jupyter 工具安装5. conda搭建虚拟环境6. 安装python模块pip安装conda安装 7. 关联虚拟环境运行项目 Python环境搭建

1. python的安装环境

python环境安装有4中方式。

从上图可以了解…

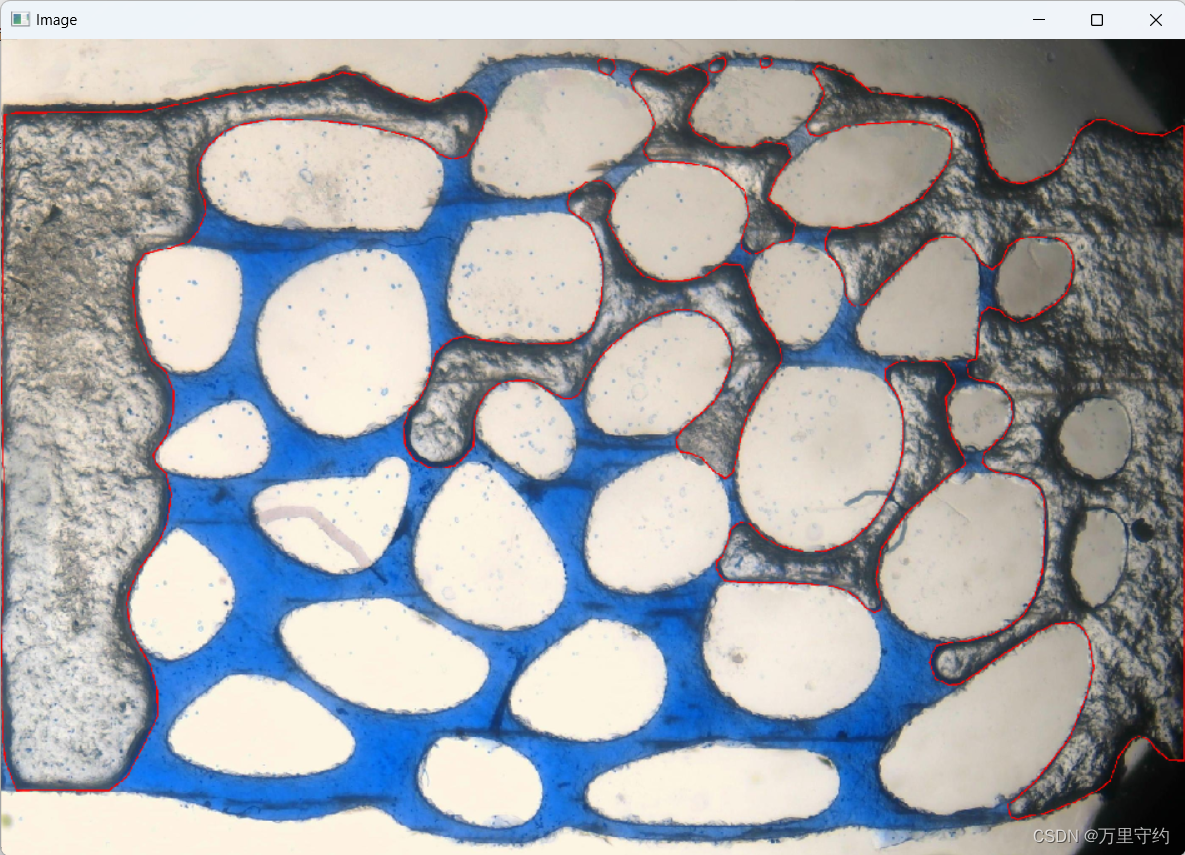

YOLO语义分割标注文件txt还原到图像中

最近做图像分割任务过程中,使用labelme对图像进行标注,得到的数据文件是json,转换为YOLO训练所需的txt格式后,想对标注文件进行检验,即将txt标注文件还原到原图像中,下面是代码:

import cv2

im…

C++指针(五)完结篇

个人主页:PingdiGuo_guo 收录专栏:C干货专栏 前言 相关文章:C指针(一)、C指针(二)、C指针(三)、C指针(四)万字图文详解! 本篇博客是介…

交易平台开发:构建安全/高效/用户友好的在线交易生态圈

在数字化浪潮的推动下,农产品现货大宗商品撮合交易平台已成为连接全球买家与卖家的核心枢纽。随着电子商务的飞速发展,一个安全、高效、用户友好的交易平台对于促进交易、提升用户体验和增加用户黏性至关重要。本文将深入探讨交易平台开发的关键要素&…

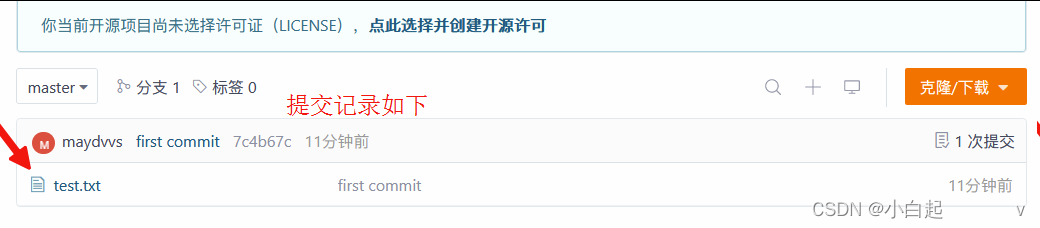

git学习(创建项目提交代码)

操作步骤如下

git init //初始化git remote add origin https://gitee.com/aydvvs.git //建立连接git remote -v //查看git add . //添加到暂存区git push 返送到暂存区git status // 查看提交代码git commit -m初次提交git push -u origin "master"//提交远程分支 …

Pytorch学习 day09(简单神经网络模型的搭建)

简单神经网络模型的搭建

针对CIFAR 10数据集的神经网络模型结构如下图: 由于上图的结构没有给出具体的padding、stride的值,所以我们需要根据以下公式,手动推算: 注意:当stride太大时,padding也会变得很大…

视频推拉流EasyDSS平台直播通道重连无法转推的原因排查与解决

视频推拉流EasyDSS视频直播点播平台,集视频直播、点播、转码、管理、录像、检索、时移回看等功能于一体,可提供音视频采集、视频推拉流、播放H.265编码视频、存储、分发等视频能力服务。 用户使用EasyDSS平台对直播通道进行转推,发现只要关闭…

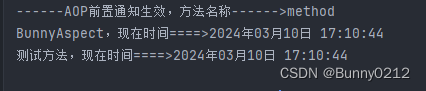

AOP切面编程,以及自定义注解实现切面

AOP切面编程

通知类型表达式重用表达式切面优先级使用注解开发,加上注解实现某些功能

简介

动态代理分为JDK动态代理和cglib动态代理当目标类有接口的情况使用JDK动态代理和cglib动态代理,没有接口时只能使用cglib动态代理JDK动态代理动态生成的代理类…

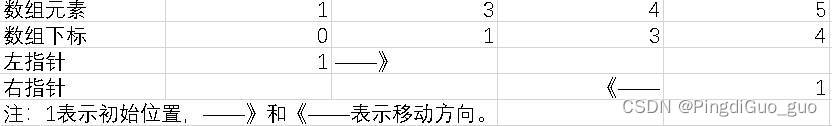

【滑动窗口】力扣239.滑动窗口最大值

前面的文章我们练习数十道 动态规划 的题目。相信小伙伴们对于动态规划的题目已经写的 得心应手 了。

还没看过的小伙伴赶快关注一下,学习如何 秒杀动态规划 吧!

接下来我们开启一个新的篇章 —— 「滑动窗口」。

滑动窗口

滑动窗口 是一种基于 双指…

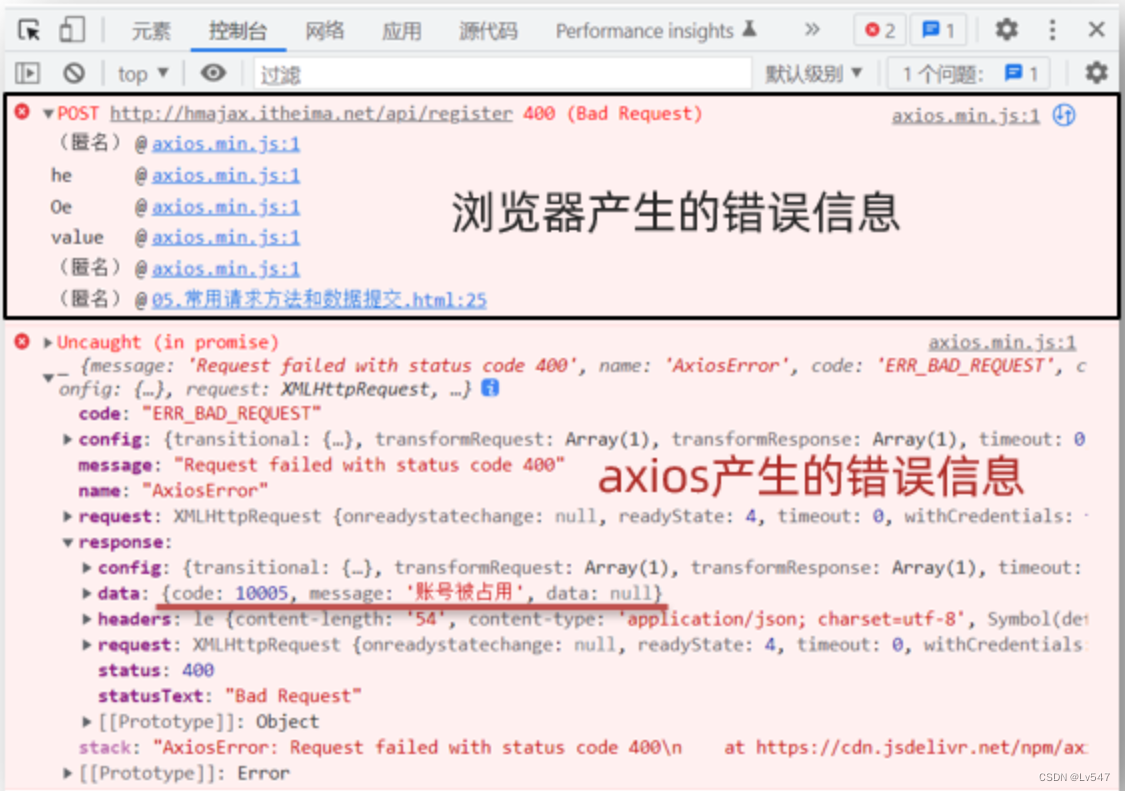

03.axios数据提交和错误处理

一.axios常用请求方法和数据提交

1. 想要提交数据,先来了解什么是请求方法 请求方法是一些固定单词的英文,例如:GET,POST,PUT,DELETE,PATCH(这些都是http协议规定的)&am…

axios的详细使用

目录

axios:现代前端开发的HTTP客户端王者

一、axios简介

二、axios的基本用法

1. 安装axios

2. 发起GET请求

3. 发起POST请求

三、axios的高级特性

1. 拦截器

2. 取消请求

3. 自动转换JSON数据

四、axios在前端开发中的应用

五、总结 axios:…

3/7—21. 合并两个有序链表

代码实现: 方法1:递归 ---->难点 /*** Definition for singly-linked list.* struct ListNode {* int val;* struct ListNode *next;* };*/

struct ListNode* mergeTwoLists(struct ListNode *list1, struct ListNode *list2) {/*1.如果l1为…

Luajit 2023移动版本编译 v2.1.ROLLING

文章顶部有编好的 2.1.ROLLING 2023/08/21版本源码 Android 64 和 iOS 64

luajit 目前最新的源码tag版本为 v2.1.ROLLING on Aug 21, 2023应该是修正了很多bug, 我是出现下面问题才编的. cocos2dx-lua 游戏 黑屏 并报错: [LUA ERROR] bad light userdata pointer

编…

推荐文章

- 千橡CEO陈一舟5日聊微软入股Facebook和校内网

- JSP住宅小区物业管理系统(源代码+开题报告+论文+答辩PPT)

- 8th参考文献:[8]许少辉.乡村振兴战略下传统村落文化旅游设计[M]北京:中国建筑出版传媒,2022.

- LeetCode解法汇总1572. 矩阵对角线元素的和

- 三江学院图书馆藏八一新书《乡村振兴战略下传统村落文化旅游设计》

- # Go学习-Day5

- ###(新)获取A股全市场实时行情接口

- (01)Hive的相关概念——架构、数据存储、读写文件机制

- (delphi11最新学习资料) Object Pascal 学习笔记---第9章(异常处理)

- (长期更新)《零基础入门 ArcGIS(ArcMap) 》实验一(下)----空间数据的编辑与处理(超超超详细!!!)

- (附项目源码)python开发语言,基于python Web的高校毕业论文管理系统 51,计算机毕设程序开发+文案(LW+PPT)

- (科目三)计算机操作系统