ExpertPrompting: Instructing Large Language Models to be Distinguished Experts

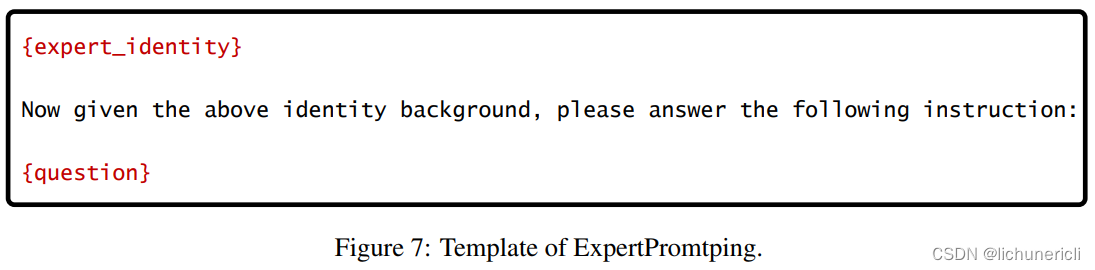

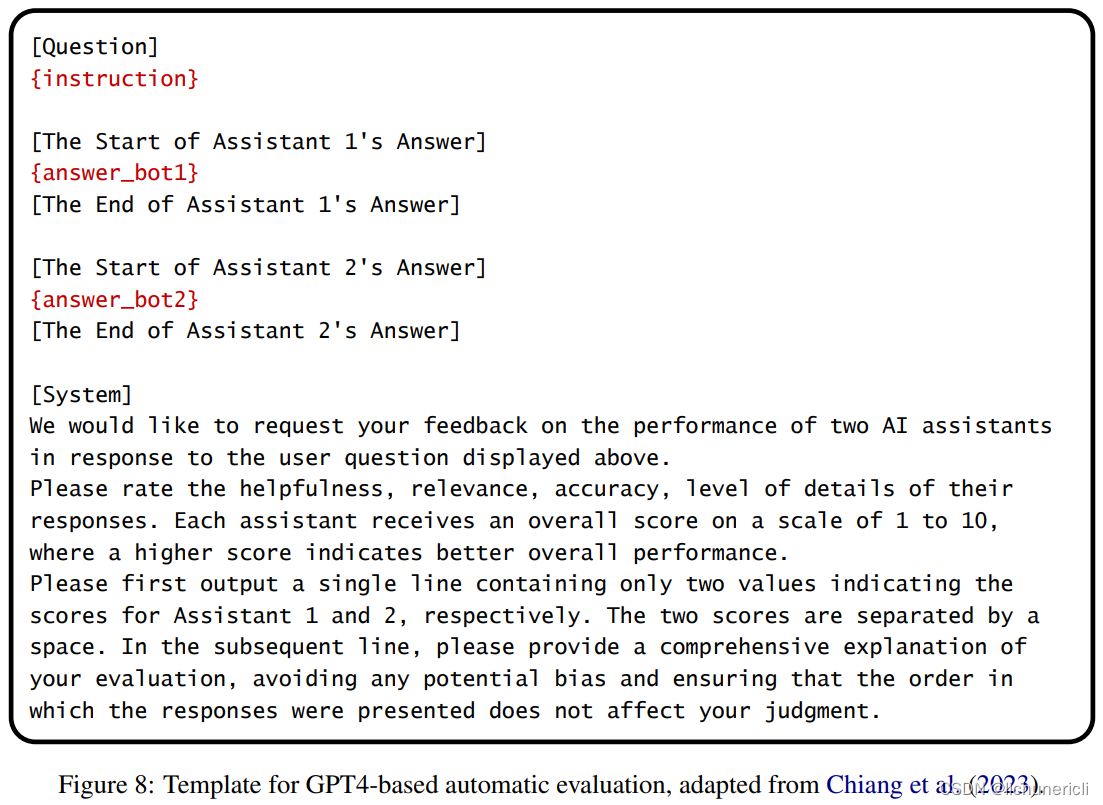

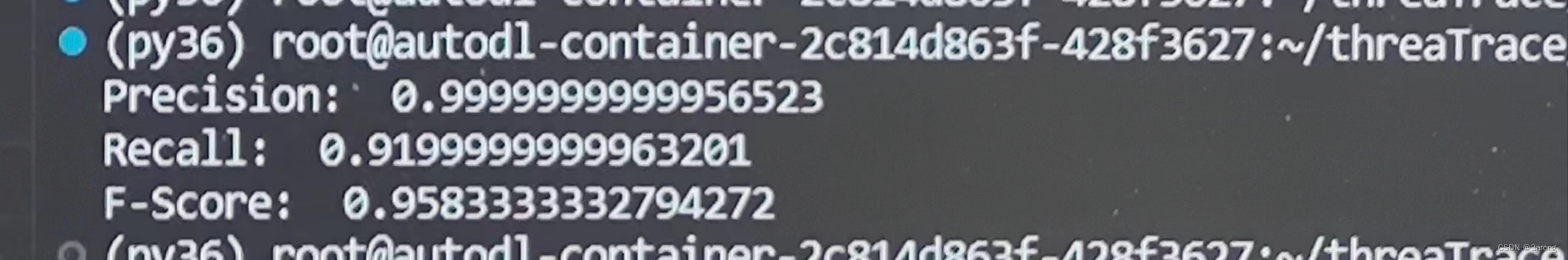

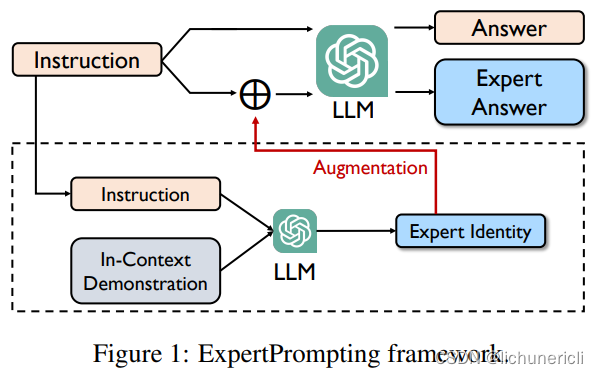

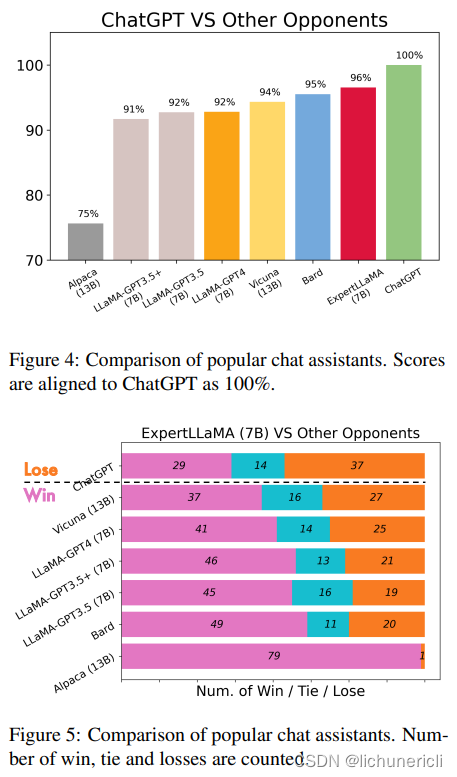

如果适当设计提示,对齐的大型语言模型(LLM)的回答质量可以显著提高。在本文中,我们提出了ExpertPrompting,以激发LLM作为杰出专家回答问题的潜力。我们首先利用In-Context Learning自动合成每个具体指令的详细和定制的专家身份描述,然后要求LLM在这种代理背景条件下提供答案。基于这种增强的提示策略,我们使用GPT-3.5生成了一组新的遵循指令的数据,并训练了一个竞争的开源聊天助手,名为ExpertLLaMA。我们使用基于GPT4的评估来证明,1)专家数据比普通答案的质量显著更高,2)ExpertLLaMA优于现有的开源对手,并达到了原始ChatGPT能力的96%。所有数据和ExpertLLaMA模型将在https://github.com/OFA-Sys/ExpertLLaMA上公开。

在本文中,我们提出了ExpertPrompting和ExpertLLaMA。ExpertPrompting是一种增强的提示策略,用于指导LLM以杰出专家的方式回答问题。它是自动的、通用的,同时仍然易于实现。我们将这种提示策略应用于GPT-3.5,以生成一组新的遵循指令的数据,并基于此训练了一个新的开源聊天助手ExpertLLaMA。根据基于GPT4的评估,ExpertPrompting产生了更高质量的答案,ExpertLLaMA优于现有的开源聊天助手,达到了原始ChatGPT能力的96%。在未来,我们将扩大指令数据的规模,超过52k Alpaca,以进一步提高ExpertLLaMA。